So optimieren Sie WordPress Robots.txt für SEO mit Beispiel

Veröffentlicht: 2021-12-20SEO hat für Website-Besitzer oberste Priorität. Da die Top-5-Ergebnisse 75 % der Klicks erzielen, war das Rennen um höhere Platzierungen eine Herausforderung. Es gibt verschiedene Off-Page- und On-Page-SEO-Techniken, die ins Spiel kommen. Die Optimierung der Robot.txt-Datei ist einer dieser Tricks, die die SEO für Ihre Website stärken können.

Die meisten Anfänger wissen jedoch nicht, wie man WordPress Robots.txt für SEO optimiert. Einige wissen vielleicht nicht einmal, was eine robots.txt-Datei überhaupt ist.

Glücklicherweise ist dieser Artikel zu Ihrer Rettung.

Hier erklären wir, was eine robots.txt-Datei ist, wie man die robots.txt-Datei erstellt und wie man die robots.txt-Datei für SEO optimiert. Wir haben auch einige FAQs am Ende hinzugefügt. Stellen Sie also sicher, dass Sie bis zum Ende bei uns sind.

Jetzt fangen wir an!

Inhaltsverzeichnis

- Was ist eine Robots.txt-Datei?

- Wie sieht eine Robots.txt-Datei aus?

- Warum brauchen Sie eine Robots.txt-Datei in WordPress?

- Wie erstelle ich eine Robots.txt für Ihre Website?

- Methode 1: Erstellen der Robots.txt-Datei mit dem Rank Math Plugin

- Methode 2: Erstellen der Robots.txt-Datei mit FTP

- Wohin mit Ihrer Robots.txt-Datei?

- Wie teste ich die Robots.txt-Datei?

- Vorteile der Robots.txt-Datei

- Nachteile der robots.txt-Datei

- Häufig gestellte Fragen (FAQs)

- Was ist Web-Crawling?

- Was ist Indizierung?

- Wie hoch ist das Crawl-Budget?

- Fazit

Was ist eine Robots.txt-Datei?

Robots.txt in WordPress ist eine einfache Textdatei, die die Suchmaschinen-Bots darüber informiert, welche Seiten auf Ihrer Website gecrawlt und indiziert werden sollen. Sie können die Datei auch so formatieren, dass die Seiten von der Indizierung ausgeschlossen werden.

Die robots.txt wird im WordPress-Root-Verzeichnis gespeichert. Diese Datei hat ein grundlegendes Format, das wie folgt aussieht:

User-agent: [user-name] Disallow: [URL of the string not to be crawled] Allow: [URL of the string to be crawled] Sitemap: [URL of your WordPress XML Sitemap]Wie sieht eine Robots.txt-Datei aus?

Eine robots.txt-Datei besteht einfach aus ein paar Textzeilen, die Suchmaschinen anweisen, wie und was auf Ihrer Website gecrawlt werden soll. Sie haben mehrere Zeilen in dieser Datei, um bestimmte Seiten-URLs zuzulassen oder einzuschränken. Sie können auch mehrere Sitemaps hinzufügen. Wenn Sie eine URL nicht zulassen, crawlen die Suchmaschinen-Bots diese Seite nicht.

Hier ist ein Beispiel für die robots.txt-Datei:

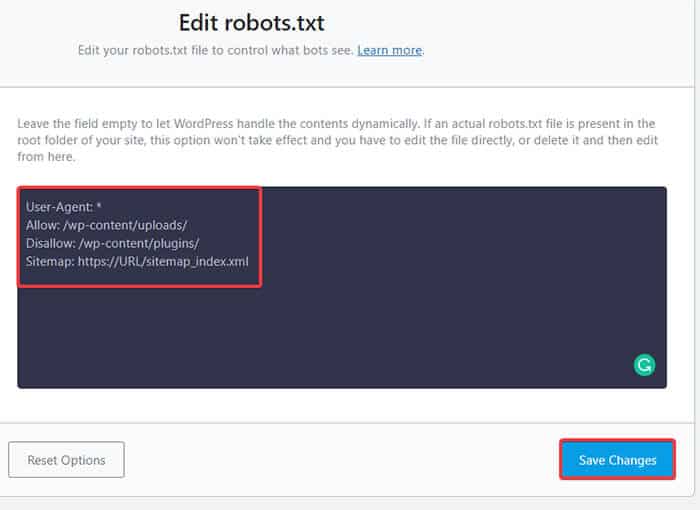

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Sitemap: https://URL/sitemap_index.xmlLassen Sie uns nun etwas über diese vier Hauptbegriffe lernen, die Sie in einer Robots-Datei finden können:

- User-Agent : User-Agent ist der spezifische Web-Crawler, dem Sie Crawling-Anweisungen erteilen. In der Regel handelt es sich dabei um eine Suchmaschine.

- Zulassen : Zulassen ist der Befehl, der dem Googlebot mitteilt, dass er auf eine Seite oder einen Unterordner zugreifen kann, obwohl sein Unterordner oder eine übergeordnete Seite möglicherweise nicht zugelassen ist.

- Disallow : Der Befehl disallow weist einen User-Agent an, eine bestimmte URL nicht zu crawlen. Sie können für jede URL nur eine „Disallow:“-Zeile einfügen.

- Sitemap : Die Sitemap wird verwendet, um den Speicherort jeder XML-Sitemap(s) aufzurufen, die mit dieser URL in Verbindung stehen. Dieser Befehl wird nur von Google, Bing, Ask und Yahoo unterstützt.

Im obigen Beispiel haben wir Such-Bots erlaubt, den Uploads-Ordner zu crawlen und zu indizieren, aber den Plugins-Ordner eingeschränkt. Am Ende haben wir die Indizierung der XML-Sitemap zugelassen.

Das Sternchen nach User-Agent bedeutet, dass der Text für alle Suchmaschinen-Bots gilt. Jede Suchmaschine hat ihren Benutzeragenten, um Websites zu indizieren. Hier sind einige User-Agents einiger beliebter Suchmaschinen:

- Google: Googlebot

- Googlebot-Bilder: Googlebot-Bild

- Googlebot-Neuigkeiten: Googlebot-Neuigkeiten

- Googlebot-Video: Googlebot-Video

- Yahoo: Slurp-Bot

- Bing: Binbot

- Alexa von Amazon: ia_archiver

- DuckDuckGo: DuckDuckBot

- Yandex: YandexBot

- Baidu: Baiduspinne

- Exalead: ExaBot

Heutzutage gibt es so viele User-Agents. Wenn Sie sich auf eine bestimmte Suchmaschine konzentrieren möchten, können Sie diese sogar in der robots.txt-Datei angeben. Das heißt, um Anweisungen für den Googlebot einzurichten, können Sie die erste Zeile Ihrer robots.txt-Datei wie folgt schreiben:

User-Agent: Googlebot

Warum brauchen Sie eine Robots.txt-Datei in WordPress?

Suchbots crawlen und indexieren Ihre Website, auch wenn Sie keine robots.txt-Datei haben. Also, warum sollten Sie es wirklich brauchen? Nun, mit der robots.txt-Datei können Sie Suchmaschinen anweisen, die Indexierung auf bestimmten Seiten zu priorisieren. Außerdem können Sie Seiten oder Ordner ausschließen, die Sie nicht indizieren möchten.

Dies hat beim ersten Mal keine größeren Auswirkungen Starten Sie einen Blog und haben nicht viel Inhalt. Nachdem Ihre Website jedoch wächst und viele Inhalte enthält, müssen Sie möglicherweise die Indizierung auf einer bestimmten Seite/einem bestimmten Beitrag/Ordner priorisieren und einige negieren.

Sie sehen, es gibt eine Quote für jeden Suchbot für jede Website. Das bedeutet, dass Bots bei einer bestimmten Crawling-Sitzung auf einer bestimmten Anzahl von Seiten crawlen. Wenn die Bots das Crawlen in dieser bestimmten Sitzung nicht beenden, kehrt der Bot zurück und setzt das Crawlen in der nächsten Sitzung fort. Dies verlangsamt die Indexierungsrate Ihrer Website.

Durch die Verwendung der robots.txt-Datei können Sie Such-Bots also anweisen, welche Seiten, Dateien und Ordner Sie indizieren möchten und welche eingeschlossen werden sollen. Dadurch sparen Sie das Crawling-Kontingent. Es ist vielleicht nicht der sicherste Weg, Ihre Inhalte vor der Öffentlichkeit zu verbergen, aber es verhindert, dass diese ausgeschlossenen Inhalte in den SERPs erscheinen.

Wie erstelle ich eine Robots.txt für Ihre Website?

Sie können robots.txt auf zwei verschiedene Arten erstellen. Wir werden diese Methoden unten erklären. Sie können dann der Methode folgen, von der Sie glauben, dass sie für Sie am besten funktioniert.

Methode 1: Erstellen der Robots.txt-Datei mit dem Rank Math Plugin

Hier zeigen wir Ihnen, wie Sie mit dem beliebten Rank Math-Plugin eine robots.txt-Datei erstellen.

Rank Math ist ein SEO-WordPress-Plugin, das es einfach macht, den Inhalt Ihrer Website mit integrierten Vorschlägen zu optimieren, die auf allgemein anerkannten Best Practices basieren. Mit diesem praktischen Tool können Sie wichtige SEO-Einstellungen einfach anpassen und steuern, welche Seiten indexierbar sind.

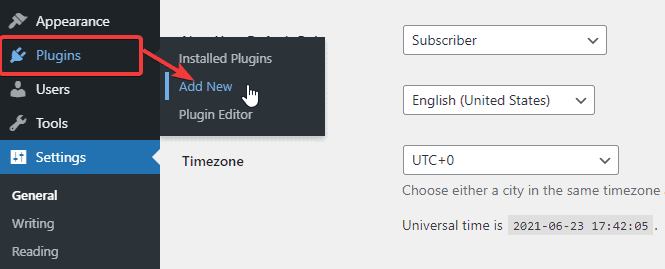

Um eine robots.txt-Datei mit dem Rank Math-Plugin zu erstellen, laden Sie zunächst das Plugin herunter, indem Sie in Ihrem WordPress-Admin-Dashboard zu Plugins -> Neu hinzufügen gehen.

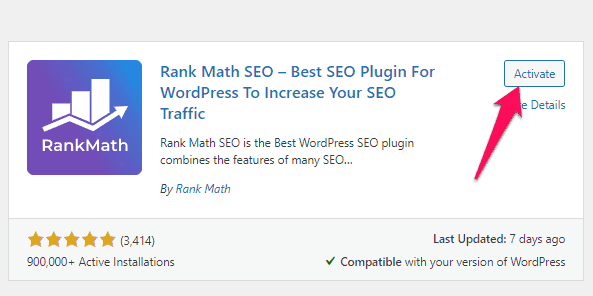

Suchen Sie nun in der Suchleiste nach Rank Math und klicken Sie auf die Schaltfläche Jetzt installieren und aktivieren , sobald Sie das Plugin gefunden haben.

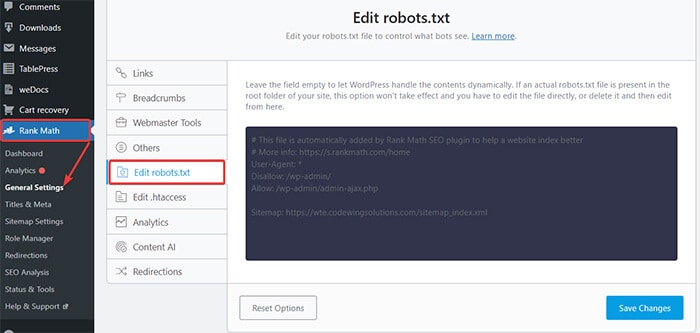

Sobald Sie das Plugin aktiviert haben, gehen Sie zu Rank Math -> General Settings -> Edit robots.txt aus dem WordPress Dashboard.

Geben Sie nun den folgenden Code ein oder kopieren Sie den Code aus dem vorherigen Beispiel in das leere Feld und klicken Sie auf die Schaltfläche Änderungen speichern .

Los geht's! Sie haben erfolgreich eine robots.txt-Datei mit dem Rank Math-Plugin erstellt.

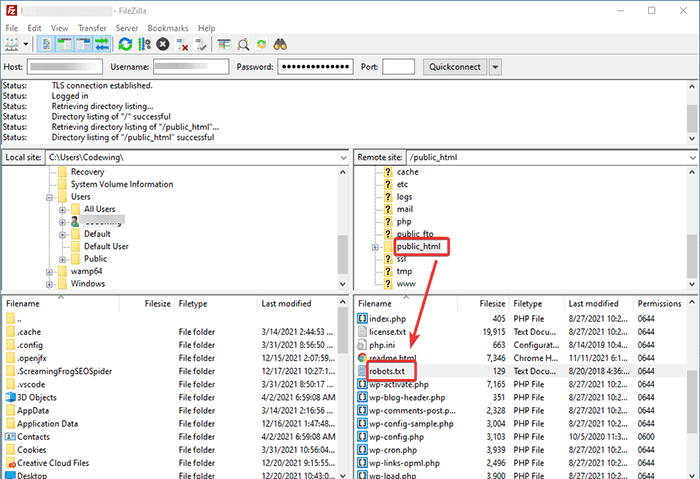

Methode 2: Erstellen der Robots.txt-Datei mit FTP

Die zweite Methode besteht darin, eine robots.txt-Datei manuell auf einem lokalen Computer zu erstellen und sie dann in den Stammordner Ihrer WordPress-Site hochzuladen.

Sie müssen über einen FTP-Client auf Ihr WordPress-Hosting zugreifen. Nachdem Sie sich bei Ihrem FTP-Client angemeldet haben, können Sie die robots.txt-Datei im Stammordner der Website sehen. Klicken Sie mit der rechten Maustaste und wählen Sie die Option Bearbeiten .

Fügen Sie nun Ihre benutzerdefinierte Regel zur Datei hinzu und speichern Sie die Änderungen. Beispielsweise:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpWenn Sie die Datei nicht im Stammordner sehen, können Sie sie mit dem Editor auf Ihrem lokalen Computer erstellen. Fügen Sie Ihre Regeln hinzu und laden Sie sie dann über FTP in Ihren Stammordner hoch.

Wohin mit Ihrer Robots.txt-Datei?

Sie sollten Ihre robots.txt-Datei immer im Stammverzeichnis Ihrer Website ablegen. Wenn Ihre Website beispielsweise domainname.com ist, lautet die Domain Ihrer robots.txt-Datei https://domainname.com/robots.txt.

Zusätzlich zum Hinzufügen der robots.txt-Datei in Ihrem Stammverzeichnis finden Sie hier einige zusätzliche Tipps:

- Es ist ein Muss, die Datei „robots.txt“ zu nennen.

- Beim Dateinamen wird zwischen Groß- und Kleinschreibung unterschieden. Sie müssen es also richtig machen, sonst funktioniert es nicht.

- Sie müssen für jede neue Regel eine neue Zeile hinzufügen.

- Fügen Sie ein „$“-Zeichen hinzu, um das Ende einer URL anzuzeigen.

- Verwenden Sie jeden User-Agent nur einmal.

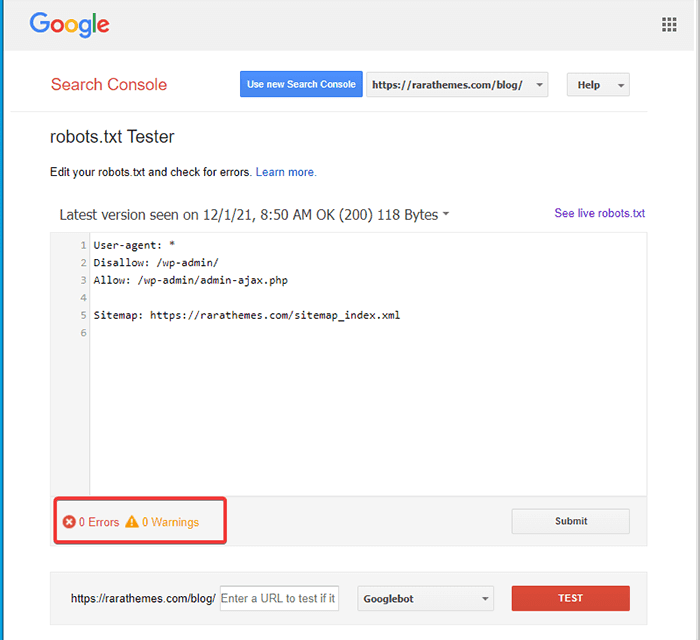

Wie teste ich die Robots.txt-Datei?

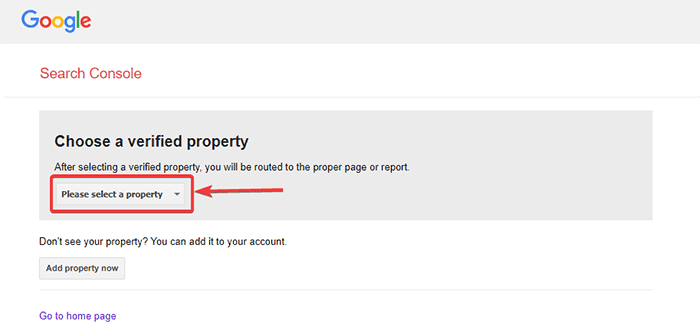

Nachdem Sie die robots.txt-Datei erstellt haben, können Sie sie mit der Google Search Console testen. Hier finden Sie das Open robot.txt-Tester-Tool.

- Wählen Sie Ihre Immobilie aus der angegebenen Dropdown-Liste aus.

Das Tool ruft die robots.txt-Datei Ihrer Website ab und hebt die Fehler und Warnungen hervor, falls es welche findet.

Hinweis : Die Dropdown-Eigenschaftsoption wird nur angezeigt, wenn Sie Ihre WordPress-Site mit der Google Search Console verknüpft haben.

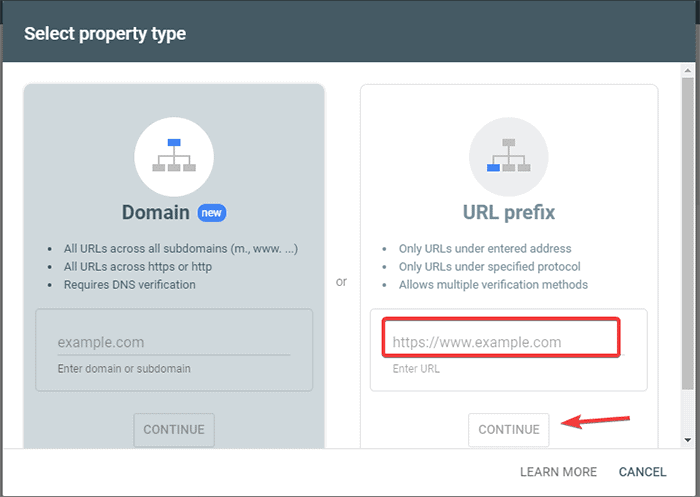

Wenn Sie es noch nicht getan haben, können Sie Ihre Website schnell wie folgt verlinken:

- Melden Sie sich bei der Google Search Console an und erstellen Sie ein Konto. Sie können Ihr Konto entweder mit Ihrer Domain oder Ihrem URL-Präfix einrichten. Es wird empfohlen, das URL-Präfix zu verwenden, da es vergleichsweise einfacher ist.

- Geben Sie die URL Ihrer Website ein.

- Klicken Sie nun auf die Schaltfläche „Weiter“.

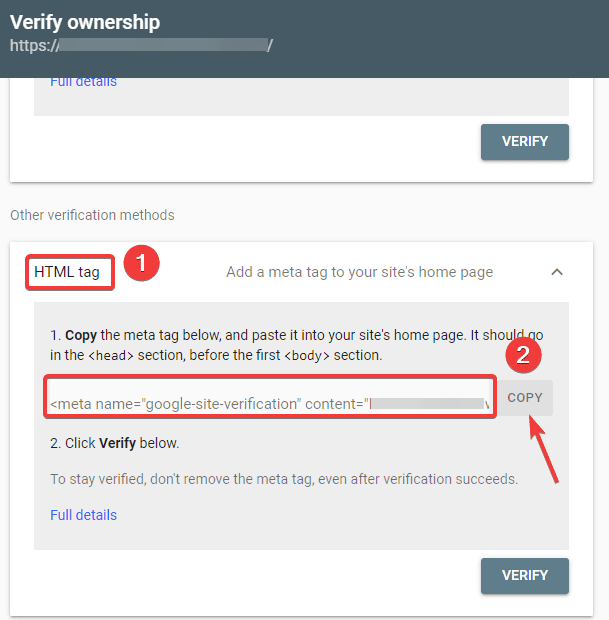

- Sie sollten jetzt die Eigentümerschaft der Website bestätigen. Sie können dies mit einer der angegebenen Optionen tun. Wir empfehlen jedoch die Verwendung der HTML-Tag-Option.

- Kopieren Sie den angegebenen Code und gehen Sie dann zu Ihrem WordPress-Dashboard.

Sie können den Code jetzt mit dem Plugin „Kopf- und Fußzeilen einfügen“ überprüfen. Verifizieren:

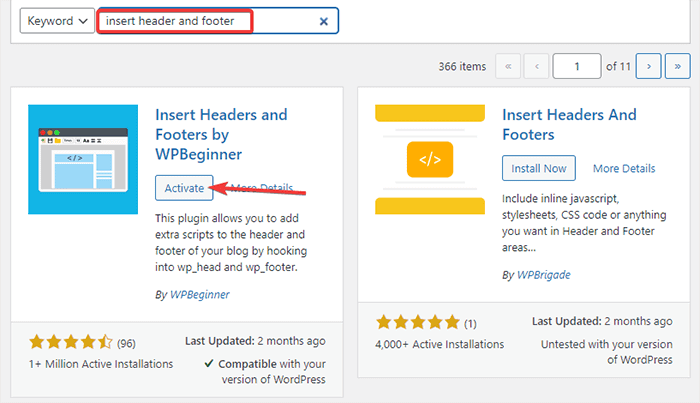

- Gehen Sie in Ihrem WordPress-Admin-Dashboard zu Plugins -> Neu hinzufügen.

- Suchen Sie nun in der Suchleiste nach dem Plugin Kopf- und Fußzeilen einfügen und installieren und aktivieren Sie dann das Plugin.

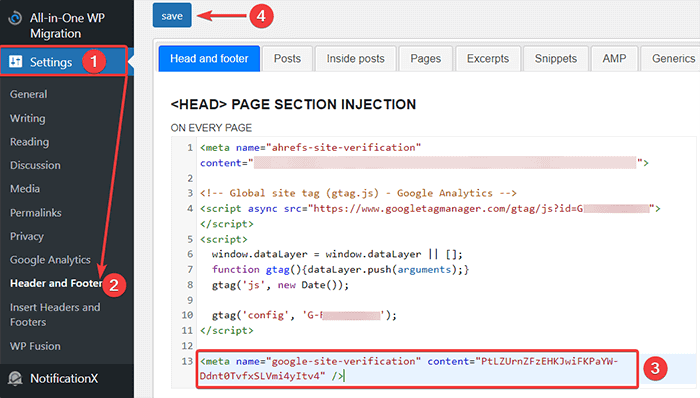

- Leiten Sie danach von Ihrem WordPress-Dashboard zu Einstellungen -> Kopf- und Fußzeile um und fügen Sie dann den kopierten Code in die Registerkarte Kopf- und Fußzeile ein. Wenn Sie fertig sind, klicken Sie auf die Schaltfläche Speichern.

- Gehen Sie zurück zur Registerkarte Google Search Console in Ihrem Browser. Klicken Sie dann auf die Schaltfläche „Bestätigen“.

- Google prüft das Eigentum und zeigt die fertige Nachricht an, sobald es fertig ist.

- Klicken Sie auf die Option „Gehe zu Property“, um auf das Dashboard der Google Search Console zuzugreifen.

Gehen Sie nun zurück zum Open robot.txt Tester Tool und testen Sie Ihre robots.txt wie oben erwähnt.

Vorteile der Robots.txt-Datei

Hier sind die Vorteile der Verwendung der Robots.txt-Datei im SEO-Kontext:

- Es hilft, die Crawling-Budgets der Suchmaschine zu optimieren, indem die Indexierung auf den Seiten übersprungen wird, die die Bots nicht crawlen sollen. Dies schafft eine Priorität für die Suchmaschine, nur die Seiten zu crawlen, die für Sie wichtig sind.

- Es hilft bei der Optimierung des Webservers, indem es Bots einschränkt, die unnötig Ressourcen verbrauchen.

- Es hilft, die Anmeldeseiten, Zielseiten und Dankesseiten vor der Indexierung durch Suchmaschinen zu verbergen. Dadurch wird die Leistung der Website optimiert.

Nachteile der robots.txt-Datei

- Das Erstellen einer robots.txt-Datei ist ziemlich einfach, wie wir oben erklärt haben. Die robots.txt-Datei enthält jedoch auch die URLs zu Ihren internen Seiten, die Crawl-Bots nicht indexieren sollen, wie z. B. die Anmeldeseite. Dies macht Ihre Website anfällig für Sicherheitsverletzungen.

- Während das Erstellen einer robots.txt-Datei einfach ist, kann selbst ein einfacher Fehler all Ihre Bemühungen zunichte machen. Wenn Sie beispielsweise ein einzelnes Zeichen in der Datei hinzufügen oder verlegen, bringt dies all Ihre SEO-Bemühungen durcheinander.

Häufig gestellte Fragen (FAQs)

Was ist Web-Crawling?

Suchmaschinen schicken ihre Webcrawler (auch bekannt als Bots oder Spider) über das Web. Diese Bots sind intelligente Software, die durch das gesamte Web navigiert, um neue Seiten, Links und Websites zu entdecken. Dieser Erkennungsprozess wird als Web-Crawling bezeichnet.

Was ist Indizierung?

Wenn Webcrawler Ihre Website entdecken, ordnen sie Ihre Seiten in einer nutzbaren Datenstruktur an. Dieser Organisationsprozess wird Indizierung genannt.

Wie hoch ist das Crawl-Budget?

Ein Crawl-Budget ist eine Grenze dafür, wie viele URLs ein Suchbot in einer bestimmten Sitzung crawlen kann. Jede Website hat ein bestimmtes Crawl-Budget. Sie müssen also sicherstellen, dass Sie es so ausgeben, dass es für Ihre Website am vorteilhaftesten ist.

Wenn Sie beispielsweise mehrere Seiten auf Ihrer Website haben, müssen Sie das Crawl-Budget den wertvollsten Seiten zuweisen. Daher können Sie die Seiten-URL in Ihrer robots.txt-Datei erwähnen.

Fazit

Bei der Arbeit an der SEO einer Website konzentrieren sich die meisten Benutzer darauf, Sitemaps zu erstellen, an Backlinks zu arbeiten, Schlüsselwörter zu recherchieren und den Inhalt zu optimieren. Nur wenige Webmaster achten auf die robots.txt-Datei.

Die robots.txt-Datei spielt möglicherweise keine große Rolle, wenn Sie eine Website starten. Wenn Ihre Website jedoch wächst, führt die Beachtung der robots.txt-Datei zu besseren Ergebnissen.

Außerdem gibt es einen Mythos, dass blockierende Kategorien, Archivseiten und Tags die Crawling-Rate erhöhen und eine schnellere Indizierung fördern. Es ist falsch.

Befolgen Sie die oben genannten Methoden, um Ihre robots.txt-Datei zu erstellen.

Wir hoffen, dass dieser Artikel Ihnen geholfen hat, Ihre Frage zum Erstellen und Optimieren von WordPress robots.txt für SEO zu sortieren.

Wenn Sie weitere nützliche Artikel zu WordPress lesen möchten, können Sie die folgenden Artikel lesen:

- Wie erstelle ich eine Sitemap in WordPress?

- Wie starte ich einen WordPress-Blog?