Cómo optimizar WordPress Robots.txt para SEO con ejemplo

Publicado: 2021-12-20El SEO ha sido una prioridad para los propietarios de sitios web. Con los cinco primeros resultados ganando el 75% de los clics, la carrera por una clasificación más alta ha sido un desafío. Hay varias técnicas de SEO fuera de la página y dentro de la página que entran en juego. Optimizar el archivo Robot.txt es uno de esos trucos que pueden fortalecer el SEO de su sitio.

Sin embargo, la mayoría de los principiantes no saben cómo optimizar WordPress Robots.txt para SEO. Es posible que algunos ni siquiera sepan qué es un archivo robots.txt en primer lugar.

Afortunadamente, este artículo está a tu rescate.

Aquí, explicaremos qué es un archivo robots.txt, cómo crear el archivo robots.txt y cómo optimizar el archivo robots.txt para SEO. También hemos agregado algunas preguntas frecuentes al final. Así que asegúrate de estar con nosotros hasta el final.

Ahora, ¡comencemos!

Tabla de contenido

- ¿Qué es un archivo Robots.txt?

- ¿Qué aspecto tiene un archivo Robots.txt?

- ¿Por qué necesita un archivo Robots.txt en WordPress?

- ¿Cómo crear un archivo Robots.txt para su sitio web?

- Método 1: crear un archivo Robots.txt usando el complemento Rank Math

- Método 2: crear un archivo Robots.txt mediante FTP

- ¿Dónde poner su archivo Robots.txt?

- ¿Cómo probar el archivo Robots.txt?

- Ventajas del archivo Robots.txt

- Contras del archivo robots.txt

- Preguntas frecuentes (FAQ)

- ¿Qué es el rastreo web?

- ¿Qué es la indexación?

- ¿Qué es el presupuesto de rastreo?

- Conclusión

¿Qué es un archivo Robots.txt?

Robots.txt en WordPress es un archivo de texto sin formato que informa a los robots de los motores de búsqueda qué páginas de su sitio deben rastrear e indexar. También puede formatear el archivo para excluir las páginas de la indexación.

El archivo robots.txt se almacena en el directorio raíz de WordPress. Este archivo tiene un formato básico que se ve así:

User-agent: [user-name] Disallow: [URL of the string not to be crawled] Allow: [URL of the string to be crawled] Sitemap: [URL of your WordPress XML Sitemap]¿Qué aspecto tiene un archivo Robots.txt?

Un archivo robots.txt son simplemente unas pocas líneas de texto que indican a los motores de búsqueda cómo y qué rastrear en su sitio. Tiene varias líneas en este archivo para permitir o restringir URL de páginas específicas. También puede agregar varios mapas de sitio. Si no permite una URL, los robots del motor de búsqueda no rastrean esa página.

Este es un ejemplo del archivo robots.txt:

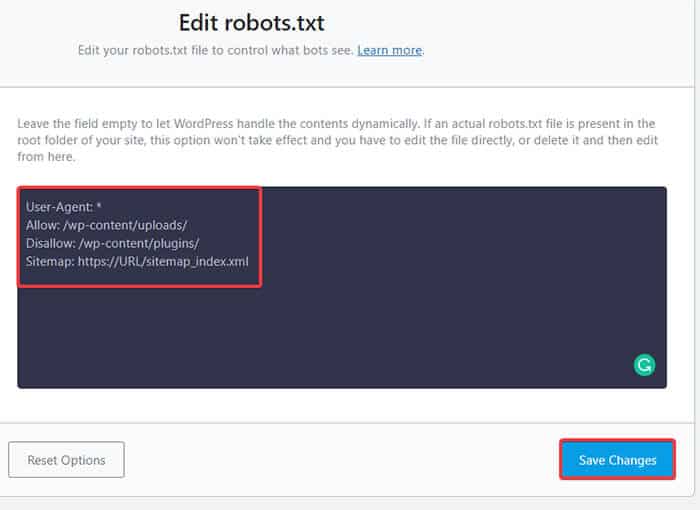

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Sitemap: https://URL/sitemap_index.xmlAhora, aprendamos sobre estos cuatro términos principales que puede encontrar en un archivo de robots:

- Agente de usuario: el agente de usuario es el rastreador web específico al que le da instrucciones de rastreo. Suele ser un motor de búsqueda.

- Permitir : Permitir es el comando que le dice a Googlebot que puede acceder a una página o subcarpeta aunque su subcarpeta o página principal no esté permitida.

- Disallow : el comando disallow le dice a un agente de usuario que no rastree una URL en particular. Solo puede incluir una línea "No permitir:" para cada URL.

- Mapa del sitio: el mapa del sitio se utiliza para indicar la ubicación de cualquier mapa del sitio XML relacionado con esta URL. Este comando solo es compatible con Google, Bing, Ask y Yahoo.

En el ejemplo anterior, permitimos que los robots de búsqueda rastrearan e indexaran la carpeta de cargas, pero restringimos la carpeta de complementos. Al final, permitimos la indexación del mapa del sitio XML.

El signo de asterisco después de User-Agent significa que el texto se aplica a todos los robots de los motores de búsqueda. Cada motor de búsqueda tiene su agente de usuario para indexar sitios. Aquí hay algunos agentes de usuario de algunos motores de búsqueda populares:

- Google: robot de Google

- Imágenes de Googlebot: Imagen de Googlebot

- Noticias de Googlebot: Noticias de Googlebot

- Vídeo de robot de Google: Vídeo de robot de Google

- Yahoo: Sorber robot

- Bing: Bingbot

- Alexa de Amazon: ia_archiver

- PatoPatoGo: PatoPatoBot

- Yandex: YandexBot

- Baidu: Baiduaraña

- Exalead: ExaBot

Hay tantos agentes de usuario por ahí hoy en día. Si desea centrarse en un motor de búsqueda en particular, incluso puede especificarlo en el archivo robots.txt. Es decir, para configurar las instrucciones para Googlebot, puede escribir la primera línea de su archivo robots.txt como:

Agente de usuario: robot de Google

¿Por qué necesita un archivo Robots.txt en WordPress?

Los robots de búsqueda rastrearán e indexarán tu sitio incluso si no tienes un archivo robots.txt. Entonces, ¿por qué realmente lo necesitarías? Bueno, con el archivo robots.txt, puede dirigir los motores de búsqueda para priorizar la indexación en ciertas páginas. Además, puede excluir páginas o carpetas que no desee indexar.

Esto no tiene un mayor impacto cuando primero empezar un blog y no tener mucho contenido. Sin embargo, después de que su sitio crezca y tenga mucho contenido, es posible que deba priorizar la indexación en una determinada página/publicación/carpeta y anular algunos.

Verá, hay una cuota para cada robot de búsqueda para cada sitio web. Eso significa que los bots rastrean una determinada cantidad de páginas en una determinada sesión de rastreo. Si los bots no terminan de rastrear en esa sesión en particular, el bot regresa y reanuda el rastreo en la siguiente sesión. Esto ralentiza la tasa de indexación de su sitio web.

Por lo tanto, al usar el archivo robots.txt, puede dirigir a los bots de búsqueda a qué páginas, archivos y carpetas desea indexar y cuáles incluir. Al hacerlo, guarda la cuota de rastreo. Puede que no sea la forma más segura de ocultar su contenido al público, pero evita que esos contenidos excluidos aparezcan en las SERP.

¿Cómo crear un archivo Robots.txt para su sitio web?

Puede crear robots.txt de dos maneras diferentes. Explicaremos esos métodos a continuación. A continuación, puede seguir el método que crea que funcionará mejor para usted.

Método 1: crear un archivo Robots.txt usando el complemento Rank Math

Aquí, le mostraremos cómo crear un archivo robots.txt utilizando el popular complemento Rank Math.

Rank Math es un complemento SEO de WordPress que facilita la optimización del contenido de su sitio web con sugerencias integradas basadas en las mejores prácticas ampliamente aceptadas. Con esta práctica herramienta, puede personalizar fácilmente configuraciones importantes de SEO y controlar qué páginas son indexables.

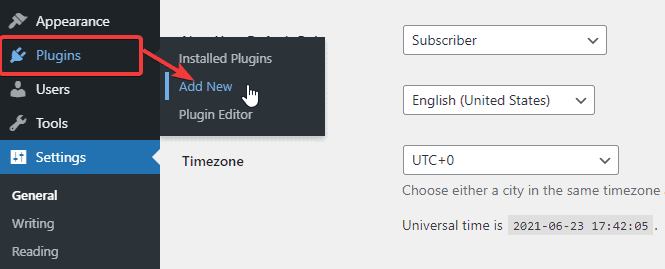

Para crear un archivo robots.txt usando el complemento Rank Math, primero, descargue el complemento yendo a Complementos -> Agregar nuevo desde su panel de administración de WordPress.

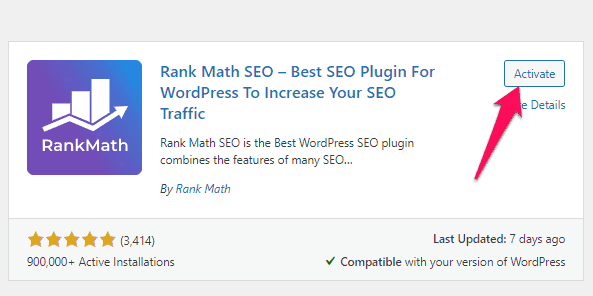

Ahora, busque Rank Math en la barra de búsqueda y haga clic en el botón Instalar ahora y activar una vez que encuentre el complemento.

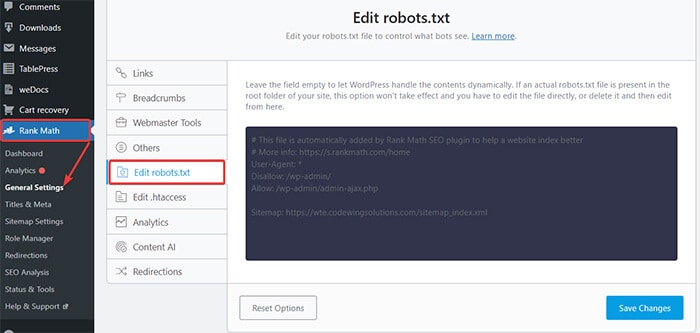

Una vez que active el complemento, diríjase a Rank Math -> Configuración general -> Editar robots.txt desde el panel de WordPress.

Ahora, ingrese el siguiente código o copie el código mencionado en el ejemplo anterior en el espacio en blanco y haga clic en el botón Guardar cambios .

¡Ahí tienes! Ha creado con éxito un archivo robots.txt utilizando el complemento Rank Math.

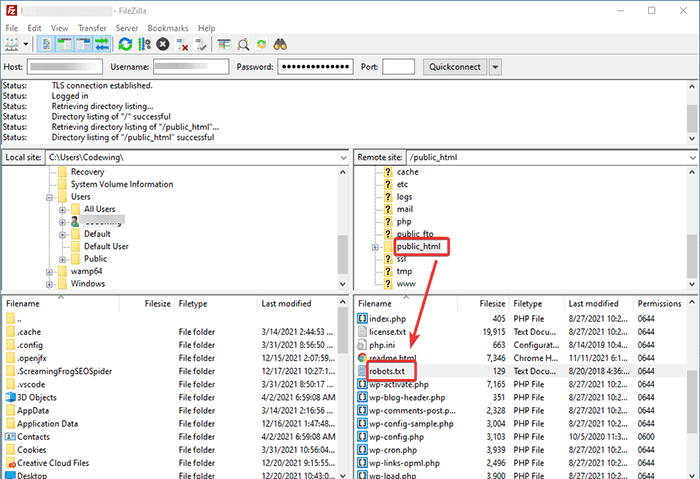

Método 2: crear un archivo Robots.txt mediante FTP

El segundo método consiste en crear un archivo robots.txt manualmente en una computadora local y luego cargarlo en la carpeta raíz de su sitio de WordPress.

Deberá acceder a su alojamiento de WordPress utilizando un cliente FTP. Después de iniciar sesión en su cliente FTP, puede ver el archivo robots.txt en la carpeta raíz del sitio web. Haga clic derecho y seleccione la opción Editar .

Ahora, agregue su regla personalizada al archivo y guarde los cambios. Por ejemplo:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpSi no ve el archivo en la carpeta raíz, puede crearlo en su computadora local usando el bloc de notas. Agregue sus reglas y luego súbalo a su carpeta rooter usando el FTP.

¿Dónde poner su archivo Robots.txt?

Siempre debe colocar su archivo robots.txt en el directorio raíz de su sitio web. Por ejemplo, si su sitio es nombrededominio.com , entonces el dominio de su archivo robots.txt será https://nombrededominio.com/robots.txt.

Además de agregar el archivo robots.txt en su directorio raíz, aquí hay algunos consejos adicionales:

- Es obligatorio nombrar el archivo "robots.txt".

- El nombre del archivo distingue entre mayúsculas y minúsculas. Por lo tanto, debe hacerlo bien o de lo contrario no funcionará.

- Debe agregar una nueva línea para cada regla nueva.

- Agregue un signo "$" para indicar el final de una URL.

- Use cada agente de usuario solo una vez.

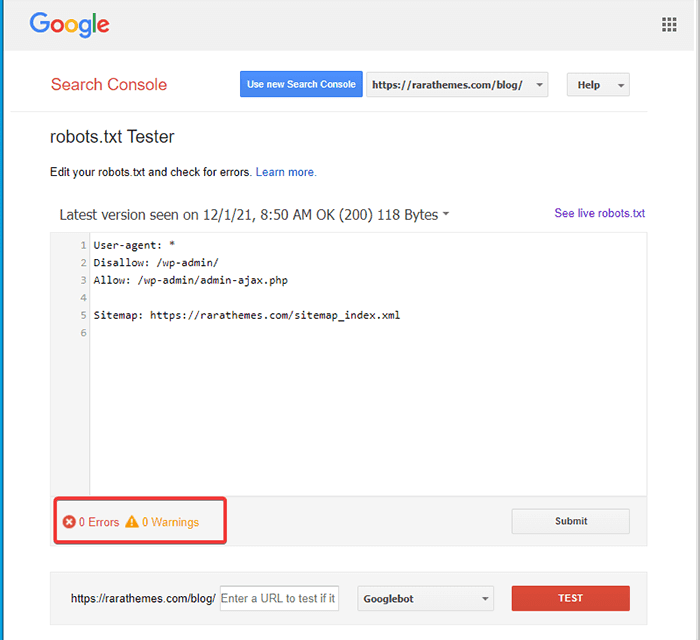

¿Cómo probar el archivo Robots.txt?

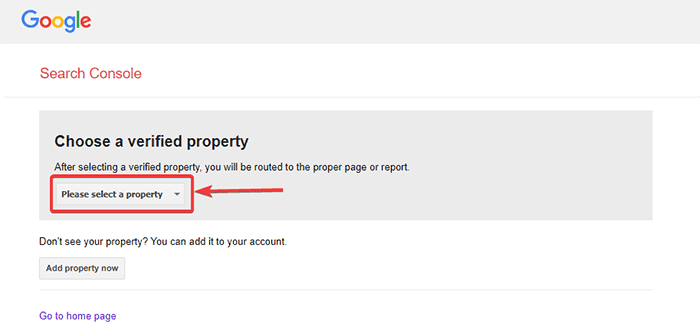

Después de crear el archivo robots.txt, puede probarlo con Google Search Console. Aquí encontrará la herramienta de prueba Open robot.txt.

- Seleccione su propiedad de la lista desplegable dada.

La herramienta obtiene el archivo robots.txt de su sitio y resalta los errores y advierte si encuentra alguno.

Nota : la opción de propiedad desplegable solo aparece si ha vinculado su sitio de WordPress con Google Search Console.

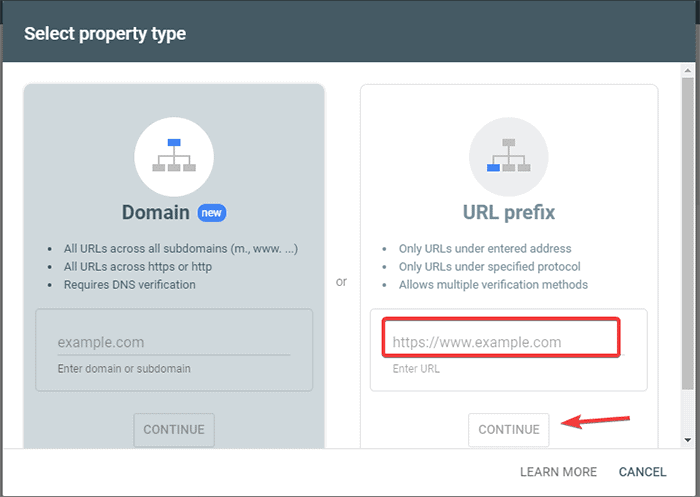

Si no lo ha hecho, puede vincular rápidamente su sitio de la siguiente manera:

- Inicie sesión en Google Search Console y cree una cuenta. Puede configurar su cuenta usando su dominio o prefijo de URL. Se recomienda ir con el prefijo de URL, ya que es comparativamente más fácil.

- Introduce la URL de tu sitio web.

- Ahora, haga clic en el botón "Continuar".

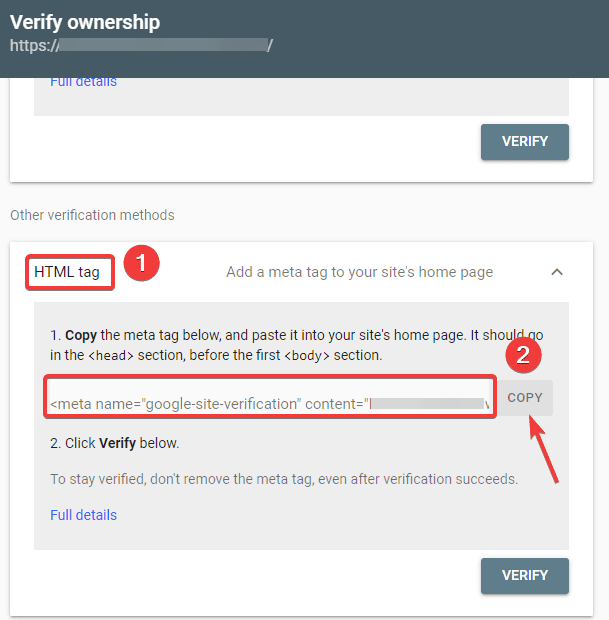

- Ahora debe verificar la propiedad del sitio. Puede hacer esto usando cualquiera de las opciones dadas. Sin embargo, recomendamos utilizar la opción de etiqueta HTML.

- Copie el código dado y luego diríjase a su tablero de WordPress.

Ahora puede verificar el código usando el complemento Insertar encabezados y pies de página. Para verificar:

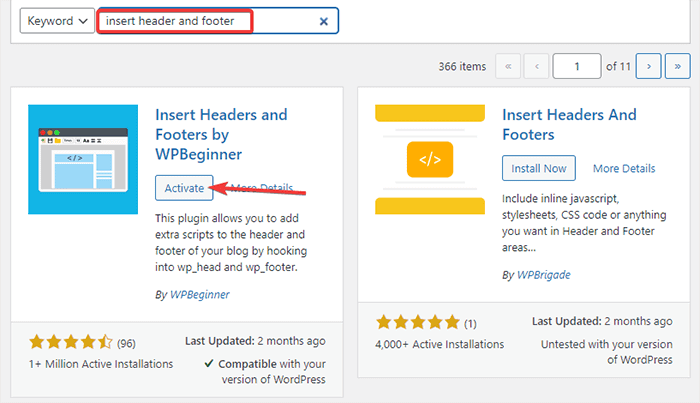

- Vaya a Complementos -> Agregar nuevo desde su Panel de administración de WordPress.

- Ahora, busque el complemento Insertar encabezados y pies de página en la barra de búsqueda y luego instale y active el complemento.

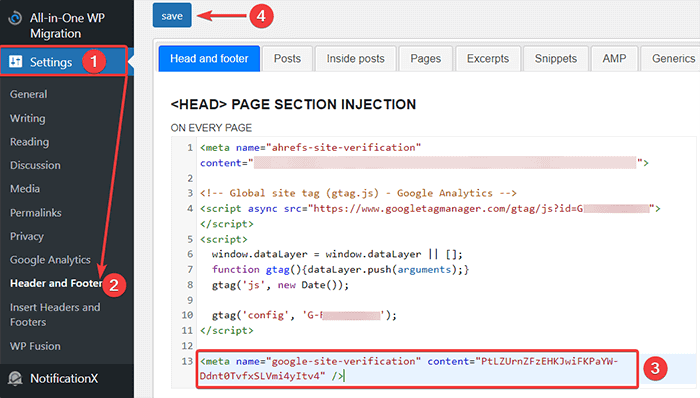

- Después de eso, redirija a Configuración -> Encabezado y pie de página desde su panel de WordPress y luego pegue el código copiado en la pestaña Encabezado y pie de página. Una vez que haya terminado, haga clic en el botón Guardar.

- Vuelva a la pestaña Consola de búsqueda de Google en su navegador. Luego, haga clic en el botón verificar.

- Google verifica la propiedad y muestra el mensaje completo una vez que está hecho.

- Haga clic en la opción "Ir a la propiedad" para acceder al panel de Google Search Console.

Ahora, regrese a la herramienta de prueba Open robot.txt y pruebe su robots.txt como se mencionó anteriormente.

Ventajas del archivo Robots.txt

Estos son los beneficios de usar el archivo Robots.txt en el contexto de SEO:

- Ayuda a optimizar los presupuestos de rastreo del motor de búsqueda al omitir la indexación en las páginas que no desea que rastreen los bots. Esto crea una prioridad para que el motor de búsqueda rastree solo las páginas que son importantes para usted.

- Ayuda a optimizar el servidor web al restringir los bots que consumen recursos innecesariamente.

- Ayuda a ocultar las páginas de inicio de sesión, las páginas de destino y las páginas de agradecimiento de la indexación de los motores de búsqueda. Por lo tanto, optimiza el rendimiento del sitio web.

Contras del archivo robots.txt

- Crear un archivo robots.txt es bastante fácil, como hemos explicado anteriormente. Sin embargo, el archivo robots.txt también incluye las URL de sus páginas internas que no desea que indexen los robots de rastreo, como la página de inicio de sesión. Esto hace que su sitio web sea vulnerable a las brechas de seguridad.

- Si bien crear un archivo robots.txt es fácil, cometer incluso un simple error puede arruinar todo su esfuerzo. Por ejemplo, si agrega o extravía un solo carácter en el archivo, estropea todos sus esfuerzos de SEO.

Preguntas frecuentes (FAQ)

¿Qué es el rastreo web?

Los motores de búsqueda envían sus rastreadores web (también conocidos como bots o arañas) a través de la web. Estos bots son un software inteligente que navega por toda la web para descubrir nuevas páginas, enlaces y sitios web. Este proceso de descubrimiento se conoce como rastreo web.

¿Qué es la indexación?

Cuando los rastreadores web descubren su sitio web, organizan sus páginas en una estructura de datos utilizable. Este proceso de organización se denomina indexación.

¿Qué es el presupuesto de rastreo?

Un presupuesto de rastreo es un límite a la cantidad de URL que un robot de búsqueda puede rastrear en una sesión determinada. Cada sitio tiene una asignación de presupuesto de rastreo específica. Por lo tanto, debe asegurarse de gastarlo de la manera que sea más beneficiosa para su sitio.

Por ejemplo, si tiene varias páginas en su sitio, debe asignar el presupuesto de rastreo a las páginas más valiosas. Por lo tanto, puede mencionar la URL de la página en su archivo robots.txt.

Conclusión

Cuando se trabaja en el SEO de un sitio web, la mayoría de los usuarios se enfocan en crear mapas de sitio, trabajar en vínculos de retroceso, investigar palabras clave y optimizar el contenido. Solo unos pocos webmasters prestan atención al archivo robots.txt.

Es posible que el archivo robots.txt no juegue un papel importante cuando inicie un sitio. Sin embargo, a medida que crece su sitio web, prestar atención al archivo robots.txt produce mejores resultados.

Además, existe el mito de que el bloqueo de categorías, páginas de archivo y etiquetas aumenta la tasa de rastreo y promueve una indexación más rápida. Es falso.

Siga los métodos que mencionamos anteriormente para crear su archivo robots.txt.

Esperamos que este artículo lo haya ayudado a resolver su consulta sobre cómo crear y optimizar WordPress robots.txt para SEO.

Si desea leer más artículos útiles relacionados con WordPress, puede leer los siguientes artículos:

- ¿Cómo crear un mapa del sitio en WordPress?

- ¿Cómo iniciar un blog de WordPress?