Como otimizar o WordPress Robots.txt para SEO com exemplo

Publicados: 2021-12-20SEO tem sido uma prioridade para os proprietários de sites. Com os cinco primeiros resultados ganhando 75% dos cliques, a corrida pela classificação mais alta tem sido um desafio. Existem várias técnicas de SEO off-page e on-page que entram em jogo. Otimizar o arquivo Robot.txt é um desses truques que podem fortalecer o SEO do seu site.

No entanto, a maioria dos iniciantes não sabe como otimizar o WordPress Robots.txt para SEO. Alguns podem nem saber o que é um arquivo robots.txt.

Felizmente, este artigo está em seu socorro.

Aqui, explicaremos o que é um arquivo robots.txt, como criar o arquivo robots.txt e como otimizar o arquivo robots.txt para SEO. Também adicionamos algumas perguntas frequentes no final. Portanto, certifique-se de estar conosco até o final.

Agora, vamos começar!

Índice

- O que é um arquivo Robots.txt?

- Como é um arquivo Robots.txt?

- Por que você precisa de um arquivo Robots.txt no WordPress?

- Como criar um Robots.txt para o seu site?

- Método 1: Criando o arquivo Robots.txt usando o plug-in Rank Math

- Método 2: Criando o arquivo Robots.txt usando FTP

- Onde colocar seu arquivo Robots.txt?

- Como testar o arquivo Robots.txt?

- Prós do arquivo Robots.txt

- Contras do arquivo robots.txt

- Perguntas frequentes (FAQs)

- O que é rastreamento na web?

- O que é indexação?

- Qual é o orçamento de rastreamento?

- Conclusão

O que é um arquivo Robots.txt?

Robots.txt no WordPress é um arquivo de texto simples que informa aos robôs do mecanismo de pesquisa quais páginas do seu site devem ser rastreadas e indexadas. Você também pode formatar o arquivo para excluir as páginas da indexação.

O robots.txt é armazenado no diretório raiz do WordPress. Este arquivo tem um formato básico que se parece com isso:

User-agent: [user-name] Disallow: [URL of the string not to be crawled] Allow: [URL of the string to be crawled] Sitemap: [URL of your WordPress XML Sitemap]Como é um arquivo Robots.txt?

Um arquivo robots.txt é simplesmente algumas linhas de texto que orientam os mecanismos de pesquisa sobre como e o que rastrear em seu site. Você tem várias linhas neste arquivo para permitir ou restringir URLs de páginas específicas. Você também pode adicionar vários sitemaps. Se você não permitir um URL, os bots do mecanismo de pesquisa não rastrearão essa página.

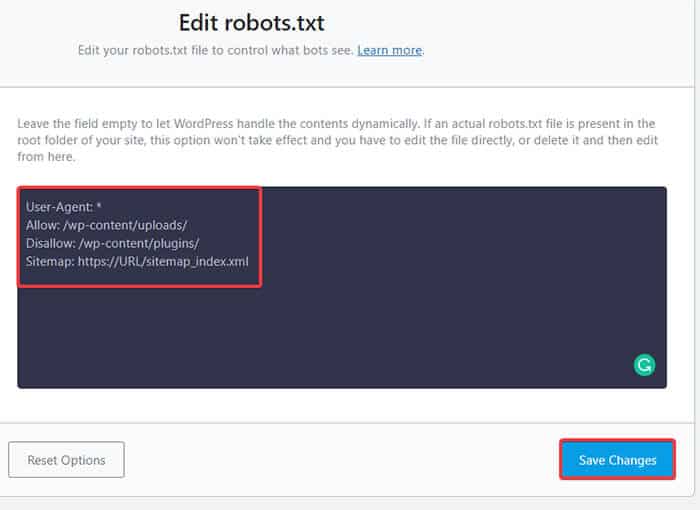

Aqui está um exemplo do arquivo robots.txt:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Sitemap: https://URL/sitemap_index.xmlAgora, vamos aprender sobre esses quatro termos principais que você pode encontrar em um arquivo robots:

- User-agent : User-agent é o rastreador da Web específico ao qual você fornece instruções de rastreamento. Geralmente é um mecanismo de busca.

- Permitir : permitir é o comando que informa ao Googlebot que ele pode acessar uma página ou subpasta mesmo que sua subpasta ou uma página pai não seja permitida.

- Disallow : O comando disallow diz a um agente de usuário para não rastrear um URL específico. Você só pode incluir uma linha “Disallow:” para cada URL.

- Sitemap : o sitemap é usado para indicar a localização de qualquer sitemap XML relacionado a esse URL. Este comando é suportado apenas pelo Google, Bing, Ask e Yahoo.

No exemplo acima, permitimos que os bots de pesquisa rastreassem e indexassem a pasta de uploads, mas restringimos a pasta de plugins. No final, permitimos a indexação do sitemap XML.

O sinal de asterisco após User-Agent significa que o texto se aplica a todos os bots de mecanismos de pesquisa. Cada mecanismo de pesquisa tem seu agente de usuário para indexar sites. Aqui estão alguns agentes do usuário de alguns mecanismos de pesquisa populares:

- Google: Googlebot

- Imagens do Googlebot: Googlebot-Image

- Googlebot News: Googlebot-News

- Vídeo do Googlebot: Googlebot-Vídeo

- Yahoo: Slurp Bot

- Bing: Bingbot

- Alexa da Amazon: ia_archiver

- DuckDuckGo: DuckDuckBot

- Yandex: YandexBot

- Baidu: Baiduspider

- Exalead: ExaBot

Existem tantos agentes de usuário por aí hoje em dia. Se você deseja se concentrar em um mecanismo de pesquisa específico, pode até mesmo especificá-lo no arquivo robots.txt. Ou seja, para configurar instruções para o Googlebot, você pode escrever a primeira linha do arquivo robots.txt como:

Agente do usuário: Googlebot

Por que você precisa de um arquivo Robots.txt no WordPress?

Os bots de pesquisa rastrearão e indexarão seu site mesmo se você não tiver um arquivo robots.txt. Então, por que você realmente precisa disso? Bem, com o arquivo robots.txt, você pode direcionar os mecanismos de pesquisa para priorizar a indexação em determinadas páginas. Além disso, você pode excluir páginas ou pastas que não deseja indexar.

Isso não tem um impacto maior quando você primeiro comece um blog e não tenha muito conteúdo. No entanto, depois que seu site crescer e tiver muito conteúdo, talvez seja necessário priorizar a indexação em uma determinada página/post/pasta e negar alguns.

Você vê, há uma cota para cada bot de pesquisa para cada site. Isso significa que os bots rastreiam um determinado número de páginas em uma determinada sessão de rastreamento. Se os bots não terminarem de rastrear nessa sessão específica, o bot volta e retoma o rastreamento na próxima sessão. Isso diminui a taxa de indexação do seu site.

Assim, usando o arquivo robots.txt, você pode direcionar os bots de pesquisa para quais páginas, arquivos e pastas deseja indexar e quais incluir. Ao fazer isso, você salva a cota de rastreamento. Pode não ser a maneira mais segura de ocultar seu conteúdo do público, mas impede que esses conteúdos excluídos apareçam nas SERPs.

Como criar um Robots.txt para o seu site?

Você pode criar robots.txt de duas maneiras diferentes. Explicaremos esses métodos abaixo. Você pode então seguir o método que achar que funcionará melhor para você.

Método 1: Criando o arquivo Robots.txt usando o plug-in Rank Math

Aqui, mostraremos como criar um arquivo robots.txt usando o popular plugin Rank Math.

Rank Math é um plugin SEO WordPress que facilita a otimização do conteúdo do seu site com sugestões integradas baseadas em práticas recomendadas amplamente aceitas. Usando esta ferramenta útil, você pode personalizar facilmente configurações importantes de SEO e controlar quais páginas são indexáveis.

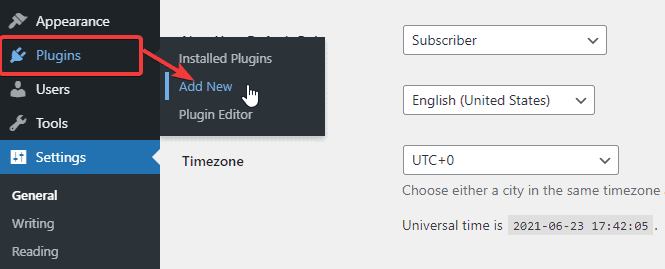

Para criar um arquivo robots.txt usando o plug-in Rank Math, primeiro, baixe o plug-in acessando Plugins -> Adicionar novo no painel de administração do WordPress.

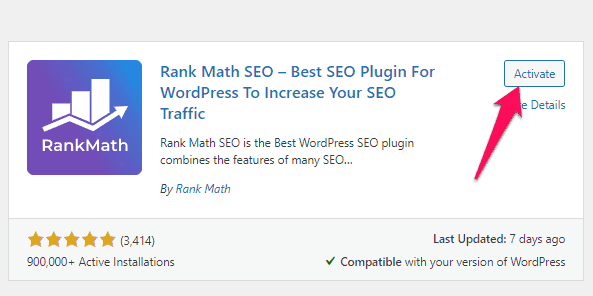

Agora, procure por Rank Math na barra de pesquisa e clique no botão Instalar agora e ativar assim que encontrar o plug-in.

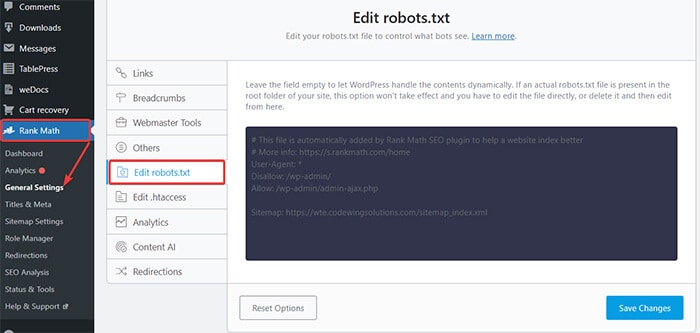

Depois de ativar o plug-in, vá para Rank Math -> General Settings -> Edit robots.txt no painel do WordPress.

Agora, insira o código a seguir ou copie o código mencionado no exemplo anterior no espaço em branco e clique no botão Salvar alterações .

Ai está! Você criou com sucesso um arquivo robots.txt usando o plug-in Rank Math.

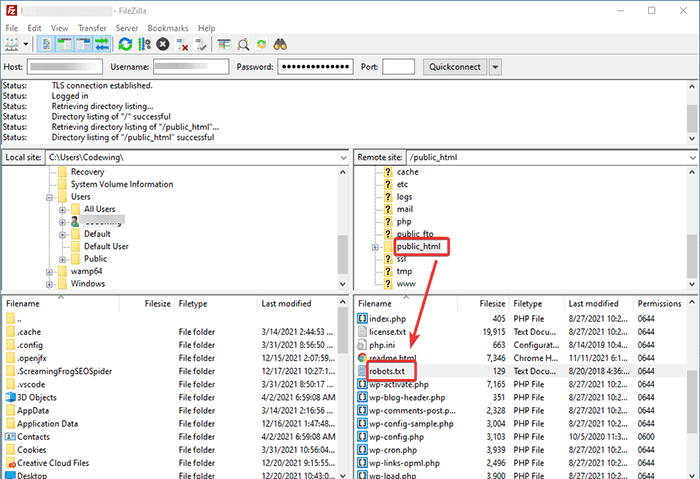

Método 2: Criando o arquivo Robots.txt usando FTP

O segundo método envolve a criação de um arquivo robots.txt manualmente em um computador local e, em seguida, carregá-lo na pasta raiz do seu site WordPress.

Você precisará acessar sua hospedagem WordPress usando um cliente FTP. Depois de fazer login no seu cliente FTP, você pode ver o arquivo robots.txt na pasta raiz do site. Clique com o botão direito do mouse e selecione a opção Editar .

Agora, adicione sua regra personalizada ao arquivo e salve as alterações. Por exemplo:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpSe você não vir o arquivo na pasta raiz, poderá criá-lo em seu computador local usando o bloco de notas. Adicione suas regras nele e, em seguida, faça o upload para sua pasta de root usando o FTP.

Onde colocar seu arquivo Robots.txt?

Você deve sempre colocar o arquivo robots.txt no diretório raiz do seu site. Por exemplo, se seu site for domainname.com , o domínio do arquivo robots.txt será https://domainname.com/robots.txt.

Além de adicionar o arquivo robots.txt em seu diretório raiz, aqui estão algumas dicas extras:

- É obrigatório nomear o arquivo como “robots.txt”.

- O nome do arquivo diferencia maiúsculas de minúsculas. Assim, você precisa acertar ou então não vai funcionar.

- Você precisa adicionar uma nova linha para cada nova regra.

- Adicione um sinal “$” para indicar o fim de uma URL.

- Use cada user agent apenas uma vez.

Como testar o arquivo Robots.txt?

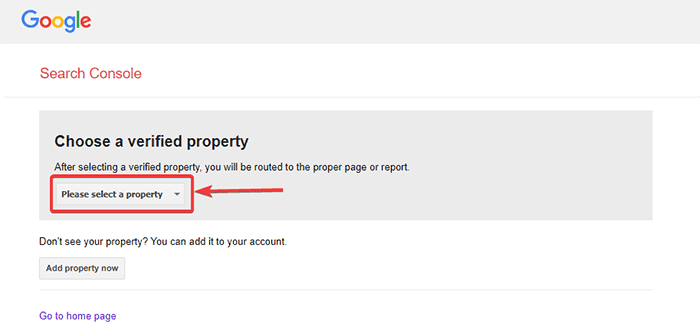

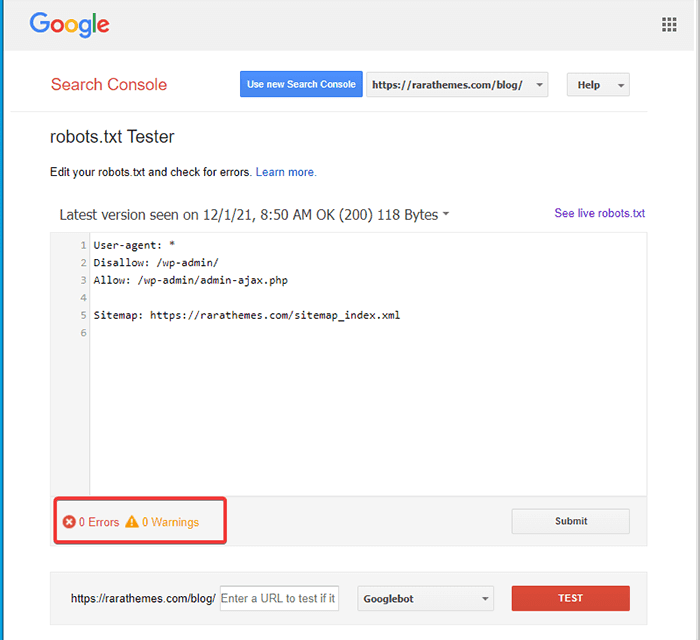

Depois de criar o arquivo robots.txt, você pode testá-lo usando o Google Search Console. Aqui, você encontrará a ferramenta de teste Open robot.txt.

- Selecione sua propriedade na lista suspensa fornecida.

A ferramenta busca o arquivo robots.txt do seu site e destaca os erros e avisa se encontrar algum.

Observação : a opção de propriedade suspensa aparece apenas se você vinculou seu site WordPress ao Google Search Console.

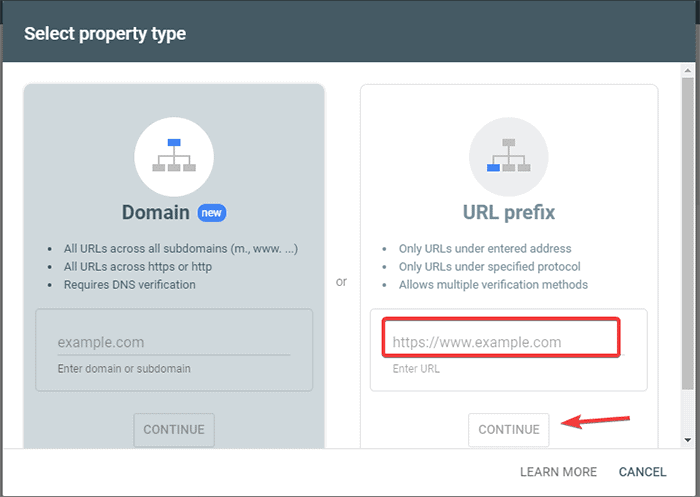

Se você ainda não fez isso, pode vincular rapidamente seu site da seguinte maneira:

- Faça login no Google Search Console e crie uma conta. Você pode configurar sua conta usando seu domínio ou prefixo de URL. Recomenda-se usar o prefixo de URL, pois é comparativamente mais fácil.

- Insira o URL do seu site.

- Agora, clique no botão “Continuar”.

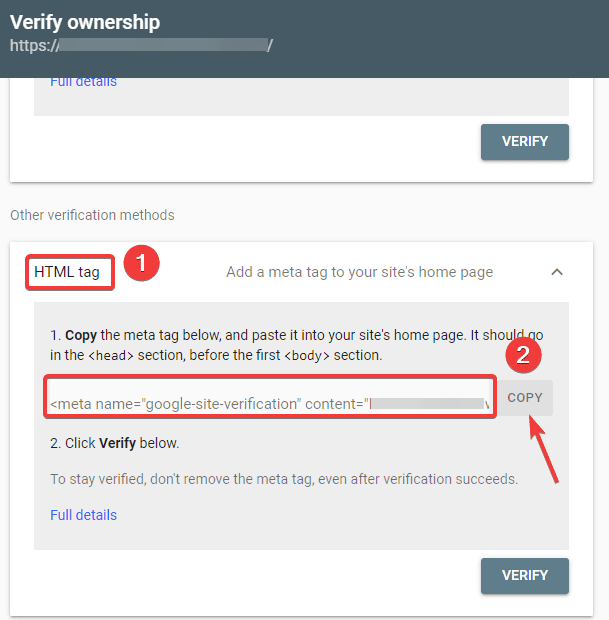

- Agora você deve verificar a propriedade do site. Você pode fazer isso usando qualquer uma das opções fornecidas. No entanto, recomendamos usar a opção de tag HTML.

- Copie o código fornecido e, em seguida, vá para o painel do WordPress.

Agora você pode verificar o código usando o plug-in Insert Headers and Footers. Verificar:

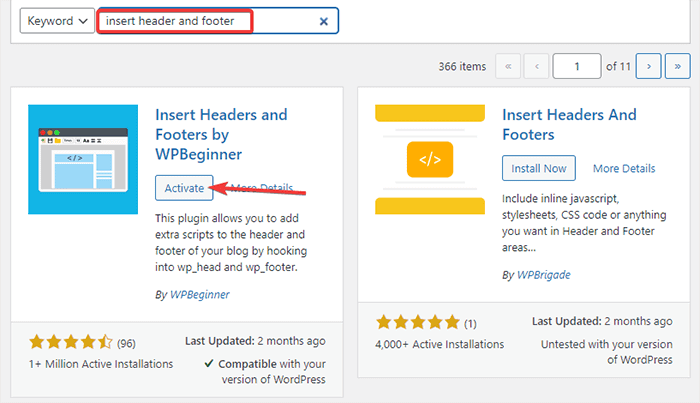

- Vá para Plugins -> Adicionar novo do seu painel de administração do WordPress.

- Agora, procure o plug-in Inserir cabeçalhos e rodapés na barra de pesquisa e, em seguida, instale e ative o plug-in.

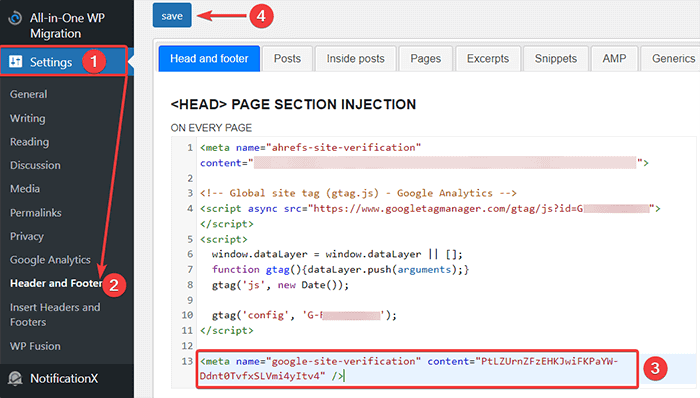

- Depois disso, redirecione para Configurações -> Cabeçalho e Rodapé do seu Painel do WordPress e cole o código copiado na guia Cabeçalho e rodapé. Quando terminar, clique no botão Salvar.

- Volte para a guia Google Search Console no seu navegador. Em seguida, clique no botão verificar.

- O Google verifica a propriedade e exibe a mensagem concluída assim que terminar.

- Clique na opção “Ir para a propriedade” para acessar o painel do Google Search Console.

Agora, volte para a ferramenta Open robot.txt tester e teste seu robots.txt como mencionado acima.

Prós do arquivo Robots.txt

Aqui estão os benefícios de usar o arquivo Robots.txt no contexto de SEO:

- Ele ajuda a otimizar os orçamentos de rastreamento do mecanismo de pesquisa, ignorando a indexação nas páginas que você não deseja que os bots rastreiem. Isso cria uma prioridade para o mecanismo de pesquisa rastrear apenas as páginas que são importantes para você.

- Ele ajuda a otimizar o servidor web restringindo os bots que estão consumindo recursos desnecessariamente.

- Ajuda a ocultar as páginas de login, páginas de destino e páginas de agradecimento da indexação pelos mecanismos de pesquisa. Assim, otimiza o desempenho do site.

Contras do arquivo robots.txt

- Criar um arquivo robots.txt é muito fácil, como explicamos acima. No entanto, o arquivo robots.txt também inclui os URLs para suas páginas internas que você não deseja que os bots de rastreamento indexem, como a página de login. Isso torna seu site vulnerável a violações de segurança.

- Embora a criação de um arquivo robots.txt seja fácil, cometer até mesmo um simples erro pode levar todo o seu esforço pelo ralo. Por exemplo, se você adicionar ou extraviar um único caractere no arquivo, isso atrapalhará todos os seus esforços de SEO.

Perguntas frequentes (FAQs)

O que é rastreamento na web?

Os mecanismos de pesquisa enviam seus rastreadores da web (também conhecidos como bots ou spiders) pela web. Esses bots são softwares inteligentes que navegam por toda a web para descobrir novas páginas, links e sites. Esse processo de descoberta é conhecido como rastreamento da web.

O que é indexação?

Quando os rastreadores da Web descobrem seu site, eles organizam suas páginas em uma estrutura de dados utilizável. Esse processo de organização é chamado de indexação.

Qual é o orçamento de rastreamento?

Um orçamento de rastreamento é um limite de quantos URLs um bot de pesquisa pode rastrear em uma determinada sessão. Cada site tem uma alocação de orçamento de rastreamento específica. Portanto, você precisa garantir que o gaste da maneira mais benéfica para o seu site.

Por exemplo, se você tiver várias páginas em seu site, precisará alocar o orçamento de rastreamento para as páginas mais valiosas. Assim, você pode mencionar o URL da página em seu arquivo robots.txt.

Conclusão

Ao trabalhar no SEO de um site, a maioria dos usuários se concentra na criação de sitemaps, trabalhando em backlinks, pesquisando palavras-chave e otimizando o conteúdo. Apenas alguns webmasters prestam atenção ao arquivo robots.txt.

O arquivo robots.txt pode não desempenhar um papel importante quando você está iniciando um site. No entanto, à medida que seu site cresce, prestar atenção ao arquivo robots.txt produz melhores resultados.

Além disso, existe um mito de que bloquear categorias, páginas de arquivo e tags aumentam a taxa de rastreamento e promovem uma indexação mais rápida. É falso.

Siga os métodos mencionados acima para criar seu arquivo robots.txt.

Esperamos que este artigo tenha ajudado você a classificar sua consulta sobre como criar e otimizar o WordPress robots.txt para SEO.

Se você quiser ler artigos mais úteis relacionados ao WordPress, você pode ler os seguintes artigos:

- Como criar um mapa do site no WordPress?

- Como iniciar um blog WordPress?