Come ottimizzare WordPress Robots.txt per SEO con l'esempio

Pubblicato: 2021-12-20La SEO è stata una priorità assoluta per i proprietari di siti web. Con i primi cinque risultati che hanno ottenuto il 75% dei clic, la corsa per un ranking più alto è stata una sfida. Ci sono varie tecniche SEO off-page e on-page che entrano in gioco. L'ottimizzazione del file Robot.txt è uno di quei trucchi che possono rafforzare la SEO per il tuo sito.

Tuttavia, la maggior parte dei principianti non sa come ottimizzare WordPress Robots.txt per SEO. Alcuni potrebbero non sapere nemmeno cosa sia un file robots.txt in primo luogo.

Fortunatamente, questo articolo è in tuo soccorso.

Qui spiegheremo cos'è un file robots.txt, come creare il file robots.txt e come ottimizzare il file robots.txt per la SEO. Abbiamo anche aggiunto alcune FAQ alla fine. Quindi assicurati di essere con noi fino alla fine.

Ora, iniziamo!

Sommario

- Che cos'è un file Robots.txt?

- Che aspetto ha un file Robots.txt?

- Perché hai bisogno di un file Robots.txt in WordPress?

- Come creare un Robots.txt per il tuo sito web?

- Metodo 1: creazione del file Robots.txt utilizzando il plugin Rank Math

- Metodo 2: creazione del file Robots.txt tramite FTP

- Dove mettere il tuo file Robots.txt?

- Come testare il file Robots.txt?

- Vantaggi del file Robots.txt

- Contro del file robots.txt

- Domande frequenti (FAQ)

- Che cos'è la scansione del Web?

- Che cos'è l'indicizzazione?

- Qual è il budget di scansione?

- Conclusione

Che cos'è un file Robots.txt?

Robots.txt in WordPress è un semplice file di testo che informa i robot dei motori di ricerca su quali pagine del tuo sito eseguire la scansione e l'indicizzazione. Puoi anche formattare il file per escludere le pagine dall'indicizzazione.

Il robots.txt è memorizzato nella directory principale di WordPress. Questo file ha un formato di base simile a questo:

User-agent: [user-name] Disallow: [URL of the string not to be crawled] Allow: [URL of the string to be crawled] Sitemap: [URL of your WordPress XML Sitemap]Che aspetto ha un file Robots.txt?

Un file robots.txt è costituito semplicemente da poche righe di testo che indirizzano i motori di ricerca su come e cosa eseguire la scansione del tuo sito. Hai più righe su questo file per consentire o limitare URL di pagina specifici. Puoi anche aggiungere più mappe del sito. Se non consenti un URL, i robot dei motori di ricerca non eseguono la scansione di quella pagina.

Ecco un esempio del file robots.txt:

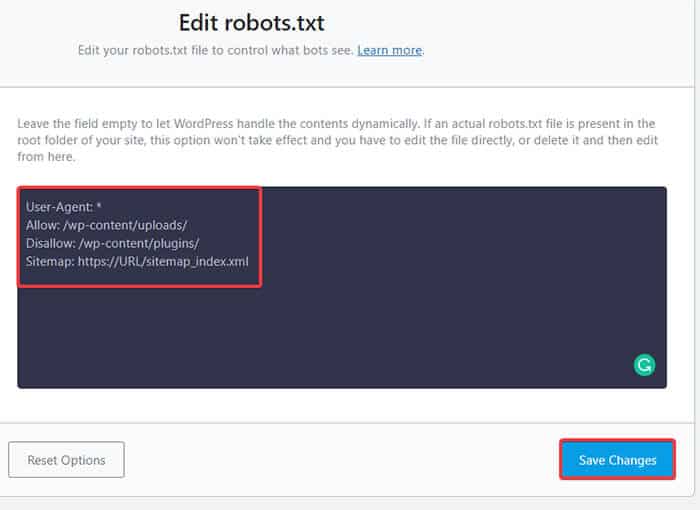

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Sitemap: https://URL/sitemap_index.xmlOra, impariamo a conoscere questi quattro termini principali che puoi trovare in un file robots:

- User-agent : User-agent è il web crawler specifico a cui fornisci le istruzioni di scansione. Di solito è un motore di ricerca.

- Consenti : Consenti è il comando che dice a Googlebot che può accedere a una pagina o una sottocartella anche se la sua sottocartella o una pagina principale potrebbero non essere consentite.

- Disallow : il comando disallow dice a un agente utente di non eseguire la scansione di un determinato URL. Puoi includere solo una riga "Disallow:" per ogni URL.

- Mappa del sito: la mappa del sito viene utilizzata per richiamare la posizione di qualsiasi mappa del sito XML correlata a questo URL. Questo comando è supportato solo da Google, Bing, Ask e Yahoo.

Nell'esempio precedente, abbiamo consentito ai robot di ricerca di eseguire la scansione e l'indicizzazione della cartella dei caricamenti, ma abbiamo limitato la cartella dei plug-in. Alla fine, abbiamo consentito l'indicizzazione della mappa del sito XML.

Il segno di asterisco dopo User-Agent significa che il testo si applica a tutti i bot dei motori di ricerca. Ogni motore di ricerca ha il suo user agent per indicizzare i siti. Ecco alcuni user agent di alcuni popolari motori di ricerca:

- Google: Googlebot

- Immagini di Googlebot: immagine di Googlebot

- Googlebot News: Googlebot-Notizie

- Video di Googlebot: video di Googlebot

- Yahoo: Slurp Bot

- Bing: Bingbot

- Alexa di Amazon: ia_archiver

- DuckDuckGo: DuckDuckBot

- Yandex: YandexBot

- Baidu: Baiduspider

- Exalead: ExaBot

Ci sono così tanti user-agenti là fuori al giorno d'oggi. Se vuoi concentrarti su un particolare motore di ricerca, puoi persino specificarlo nel file robots.txt. Cioè, per impostare le istruzioni per Googlebot, puoi scrivere la prima riga del tuo file robots.txt come:

User-agent: Googlebot

Perché hai bisogno di un file Robots.txt in WordPress?

I robot di ricerca eseguiranno la scansione e indicizzeranno il tuo sito anche se non disponi di un file robots.txt. Allora, perché ne avresti davvero bisogno? Bene, con il file robots.txt, puoi indirizzare i motori di ricerca a dare la priorità all'indicizzazione su determinate pagine. Inoltre, puoi escludere pagine o cartelle che non desideri indicizzare.

Questo non ha un impatto maggiore quando lo fai per la prima volta avviare un blog e non avere molti contenuti. Tuttavia, dopo che il tuo sito è cresciuto e ha molti contenuti, potresti dover dare la priorità all'indicizzazione su una determinata pagina/post/cartella e annullarne alcuni.

Vedi, c'è una quota per ogni bot di ricerca per ogni sito web. Ciò significa che i robot eseguono la scansione su un certo numero di pagine in una determinata sessione di scansione. Se i bot non terminano la scansione in quella particolare sessione, il bot torna e riprende la scansione nella sessione successiva. Questo rallenta il tasso di indicizzazione del tuo sito web.

Quindi, utilizzando il file robots.txt, puoi indirizzare i robot di ricerca su quali pagine, file e cartelle desideri indicizzare e quali includere. In questo modo, salvi la quota di scansione. Potrebbe non essere il modo più sicuro per nascondere i tuoi contenuti al pubblico, ma impedisce che i contenuti esclusi appaiano nelle SERP.

Come creare un Robots.txt per il tuo sito web?

Puoi creare robots.txt in due modi diversi. Spiegheremo questi metodi di seguito. Puoi quindi seguire il metodo che ritieni funzionerà meglio per te.

Metodo 1: creazione del file Robots.txt utilizzando il plugin Rank Math

Qui ti mostreremo come creare un file robots.txt usando il popolare plugin Rank Math.

Rank Math è un plug-in SEO per WordPress che semplifica l'ottimizzazione dei contenuti del tuo sito Web con suggerimenti integrati basati su best practice ampiamente accettate. Utilizzando questo pratico strumento, puoi facilmente personalizzare importanti impostazioni SEO e controllare quali pagine sono indicizzabili.

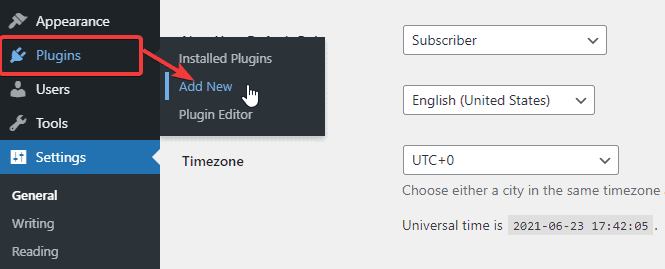

Per creare un file robots.txt utilizzando il plug-in Rank Math, prima scarica il plug-in andando su Plugin -> Aggiungi nuovo dalla dashboard di amministrazione di WordPress.

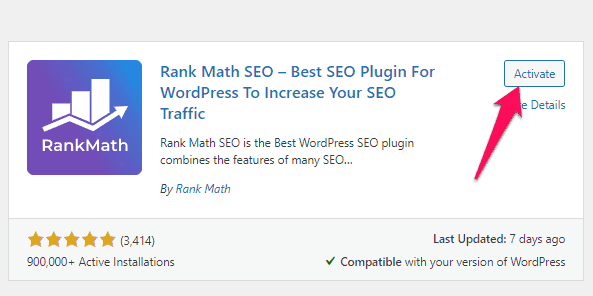

Ora, cerca Rank Math nella barra di ricerca e fai clic sul pulsante Installa ora e attiva una volta trovato il plug-in.

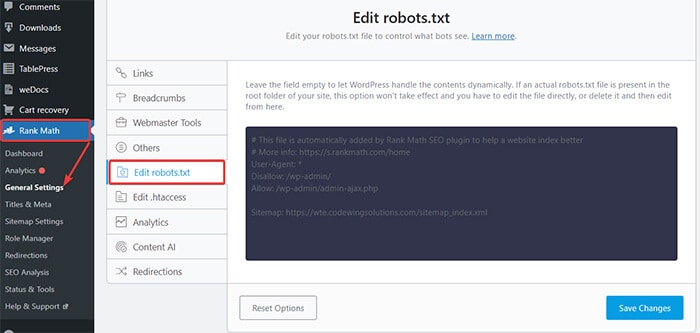

Una volta attivato il plug-in, vai su Classifica matematica -> Impostazioni generali -> Modifica robots.txt dalla dashboard di WordPress.

Ora, inserisci il codice seguente o copia il codice menzionato nell'esempio precedente nello spazio vuoto e fai clic sul pulsante Salva modifiche .

Ecco qua! Hai creato con successo un file robots.txt usando il plugin Rank Math.

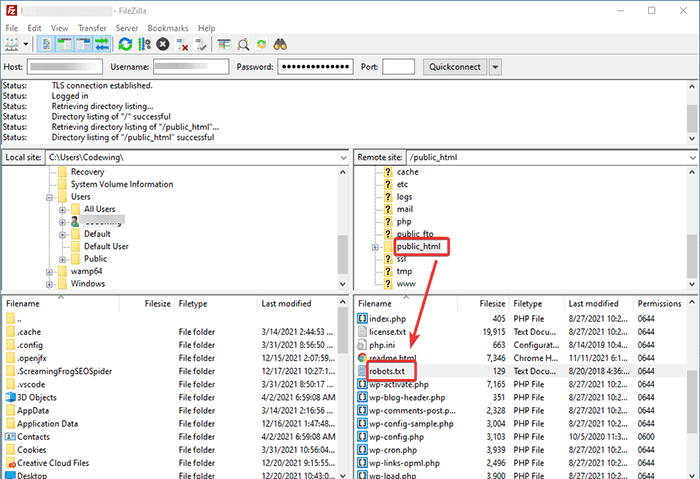

Metodo 2: creazione del file Robots.txt tramite FTP

Il secondo metodo prevede la creazione manuale di un file robots.txt su un computer locale e il caricamento nella cartella principale del tuo sito WordPress.

Dovrai accedere al tuo hosting WordPress utilizzando un client FTP. Dopo aver effettuato l'accesso al tuo client FTP, puoi vedere il file robots.txt nella cartella principale del sito web. Fare clic con il pulsante destro del mouse e selezionare l'opzione Modifica .

Ora aggiungi la tua regola personalizzata al file e salva le modifiche. Per esempio:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpSe non vedi il file nella cartella principale, puoi crearlo sul tuo computer locale usando il blocco note. Aggiungi le tue regole su di esso e quindi caricalo nella cartella del rooter utilizzando l'FTP.

Dove mettere il tuo file Robots.txt?

Dovresti sempre posizionare il tuo file robots.txt nella directory principale del tuo sito web. Ad esempio, se il tuo sito è nomedominio.com , il dominio del tuo file robots.txt sarà https://nomedominio.com/robots.txt.

Oltre ad aggiungere il file robots.txt nella directory principale, ecco alcuni suggerimenti aggiuntivi:

- È necessario nominare il file "robots.txt".

- Il nome del file fa distinzione tra maiuscole e minuscole. Quindi, devi farlo bene, altrimenti non funzionerà.

- Devi aggiungere una nuova riga per ogni nuova regola.

- Aggiungi un segno "$" per indicare la fine di un URL.

- Utilizzare ogni user-agent solo una volta.

Come testare il file Robots.txt?

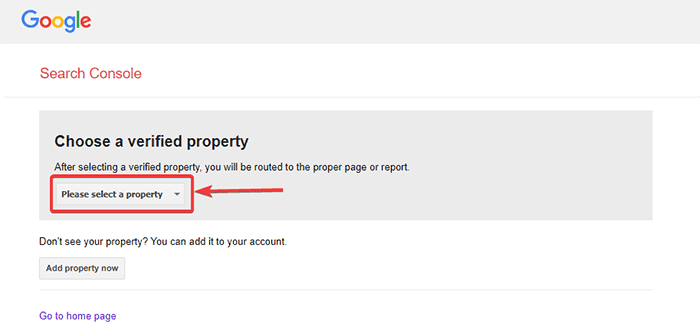

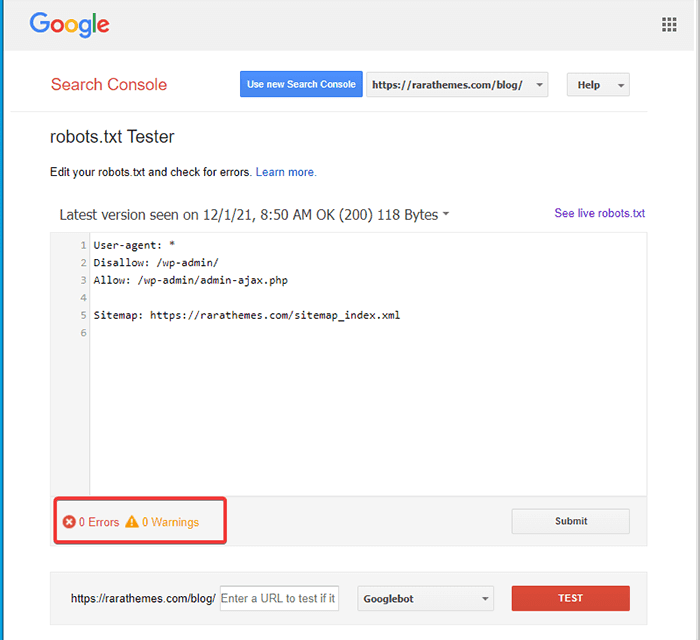

Dopo aver creato il file robots.txt, puoi testarlo utilizzando Google Search Console. Qui troverai lo strumento di test Apri robot.txt.

- Seleziona la tua proprietà dall'elenco a discesa fornito.

Lo strumento recupera il file robots.txt del tuo sito ed evidenzia gli errori e l'avviso se ne trova.

Nota : l'opzione della proprietà a discesa viene visualizzata solo se hai collegato il tuo sito WordPress con Google Search Console.

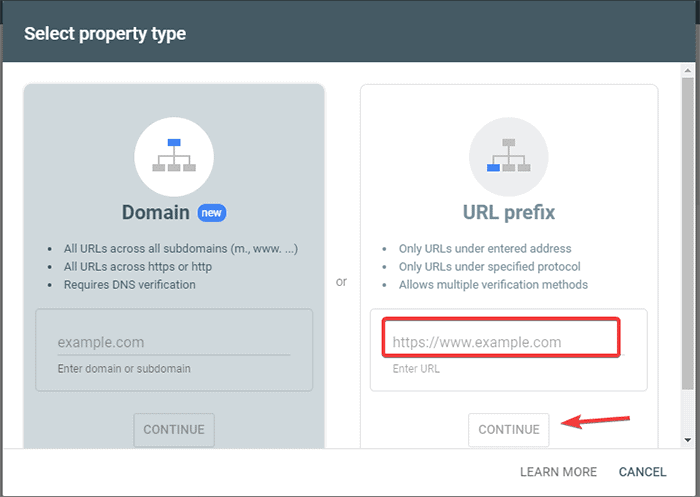

Se non l'hai fatto, puoi collegare rapidamente il tuo sito come segue:

- Accedi a Google Search Console e crea un account. Puoi configurare il tuo account utilizzando il tuo dominio o il prefisso URL. Si consiglia di utilizzare il prefisso URL in quanto è relativamente più semplice.

- Inserisci l'URL del tuo sito web.

- Ora, fai clic sul pulsante "Continua".

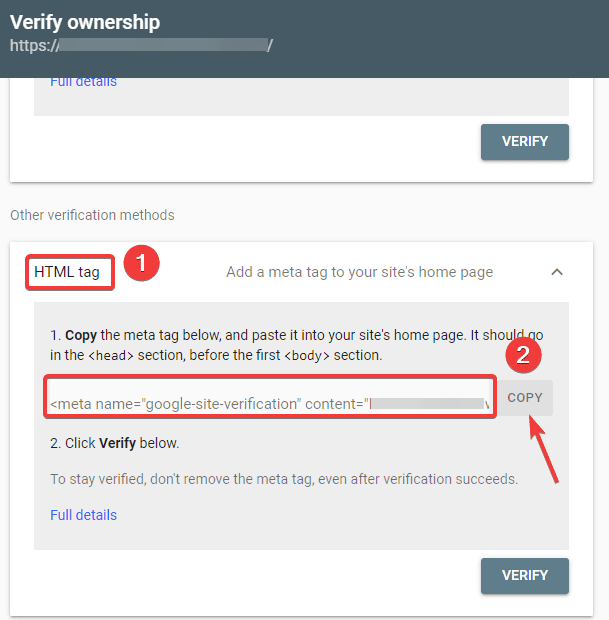

- Ora dovresti verificare la proprietà del sito. Puoi farlo usando una qualsiasi delle opzioni fornite. Tuttavia, consigliamo di utilizzare l'opzione tag HTML.

- Copia il codice fornito e poi vai alla dashboard di WordPress.

Ora puoi verificare il codice utilizzando il plug-in Inserisci intestazioni e piè di pagina. Verificare:

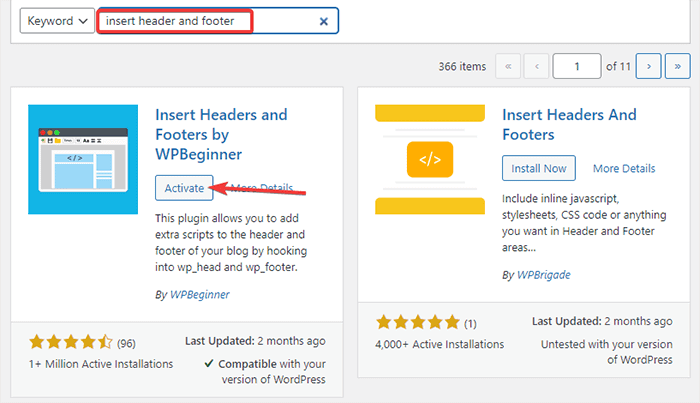

- Vai su Plugin -> Aggiungi nuovo dalla dashboard di amministrazione di WordPress.

- Ora, cerca il plug-in Inserisci intestazioni e piè di pagina nella barra di ricerca, quindi Installa e attiva il plug-in.

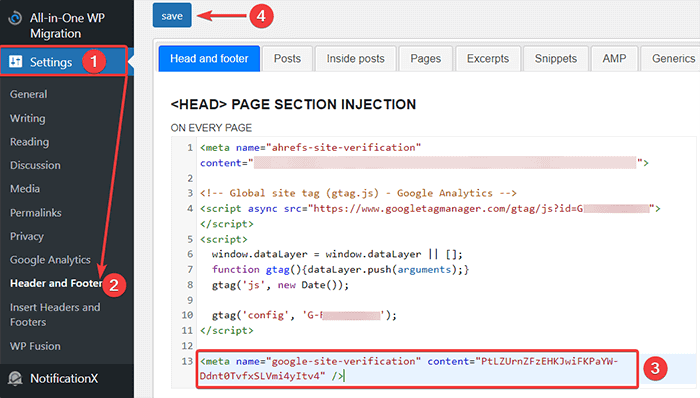

- Successivamente, reindirizza a Impostazioni -> Intestazione e piè di pagina dalla dashboard di WordPress e quindi incolla il codice copiato nella scheda Testa e piè di pagina. Al termine, fai clic sul pulsante Salva.

- Torna alla scheda Google Search Console sul tuo browser. Quindi, fare clic sul pulsante di verifica.

- Google verifica la proprietà e visualizza il messaggio completato una volta terminato.

- Fai clic sull'opzione "Vai alla proprietà" per accedere alla dashboard di Google Search Console.

Ora torna allo strumento di test Apri robot.txt e testa il tuo robots.txt come menzionato sopra.

Vantaggi del file Robots.txt

Ecco i vantaggi dell'utilizzo del file Robots.txt nel contesto SEO:

- Aiuta a ottimizzare i budget di scansione del motore di ricerca saltando l'indicizzazione sulle pagine che non si desidera vengano scansionate dai robot. Questo crea una priorità per il motore di ricerca per eseguire la scansione solo delle pagine che sono importanti per te.

- Aiuta a ottimizzare il server web limitando i bot che consumano risorse inutilmente.

- Aiuta a nascondere le pagine di accesso, le pagine di destinazione, le pagine di ringraziamento dall'indicizzazione dei motori di ricerca. Pertanto, ottimizza le prestazioni del sito web.

Contro del file robots.txt

- Creare un file robots.txt è abbastanza semplice, come abbiamo spiegato sopra. Tuttavia, il file robots.txt include anche gli URL delle tue pagine interne che non desideri vengano indicizzati dai bot di scansione, come la pagina di accesso. Ciò rende il tuo sito Web vulnerabile alle violazioni della sicurezza.

- Sebbene la creazione di un file robots.txt sia facile, anche commettere un semplice errore può vanificare tutti i tuoi sforzi. Ad esempio, se aggiungi o perdi un singolo carattere nel file, incasina tutti i tuoi sforzi SEO.

Domande frequenti (FAQ)

Che cos'è la scansione del Web?

I motori di ricerca inviano i loro web crawler (noti anche come bot o spider) attraverso il web. Questi bot sono software intelligenti che esplorano l'intero Web per scoprire nuove pagine, collegamenti e siti Web. Questo processo di individuazione è noto come scansione del Web.

Che cos'è l'indicizzazione?

Quando i web crawler scoprono il tuo sito web, organizzano le tue pagine in una struttura di dati utilizzabile. Questo processo di organizzazione è chiamato indicizzazione.

Qual è il budget di scansione?

Un budget di scansione è un limite al numero di URL che un bot di ricerca può eseguire la scansione in una determinata sessione. Ogni sito ha un'allocazione del budget di scansione specifica. Quindi devi assicurarti di spenderli nel modo più vantaggioso per il tuo sito.

Ad esempio, se hai più pagine sul tuo sito, devi allocare il budget di scansione alle pagine più preziose. Pertanto, puoi menzionare l'URL della pagina nel tuo file robots.txt.

Conclusione

Quando si lavora sulla SEO di un sito Web, la maggior parte degli utenti si concentra sulla creazione di mappe del sito, sul lavoro sui backlink, sulla ricerca di parole chiave e sull'ottimizzazione del contenuto. Solo pochi webmaster prestano attenzione al file robots.txt.

Il file robots.txt potrebbe non svolgere un ruolo importante quando avvii un sito. Tuttavia, man mano che il tuo sito web cresce, prestare attenzione al file robots.txt produce risultati migliori.

Inoltre, esiste un mito secondo cui il blocco di categorie, pagine di archivio e tag aumenta la velocità di scansione e promuove un'indicizzazione più rapida. È falso.

Segui i metodi sopra menzionati per creare il tuo file robots.txt.

Ci auguriamo che questo articolo ti abbia aiutato a risolvere la tua domanda su come creare e ottimizzare WordPress robots.txt per SEO.

Se vuoi leggere altri articoli utili relativi a WordPress, puoi leggere i seguenti articoli:

- Come creare una mappa del sito in WordPress?

- Come avviare un blog WordPress?