วิธีเพิ่มประสิทธิภาพ WordPress Robots.txt สำหรับ SEO ด้วยตัวอย่าง

เผยแพร่แล้ว: 2021-12-20SEO มีความสำคัญสูงสุดสำหรับเจ้าของเว็บไซต์ ด้วยผลลัพธ์ห้าอันดับแรกที่ได้รับการคลิกถึง 75% การแข่งขันเพื่ออันดับที่สูงขึ้นจึงเป็นเรื่องที่ท้าทาย มีเทคนิค SEO นอกหน้าและในหน้าต่างๆ ที่นำมาใช้ การเพิ่มประสิทธิภาพไฟล์ Robot.txt เป็นหนึ่งในเทคนิคที่สามารถเสริมสร้าง SEO สำหรับเว็บไซต์ของคุณ

อย่างไรก็ตาม ผู้เริ่มต้นส่วนใหญ่ไม่รู้วิธีเพิ่มประสิทธิภาพ WordPress Robots.txt สำหรับ SEO บางคนอาจไม่รู้ด้วยซ้ำว่าไฟล์ robots.txt คืออะไรตั้งแต่แรก

โชคดีที่บทความนี้ช่วยคุณได้

ในที่นี้ เราจะอธิบายว่าไฟล์ robots.txt คืออะไร วิธีสร้างไฟล์ robots.txt และวิธีเพิ่มประสิทธิภาพไฟล์ robots.txt สำหรับ SEO เราได้เพิ่มคำถามที่พบบ่อยในตอนท้าย ดังนั้นให้แน่ใจว่าคุณอยู่กับเราจนจบ

เอาล่ะ มาเริ่มกันเลย!

สารบัญ

- ไฟล์ Robots.txt คืออะไร

- ไฟล์ Robots.txt มีลักษณะอย่างไร

- ทำไมคุณถึงต้องการไฟล์ Robots.txt ใน WordPress?

- วิธีสร้าง Robots.txt สำหรับเว็บไซต์ของคุณ

- วิธีที่ 1: การสร้างไฟล์ Robots.txt โดยใช้ Rank Math Plugin

- วิธีที่ 2: การสร้างไฟล์ Robots.txt โดยใช้ FTP

- จะวางไฟล์ Robots.txt ของคุณไว้ที่ใด

- วิธีทดสอบไฟล์ Robots.txt

- ข้อดีของไฟล์ Robots.txt

- ข้อเสียของไฟล์ robots.txt

- คำถามที่พบบ่อย (FAQ)

- การรวบรวมข้อมูลเว็บคืออะไร?

- การจัดทำดัชนีคืออะไร?

- งบประมาณการรวบรวมข้อมูลคืออะไร?

- บทสรุป

ไฟล์ Robots.txt คืออะไร

Robots.txt ใน WordPress เป็นไฟล์ข้อความธรรมดาที่แจ้งบอทของเครื่องมือค้นหาว่าหน้าใดในไซต์ของคุณที่จะรวบรวมข้อมูลและจัดทำดัชนี คุณยังสามารถจัดรูปแบบไฟล์เพื่อแยกหน้าจากการจัดทำดัชนี

robots.txt ถูกเก็บไว้ในไดเรกทอรีรากของ WordPress ไฟล์นี้มีรูปแบบพื้นฐานที่มีลักษณะดังนี้:

User-agent: [user-name] Disallow: [URL of the string not to be crawled] Allow: [URL of the string to be crawled] Sitemap: [URL of your WordPress XML Sitemap]ไฟล์ Robots.txt มีลักษณะอย่างไร

ไฟล์ robots.txt เป็นเพียงข้อความสองสามบรรทัดที่นำเครื่องมือค้นหาเกี่ยวกับวิธีการและสิ่งที่จะรวบรวมข้อมูลบนเว็บไซต์ของคุณ คุณมีหลายบรรทัดในไฟล์นี้เพื่ออนุญาตหรือจำกัด URL ของหน้าเฉพาะ คุณยังสามารถเพิ่มแผนผังเว็บไซต์ได้หลายรายการ หากคุณไม่อนุญาต URL บอทของเครื่องมือค้นหาจะไม่รวบรวมข้อมูลจากหน้านั้น

นี่คือตัวอย่างไฟล์ robots.txt:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Sitemap: https://URL/sitemap_index.xmlตอนนี้ มาเรียนรู้เกี่ยวกับคำศัพท์หลักสี่คำเหล่านี้ที่คุณสามารถหาได้ในไฟล์โรบ็อต:

- User-agent : User-agent คือโปรแกรมรวบรวมข้อมูลเว็บเฉพาะที่คุณให้คำแนะนำในการรวบรวมข้อมูล มักจะเป็นเครื่องมือค้นหา

- อนุญาต : อนุญาต เป็นคำสั่งที่บอก Googlebot ว่าสามารถเข้าถึงหน้าหรือโฟลเดอร์ย่อยได้ แม้ว่าโฟลเดอร์ย่อยหรือหน้าหลักอาจไม่อนุญาต

- Disallow : คำสั่ง disallow จะบอก user-agent ไม่ให้รวบรวมข้อมูล URL เฉพาะ คุณสามารถใส่บรรทัด “Disallow:” ได้เพียงบรรทัดเดียวสำหรับแต่ละ URL

- แผนผังเว็บไซต์ : แผนผังเว็บไซต์ใช้เพื่อเรียกตำแหน่งของแผนผังเว็บไซต์ XML ที่เกี่ยวข้องกับ URL นี้ คำสั่งนี้รองรับโดย Google, Bing, Ask และ Yahoo เท่านั้น

ในตัวอย่างข้างต้น เราอนุญาตให้บอทการค้นหารวบรวมข้อมูลและจัดทำดัชนีโฟลเดอร์อัปโหลด แต่ได้จำกัดโฟลเดอร์ปลั๊กอินไว้ ในที่สุด เราอนุญาตให้สร้างดัชนีของแผนผังเว็บไซต์ XML

เครื่องหมายดอกจันหลัง User-Agent หมายถึงข้อความที่ใช้กับบอทของเครื่องมือค้นหาทั้งหมด เครื่องมือค้นหาแต่ละรายการมีตัวแทนผู้ใช้สำหรับสร้างดัชนีไซต์ ต่อไปนี้คือตัวแทนผู้ใช้ของเครื่องมือค้นหายอดนิยมบางรายการ:

- Google: Googlebot

- รูปภาพ Googlebot: Googlebot-Image

- Googlebot News: Googlebot-ข่าวสาร

- วิดีโอ Googlebot: Googlebot-Video

- Yahoo: Slurp Bot

- Bing: บิงบอต

- Alexa ของ Amazon: ia_archiver

- DuckDuckGo: DuckDuckBot

- ยานเดกซ์: YandexBot

- Baidu: ไป่ดูสไปเดอร์

- Exalead: ExaBot

มีตัวแทนผู้ใช้จำนวนมากในปัจจุบัน หากคุณต้องการเน้นที่เสิร์ชเอ็นจิ้นใดโดยเฉพาะ คุณสามารถระบุได้ในไฟล์ robots.txt กล่าวคือ ในการตั้งค่าคำแนะนำสำหรับ Googlebot คุณสามารถเขียนบรรทัดแรกของไฟล์ robots.txt ได้ดังนี้:

User-agent: Googlebot

ทำไมคุณถึงต้องการไฟล์ Robots.txt ใน WordPress?

บอทการค้นหาจะรวบรวมข้อมูลและจัดทำดัชนีเว็บไซต์ของคุณ แม้ว่าคุณจะไม่มีไฟล์ robots.txt ทำไมคุณถึงต้องการมันจริงๆ? ด้วยไฟล์ robots.txt คุณสามารถสั่งให้เครื่องมือค้นหาจัดลำดับความสำคัญของการจัดทำดัชนีในบางหน้าได้ นอกจากนี้ คุณสามารถยกเว้นหน้าหรือโฟลเดอร์ที่คุณไม่ต้องการสร้างดัชนีได้

สิ่งนี้ไม่มีผลกระทบมากขึ้นเมื่อคุณครั้งแรก เริ่มบล็อกและไม่มีเนื้อหามากมาย อย่างไรก็ตาม หลังจากที่ไซต์ของคุณเติบโตและมีเนื้อหาจำนวนมาก คุณอาจจำเป็นต้องจัดลำดับความสำคัญของการจัดทำดัชนีในหน้า/โพสต์/โฟลเดอร์บางหน้าและปฏิเสธบางรายการ

คุณเห็นไหมว่ามีโควต้าสำหรับบอทการค้นหาแต่ละรายการสำหรับแต่ละเว็บไซต์ นั่นหมายถึงบอทรวบรวมข้อมูลบนหน้าจำนวนหนึ่งในเซสชันการรวบรวมข้อมูลที่แน่นอน หากบ็อตรวบรวมข้อมูลไม่เสร็จในเซสชันนั้น บอทจะกลับมาและรวบรวมข้อมูลต่อในเซสชันถัดไป ทำให้อัตราการสร้างดัชนีเว็บไซต์ของคุณช้าลง

ดังนั้น เมื่อใช้ไฟล์ robots.txt คุณจะสามารถกำหนดบ็อตการค้นหาที่หน้า ไฟล์ และโฟลเดอร์ที่คุณต้องการสร้างดัชนี และรายการที่จะรวมไว้ คุณจะบันทึกโควต้าการรวบรวมข้อมูลได้ อาจไม่ใช่วิธีที่ปลอดภัยที่สุดในการซ่อนเนื้อหาของคุณจากสาธารณะ แต่จะป้องกันไม่ให้เนื้อหาที่ยกเว้นเหล่านั้นปรากฏใน SERP

วิธีสร้าง Robots.txt สำหรับเว็บไซต์ของคุณ

คุณสามารถสร้าง robots.txt ได้สองวิธี เราจะอธิบายวิธีการเหล่านั้นด้านล่าง จากนั้นคุณสามารถทำตามวิธีที่คุณคิดว่าจะได้ผลดีที่สุดสำหรับคุณ

วิธีที่ 1: การสร้างไฟล์ Robots.txt โดยใช้ Rank Math Plugin

ที่นี่ เราจะแสดงวิธีสร้างไฟล์ robots.txt โดยใช้ปลั๊กอิน Rank Math ยอดนิยม

Rank Math เป็นปลั๊กอิน SEO WordPress ที่ทำให้ง่ายต่อการเพิ่มประสิทธิภาพเนื้อหาเว็บไซต์ของคุณด้วยคำแนะนำในตัวตามแนวทางปฏิบัติที่ดีที่สุดที่ได้รับการยอมรับอย่างกว้างขวาง ด้วยเครื่องมือที่มีประโยชน์นี้ คุณสามารถปรับแต่งการตั้งค่า SEO ที่สำคัญและควบคุมว่าหน้าใดจัดทำดัชนีได้

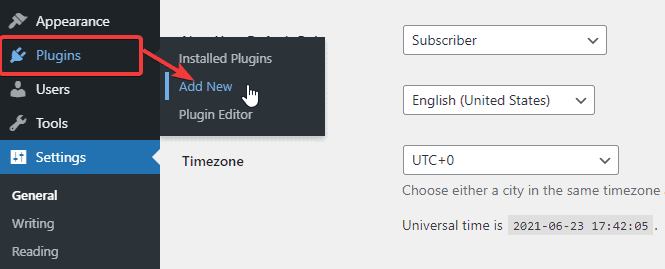

ในการสร้างไฟล์ robots.txt โดยใช้ปลั๊กอิน Rank Math ก่อนอื่นให้ดาวน์โหลดปลั๊กอินโดยไปที่ Plugins -> Add New จาก WordPress Admin Dashboard ของคุณ

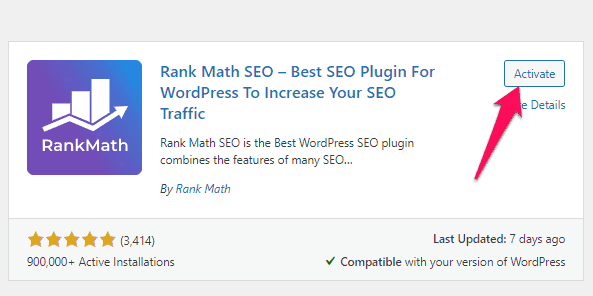

ตอนนี้ ให้ค้นหา Rank Math ในแถบค้นหา แล้วคลิกปุ่ม Install Now และ Activate เมื่อคุณพบปลั๊กอิน

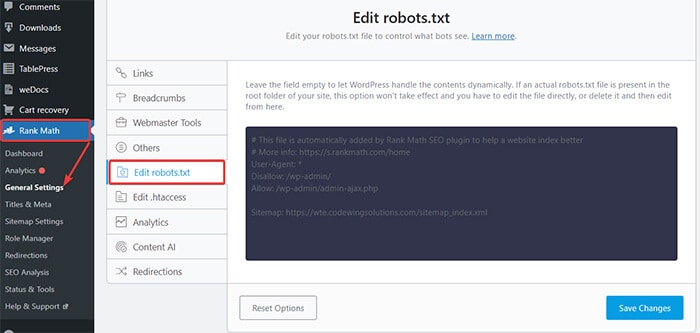

เมื่อคุณเปิดใช้งานปลั๊กอินแล้ว ตรงไปที่ อันดับคณิตศาสตร์ -> การตั้งค่าทั่วไป -> แก้ไข robots.txt จากแดชบอร์ด WordPress

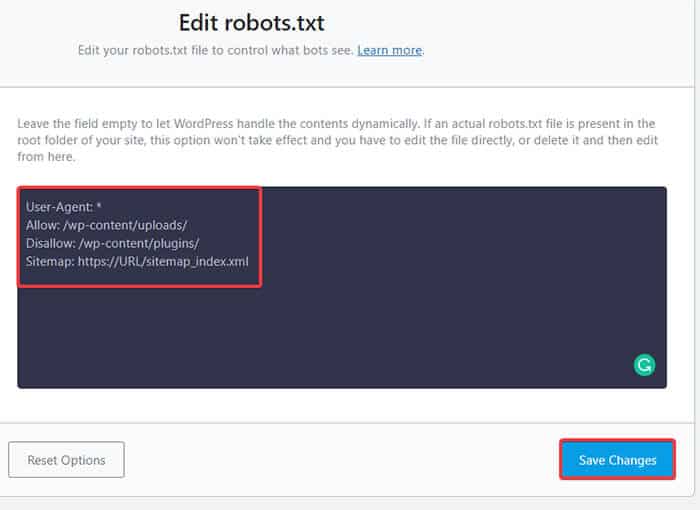

ตอนนี้ให้ป้อนรหัสต่อไปนี้หรือคัดลอกรหัสจากตัวอย่างก่อนหน้านี้ในช่องว่างแล้วคลิกปุ่ม บันทึกการเปลี่ยนแปลง

ไปเลย! คุณสร้างไฟล์ robots.txt สำเร็จโดยใช้ปลั๊กอิน Rank Math

วิธีที่ 2: การสร้างไฟล์ Robots.txt โดยใช้ FTP

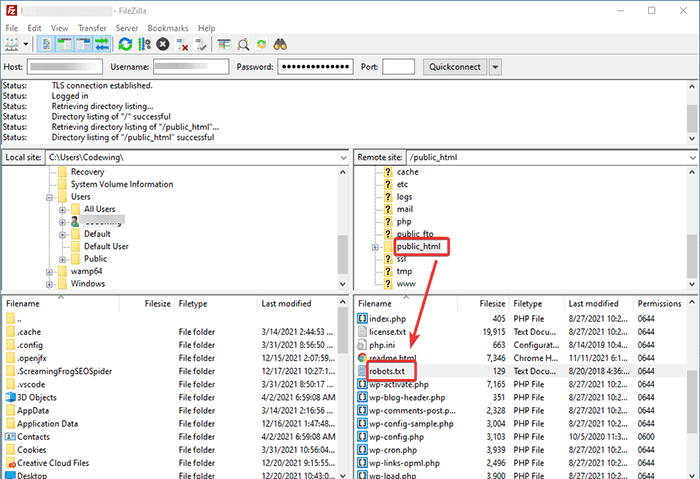

วิธีที่สองเกี่ยวข้องกับการสร้างไฟล์ robots.txt ด้วยตนเองบนเครื่องคอมพิวเตอร์ จากนั้นอัปโหลดไปยังโฟลเดอร์รากของไซต์ WordPress

คุณจะต้องเข้าถึงโฮสติ้ง WordPress โดยใช้ไคลเอนต์ FTP หลังจากเข้าสู่ระบบไคลเอนต์ FTP ของคุณ คุณจะเห็นไฟล์ robots.txt ในโฟลเดอร์รูทของเว็บไซต์ คลิกขวาและเลือกตัวเลือก แก้ไข

ตอนนี้ เพิ่มกฎที่กำหนดเองของคุณลงในไฟล์และบันทึกการเปลี่ยนแปลง ตัวอย่างเช่น:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpหากคุณไม่เห็นไฟล์ในโฟลเดอร์รูท คุณสามารถสร้างไฟล์ในเครื่องคอมพิวเตอร์ของคุณโดยใช้แผ่นจดบันทึก เพิ่มกฎของคุณลงไป จากนั้นอัปโหลดไปยังโฟลเดอร์รูทของคุณโดยใช้ FTP

จะวางไฟล์ Robots.txt ของคุณไว้ที่ใด

คุณควรวางไฟล์ robots.txt ไว้ในไดเรกทอรีรากของเว็บไซต์ของคุณเสมอ ตัวอย่างเช่น หากเว็บไซต์ของคุณคือ domainname.com โดเมนไฟล์ robots.txt ของคุณจะเป็น https://domainname.com/robots.txt

นอกเหนือจากการเพิ่มไฟล์ robots.txt ในไดเร็กทอรีรากของคุณแล้ว ต่อไปนี้คือเคล็ดลับเพิ่มเติมบางประการ:

- จำเป็นต้องตั้งชื่อไฟล์ว่า “robots.txt”

- ชื่อไฟล์เป็นแบบตรงตามตัวพิมพ์ ดังนั้น คุณต้องทำให้ถูกต้อง มิฉะนั้น มันจะไม่ทำงาน

- คุณต้องเพิ่มบรรทัดใหม่สำหรับกฎใหม่แต่ละข้อ

- เพิ่มเครื่องหมาย “$” เพื่อแสดงส่วนท้ายของ URL

- ใช้แต่ละ user-agent เพียงครั้งเดียว

วิธีทดสอบไฟล์ Robots.txt

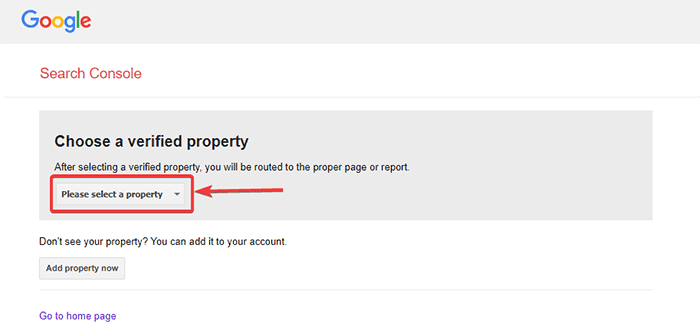

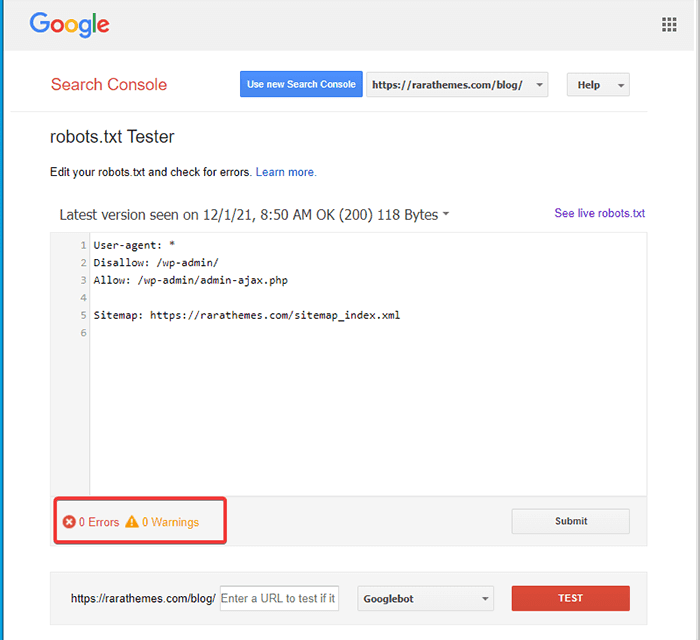

หลังจากสร้างไฟล์ robots.txt แล้ว คุณสามารถทดสอบโดยใช้ Google Search Console ที่นี่ คุณจะพบเครื่องมือทดสอบ Open robot.txt

- เลือกทรัพย์สินของคุณจากรายการดรอปดาวน์ที่กำหนด

เครื่องมือจะดึงไฟล์ robots.txt ของเว็บไซต์และไฮไลต์ข้อผิดพลาดและคำเตือนหากพบ

หมายเหตุ : ตัวเลือกคุณสมบัติดรอปดาวน์จะปรากฏขึ้นก็ต่อเมื่อคุณได้เชื่อมโยงไซต์ WordPress ของคุณกับ Google Search Console

หากคุณยังไม่ได้ดำเนินการ คุณสามารถเชื่อมโยงไซต์ของคุณได้อย่างรวดเร็วดังนี้:

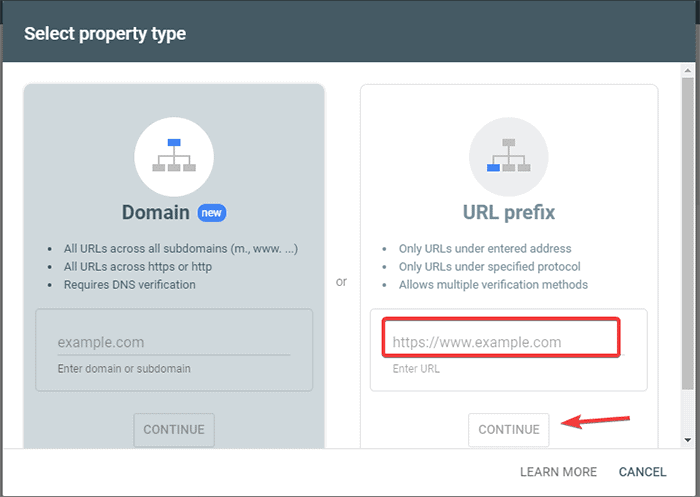

- ลงชื่อเข้าใช้ Google Search Console และสร้างบัญชี คุณสามารถตั้งค่าบัญชีของคุณโดยใช้โดเมนหรือคำนำหน้า URL ขอแนะนำให้ใช้คำนำหน้า URL เนื่องจากค่อนข้างง่ายกว่า

- ป้อน URL เว็บไซต์ของคุณ

- ตอนนี้คลิกที่ปุ่ม "ดำเนินการต่อ"

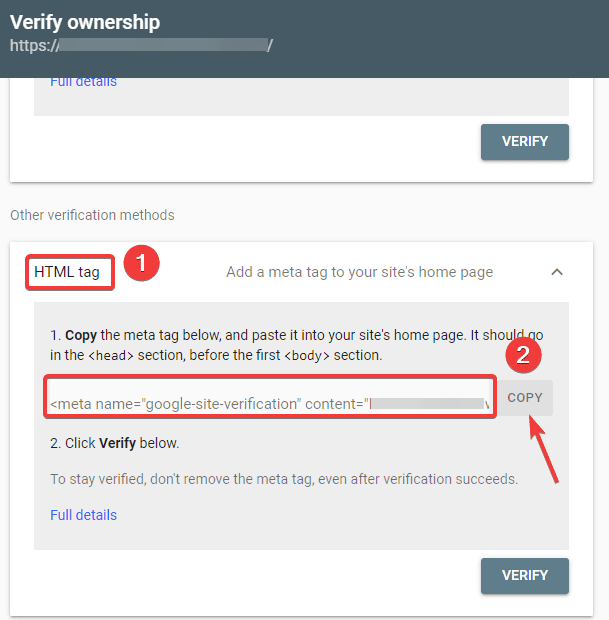

- ตอนนี้คุณควรยืนยันความเป็นเจ้าของไซต์ คุณสามารถทำได้โดยใช้ตัวเลือกใดๆ ที่ให้มา อย่างไรก็ตาม เราขอแนะนำให้ใช้ตัวเลือกแท็ก HTML

- คัดลอกรหัสที่กำหนดแล้วตรงไปที่แดชบอร์ด WordPress ของคุณ

ตอนนี้คุณสามารถตรวจสอบรหัสโดยใช้ปลั๊กอินแทรกส่วนหัวและส่วนท้าย วิธีตรวจสอบ:

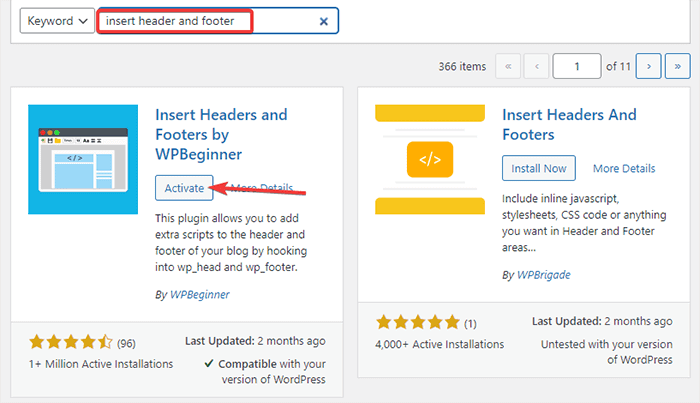

- ไปที่ Plugins -> Add New จาก WordPress Admin Dashboard ของคุณ

- ตอนนี้ ค้นหาปลั๊กอิน แทรกส่วนหัวและส่วนท้าย ในแถบค้นหา จากนั้น ติดตั้งและเปิดใช้งานปลั๊กอิน

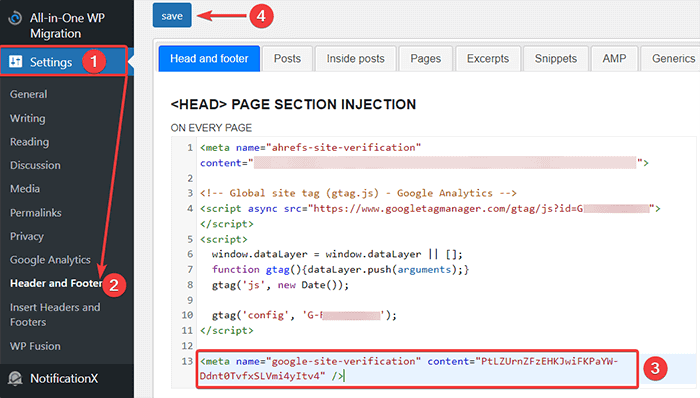

- หลังจากนั้น เปลี่ยนเส้นทางไปที่ การตั้งค่า -> ส่วนหัวและส่วนท้าย จากแดชบอร์ด WordPress แล้ววางโค้ดที่คัดลอกไว้ในแท็บส่วนหัวและส่วนท้าย เมื่อเสร็จแล้วให้คลิกปุ่มบันทึก

- กลับไปที่แท็บ Google Search Console บนเบราว์เซอร์ของคุณ จากนั้นคลิกที่ปุ่มยืนยัน

- Google จะตรวจสอบความเป็นเจ้าของและแสดงข้อความที่เสร็จสมบูรณ์เมื่อดำเนินการเสร็จสิ้น

- คลิกตัวเลือก "ไปที่พร็อพเพอร์ตี้" เพื่อเข้าถึงแดชบอร์ดของ Google Search Console

ตอนนี้ กลับไปที่เครื่องมือทดสอบ Open robot.txt และทดสอบ robots.txt ตามที่กล่าวไว้ข้างต้น

ข้อดีของไฟล์ Robots.txt

ต่อไปนี้คือประโยชน์ของการใช้ไฟล์ Robots.txt ในบริบท SEO:

- ช่วยเพิ่มประสิทธิภาพงบประมาณการรวบรวมข้อมูลของเครื่องมือค้นหาโดยข้ามการจัดทำดัชนีบนหน้าเว็บที่คุณไม่ต้องการให้บอทรวบรวมข้อมูล สิ่งนี้สร้างลำดับความสำคัญสำหรับเครื่องมือค้นหาเพื่อรวบรวมข้อมูลเฉพาะหน้าที่มีความสำคัญสำหรับคุณ

- ช่วยเพิ่มประสิทธิภาพเว็บเซิร์ฟเวอร์โดยจำกัดบอทที่ใช้ทรัพยากรโดยไม่จำเป็น

- ช่วยซ่อนหน้าเข้าสู่ระบบ, หน้า Landing Page, ขอบคุณหน้าจากการจัดทำดัชนีโดยเครื่องมือค้นหา ดังนั้นจึงช่วยเพิ่มประสิทธิภาพการทำงานของเว็บไซต์

ข้อเสียของไฟล์ robots.txt

- การสร้างไฟล์ robots.txt นั้นค่อนข้างง่าย ดังที่เราได้อธิบายไว้ข้างต้น อย่างไรก็ตาม ไฟล์ robots.txt ยังรวม URL ไปยังหน้าภายในของคุณที่คุณไม่ต้องการให้บ็อตรวบรวมข้อมูลจัดทำดัชนี เช่น หน้าเข้าสู่ระบบ ทำให้เว็บไซต์ของคุณเสี่ยงต่อการละเมิดความปลอดภัย

- ในขณะที่การสร้างไฟล์ robots.txt นั้นเป็นเรื่องง่าย การทำผิดพลาดแม้แต่นิดเดียวก็สามารถดึงความพยายามทั้งหมดของคุณลงไปได้ ตัวอย่างเช่น หากคุณเพิ่มหรือใส่อักขระตัวเดียวในไฟล์ผิด จะทำให้ความพยายาม SEO ทั้งหมดของคุณยุ่งเหยิง

คำถามที่พบบ่อย (FAQ)

การรวบรวมข้อมูลเว็บคืออะไร?

เสิร์ชเอ็นจิ้นส่งโปรแกรมรวบรวมข้อมูลเว็บ (หรือที่เรียกว่าบอทหรือสไปเดอร์) ไปทั่วเว็บ บอทเหล่านี้เป็นซอฟต์แวร์อัจฉริยะที่นำทางทั่วทั้งเว็บเพื่อค้นหาหน้า ลิงก์ และเว็บไซต์ใหม่ กระบวนการค้นพบนี้เรียกว่าการรวบรวมข้อมูลเว็บ

การจัดทำดัชนีคืออะไร?

เมื่อโปรแกรมรวบรวมข้อมูลเว็บค้นพบเว็บไซต์ของคุณ พวกเขาจะจัดเรียงหน้าของคุณให้เป็นโครงสร้างข้อมูลที่ใช้งานได้ กระบวนการจัดระเบียบนี้เรียกว่าการทำดัชนี

งบประมาณการรวบรวมข้อมูลคืออะไร?

งบประมาณการรวบรวมข้อมูลเป็นการจำกัดจำนวน URL ที่บอทการค้นหาสามารถรวบรวมข้อมูลในเซสชันที่กำหนด ทุกไซต์มีการจัดสรรงบประมาณการตระเวนเฉพาะ ดังนั้นคุณต้องแน่ใจว่าคุณใช้จ่ายเงินในลักษณะที่เป็นประโยชน์ต่อไซต์ของคุณมากที่สุด

ตัวอย่างเช่น หากคุณมีหน้าเว็บหลายหน้าในไซต์ของคุณ คุณต้องจัดสรรงบประมาณการรวบรวมข้อมูลให้กับหน้าเว็บที่มีค่าที่สุด ดังนั้น คุณสามารถพูดถึง URL ของหน้าในไฟล์ robots.txt ของคุณได้

บทสรุป

เมื่อทำงานกับ SEO ของเว็บไซต์ ผู้ใช้ส่วนใหญ่มุ่งเน้นไปที่การสร้างแผนผังเว็บไซต์ การทำงานกับลิงก์ย้อนกลับ การค้นคว้าเกี่ยวกับคีย์เวิร์ด และการปรับเนื้อหาให้เหมาะสม มีผู้ดูแลเว็บเพียงไม่กี่คนเท่านั้นที่ให้ความสนใจกับไฟล์ robots.txt

ไฟล์ robots.txt อาจไม่ได้มีส่วนร่วมมากนักเมื่อคุณเริ่มไซต์ อย่างไรก็ตาม เมื่อเว็บไซต์ของคุณเติบโตขึ้น การให้ความสนใจกับไฟล์ robots.txt จะให้ผลลัพธ์ที่ดีกว่า

นอกจากนี้ยังมีตำนานที่บล็อกหมวดหมู่ หน้าเก็บถาวร และแท็กเพิ่มอัตราการรวบรวมข้อมูลและส่งเสริมการจัดทำดัชนีที่เร็วขึ้น มันเป็นเท็จ

ทำตามวิธีการที่เรากล่าวถึงข้างต้นเพื่อสร้างไฟล์ robots.txt ของคุณ

เราหวังว่าบทความนี้จะช่วยคุณจัดเรียงคำถามของคุณเกี่ยวกับวิธีการสร้างและเพิ่มประสิทธิภาพ WordPress robots.txt สำหรับ SEO

หากคุณต้องการอ่านบทความที่เป็นประโยชน์เพิ่มเติมเกี่ยวกับ WordPress คุณสามารถอ่านบทความต่อไปนี้:

- วิธีการสร้างแผนผังเว็บไซต์ใน WordPress?

- จะเริ่มบล็อก WordPress ได้อย่างไร?