例を使用してSEO用にWordPressRobots.txtを最適化する方法

公開: 2021-12-20SEOはウェブサイトの所有者にとって最優先事項です。 トップ5の結果がクリック数の75%を獲得しているため、上位を獲得するための競争は困難でした。 さまざまなオフページおよびオンページのSEO手法が関係しています。 Robot.txtファイルの最適化は、サイトのSEOを強化できるトリックの1つです。

ただし、ほとんどの初心者は、SEO用にWordPressRobots.txtを最適化する方法を知りません。 そもそもrobots.txtファイルが何であるかさえ知らない人もいるかもしれません。

幸いなことに、この記事はあなたの助けになります。

ここでは、robots.txtファイルとは何か、robots.txtファイルを作成する方法、およびSEO用にrobots.txtファイルを最適化する方法について説明します。 最後にいくつかのFAQも追加しました。 だから、最後まで私たちと一緒にいることを確認してください。

それでは、始めましょう!

目次

- Robots.txtファイルとは何ですか?

- Robots.txtファイルはどのように見えますか?

- WordPressにRobots.txtファイルが必要なのはなぜですか?

- あなたのウェブサイトのためにRobots.txtを作成する方法は?

- 方法1:ランク数学プラグインを使用してRobots.txtファイルを作成する

- 方法2:FTPを使用してRobots.txtファイルを作成する

- Robots.txtファイルをどこに置くか?

- Robots.txtファイルをテストする方法は?

- Robots.txtファイルの長所

- robots.txtファイルの短所

- よくある質問(FAQ)

- Webクロールとは何ですか?

- インデックス作成とは何ですか?

- クロール予算はいくらですか?

- 結論

Robots.txtファイルとは何ですか?

WordPressのRobots.txtは、検索エンジンのボットにサイトのどのページをクロールしてインデックスを作成するかを通知するプレーンテキストファイルです。 ファイルをフォーマットして、ページをインデックスから除外することもできます。

robots.txtはWordPressのルートディレクトリに保存されます。 このファイルの基本形式は次のようになります。

User-agent: [user-name] Disallow: [URL of the string not to be crawled] Allow: [URL of the string to be crawled] Sitemap: [URL of your WordPress XML Sitemap]Robots.txtファイルはどのように見えますか?

robots.txtファイルは、サイトをクロールする方法と内容を検索エンジンに指示する数行のテキストです。 このファイルには、特定のページURLを許可または制限するための複数の行があります。 複数のサイトマップを追加することもできます。 URLを許可しない場合、検索エンジンボットはそのページをクロールしません。

次にrobots.txtファイルの例を示します。

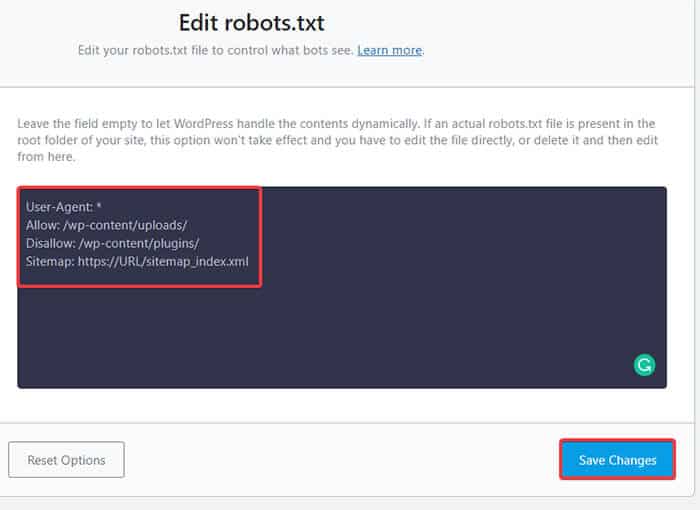

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Sitemap: https://URL/sitemap_index.xmlそれでは、ロボットファイルにある次の4つの主要な用語について学びましょう。

- User-agent :User-agentは、クロール命令を与える特定のWebクローラーです。 通常は検索エンジンです。

- 許可:許可は、サブフォルダまたは親ページが許可されていない場合でも、ページまたはサブフォルダにアクセスできることをGooglebotに通知するコマンドです。

- Disallow :disallowコマンドは、特定のURLをクロールしないようにユーザーエージェントに指示します。 URLごとに1つの「Disallow:」行のみを含めることができます。

- サイトマップ:サイトマップは、このURLに関連するXMLサイトマップの場所を呼び出すために使用されます。 このコマンドは、Google、Bing、Ask、およびYahooでのみサポートされています。

上記の例では、検索ボットがアップロードフォルダーをクロールしてインデックスを作成することを許可しましたが、プラグインフォルダーを制限しました。 最終的に、XMLサイトマップのインデックス作成を許可しました。

User-Agentの後のアスタリスク記号は、テキストがすべての検索エンジンボットに適用されることを意味します。 各検索エンジンには、サイトにインデックスを付けるためのユーザーエージェントがあります。 いくつかの人気のある検索エンジンのいくつかのユーザーエージェントは次のとおりです。

- Google:Googlebot

- Googlebot画像:Googlebot-画像

- Googlebotニュース:Googlebot-ニュース

- Googlebotビデオ:Googlebot-ビデオ

- Yahoo:Slurp Bot

- Bing:Bingbot

- アマゾンのアレクサ:ia_archiver

- DuckDuckGo:DuckDuckBot

- Yandex:YandexBot

- Baidu:Baiduspider

- Exalead:ExaBot

今日、そこには非常に多くのユーザーエージェントがいます。 特定の検索エンジンに焦点を当てたい場合は、robots.txtファイルで指定することもできます。 つまり、Googlebotの手順を設定するには、robots.txtファイルの最初の行を次のように記述します。

ユーザーエージェント:Googlebot

WordPressにRobots.txtファイルが必要なのはなぜですか?

robots.txtファイルがない場合でも、検索ボットはサイトをクロールしてインデックスに登録します。 それで、なぜあなたは本当にそれを必要とするのでしょうか? robots.txtファイルを使用すると、検索エンジンに特定のページのインデックス作成を優先するように指示できます。 また、インデックスを作成したくないページやフォルダを除外することもできます。

これは、最初に大きな影響を与えることはありません ブログを始めて、たくさんのコンテンツを持っていません。 ただし、サイトが成長して多くのコンテンツが含まれるようになった後は、特定のページ/投稿/フォルダーでのインデックス作成を優先し、一部を無効にする必要がある場合があります。

ご覧のとおり、各Webサイトの各検索ボットには割り当てがあります。 つまり、ボットは特定のクロールセッションで特定のページ数をクロールします。 ボットがその特定のセッションでクロールを終了しない場合、ボットは戻ってきて、次のセッションでクロールを再開します。 これにより、Webサイトのインデックス作成率が低下します。

したがって、robots.txtファイルを使用することで、インデックスを作成するページ、ファイル、フォルダー、および含めるページ、ファイル、フォルダーを検索ボットに送信できます。 そうすることで、クロールクォータを節約できます。 コンテンツを公開しないようにするのが最も安全な方法ではないかもしれませんが、除外されたコンテンツがSERPに表示されるのを防ぎます。

あなたのウェブサイトのためにRobots.txtを作成する方法は?

robots.txtは2つの異なる方法で作成できます。 これらの方法を以下に説明します。 その後、自分に最適と思われる方法に従うことができます。

方法1:ランク数学プラグインを使用してRobots.txtファイルを作成する

ここでは、人気のあるランク数学プラグインを使用してrobots.txtファイルを作成する方法を紹介します。

ランク数学は、広く受け入れられているベストプラクティスに基づいた組み込みの提案を使用して、Webサイトのコンテンツを簡単に最適化できるSEOWordPressプラグインです。 この便利なツールを使用すると、重要なSEO設定を簡単にカスタマイズし、インデックスを作成できるページを制御できます。

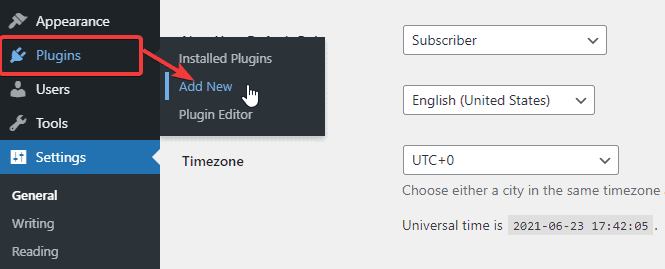

ランク数学プラグインを使用してrobots.txtファイルを作成するには、まず、WordPress管理ダッシュボードから[プラグイン]-> [新規追加]に移動してプラグインをダウンロードします。

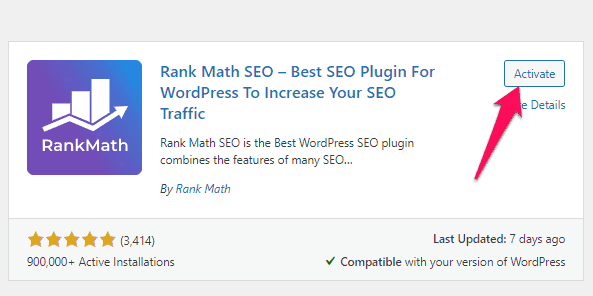

次に、検索バーでランク数学を検索し、プラグインが見つかったら[今すぐインストールしてアクティブ化]ボタンをクリックします。

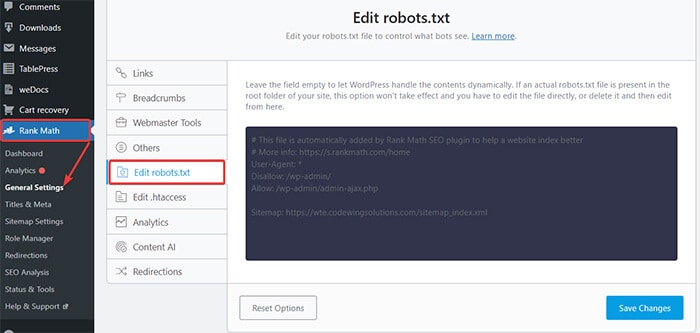

プラグインをアクティブにしたら、WordPressダッシュボードからRank Math-> General Settings-> Editrobots.txtに移動します。

次に、次のコードを入力するか、前の例で説明したコードを空白スペースにコピーして、[変更を保存]ボタンをクリックします。

どうぞ! これで、RankMathプラグインを使用してrobots.txtファイルが正常に作成されました。

方法2:FTPを使用してRobots.txtファイルを作成する

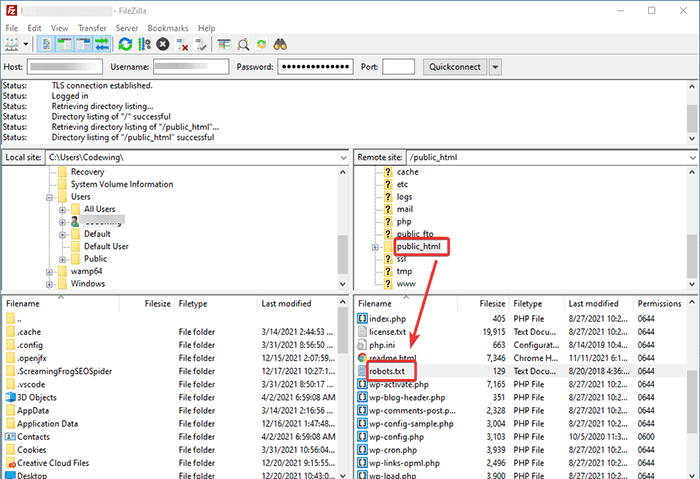

2番目の方法では、ローカルコンピューターでrobots.txtファイルを手動で作成し、それをWordPressサイトのルートフォルダーにアップロードします。

FTPクライアントを使用してWordPressホスティングにアクセスする必要があります。 FTPクライアントにログインすると、Webサイトのルートフォルダーにあるrobots.txtファイルが表示されます。 右クリックして[編集]オプションを選択します。

次に、カスタムルールをファイルに追加し、変更を保存します。 例えば:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpルートフォルダにファイルが表示されない場合は、メモ帳を使用してローカルコンピュータにファイルを作成できます。 ルールを追加してから、FTPを使用してrooterフォルダーにアップロードします。

Robots.txtファイルをどこに置くか?

robots.txtファイルは常にWebサイトのルートディレクトリに配置する必要があります。 たとえば、サイトがdomainname.comの場合、robots.txtファイルドメインはhttps://domainname.com/robots.txtになります。

ルートディレクトリにrobots.txtファイルを追加することに加えて、ここにいくつかの追加のヒントがあります。

- ファイルに「robots.txt」という名前を付ける必要があります。

- ファイル名では大文字と小文字が区別されます。 したがって、正しくする必要があります。そうしないと機能しません。

- 新しいルールごとに新しい行を追加する必要があります。

- URLの終わりを示す「$」記号を追加します。

- 各ユーザーエージェントは1回だけ使用してください。

Robots.txtファイルをテストする方法は?

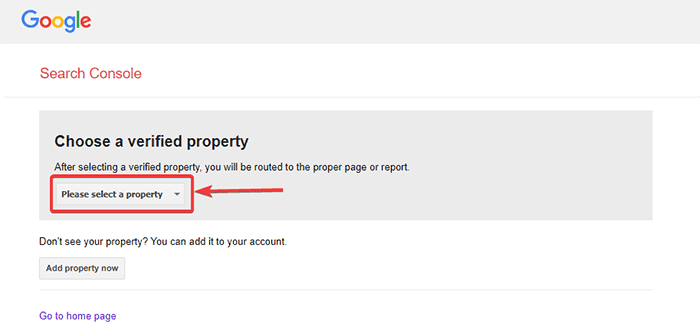

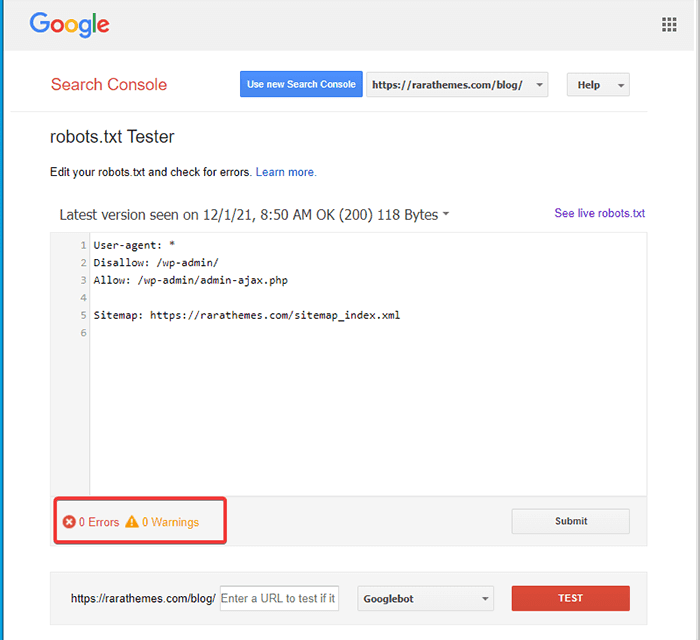

robots.txtファイルを作成したら、Google検索コンソールを使用してテストできます。 ここに、Openrobot.txtテスターツールがあります。

- 所定のドロップダウンリストからプロパティを選択します。

ツールはサイトのrobots.txtファイルを取得し、エラーと警告が見つかった場合はそれを強調表示します。

注:ドロップダウンプロパティオプションは、WordPressサイトをGoogle検索コンソールにリンクしている場合にのみ表示されます。

まだ行っていない場合は、次のようにサイトをすばやくリンクできます。

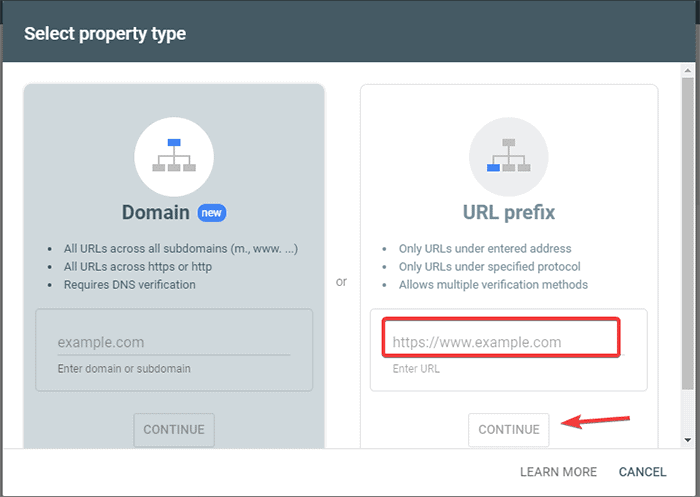

- Google Search Consoleにログインして、アカウントを作成します。 ドメインまたはURLプレフィックスのいずれかを使用してアカウントを設定できます。 比較的簡単なので、URLプレフィックスを使用することをお勧めします。

- WebサイトのURLを入力します。

- 次に、「続行」ボタンをクリックします。

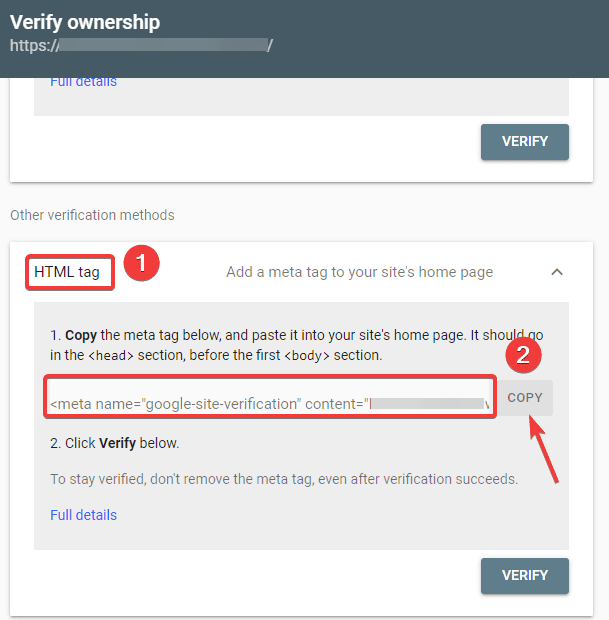

- ここで、サイトの所有権を確認する必要があります。 これは、指定されたオプションのいずれかを使用して実行できます。 ただし、HTMLタグオプションを使用することをお勧めします。

- 指定されたコードをコピーしてから、WordPressダッシュボードに移動します。

これで、Insert Headers andFootersプラグインを使用してコードを検証できます。 検証します:

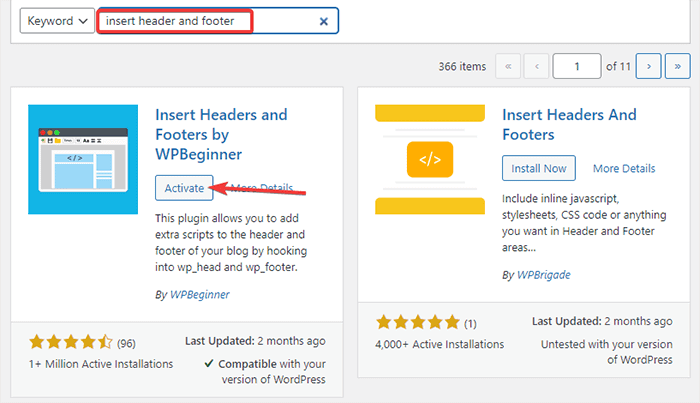

- WordPress管理ダッシュボードから[プラグイン]-> [新規追加]に移動します。

- 次に、検索バーで[ヘッダーとフッターの挿入]プラグインを検索し、プラグインをインストールしてアクティブ化します。

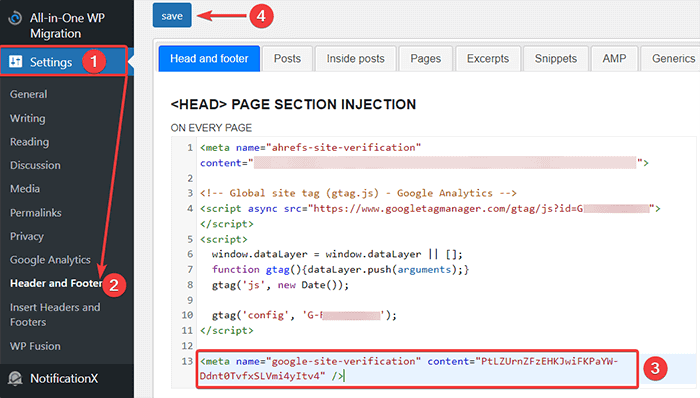

- その後、WordPressダッシュボードから[設定]-> [ヘッダーとフッター]にリダイレクトし、コピーしたコードを[ヘッドとフッター]タブに貼り付けます。 完了したら、[保存]ボタンをクリックします。

- ブラウザの[Google検索コンソール]タブに戻ります。 次に、確認ボタンをクリックします。

- Googleは所有権を確認し、完了すると完了したメッセージを表示します。

- [プロパティに移動]オプションをクリックして、Google検索コンソールのダッシュボードにアクセスします。

次に、Open robot.txtテスターツールに戻り、上記のようにrobots.txtをテストします。

Robots.txtファイルの長所

SEOコンテキストでRobots.txtファイルを使用する利点は次のとおりです。

- ボットをクロールさせたくないページのインデックス作成をスキップすることで、検索エンジンのクロールバジェットを最適化するのに役立ちます。 これにより、検索エンジンが重要なページのみをクロールする優先順位が作成されます。

- リソースを不必要に消費しているボットを制限することにより、Webサーバーを最適化するのに役立ちます。

- ログインページ、ランディングページ、ありがとうページを検索エンジンによるインデックス作成から非表示にするのに役立ちます。 したがって、Webサイトのパフォーマンスを最適化します。

robots.txtファイルの短所

- 上で説明したように、robots.txtファイルの作成は非常に簡単です。 ただし、robots.txtファイルには、ログインページなど、クロールボットにインデックスを付けさせたくない内部ページへのURLも含まれています。 これにより、Webサイトがセキュリティ違反に対して脆弱になります。

- robots.txtファイルを作成するのは簡単ですが、単純なミスでもすべての労力を無駄にする可能性があります。 たとえば、ファイルに1つの文字を追加したり、置き忘れたりすると、SEOのすべての作業が台無しになります。

よくある質問(FAQ)

Webクロールとは何ですか?

検索エンジンは、Webクローラー(ボットまたはスパイダーとも呼ばれます)をWeb全体に送信します。 これらのボットは、Web全体をナビゲートして、新しいページ、リンク、およびWebサイトを検出するスマートソフトウェアです。 この検出プロセスは、Webクロールと呼ばれます。

インデックス作成とは何ですか?

Webクローラーは、Webサイトを検出すると、ページを使用可能なデータ構造に配置します。 この整理プロセスは、インデックス作成と呼ばれます。

クロール予算はいくらですか?

クロールバジェットは、検索ボットが特定のセッションでクロールできるURLの数に対する制限です。 すべてのサイトには、特定のクロール予算が割り当てられています。 したがって、サイトにとって最も有益な方法でそれを使用することを確認する必要があります。

たとえば、サイトに複数のページがある場合、最も価値のあるページにクロール予算を割り当てる必要があります。 したがって、robots.txtファイルでページのURLに言及できます。

結論

WebサイトのSEOで作業する場合、ほとんどのユーザーはサイトマップの作成、バックリンクの作業、キーワードの調査、およびコンテンツの最適化に重点を置いています。 robots.txtファイルに注意を払っているウェブマスターはごくわずかです。

サイトを開始するとき、robots.txtファイルはあまり役立たない場合があります。 ただし、Webサイトが大きくなるにつれて、robots.txtファイルに注意を払うとより良い結果が得られます。

また、カテゴリ、アーカイブページ、タグをブロックすると、クロールレートが向上し、インデックス作成が高速化されるという神話があります。 それは誤りです。

上記の方法に従って、robots.txtファイルを作成します。

この記事が、SEO用にWordPressrobots.txtを作成および最適化する方法に関するクエリの並べ替えに役立つことを願っています。

WordPressに関連するより有用な記事を読みたい場合は、次の記事を読むことができます。

- WordPressでサイトマップを作成する方法は?

- WordPressブログを始める方法は?