Cara Mengoptimalkan Robots.txt WordPress Untuk SEO Dengan Contoh

Diterbitkan: 2021-12-20SEO telah menjadi prioritas utama bagi pemilik situs web. Dengan hasil lima besar mendapatkan 75% klik, perlombaan untuk peringkat yang lebih tinggi telah menjadi tantangan. Ada berbagai teknik SEO off-page dan on-page yang ikut bermain. Mengoptimalkan file Robot.txt adalah salah satu trik yang dapat memperkuat SEO untuk situs Anda.

Namun, kebanyakan pemula tidak tahu cara mengoptimalkan WordPress Robots.txt untuk SEO. Beberapa bahkan mungkin tidak tahu apa itu file robots.txt.

Untungnya, artikel ini membantu Anda.

Disini kami akan menjelaskan apa itu file robots.txt, cara membuat file robots.txt, dan cara optimasi file robots.txt untuk SEO. Kami juga telah menambahkan beberapa FAQ di bagian akhir. Jadi pastikan Anda bersama kami sampai akhir.

Sekarang, mari kita mulai!

Daftar isi

- Apa itu file Robots.txt?

- Seperti Apa Tampilan File Robots.txt?

- Mengapa Anda Membutuhkan File Robots.txt di WordPress?

- Bagaimana Membuat Robots.txt untuk Website Anda?

- Metode 1: Membuat file Robots.txt menggunakan Plugin Rank Math

- Metode 2: Membuat file Robots.txt menggunakan FTP

- Di mana Menempatkan File Robots.txt Anda?

- Bagaimana Menguji File Robots.txt?

- Kelebihan File Robots.txt

- Kekurangan File robots.txt

- Pertanyaan yang Sering Diajukan (FAQ)

- Apa itu perayapan web?

- Apa itu pengindeksan?

- Berapa anggaran perayapan?

- Kesimpulan

Apa itu file Robots.txt?

Robots.txt di WordPress adalah file teks biasa yang menginformasikan bot mesin pencari halaman mana di situs Anda untuk dirayapi dan diindeks. Anda juga dapat memformat file untuk mengecualikan halaman dari pengindeksan.

Robots.txt disimpan di direktori root WordPress. File ini memiliki format dasar yang terlihat seperti ini:

User-agent: [user-name] Disallow: [URL of the string not to be crawled] Allow: [URL of the string to be crawled] Sitemap: [URL of your WordPress XML Sitemap]Seperti Apa Tampilan File Robots.txt?

File robots.txt hanyalah beberapa baris teks yang mengarahkan mesin pencari tentang bagaimana dan apa yang harus dirayapi di situs Anda. Anda memiliki beberapa baris pada file ini untuk mengizinkan atau membatasi URL halaman tertentu. Anda juga dapat menambahkan beberapa peta situs. Jika Anda melarang URL, bot mesin telusur tidak merayapi laman itu.

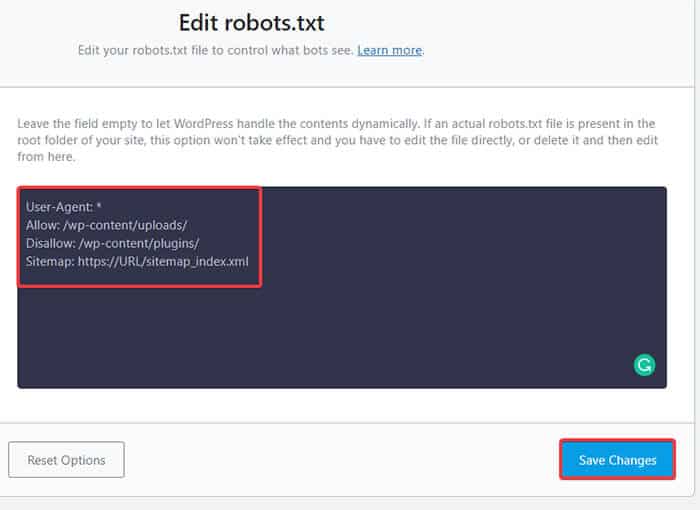

Berikut adalah contoh file robots.txt:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Sitemap: https://URL/sitemap_index.xmlSekarang, mari kita pelajari tentang empat istilah utama yang dapat Anda temukan di file robots:

- User-agent : User-agent adalah web crawler tertentu yang Anda berikan instruksi crawl. Biasanya mesin pencari.

- Allow : Allow adalah perintah yang memberi tahu Googlebot bahwa ia dapat mengakses halaman atau subfolder meskipun subfolder atau halaman induknya mungkin tidak diizinkan.

- Disallow : Perintah disallow memberitahu agen pengguna untuk tidak merayapi URL tertentu. Anda hanya dapat menyertakan satu baris “Larang:” untuk setiap URL.

- Peta Situs : Peta situs digunakan untuk memanggil lokasi peta situs XML apa pun yang terkait dengan URL ini. Perintah ini hanya didukung oleh Google, Bing, Ask, dan Yahoo.

Dalam contoh di atas, kami mengizinkan bot pencarian untuk merayapi dan mengindeks folder unggahan tetapi telah membatasi folder plugins. Pada akhirnya, kami mengizinkan pengindeksan peta situs XML.

Tanda asterisk setelah User-Agent berarti teks tersebut berlaku untuk semua bot mesin pencari. Setiap mesin pencari memiliki agen penggunanya untuk mengindeks situs. Berikut adalah beberapa agen pengguna dari beberapa mesin pencari populer:

- Google: Googlebot

- Gambar Googlebot: Gambar Googlebot

- Berita Googlebot: Berita Googlebot

- Video Googlebot: Googlebot-Video

- Yahoo: Slurp Bot

- Bing: Bingbot

- Alexa Amazon: ia_archiver

- DuckDuckGo: DuckDuckBot

- Yandex: YandexBot

- Baidu: Baiduspider

- Exalead: ExaBot

Ada begitu banyak agen pengguna di luar sana saat ini. Jika Anda ingin fokus pada mesin pencari tertentu, Anda bahkan dapat menentukannya di file robots.txt. Artinya, untuk menyiapkan instruksi untuk Googlebot, Anda dapat menulis baris pertama file robots.txt sebagai:

Agen-pengguna: Googlebot

Mengapa Anda Membutuhkan File Robots.txt di WordPress?

Bot pencarian akan merayapi dan mengindeks situs Anda meskipun Anda tidak memiliki file robots.txt. Jadi, mengapa Anda benar-benar membutuhkannya? Nah, dengan adanya file robots.txt, Anda bisa mengarahkan mesin pencari untuk memprioritaskan pengindeksan pada halaman tertentu. Selain itu, Anda dapat mengecualikan halaman atau folder yang tidak ingin Anda indeks.

Ini tidak memiliki dampak yang lebih besar ketika Anda pertama kali memulai sebuah blog dan tidak memiliki banyak konten. Namun, setelah situs Anda berkembang dan memiliki banyak konten, Anda mungkin perlu memprioritaskan pengindeksan pada halaman/posting/folder tertentu dan meniadakannya.

Soalnya, ada kuota untuk setiap bot pencarian untuk setiap situs web. Itu berarti bot merayapi sejumlah halaman tertentu pada sesi perayapan tertentu. Jika bot tidak selesai merangkak di sesi tertentu, bot kembali dan melanjutkan merangkak di sesi berikutnya. Ini memperlambat tingkat pengindeksan situs web Anda.

Jadi, dengan menggunakan file robots.txt, Anda dapat mengarahkan bot pencarian ke halaman, file, dan folder mana yang ingin Anda indeks dan mana yang akan disertakan. Dengan demikian, Anda menghemat kuota perayapan. Ini mungkin bukan cara teraman untuk menyembunyikan konten Anda dari publik, tetapi mencegah konten yang dikecualikan itu muncul di SERP.

Bagaimana Membuat Robots.txt untuk Website Anda?

Anda dapat membuat robots.txt dengan dua cara berbeda. Kami akan menjelaskan cara-cara tersebut di bawah ini. Anda kemudian dapat mengikuti metode yang menurut Anda paling cocok untuk Anda.

Metode 1: Membuat file Robots.txt menggunakan Plugin Rank Math

Di sini, kami akan menunjukkan cara membuat file robots.txt menggunakan plugin Rank Math yang populer.

Rank Math adalah plugin SEO WordPress yang memudahkan pengoptimalan konten situs web Anda dengan saran bawaan berdasarkan praktik terbaik yang diterima secara luas. Dengan menggunakan alat praktis ini, Anda dapat dengan mudah menyesuaikan pengaturan SEO penting dan mengontrol halaman mana yang dapat diindeks.

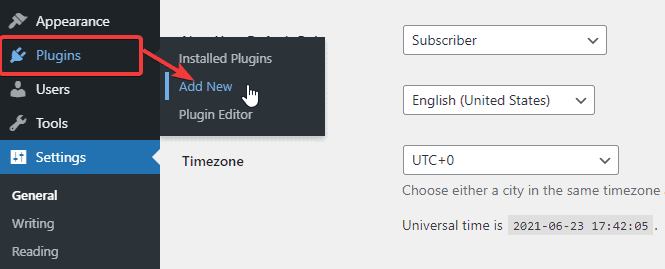

Untuk membuat file robots.txt menggunakan plugin Rank Math, pertama, unduh plugin dengan masuk ke Plugins -> Add New dari Dashboard Admin WordPress Anda.

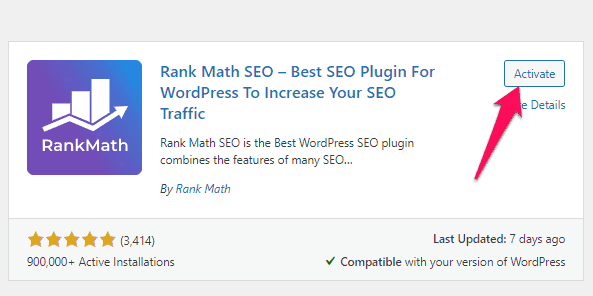

Sekarang, cari Rank Math di bilah Pencarian dan klik tombol Instal Sekarang dan Aktifkan setelah Anda menemukan plugin.

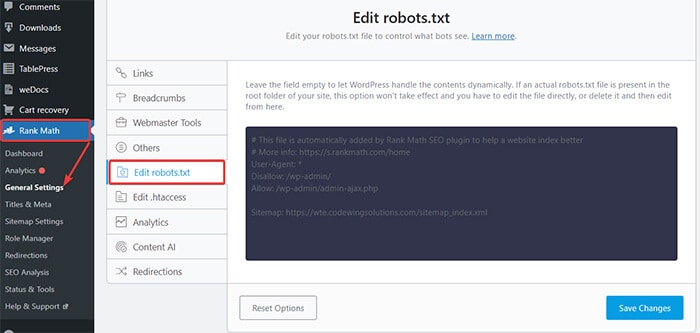

Setelah Anda mengaktifkan plugin, buka Rank Math -> General Settings -> Edit robots.txt dari Dashboard WordPress.

Sekarang, masukkan kode berikut atau salin kode dari yang disebutkan dalam contoh sebelumnya di ruang kosong dan klik tombol Simpan Perubahan .

Ini dia! Anda telah berhasil membuat file robots.txt menggunakan plugin Rank Math.

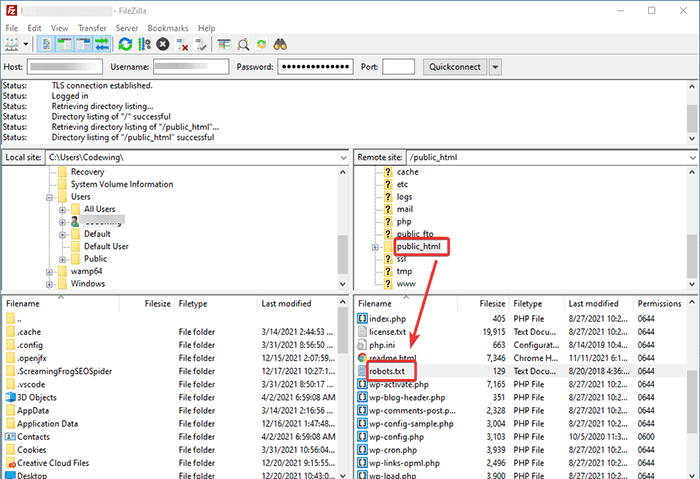

Metode 2: Membuat file Robots.txt menggunakan FTP

Metode kedua melibatkan pembuatan file robots.txt secara manual di komputer lokal dan kemudian mengunggahnya ke folder root situs WordPress Anda.

Anda perlu mengakses hosting WordPress Anda menggunakan klien FTP. Setelah masuk ke klien FTP Anda, Anda dapat melihat file robots.txt di folder root situs web. Klik kanan dan pilih opsi Edit .

Sekarang, tambahkan aturan khusus Anda ke file dan simpan perubahannya. Sebagai contoh:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpJika Anda tidak melihat file di folder root, Anda dapat membuatnya di komputer lokal menggunakan notepad. Tambahkan aturan Anda di atasnya dan kemudian unggah ke folder rooter Anda menggunakan FTP.

Di mana Menempatkan File Robots.txt Anda?

Anda harus selalu menempatkan file robots.txt di direktori root situs web Anda. Misalnya, jika situs Anda adalah domainname.com , maka domain file robots.txt Anda akan menjadi https://domainname.com/robots.txt.

Selain menambahkan file robots.txt di direktori root Anda, berikut adalah beberapa tips tambahan:

- Ini adalah suatu keharusan untuk nama file "robots.txt."

- Nama file peka huruf besar/kecil. Jadi, Anda harus melakukannya dengan benar atau tidak akan berhasil.

- Anda perlu menambahkan baris baru untuk setiap aturan baru.

- Tambahkan tanda “$” untuk menandakan akhir dari sebuah URL.

- Gunakan setiap agen pengguna hanya sekali.

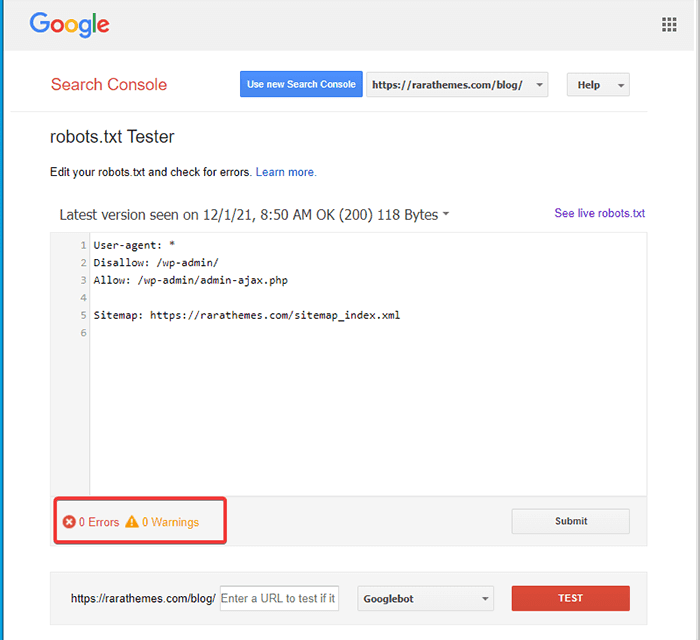

Bagaimana Menguji File Robots.txt?

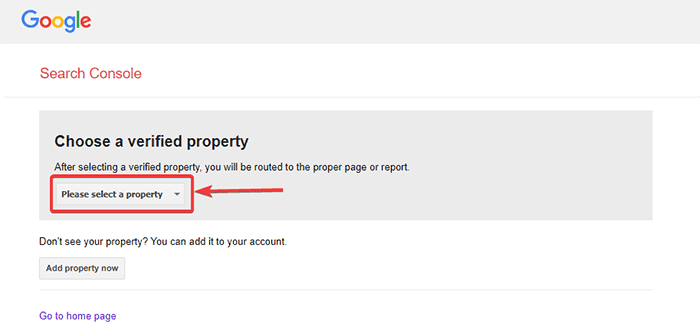

Setelah membuat file robots.txt, Anda dapat mengujinya menggunakan Google Search Console. Di sini, Anda akan menemukan alat penguji Open robot.txt.

- Pilih properti Anda dari daftar drop-down yang diberikan.

Alat ini mengambil file robots.txt situs Anda dan menyoroti kesalahan dan peringatan jika ditemukan.

Catatan : Opsi properti drop-down hanya muncul jika Anda telah menautkan situs WordPress Anda dengan Google Search Console.

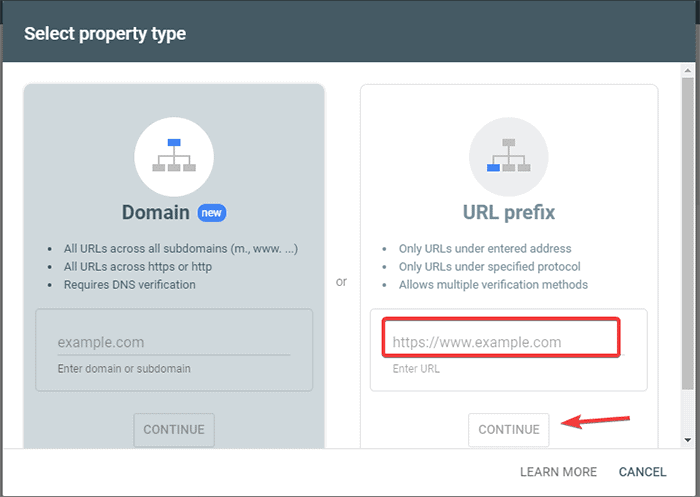

Jika Anda belum melakukannya, Anda dapat dengan cepat menautkan situs Anda sebagai berikut:

- Masuk ke Google Search Console dan buat akun. Anda dapat menyiapkan akun menggunakan domain atau awalan URL. Disarankan untuk menggunakan awalan URL karena relatif lebih mudah.

- Masukkan URL situs web Anda.

- Sekarang, klik tombol "Lanjutkan".

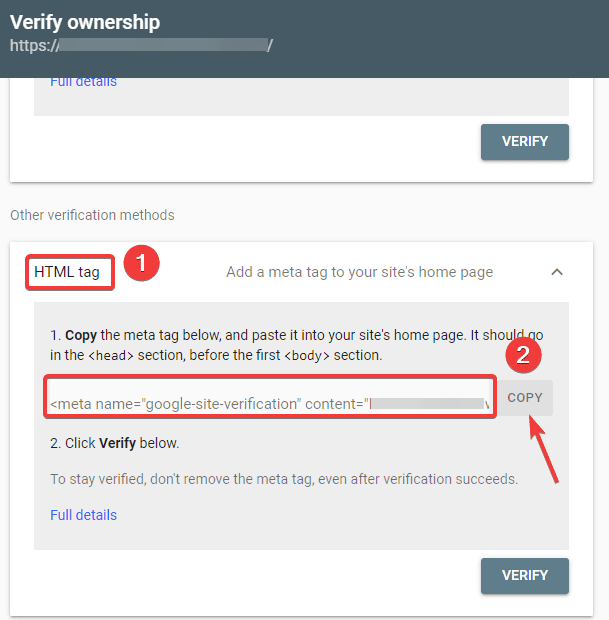

- Anda sekarang harus memverifikasi kepemilikan situs. Anda dapat melakukan ini menggunakan salah satu opsi yang diberikan. Namun, sebaiknya gunakan opsi tag HTML.

- Salin kode yang diberikan dan kemudian menuju ke dashboard WordPress Anda.

Anda sekarang dapat memverifikasi kode menggunakan plugin Insert Headers and Footers. Untuk memverifikasi:

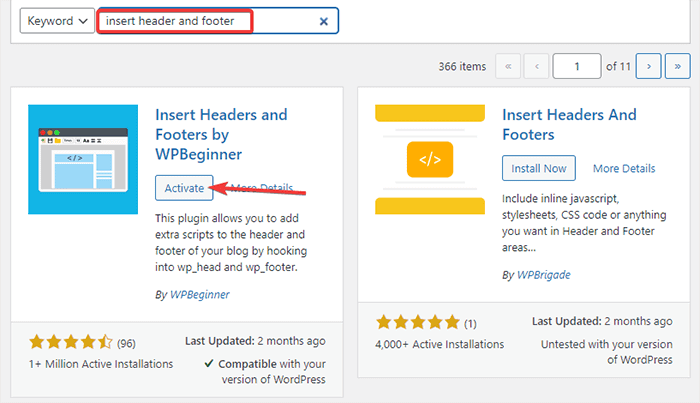

- Buka Plugin -> Tambah Baru dari Dasbor Admin WordPress Anda.

- Sekarang, cari plugin Insert Headers and Footers di bilah pencarian dan kemudian Instal dan Aktifkan plugin.

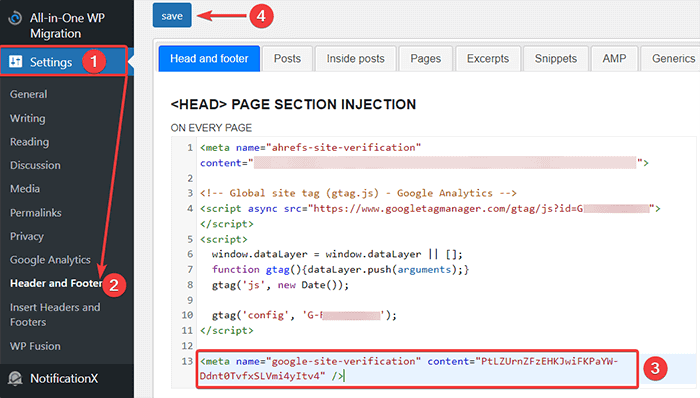

- Setelah itu, redirect ke Settings -> Header and Footer dari Dashboard WordPress Anda dan kemudian paste kode yang disalin di tab Head and footer. Setelah Anda selesai, klik tombol Simpan.

- Kembali ke tab Google Search Console di browser Anda. Kemudian, klik tombol verifikasi.

- Google memeriksa kepemilikan dan menampilkan pesan yang sudah selesai setelah selesai.

- Klik opsi “Go to property” untuk mengakses dasbor Google Search Console.

Sekarang, kembali ke alat penguji Open robot.txt dan uji robots.txt Anda seperti yang disebutkan di atas.

Kelebihan File Robots.txt

Berikut adalah manfaat menggunakan file Robots.txt dalam konteks SEO:

- Ini membantu untuk mengoptimalkan anggaran perayapan mesin pencari dengan melewatkan pengindeksan pada halaman yang Anda tidak ingin bot dirayapi. Ini menciptakan prioritas bagi mesin pencari untuk merayapi hanya halaman yang penting bagi Anda.

- Ini membantu mengoptimalkan server web dengan membatasi bot yang menghabiskan sumber daya yang tidak perlu.

- Ini membantu untuk menyembunyikan halaman login, halaman arahan, halaman terima kasih dari pengindeksan oleh mesin pencari. Dengan demikian, mengoptimalkan kinerja situs web.

Kekurangan File robots.txt

- Membuat file robots.txt cukup mudah, seperti yang sudah kami jelaskan di atas. Namun, file robots.txt juga menyertakan URL ke halaman internal Anda yang tidak ingin diindeks oleh bot perayapan, seperti halaman login. Ini membuat situs web Anda rentan terhadap pelanggaran keamanan.

- Meskipun membuat file robots.txt itu mudah, membuat kesalahan sederhana sekalipun dapat membuang semua upaya Anda. Misalnya, jika Anda menambahkan atau salah menempatkan satu karakter dalam file, itu akan mengacaukan semua upaya SEO Anda.

Pertanyaan yang Sering Diajukan (FAQ)

Apa itu perayapan web?

Mesin pencari mengirim perayap web mereka (juga dikenal sebagai bot atau laba-laba) di seluruh web. Bot ini adalah perangkat lunak pintar yang menavigasi seluruh web untuk menemukan halaman, tautan, dan situs web baru. Proses penemuan ini dikenal sebagai web crawling.

Apa itu pengindeksan?

Ketika perayap web menemukan situs web Anda, mereka mengatur halaman Anda menjadi struktur data yang dapat digunakan. Proses pengorganisasian ini disebut pengindeksan.

Berapa anggaran perayapan?

Anggaran perayapan adalah batas jumlah URL yang dapat dirayapi bot penelusuran dalam sesi tertentu. Setiap situs memiliki alokasi anggaran perayapan tertentu. Jadi, Anda perlu memastikan bahwa Anda membelanjakannya dengan cara yang paling bermanfaat bagi situs Anda.

Misalnya, jika Anda memiliki beberapa halaman di situs Anda, Anda perlu mengalokasikan anggaran perayapan ke halaman yang paling berharga. Dengan demikian, Anda dapat menyebutkan URL halaman di file robots.txt Anda.

Kesimpulan

Saat mengerjakan SEO situs web, sebagian besar pengguna fokus pada pembuatan peta situs, mengerjakan tautan balik, meneliti kata kunci, dan mengoptimalkan konten. Hanya sedikit webmaster yang memperhatikan file robots.txt.

File robots.txt mungkin tidak berperan banyak saat Anda memulai sebuah situs. Namun, seiring pertumbuhan situs web Anda, memperhatikan file robots.txt akan memberikan hasil yang lebih baik.

Juga, ada mitos bahwa memblokir kategori, halaman arsip, dan tag meningkatkan tingkat perayapan dan mempromosikan pengindeksan yang lebih cepat. Itu salah.

Ikuti metode yang kami sebutkan di atas untuk membuat file robots.txt Anda.

Kami harap artikel ini membantu Anda mengurutkan kueri Anda tentang cara membuat dan mengoptimalkan robots.txt WordPress untuk SEO.

Jika Anda ingin membaca lebih banyak artikel bermanfaat terkait WordPress, Anda dapat membaca artikel berikut:

- Bagaimana Cara Membuat Peta Situs di WordPress?

- Bagaimana Memulai Blog WordPress?