Jak zoptymalizować WordPress Robots.txt pod kątem SEO na przykładzie

Opublikowany: 2021-12-20SEO było najwyższym priorytetem dla właścicieli witryn. Przy pięciu najlepszych wynikach, które uzyskały 75% kliknięć, wyścig o wyższą pozycję w rankingu był nie lada wyzwaniem. W grę wchodzą różne techniki SEO poza stroną i na stronie. Optymalizacja pliku Robot.txt to jedna z tych sztuczek, które mogą wzmocnić SEO Twojej witryny.

Jednak większość początkujących nie wie, jak zoptymalizować WordPress Robots.txt pod kątem SEO. Niektórzy mogą nawet nie wiedzieć, czym jest plik robots.txt.

Na szczęście ten artykuł jest na twoją pomoc.

Tutaj wyjaśnimy, czym jest plik robots.txt, jak utworzyć plik robots.txt i jak zoptymalizować plik robots.txt pod kątem SEO. Na końcu dodaliśmy również kilka często zadawanych pytań. Upewnij się więc, że jesteś z nami do końca.

Teraz zacznijmy!

Spis treści

- Co to jest plik Robots.txt?

- Jak wygląda plik Robots.txt?

- Dlaczego potrzebujesz pliku Robots.txt w WordPressie?

- Jak utworzyć plik Robots.txt dla swojej witryny?

- Metoda 1: Tworzenie pliku Robots.txt za pomocą wtyczki Rank Math

- Metoda 2: Tworzenie pliku Robots.txt za pomocą FTP

- Gdzie umieścić plik Robots.txt?

- Jak przetestować plik Robots.txt?

- Plusy pliku Robots.txt

- Wady pliku robots.txt

- Często zadawane pytania (FAQ)

- Co to jest indeksowanie sieci?

- Co to jest indeksowanie?

- Jaki jest budżet indeksowania?

- Wniosek

Co to jest plik Robots.txt?

Robots.txt w WordPress to zwykły plik tekstowy, który informuje roboty wyszukiwarek, które strony w Twojej witrynie mają przeszukiwać i indeksować. Możesz także sformatować plik, aby wykluczyć strony z indeksowania.

Plik robots.txt jest przechowywany w katalogu głównym WordPressa. Ten plik ma podstawowy format, który wygląda tak:

User-agent: [user-name] Disallow: [URL of the string not to be crawled] Allow: [URL of the string to be crawled] Sitemap: [URL of your WordPress XML Sitemap]Jak wygląda plik Robots.txt?

Plik robots.txt to po prostu kilka wierszy tekstu, które wskazują wyszukiwarkom, jak i co mają indeksować w Twojej witrynie. W tym pliku jest wiele wierszy, aby zezwolić lub ograniczyć określone adresy URL stron. Możesz też dodać wiele map witryn. Jeśli zabronisz adresu URL, roboty wyszukiwarek nie będą indeksować tej strony.

Oto przykład pliku robots.txt:

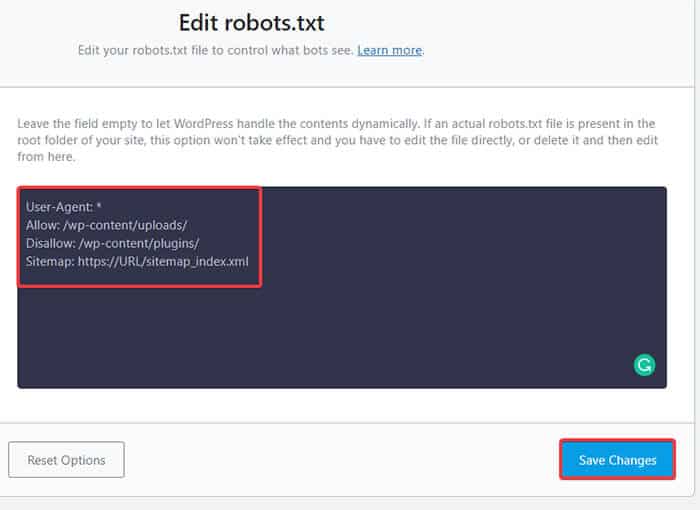

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Sitemap: https://URL/sitemap_index.xmlTeraz poznajmy te cztery główne terminy, które można znaleźć w pliku robots:

- User-agent : User-agent to konkretny robot internetowy, któremu przekazujesz instrukcje indeksowania. Zwykle jest to wyszukiwarka.

- Zezwól : Zezwól to polecenie informujące Googlebota, że może uzyskać dostęp do strony lub podfolderu, nawet jeśli jego podfolder lub strona nadrzędna mogą być niedozwolone.

- Disallow : polecenie disallow mówi klientowi użytkownika, aby nie indeksował określonego adresu URL. Możesz dołączyć tylko jeden wiersz „Disallow:” dla każdego adresu URL.

- Mapa witryny : mapa witryny służy do wskazywania lokalizacji wszelkich map witryn XML powiązanych z tym adresem URL. To polecenie jest obsługiwane tylko przez Google, Bing, Ask i Yahoo.

W powyższym przykładzie zezwoliliśmy botom wyszukiwania na indeksowanie i indeksowanie folderu przesyłania, ale ograniczyliśmy folder wtyczek. Ostatecznie zezwoliliśmy na indeksowanie mapy witryny XML.

Znak gwiazdki po User-Agent oznacza, że tekst dotyczy wszystkich botów wyszukiwarek. Każda wyszukiwarka ma swojego agenta użytkownika do indeksowania witryn. Oto niektóre klienty użytkownika niektórych popularnych wyszukiwarek:

- Google: Googlebot

- Obrazy Googlebota: Googlebot-Obraz

- Wiadomości o Googlebocie: Wiadomości o Googlebocie

- Wideo Googlebota: Wideo Googlebota

- Yahoo: Slurp Bot

- Bing: Bingbot

- Alexa Amazona: ia_archiver

- DuckDuckGo: DuckDuckBot

- Yandex: YandexBot

- Baidu: Baiduspider

- Exalead: ExaBot

W dzisiejszych czasach jest tak wielu klientów użytkownika. Jeśli chcesz skupić się na konkretnej wyszukiwarce, możesz nawet określić ją w pliku robots.txt. Oznacza to, że aby skonfigurować instrukcje dla Googlebota, możesz wpisać pierwszy wiersz pliku robots.txt jako:

Klient użytkownika: Googlebot

Dlaczego potrzebujesz pliku Robots.txt w WordPressie?

Boty wyszukiwania będą przeszukiwać i indeksować Twoją witrynę, nawet jeśli nie masz pliku robots.txt. Dlaczego więc naprawdę tego potrzebujesz? Cóż, dzięki plikowi robots.txt możesz nakazać wyszukiwarkom priorytet indeksowania niektórych stron. Możesz także wykluczyć strony lub foldery, których nie chcesz indeksować.

Nie ma to większego wpływu, gdy po raz pierwszy założyć bloga i nie mieć dużo treści. Jednak gdy Twoja witryna się rozrośnie i będzie zawierała dużo treści, może być konieczne nadanie priorytetu indeksowaniu określonej strony/postu/folderu i zanegowanie niektórych.

Widzisz, istnieje limit dla każdego bota wyszukiwania dla każdej witryny. Oznacza to, że boty indeksują określoną liczbę stron podczas określonej sesji indeksowania. Jeśli boty nie zakończą indeksowania w tej konkretnej sesji, bot wraca i wznawia indeksowanie w następnej sesji. Spowalnia to indeksowanie Twojej witryny.

Tak więc, używając pliku robots.txt, możesz kierować boty wyszukiwania, które strony, pliki i foldery chcesz zaindeksować i które uwzględnić. W ten sposób oszczędzasz limit indeksowania. Może to nie być najbezpieczniejszy sposób na ukrycie treści przed opinią publiczną, ale zapobiega pojawianiu się tych wykluczonych treści w SERPach.

Jak utworzyć plik Robots.txt dla swojej witryny?

Plik robots.txt można utworzyć na dwa różne sposoby. Wyjaśnimy te metody poniżej. Następnie możesz zastosować metodę, która Twoim zdaniem będzie dla Ciebie najlepsza.

Metoda 1: Tworzenie pliku Robots.txt za pomocą wtyczki Rank Math

Tutaj pokażemy Ci, jak utworzyć plik robots.txt za pomocą popularnej wtyczki Rank Math.

Rank Math to wtyczka SEO WordPress, która ułatwia optymalizację treści witryny dzięki wbudowanym sugestiom opartym na powszechnie akceptowanych najlepszych praktykach. Korzystając z tego poręcznego narzędzia, możesz łatwo dostosować ważne ustawienia SEO i kontrolować, które strony są indeksowane.

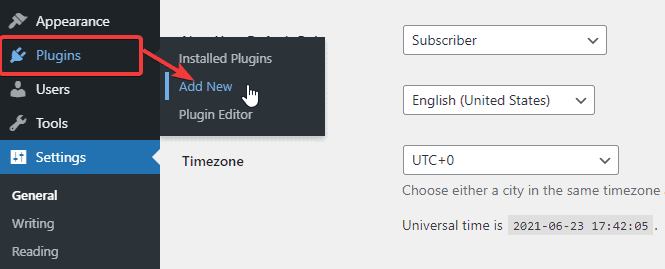

Aby utworzyć plik robots.txt za pomocą wtyczki Rank Math, najpierw pobierz wtyczkę, przechodząc do Wtyczki -> Dodaj nowy z pulpitu administratora WordPress.

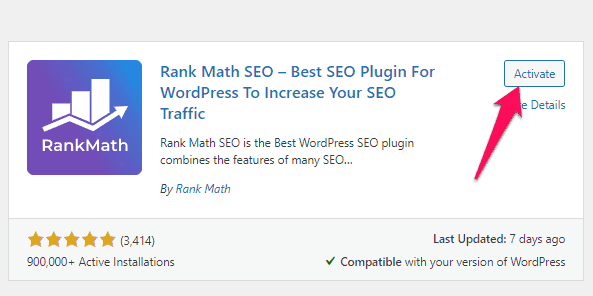

Teraz wyszukaj Rang Math na pasku wyszukiwania i kliknij przycisk Zainstaluj teraz i aktywuj , gdy znajdziesz wtyczkę.

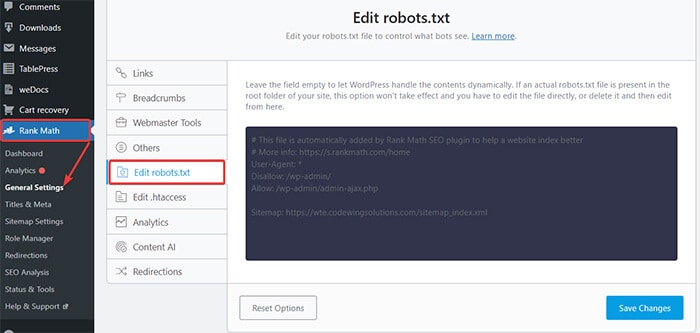

Po aktywacji wtyczki przejdź do opcji Rang Math -> Ustawienia ogólne -> Edytuj plik robots.txt z pulpitu nawigacyjnego WordPress.

Teraz wprowadź następujący kod lub skopiuj kod z poprzedniego przykładu w puste miejsce i kliknij przycisk Zapisz zmiany .

Proszę bardzo! Pomyślnie utworzyłeś plik robots.txt za pomocą wtyczki Rank Math.

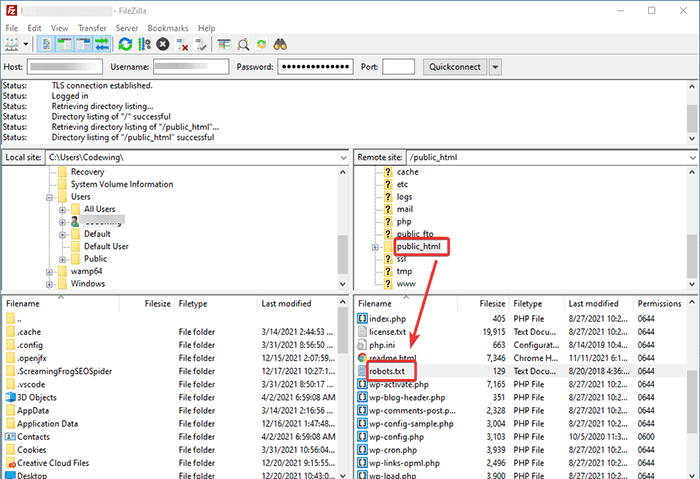

Metoda 2: Tworzenie pliku Robots.txt za pomocą FTP

Druga metoda polega na ręcznym utworzeniu pliku robots.txt na komputerze lokalnym, a następnie przesłaniu go do folderu głównego witryny WordPress.

Będziesz musiał uzyskać dostęp do swojego hostingu WordPress za pomocą klienta FTP. Po zalogowaniu się do klienta FTP możesz zobaczyć plik robots.txt w folderze głównym witryny. Kliknij prawym przyciskiem myszy i wybierz opcję Edytuj .

Teraz dodaj swoją niestandardową regułę do pliku i zapisz zmiany. Na przykład:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpJeśli nie widzisz pliku w folderze głównym, możesz go utworzyć na komputerze lokalnym za pomocą notatnika. Dodaj do niego swoje reguły, a następnie prześlij je do folderu rooter za pomocą FTP.

Gdzie umieścić plik Robots.txt?

Plik robots.txt należy zawsze umieszczać w katalogu głównym witryny. Jeśli na przykład Twoja witryna to nazwadomeny.com , domeną pliku robots.txt będzie https://nazwadomeny.com/robots.txt.

Oprócz dodania pliku robots.txt do katalogu głównego, oto kilka dodatkowych wskazówek:

- Konieczne jest nazwanie pliku „robots.txt”.

- W nazwie pliku rozróżniana jest wielkość liter. Dlatego musisz to zrobić dobrze, bo inaczej nie zadziała.

- Musisz dodać nową linię dla każdej nowej reguły.

- Dodaj znak „$”, aby wskazać koniec adresu URL.

- Użyj każdego klienta użytkownika tylko raz.

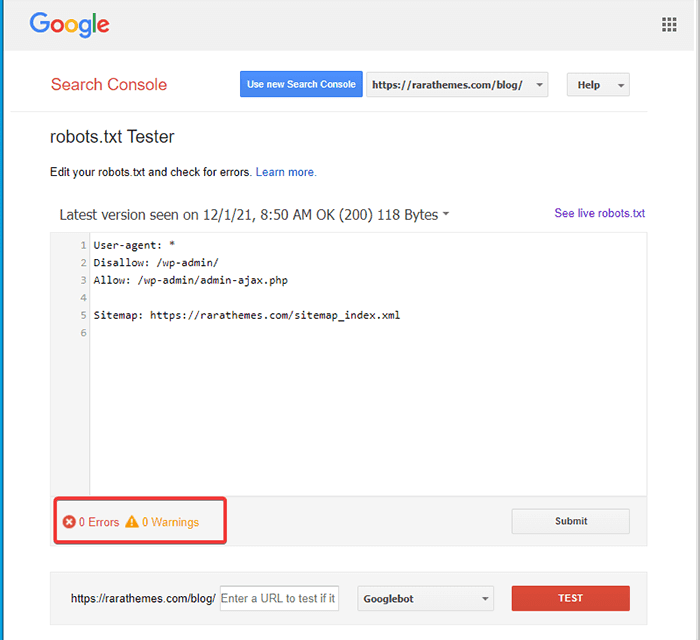

Jak przetestować plik Robots.txt?

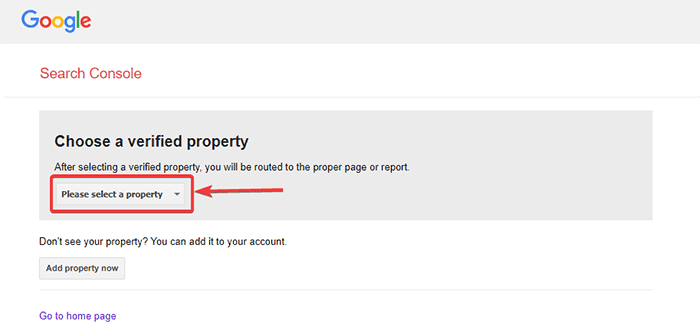

Po utworzeniu pliku robots.txt możesz go przetestować za pomocą Google Search Console. Tutaj znajdziesz narzędzie testowe Open robot.txt.

- Wybierz swoją nieruchomość z podanej listy rozwijanej.

Narzędzie pobiera plik robots.txt Twojej witryny i podświetla błędy oraz ostrzeżenia, jeśli je znajdzie.

Uwaga : opcja rozwijanej właściwości pojawia się tylko wtedy, gdy połączyłeś swoją witrynę WordPress z Google Search Console.

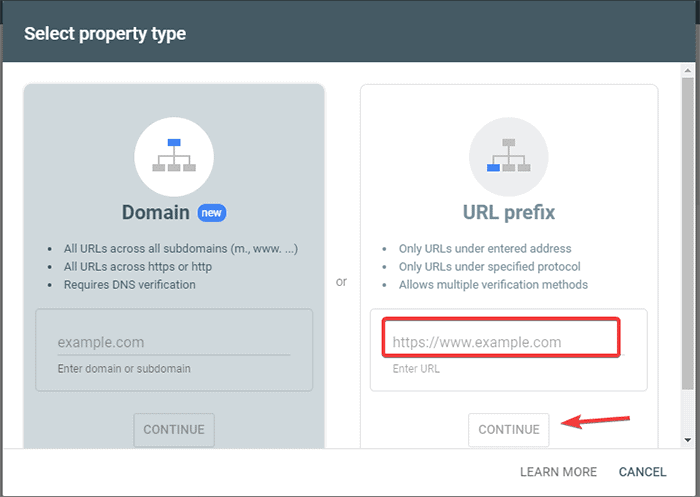

Jeśli tego nie zrobiłeś, możesz szybko połączyć swoją witrynę w następujący sposób:

- Zaloguj się do Google Search Console i utwórz konto. Możesz skonfigurować swoje konto, używając swojej domeny lub prefiksu adresu URL. Zaleca się stosowanie prefiksu adresu URL, ponieważ jest to stosunkowo łatwiejsze.

- Wpisz adres URL swojej witryny.

- Teraz kliknij przycisk „Kontynuuj”.

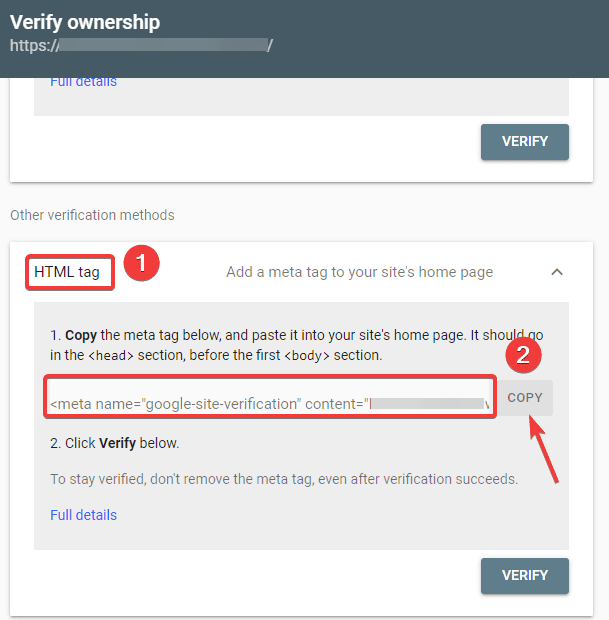

- Powinieneś teraz zweryfikować własność witryny. Możesz to zrobić za pomocą dowolnej z podanych opcji. Zalecamy jednak korzystanie z opcji tagu HTML.

- Skopiuj podany kod, a następnie przejdź do pulpitu WordPress.

Możesz teraz zweryfikować kod za pomocą wtyczki Insert Headers and Footers. Do weryfikacji:

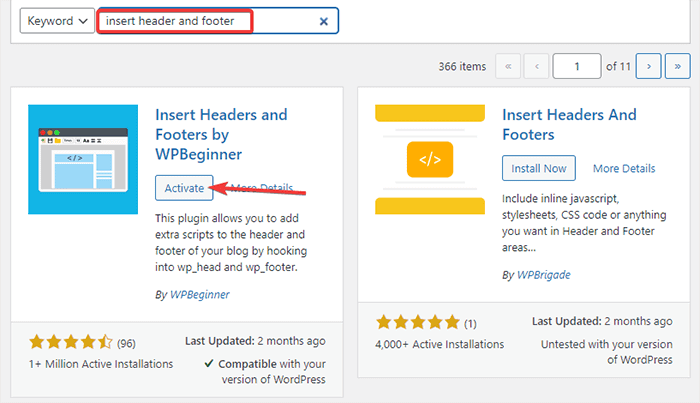

- Przejdź do Wtyczki -> Dodaj nowy z pulpitu administratora WordPress.

- Teraz wyszukaj wtyczkę Wstaw nagłówki i stopki na pasku wyszukiwania, a następnie zainstaluj i aktywuj wtyczkę.

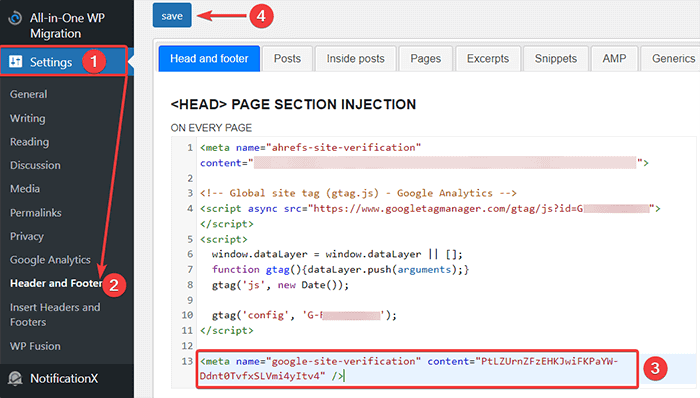

- Następnie przekieruj do opcji Ustawienia -> Nagłówek i stopka z pulpitu nawigacyjnego WordPress, a następnie wklej skopiowany kod w zakładce Nagłówek i stopka. Gdy skończysz, kliknij przycisk Zapisz.

- Wróć do karty Google Search Console w przeglądarce. Następnie kliknij przycisk weryfikacji.

- Google sprawdza prawo własności i wyświetla ukończony komunikat po zakończeniu.

- Kliknij opcję „Przejdź do usługi”, aby uzyskać dostęp do panelu Google Search Console.

Teraz wróć do narzędzia testowego Open robot.txt i przetestuj swój robots.txt, jak wspomniano powyżej.

Plusy pliku Robots.txt

Oto zalety korzystania z pliku Robots.txt w kontekście SEO:

- Pomaga zoptymalizować budżety indeksowania wyszukiwarki, pomijając indeksowanie stron, których nie chcesz indeksować. Stwarza to priorytet wyszukiwarce, aby indeksować tylko te strony, które są dla Ciebie ważne.

- Pomaga zoptymalizować serwer WWW, ograniczając boty, które niepotrzebnie zużywają zasoby.

- Pomaga ukryć strony logowania, strony docelowe, strony z podziękowaniami przed indeksowaniem przez wyszukiwarki. W ten sposób optymalizuje działanie strony.

Wady pliku robots.txt

- Tworzenie pliku robots.txt jest dość łatwe, jak wyjaśniliśmy powyżej. Jednak plik robots.txt zawiera również adresy URL stron wewnętrznych, których indeksowanie przez roboty indeksujące nie ma być indeksowane, takich jak strona logowania. To sprawia, że Twoja witryna jest podatna na naruszenia bezpieczeństwa.

- Chociaż tworzenie pliku robots.txt jest łatwe, nawet prosty błąd może zmarnować cały wysiłek. Na przykład, jeśli dodasz lub zgubisz pojedynczy znak w pliku, zepsuje to wszystkie twoje wysiłki SEO.

Często zadawane pytania (FAQ)

Co to jest indeksowanie sieci?

Wyszukiwarki wysyłają swoje roboty sieciowe (znane również jako boty lub pająki) przez sieć. Te boty to inteligentne oprogramowanie, które porusza się po całej sieci w celu odkrywania nowych stron, linków i witryn. Ten proces wykrywania jest znany jako indeksowanie sieci.

Co to jest indeksowanie?

Gdy roboty indeksujące wykryją Twoją witrynę, uporządkują Twoje strony w użyteczną strukturę danych. Ten proces organizowania nazywa się indeksowaniem.

Jaki jest budżet indeksowania?

Budżet indeksowania to limit liczby adresów URL, które robot wyszukiwania może zaindeksować w danej sesji. Każda witryna ma określony przydział budżetu indeksowania. Musisz więc upewnić się, że wydajesz je w sposób, który jest najbardziej korzystny dla Twojej witryny.

Na przykład, jeśli masz wiele stron w swojej witrynie, musisz przydzielić budżet indeksowania do najbardziej wartościowych stron. W ten sposób możesz podać adres URL strony w pliku robots.txt.

Wniosek

Podczas pracy nad SEO witryny większość użytkowników koncentruje się na tworzeniu map witryn, pracy nad linkami zwrotnymi, badaniu słów kluczowych i optymalizacji treści. Tylko nieliczni webmasterzy zwracają uwagę na plik robots.txt.

Plik robots.txt może nie odgrywać dużej roli podczas uruchamiania witryny. Jednak wraz z rozwojem witryny zwracanie uwagi na plik robots.txt daje lepsze wyniki.

Istnieje również mit, że blokowanie kategorii, stron archiwalnych i tagów zwiększa szybkość indeksowania i przyspiesza indeksowanie. To fałszywe.

Postępuj zgodnie z metodami, które wymieniliśmy powyżej, aby utworzyć plik robots.txt.

Mamy nadzieję, że ten artykuł pomógł Ci uporządkować zapytanie dotyczące tworzenia i optymalizacji pliku robots.txt WordPress pod kątem SEO.

Jeśli chcesz przeczytać więcej przydatnych artykułów związanych z WordPressem, możesz przeczytać następujące artykuły:

- Jak stworzyć mapę witryny w WordPress?

- Jak założyć blog WordPress?