如何通过示例为 SEO 优化 WordPress Robots.txt

已发表: 2021-12-20SEO一直是网站所有者的首要任务。 前五名的结果获得了 75% 的点击次数,争夺更高排名一直是一项挑战。 有各种页外和页内 SEO 技术可以发挥作用。 优化 Robot.txt 文件是可以加强网站 SEO 的技巧之一。

但是,大多数初学者不知道如何针对 SEO 优化 WordPress Robots.txt。 有些人可能一开始甚至不知道 robots.txt 文件是什么。

幸运的是,这篇文章助您一臂之力。

在这里,我们将解释什么是 robots.txt 文件,如何创建 robots.txt 文件,以及如何针对 SEO 优化 robots.txt 文件。 我们还在最后添加了一些常见问题解答。 所以请确保你和我们在一起直到最后。

现在,让我们开始吧!

目录

- 什么是 Robots.txt 文件?

- Robots.txt 文件是什么样的?

- 为什么在 WordPress 中需要 Robots.txt 文件?

- 如何为您的网站创建 Robots.txt?

- 方法 1:使用 Rank Math 插件创建 Robots.txt 文件

- 方法 2:使用 FTP 创建 Robots.txt 文件

- 将 Robots.txt 文件放在哪里?

- 如何测试 Robots.txt 文件?

- Robots.txt 文件的优点

- robots.txt 文件的缺点

- 常见问题 (FAQ)

- 什么是网络爬虫?

- 什么是索引?

- 抓取预算是多少?

- 结论

什么是 Robots.txt 文件?

WordPress 中的 Robots.txt 是一个纯文本文件,它通知搜索引擎机器人要抓取和索引您网站上的哪些页面。 您还可以格式化文件以从索引中排除页面。

robots.txt 存储在 WordPress 根目录中。 该文件的基本格式如下所示:

User-agent: [user-name] Disallow: [URL of the string not to be crawled] Allow: [URL of the string to be crawled] Sitemap: [URL of your WordPress XML Sitemap]Robots.txt 文件是什么样的?

robots.txt 文件只是几行文本,可指导搜索引擎如何以及在您的网站上抓取什么内容。 您在此文件中有多行来允许或限制特定页面 URL。 您还可以添加多个站点地图。 如果您禁止某个 URL,则搜索引擎机器人不会抓取该页面。

以下是 robots.txt 文件的示例:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Sitemap: https://URL/sitemap_index.xml现在,让我们了解一下可以在 robots 文件中找到的这四个主要术语:

- User-agent :User-agent 是您提供抓取指令的特定网络爬虫。 它通常是一个搜索引擎。

- Allow :Allow 是告诉 Googlebot 它可以访问页面或子文件夹的命令,即使其子文件夹或父页面可能被禁止。

- Disallow :disallow 命令告诉用户代理不要抓取特定的 URL。 每个 URL 只能包含一个“Disallow:”行。

- 站点地图:站点地图用于标注与此 URL 相关的任何 XML 站点地图的位置。 此命令仅受 Google、Bing、Ask 和 Yahoo 支持。

在上面的示例中,我们允许搜索机器人抓取并索引上传文件夹,但限制了插件文件夹。 最后,我们允许对 XML 站点地图进行索引。

User-Agent后面的星号表示文本适用于所有搜索引擎机器人。 每个搜索引擎都有自己的用户代理来索引网站。 以下是一些流行搜索引擎的一些用户代理:

- 谷歌:谷歌机器人

- Googlebot 图片:Googlebot 图片

- Googlebot 新闻:Googlebot 新闻

- Googlebot 视频:Googlebot 视频

- 雅虎:啜食机器人

- 必应:Bingbot

- 亚马逊的 Alexa:ia_archiver

- DuckDuckGo:鸭鸭机器人

- Yandex:YandexBot

- 百度:百度蜘蛛

- Exalead:ExaBot

现在有很多用户代理。 如果您想专注于特定的搜索引擎,您甚至可以在 robots.txt 文件中指定它。 也就是说,要为 Googlebot 设置指令,您可以将 robots.txt 文件的第一行编写为:

用户代理:Googlebot

为什么在 WordPress 中需要 Robots.txt 文件?

即使您没有 robots.txt 文件,搜索机器人也会抓取您的网站并将其编入索引。 那么,为什么你真的需要它呢? 好吧,使用 robots.txt 文件,您可以指示搜索引擎在某些页面上优先编制索引。 此外,您可以排除不想编制索引的页面或文件夹。

当您第一次使用时,这不会产生更大的影响 开始一个博客,没有很多内容。 但是,在您的网站增长并拥有大量内容后,您可能需要优先对某个页面/帖子/文件夹进行索引并否定一些。

你看,每个网站的每个搜索机器人都有一个配额。 这意味着机器人在某个抓取会话中抓取一定数量的页面。 如果机器人在该特定会话中没有完成爬行,机器人会返回并在下一个会话中继续爬行。 这会减慢您的网站索引速度。

因此,通过使用 robots.txt 文件,您可以将搜索机器人定向到您想要索引以及包含哪些页面、文件和文件夹。 通过这样做,您可以节省爬网配额。 这可能不是向公众隐藏您的内容的最安全方法,但它可以防止那些被排除的内容出现在 SERP 中。

如何为您的网站创建 Robots.txt?

您可以通过两种不同的方式创建 robots.txt。 我们将在下面解释这些方法。 然后,您可以按照您认为最适合您的方法进行操作。

方法 1:使用 Rank Math 插件创建 Robots.txt 文件

在这里,我们将向您展示如何使用流行的 Rank Math 插件创建 robots.txt 文件。

Rank Math 是一个 SEO WordPress 插件,它可以通过基于广泛接受的最佳实践的内置建议轻松优化您的网站内容。 使用这个方便的工具,您可以轻松自定义重要的 SEO 设置并控制可索引的页面。

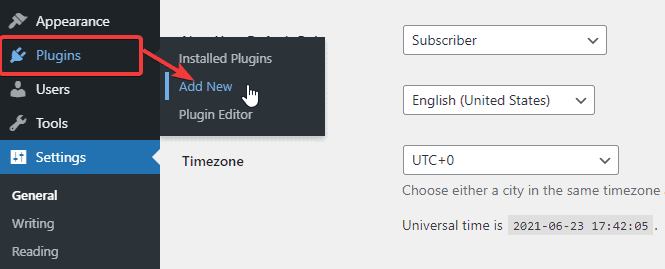

为了使用 Rank Math 插件创建 robots.txt 文件,首先,通过从 WordPress 管理仪表板转到插件 -> 添加新插件来下载插件。

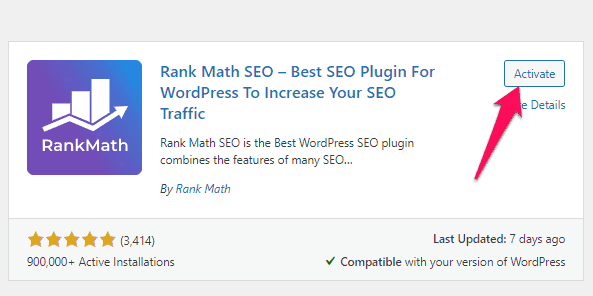

现在,在搜索栏中搜索 Rank Math,找到插件后单击立即安装并激活按钮。

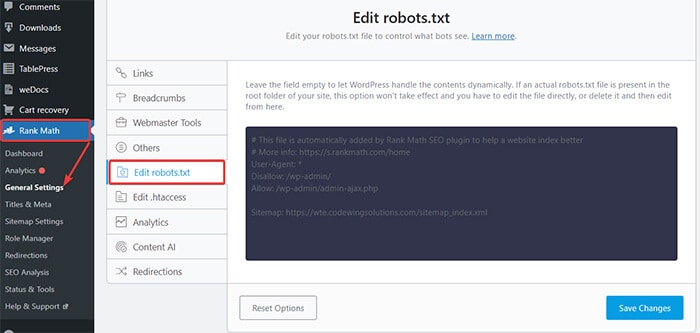

激活插件后,从 WordPress 仪表板转到排名数学 -> 常规设置 -> 编辑 robots.txt 。

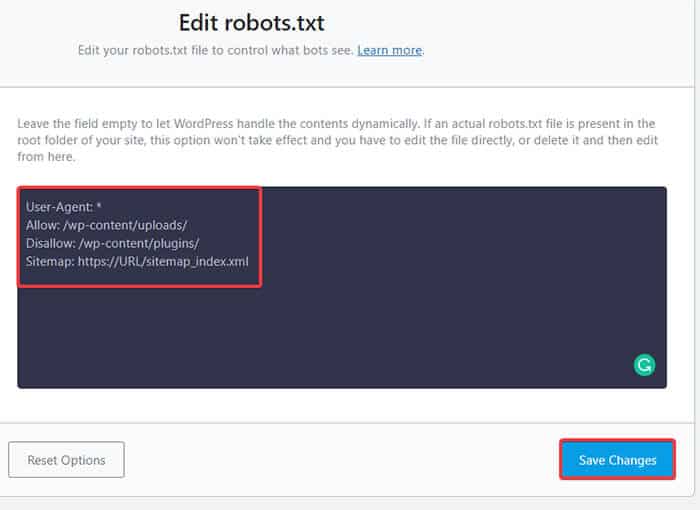

现在,在空白处输入以下代码或复制上一个示例中提到的代码,然后单击Save Changes按钮。

给你! 您已使用 Rank Math 插件成功创建了 robots.txt 文件。

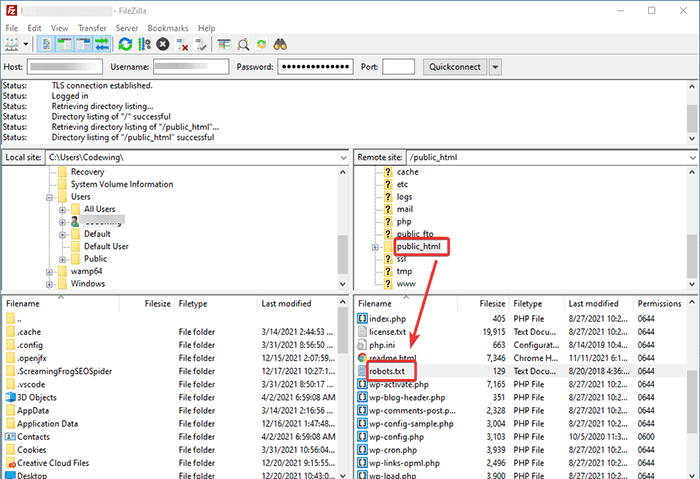

方法 2:使用 FTP 创建 Robots.txt 文件

第二种方法是在本地计算机上手动创建 robots.txt 文件,然后将其上传到 WordPress 站点的根文件夹。

您将需要使用 FTP 客户端访问您的 WordPress 主机。 登录 FTP 客户端后,您可以在网站的根文件夹中看到 robots.txt 文件。 右键单击并选择编辑选项。

现在,将您的自定义规则添加到文件并保存更改。 例如:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php如果您在根文件夹中看不到该文件,您可以使用记事本在本地计算机上创建它。 在其上添加您的规则,然后使用 FTP 将其上传到您的根文件夹。

将 Robots.txt 文件放在哪里?

您应该始终将 robots.txt 文件放在网站的根目录中。 例如,如果您的站点是domainname.com ,那么您的 robots.txt 文件域将为https://domainname.com/robots.txt。

除了在你的根目录中添加 robots.txt 文件,这里还有一些额外的提示:

- 必须将文件命名为“robots.txt”。

- 文件名区分大小写。 因此,您需要正确处理它,否则它将无法正常工作。

- 您需要为每个新规则添加一个新行。

- 添加“$”符号以表示 URL 的结尾。

- 每个用户代理只使用一次。

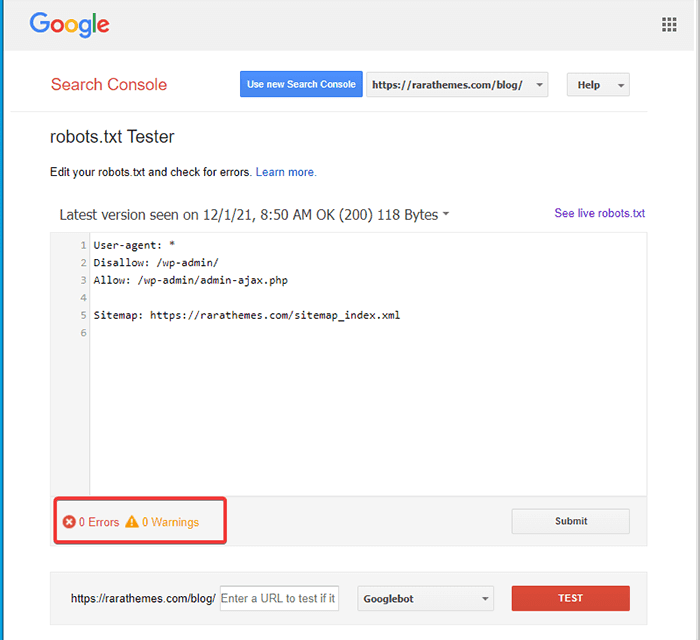

如何测试 Robots.txt 文件?

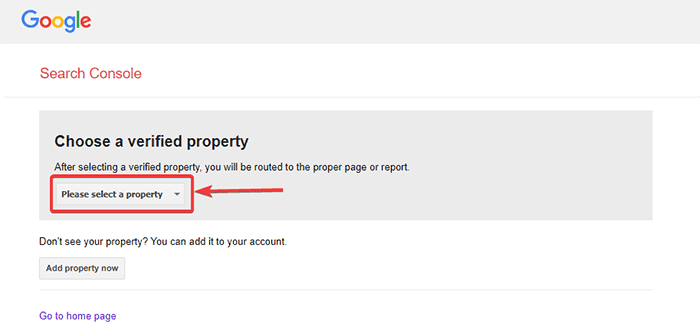

创建 robots.txt 文件后,您可以使用 Google Search Console 对其进行测试。 在这里,您将找到 Open robots.txt 测试工具。

- 从给定的下拉列表中选择您的属性。

该工具会提取您网站的 robots.txt 文件,并在发现错误时突出显示错误和警告。

注意:仅当您已将 WordPress 网站与 Google Search Console 关联时,才会出现下拉属性选项。

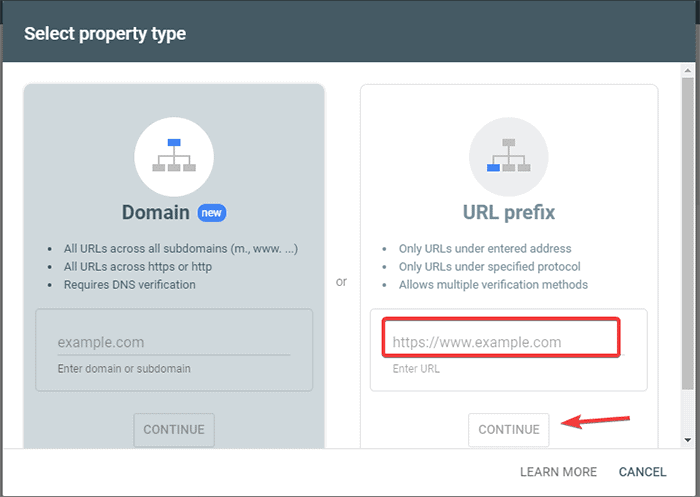

如果您还没有这样做,您可以快速链接您的网站,如下所示:

- 登录 Google Search Console 并创建一个帐户。 您可以使用您的域或 URL 前缀来设置您的帐户。 建议使用 URL 前缀,因为它比较容易。

- 输入您网站的网址。

- 现在,单击“继续”按钮。

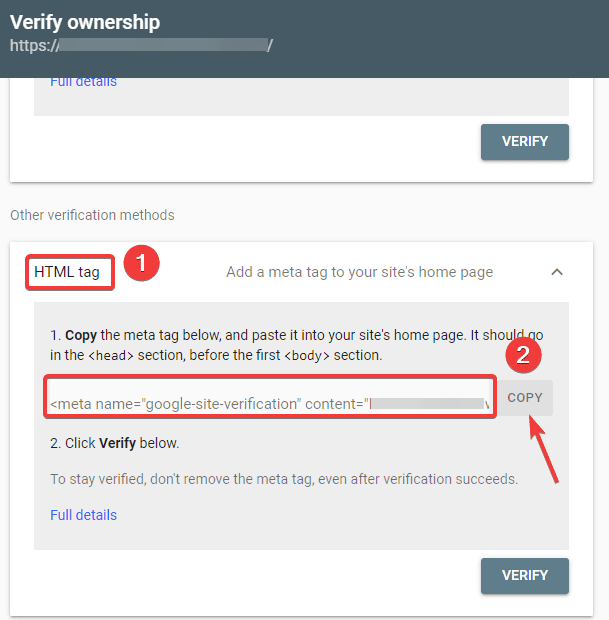

- 您现在应该验证网站的所有权。 您可以使用任何给定的选项来执行此操作。 但是,我们建议使用 HTML 标记选项。

- 复制给定的代码,然后转到您的 WordPress 仪表板。

您现在可以使用插入页眉和页脚插件验证代码。 验证:

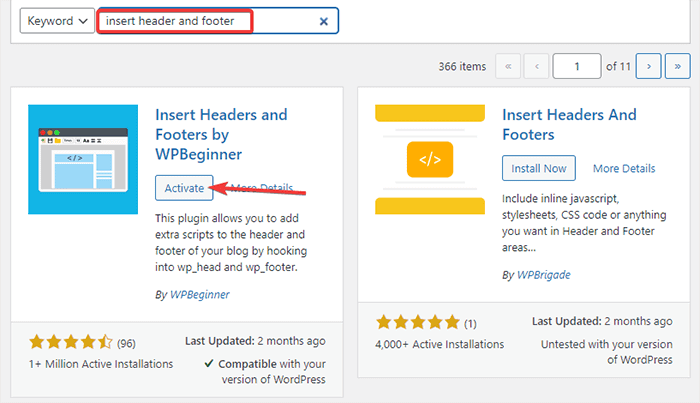

- 从您的 WordPress 管理仪表板转到插件 -> 添加新的。

- 现在,在搜索栏中搜索插入页眉和页脚插件,然后安装并激活插件。

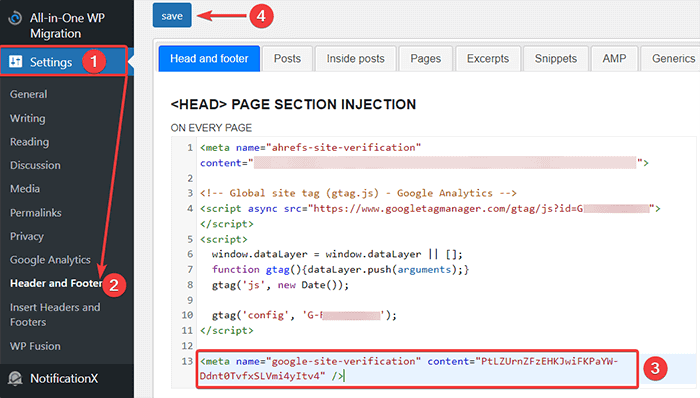

- 之后,从您的 WordPress 仪表板重定向到设置 -> 页眉和页脚,然后将复制的代码粘贴到页眉和页脚选项卡中。 完成后,单击“保存”按钮。

- 返回浏览器上的 Google Search Console 标签。 然后,单击验证按钮。

- 谷歌检查所有权并在完成后显示完整的消息。

- 单击“转到属性”选项以访问 Google Search Console 仪表板。

现在,回到 Open robots.txt 测试工具并如上所述测试您的 robots.txt。

Robots.txt 文件的优点

以下是在 SEO 环境中使用 Robots.txt 文件的好处:

- 它通过跳过您不希望机器人抓取的页面上的索引来帮助优化搜索引擎的抓取预算。 这为搜索引擎创建了一个优先级,以仅抓取对您很重要的页面。

- 它通过限制不必要地消耗资源的机器人来帮助优化 Web 服务器。

- 它有助于隐藏登录页面、登录页面、感谢页面,使其免受搜索引擎的索引。 因此,它优化了网站的性能。

robots.txt 文件的缺点

- 如上所述,创建 robots.txt 文件非常简单。 但是,robots.txt 文件还包含您不希望抓取机器人索引的内部页面的 URL,例如登录页面。 这使您的网站容易受到安全漏洞的影响。

- 虽然创建 robots.txt 文件很容易,但即使是一个简单的错误也会使您的所有努力付诸东流。 例如,如果您在文件中添加或放错了一个字符,它会打乱您所有的 SEO 工作。

常见问题 (FAQ)

什么是网络爬虫?

搜索引擎通过网络发送他们的网络爬虫(也称为机器人或蜘蛛)。 这些机器人是智能软件,可以导航整个网络以发现新页面、链接和网站。 这个发现过程被称为网络爬行。

什么是索引?

当网络爬虫发现您的网站时,它们会将您的页面排列成可用的数据结构。 这种组织过程称为索引。

抓取预算是多少?

抓取预算是对搜索机器人在给定会话中可以抓取多少 URL 的限制。 每个站点都有特定的抓取预算分配。 因此,您需要确保以对您的网站最有利的方式使用它。

例如,如果您的网站上有多个页面,则需要将抓取预算分配给最有价值的页面。 因此,您可以在 robots.txt 文件中提及页面 URL。

结论

在处理网站的 SEO 时,大多数用户专注于创建站点地图、处理反向链接、研究关键字和优化内容。 只有少数站长关注 robots.txt 文件。

启动站点时,robots.txt 文件可能起不了多大作用。 但是,随着您网站的发展,关注 robots.txt 文件会产生更好的结果。

此外,还有一个神话,即阻止类别、存档页面和标签会提高抓取速度并促进更快的索引编制。 这是假的。

按照我们上面提到的方法创建您的 robots.txt 文件。

我们希望本文能帮助您对有关如何为 SEO 创建和优化 WordPress robots.txt 的查询进行排序。

如果您想阅读更多与 WordPress 相关的有用文章,您可以阅读以下文章:

- 如何在 WordPress 中创建站点地图?

- 如何开始一个 WordPress 博客?