Comment optimiser WordPress Robots.txt pour le référencement avec un exemple

Publié: 2021-12-20Le référencement est une priorité absolue pour les propriétaires de sites Web. Avec les cinq premiers résultats gagnant 75% des clics, la course pour un meilleur classement a été un défi. Il existe diverses techniques de référencement hors page et sur page qui entrent en jeu. L'optimisation du fichier Robot.txt fait partie de ces astuces qui peuvent renforcer le référencement de votre site.

Cependant, la plupart des débutants ne savent pas comment optimiser WordPress Robots.txt pour le référencement. Certains pourraient même ne pas savoir ce qu'est un fichier robots.txt en premier lieu.

Heureusement, cet article est à votre secours.

Ici, nous expliquerons ce qu'est un fichier robots.txt, comment créer le fichier robots.txt et comment optimiser le fichier robots.txt pour le référencement. Nous avons également ajouté quelques FAQ à la fin. Alors assurez-vous d'être avec nous jusqu'à la fin.

Maintenant, commençons !

Table des matières

- Qu'est-ce qu'un fichier Robots.txt ?

- À quoi ressemble un fichier Robots.txt ?

- Pourquoi avez-vous besoin d'un fichier Robots.txt dans WordPress ?

- Comment créer un Robots.txt pour votre site Web ?

- Méthode 1 : création d'un fichier Robots.txt à l'aide du plugin Rank Math

- Méthode 2 : Création d'un fichier Robots.txt à l'aide de FTP

- Où placer votre fichier Robots.txt ?

- Comment tester le fichier Robots.txt ?

- Avantages du fichier Robots.txt

- Inconvénients du fichier robots.txt

- Foire aux questions (FAQ)

- Qu'est-ce que l'exploration Web ?

- Qu'est-ce que l'indexation ?

- Quel est le budget de crawl ?

- Conclusion

Qu'est-ce qu'un fichier Robots.txt ?

Robots.txt dans WordPress est un fichier texte brut qui informe les robots des moteurs de recherche des pages de votre site à explorer et à indexer. Vous pouvez également formater le fichier pour exclure les pages de l'indexation.

Le robots.txt est stocké dans le répertoire racine de WordPress. Ce fichier a un format de base qui ressemble à ceci :

User-agent: [user-name] Disallow: [URL of the string not to be crawled] Allow: [URL of the string to be crawled] Sitemap: [URL of your WordPress XML Sitemap]À quoi ressemble un fichier Robots.txt ?

Un fichier robots.txt est simplement quelques lignes de texte qui orientent les moteurs de recherche sur comment et quoi explorer sur votre site. Vous avez plusieurs lignes sur ce fichier pour autoriser ou restreindre des URL de page spécifiques. Vous pouvez également ajouter plusieurs sitemaps. Si vous n'autorisez pas une URL, les robots des moteurs de recherche n'explorent pas cette page.

Voici un exemple de fichier robots.txt :

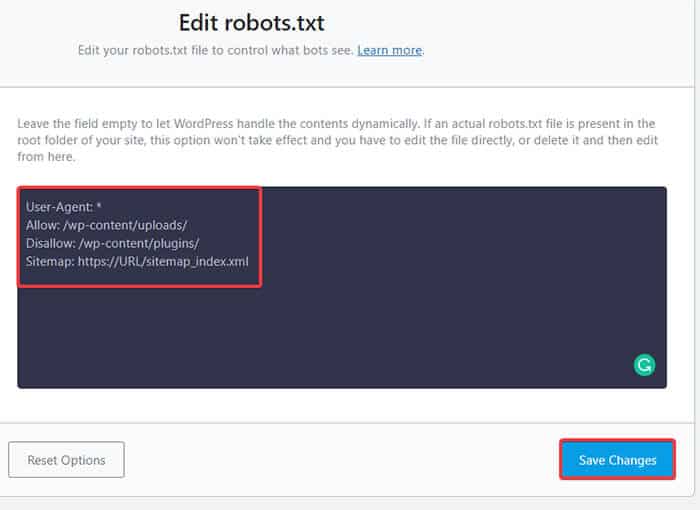

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Sitemap: https://URL/sitemap_index.xmlDécouvrons maintenant ces quatre termes majeurs que vous pouvez trouver dans un fichier robots :

- User-agent : L'agent utilisateur est le robot d'exploration Web spécifique auquel vous donnez des instructions d'exploration. Il s'agit généralement d'un moteur de recherche.

- Autoriser : Autoriser est la commande qui indique à Googlebot qu'il peut accéder à une page ou à un sous-dossier même si son sous-dossier ou une page parent peut être interdit.

- Disallow : La commande disallow indique à un agent utilisateur de ne pas explorer une URL particulière. Vous ne pouvez inclure qu'une seule ligne "Disallow :" pour chaque URL.

- Plan du site : le plan du site est utilisé pour indiquer l'emplacement de tout plan de site XML lié à cette URL. Cette commande est uniquement prise en charge par Google, Bing, Ask et Yahoo.

Dans l'exemple ci-dessus, nous avons autorisé les robots de recherche à explorer et à indexer le dossier des téléchargements, mais nous avons restreint le dossier des plugins. Au final, nous avons autorisé l'indexation du sitemap XML.

Le signe astérisque après User-Agent signifie que le texte s'applique à tous les robots des moteurs de recherche. Chaque moteur de recherche a son agent utilisateur pour indexer les sites. Voici quelques agents utilisateurs de certains moteurs de recherche populaires :

- Google : Googlebot

- Googlebot Images : Googlebot-Image

- Actualités Googlebot : Googlebot-Actualités

- Vidéo Googlebot : Googlebot-Vidéo

- Yahoo : Slurp Bot

- Bing : Bingbot

- Alexa d'Amazon : ia_archiver

- DuckDuckGo : DuckDuckBot

- Yandex : YandexBot

- Baidu : Araignée Baidu

- Exalead : ExaBot

Il y a tellement d'agents utilisateurs de nos jours. Si vous souhaitez vous concentrer sur un moteur de recherche particulier, vous pouvez même le spécifier sur le fichier robots.txt. Autrement dit, pour configurer les instructions pour le Googlebot, vous pouvez écrire la première ligne de votre fichier robots.txt comme suit :

Agent utilisateur : Googlebot

Pourquoi avez-vous besoin d'un fichier Robots.txt dans WordPress ?

Les robots de recherche exploreront et indexeront votre site même si vous n'avez pas de fichier robots.txt. Alors, pourquoi en auriez-vous vraiment besoin ? Eh bien, avec le fichier robots.txt, vous pouvez demander aux moteurs de recherche de donner la priorité à l'indexation sur certaines pages. Vous pouvez également exclure des pages ou des dossiers que vous ne souhaitez pas indexer.

Cela n'a pas un plus grand impact lorsque vous créer un blog et ne pas avoir beaucoup de contenu. Cependant, une fois que votre site se développe et contient beaucoup de contenu, vous devrez peut-être donner la priorité à l'indexation sur une certaine page/publication/dossier et en annuler certaines.

Vous voyez, il y a un quota pour chaque robot de recherche pour chaque site Web. Cela signifie que les bots explorent un certain nombre de pages lors d'une certaine session d'exploration. Si les bots ne terminent pas l'exploration dans cette session particulière, le bot revient et reprend l'exploration dans la session suivante. Cela ralentit le taux d'indexation de votre site Web.

Ainsi, en utilisant le fichier robots.txt, vous pouvez diriger les robots de recherche sur les pages, fichiers et dossiers que vous souhaitez indexer et lesquels inclure. Ce faisant, vous économisez le quota de crawl. Ce n'est peut-être pas le moyen le plus sûr de cacher votre contenu au public, mais cela empêche ces contenus exclus d'apparaître dans les SERP.

Comment créer un Robots.txt pour votre site Web ?

Vous pouvez créer robots.txt de deux manières différentes. Nous expliquerons ces méthodes ci-dessous. Vous pouvez ensuite suivre la méthode qui, selon vous, fonctionnera le mieux pour vous.

Méthode 1 : création d'un fichier Robots.txt à l'aide du plugin Rank Math

Ici, nous allons vous montrer comment créer un fichier robots.txt en utilisant le populaire plugin Rank Math.

Rank Math est un plugin SEO WordPress qui facilite l'optimisation du contenu de votre site Web avec des suggestions intégrées basées sur les meilleures pratiques largement acceptées. À l'aide de cet outil pratique, vous pouvez facilement personnaliser les paramètres de référencement importants et contrôler les pages indexables.

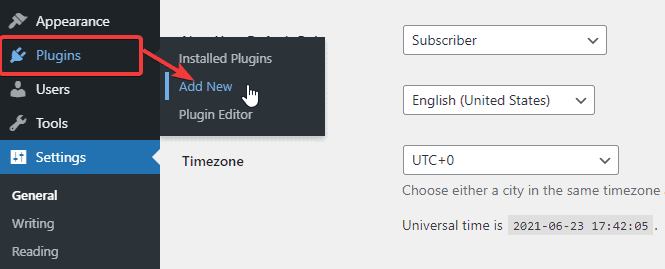

Afin de créer un fichier robots.txt à l'aide du plugin Rank Math, commencez par télécharger le plugin en allant dans Plugins -> Ajouter un nouveau depuis votre tableau de bord d'administration WordPress.

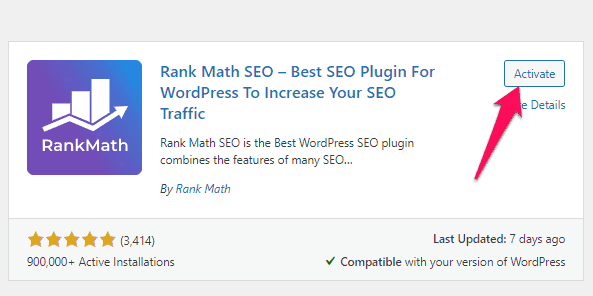

Maintenant, recherchez Rank Math dans la barre de recherche et cliquez sur le bouton Installer maintenant et activer une fois que vous avez trouvé le plugin.

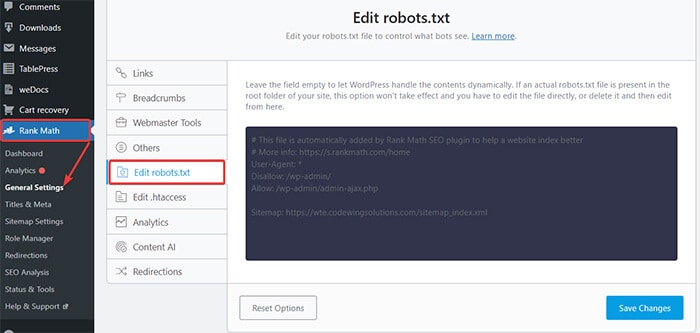

Une fois que vous avez activé le plugin, rendez-vous sur Rank Math -> General Settings -> Edit robots.txt depuis le tableau de bord WordPress.

Maintenant, entrez le code suivant ou copiez le code mentionné dans l'exemple précédent dans l'espace vide et cliquez sur le bouton Enregistrer les modifications .

Voilà! Vous avez créé avec succès un fichier robots.txt à l'aide du plugin Rank Math.

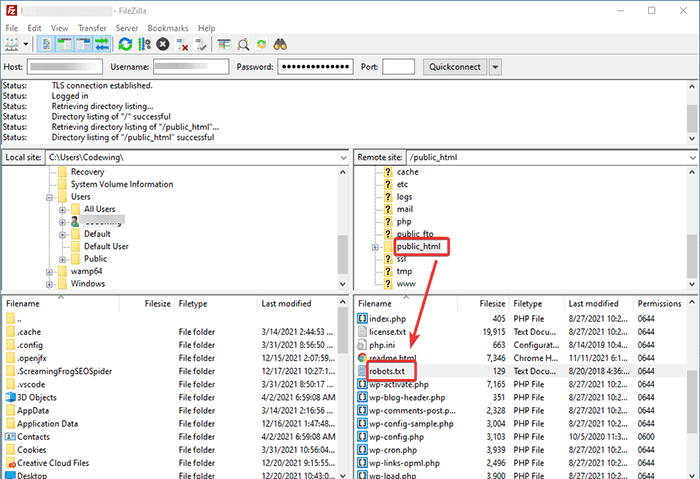

Méthode 2 : Création d'un fichier Robots.txt à l'aide de FTP

La deuxième méthode consiste à créer manuellement un fichier robots.txt sur un ordinateur local, puis à le télécharger dans le dossier racine de votre site WordPress.

Vous devrez accéder à votre hébergement WordPress à l'aide d'un client FTP. Après vous être connecté à votre client FTP, vous pouvez voir le fichier robots.txt dans le dossier racine du site Web. Faites un clic droit et sélectionnez l'option Modifier .

Maintenant, ajoutez votre règle personnalisée au fichier et enregistrez les modifications. Par example:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpSi vous ne voyez pas le fichier dans le dossier racine, vous pouvez le créer sur votre ordinateur local à l'aide du bloc-notes. Ajoutez-y vos règles, puis téléchargez-le dans votre dossier racine à l'aide du FTP.

Où placer votre fichier Robots.txt ?

Vous devez toujours placer votre fichier robots.txt dans le répertoire racine de votre site Web. Par exemple, si votre site est domainname.com , le domaine de votre fichier robots.txt sera https://domainname.com/robots.txt.

En plus d'ajouter le fichier robots.txt dans votre répertoire racine, voici quelques conseils supplémentaires :

- Il est indispensable de nommer le fichier "robots.txt".

- Le nom du fichier est sensible à la casse. Ainsi, vous devez bien faire les choses, sinon cela ne fonctionnera pas.

- Vous devez ajouter une nouvelle ligne pour chaque nouvelle règle.

- Ajoutez un signe "$" pour signifier la fin d'une URL.

- Utilisez chaque agent utilisateur une seule fois.

Comment tester le fichier Robots.txt ?

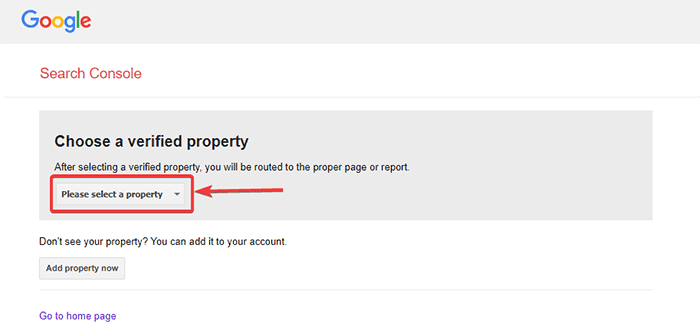

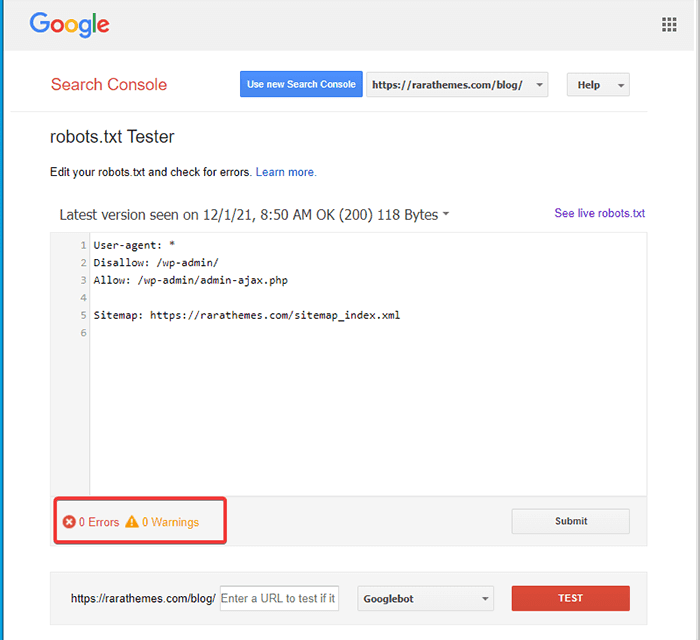

Après avoir créé le fichier robots.txt, vous pouvez le tester à l'aide de Google Search Console. Ici, vous trouverez l'outil de test Open robot.txt.

- Sélectionnez votre propriété dans la liste déroulante donnée.

L'outil récupère le fichier robots.txt de votre site et met en évidence les erreurs et les avertissements s'il en trouve.

Remarque : L'option de propriété déroulante apparaît uniquement si vous avez lié votre site WordPress à Google Search Console.

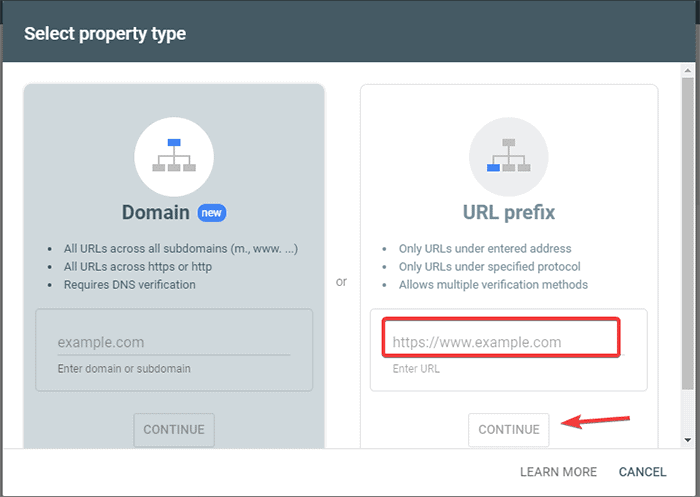

Si vous ne l'avez pas encore fait, vous pouvez rapidement lier votre site comme suit :

- Connectez-vous à Google Search Console et créez un compte. Vous pouvez configurer votre compte en utilisant votre domaine ou votre préfixe d'URL. Il est recommandé d'utiliser le préfixe d'URL car c'est relativement plus facile.

- Saisissez l'URL de votre site Web.

- Maintenant, cliquez sur le bouton "Continuer".

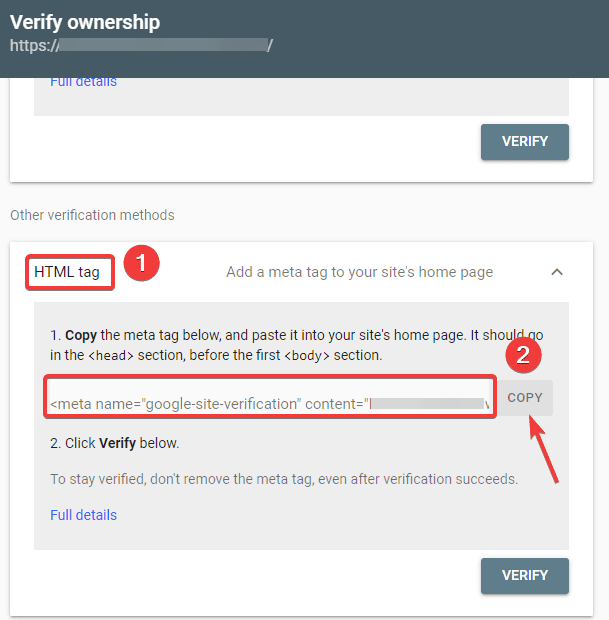

- Vous devez maintenant vérifier la propriété du site. Vous pouvez le faire en utilisant l'une des options proposées. Cependant, nous vous recommandons d'utiliser l'option de balise HTML.

- Copiez le code donné, puis rendez-vous sur votre tableau de bord WordPress.

Vous pouvez maintenant vérifier le code à l'aide du plug-in Insérer des en-têtes et des pieds de page. Vérifier:

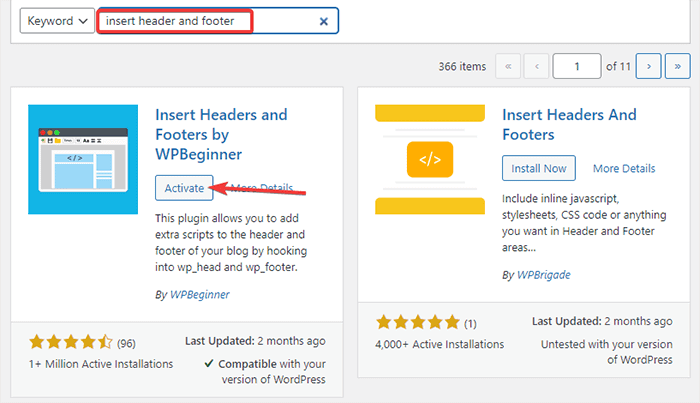

- Accédez à Plugins -> Ajouter un nouveau depuis votre tableau de bord d'administration WordPress.

- Maintenant, recherchez le plug-in Insert Headers and Footers dans la barre de recherche, puis installez et activez le plug-in.

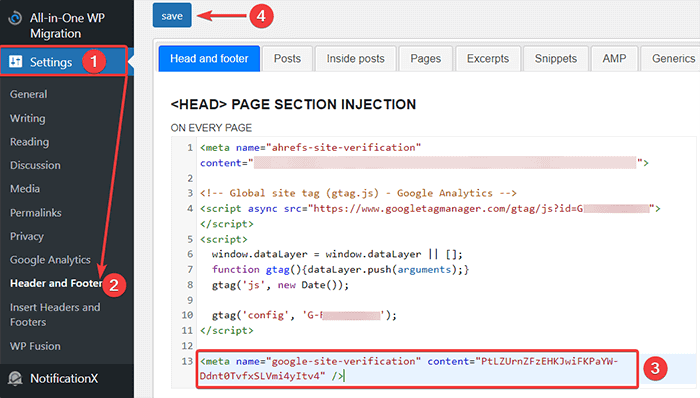

- Après cela, redirigez vers Paramètres -> En-tête et pied de page depuis votre tableau de bord WordPress, puis collez le code copié dans l'onglet En-tête et pied de page. Une fois que vous avez terminé, cliquez sur le bouton Enregistrer.

- Revenez à l'onglet Google Search Console de votre navigateur. Ensuite, cliquez sur le bouton vérifier.

- Google vérifie la propriété et affiche le message terminé une fois que c'est fait.

- Cliquez sur l'option "Aller à la propriété" pour accéder au tableau de bord de la Google Search Console.

Maintenant, revenez à l'outil de test Open robot.txt et testez votre robots.txt comme mentionné ci-dessus.

Avantages du fichier Robots.txt

Voici les avantages de l'utilisation du fichier Robots.txt dans un contexte SEO :

- Cela aide à optimiser les budgets d'exploration du moteur de recherche en sautant l'indexation sur les pages que vous ne voulez pas que les bots explorent. Cela crée une priorité pour le moteur de recherche pour explorer uniquement les pages qui sont importantes pour vous.

- Il aide à optimiser le serveur Web en limitant les robots qui consomment inutilement des ressources.

- Cela aide à cacher les pages de connexion, les pages de destination, les pages de remerciement de l'indexation par les moteurs de recherche. Ainsi, il optimise les performances du site Web.

Inconvénients du fichier robots.txt

- La création d'un fichier robots.txt est assez simple, comme nous l'avons expliqué ci-dessus. Cependant, le fichier robots.txt inclut également les URL de vos pages internes que vous ne souhaitez pas que les crawl bots indexent, telles que la page de connexion. Cela rend votre site Web vulnérable aux failles de sécurité.

- Bien que la création d'un fichier robots.txt soit facile, même une simple erreur peut réduire à néant tous vos efforts. Par exemple, si vous ajoutez ou égarez un seul caractère dans le fichier, cela gâche tous vos efforts de référencement.

Foire aux questions (FAQ)

Qu'est-ce que l'exploration Web ?

Les moteurs de recherche envoient leurs robots d'indexation (également appelés robots ou araignées) sur le Web. Ces bots sont des logiciels intelligents qui naviguent sur l'ensemble du Web pour découvrir de nouvelles pages, liens et sites Web. Ce processus de découverte est connu sous le nom d'exploration Web.

Qu'est-ce que l'indexation ?

Lorsque les robots d'exploration du Web découvrent votre site Web, ils organisent vos pages dans une structure de données utilisable. Ce processus d'organisation s'appelle l'indexation.

Quel est le budget de crawl ?

Un budget d'exploration est une limite au nombre d'URL qu'un robot de recherche peut explorer dans une session donnée. Chaque site a une allocation de budget de crawl spécifique. Vous devez donc vous assurer que vous le dépensez de la manière la plus bénéfique pour votre site.

Par exemple, si vous avez plusieurs pages sur votre site, vous devez allouer le budget de crawl aux pages les plus précieuses. Ainsi, vous pouvez mentionner l'URL de la page dans votre fichier robots.txt.

Conclusion

Lorsqu'ils travaillent sur le référencement d'un site Web, la plupart des utilisateurs se concentrent sur la création de plans de site, le travail sur les backlinks, la recherche de mots-clés et l'optimisation du contenu. Seuls quelques webmasters prêtent attention au fichier robots.txt.

Le fichier robots.txt peut ne pas jouer un grand rôle lorsque vous démarrez un site. Cependant, à mesure que votre site Web se développe, prêter attention au fichier robots.txt donne de meilleurs résultats.

En outre, il existe un mythe selon lequel le blocage des catégories, des pages d'archives et des balises augmente le taux d'exploration et favorise une indexation plus rapide. C'est faux.

Suivez les méthodes que nous avons mentionnées ci-dessus pour créer votre fichier robots.txt.

Nous espérons que cet article vous a aidé à trier votre requête concernant la création et l'optimisation de WordPress robots.txt pour le référencement.

Si vous souhaitez lire des articles plus utiles liés à WordPress, vous pouvez lire les articles suivants :

- Comment créer un sitemap dans WordPress ?

- Comment démarrer un blog WordPress ?