Как оптимизировать WordPress Robots.txt для SEO на примере

Опубликовано: 2021-12-20SEO является главным приоритетом для владельцев веб-сайтов. Поскольку первые пять результатов получают 75% кликов, гонка за более высокий рейтинг была сложной задачей. Существуют различные внестраничные и внутренние методы SEO, которые вступают в игру. Оптимизация файла Robot.txt — один из тех приемов, которые могут усилить SEO вашего сайта.

Однако большинство новичков не знают, как оптимизировать WordPress Robots.txt для SEO. Некоторые могут даже не знать, что такое файл robots.txt.

К счастью, эта статья вам в помощь.

Здесь мы объясним, что такое файл robots.txt, как создать файл robots.txt и как оптимизировать файл robots.txt для SEO. Мы также добавили несколько часто задаваемых вопросов в конце. Так что убедитесь, что вы с нами до конца.

Теперь давайте начнем!

Оглавление

- Что такое файл robots.txt?

- Как выглядит файл robots.txt?

- Зачем вам нужен файл robots.txt в WordPress?

- Как создать robots.txt для вашего сайта?

- Способ 1: создание файла Robots.txt с помощью плагина Rank Math

- Способ 2: создание файла Robots.txt с использованием FTP

- Куда поместить файл robots.txt?

- Как протестировать файл robots.txt?

- Плюсы файла robots.txt

- Минусы файла robots.txt

- Часто задаваемые вопросы (FAQ)

- Что такое веб-сканирование?

- Что такое индексация?

- Каков краулинговый бюджет?

- Вывод

Что такое файл robots.txt?

Robots.txt в WordPress — это обычный текстовый файл, который сообщает ботам поисковых систем, какие страницы вашего сайта следует сканировать и индексировать. Вы также можете отформатировать файл, чтобы исключить страницы из индексации.

robots.txt хранится в корневом каталоге WordPress. Этот файл имеет базовый формат, который выглядит следующим образом:

User-agent: [user-name] Disallow: [URL of the string not to be crawled] Allow: [URL of the string to be crawled] Sitemap: [URL of your WordPress XML Sitemap]Как выглядит файл robots.txt?

Файл robots.txt — это всего лишь несколько строк текста, которые указывают поисковым системам, как и что сканировать на вашем сайте. У вас есть несколько строк в этом файле, чтобы разрешить или ограничить определенные URL-адреса страниц. Вы также можете добавить несколько файлов Sitemap. Если вы запретите URL-адрес, боты поисковых систем не будут сканировать эту страницу.

Вот пример файла robots.txt:

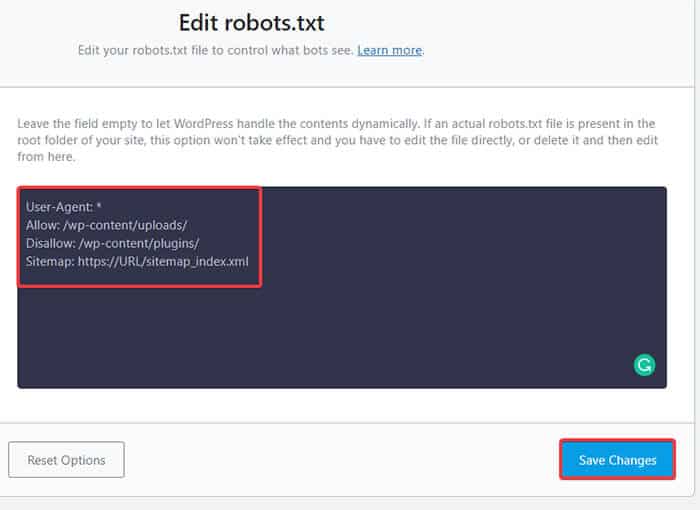

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Sitemap: https://URL/sitemap_index.xmlТеперь давайте узнаем об этих четырех основных терминах, которые вы можете найти в файле robots:

- Пользовательский агент : Пользовательский агент — это конкретный веб-сканер, которому вы даете инструкции по сканированию. Обычно это поисковая система.

- Разрешить : Разрешить — это команда, которая сообщает роботу Googlebot, что он может получить доступ к странице или вложенной папке, даже если ее вложенная папка или родительская страница могут быть запрещены.

- Disallow : команда disallow указывает агенту пользователя не сканировать определенный URL-адрес. Вы можете включить только одну строку «Disallow:» для каждого URL-адреса.

- Карта сайта : Карта сайта используется для определения местоположения любой карты сайта в формате XML, связанной с этим URL-адресом. Эта команда поддерживается только Google, Bing, Ask и Yahoo.

В приведенном выше примере мы разрешили поисковым ботам сканировать и индексировать папку загрузок, но ограничили папку плагинов. В конце концов, мы разрешили индексацию XML-карты сайта.

Знак звездочки после User-Agent означает, что текст применим ко всем ботам поисковых систем. У каждой поисковой системы есть свой пользовательский агент для индексации сайтов. Вот некоторые пользовательские агенты некоторых популярных поисковых систем:

- Гугл: Гуглбот

- Изображения Googlebot: Изображение Googlebot

- Новости Googlebot: Новости Googlebot

- Видео Googlebot: Googlebot-видео

- Yahoo: Slurp Bot

- Бинг: Бингбот

- Alexa от Amazon: ia_archiver

- DuckDuckGo: DuckDuckBot

- Яндекс: ЯндексБот

- Байду: Байдуспайдер

- Эксалид: ЭксаБот

В настоящее время существует так много пользовательских агентов. Если вы хотите сосредоточиться на конкретной поисковой системе, вы даже можете указать ее в файле robots.txt. То есть, чтобы настроить инструкции для робота Googlebot, вы можете написать первую строку вашего файла robots.txt следующим образом:

Агент пользователя: Googlebot

Зачем вам нужен файл robots.txt в WordPress?

Поисковые роботы будут сканировать и индексировать ваш сайт, даже если у вас нет файла robots.txt. Итак, зачем вам это действительно нужно? Что ж, с помощью файла robots.txt вы можете указать поисковым системам расставлять приоритеты при индексации определенных страниц. Кроме того, вы можете исключить страницы или папки, которые не хотите индексировать.

Это не оказывает большего влияния, когда вы впервые начать вести блог и не иметь большого количества контента. Однако после того, как ваш сайт разрастется и на нем будет много контента, вам может потребоваться установить приоритет индексации определенной страницы/записи/папки и отменить некоторые из них.

Видите ли, есть квота на каждого поискового бота для каждого сайта. Это означает, что боты сканируют определенное количество страниц за определенный сеанс сканирования. Если боты не завершают сканирование в этом конкретном сеансе, бот возвращается и возобновляет сканирование в следующем сеансе. Это замедляет индексацию вашего сайта.

Таким образом, используя файл robots.txt, вы можете указать поисковым ботам, какие страницы, файлы и папки вы хотите проиндексировать, а какие включить. Тем самым вы сохраняете квоту сканирования. Возможно, это не самый безопасный способ скрыть ваш контент от общественности, но он предотвращает появление исключенного контента в поисковой выдаче.

Как создать robots.txt для вашего сайта?

Вы можете создать файл robots.txt двумя разными способами. Мы объясним эти методы ниже. Затем вы можете следовать методу, который, по вашему мнению, будет работать лучше всего для вас.

Способ 1: создание файла Robots.txt с помощью плагина Rank Math

Здесь мы покажем вам, как создать файл robots.txt с помощью популярного плагина Rank Math.

Rank Math — это SEO-плагин для WordPress, который упрощает оптимизацию контента вашего веб-сайта с помощью встроенных предложений, основанных на общепринятых передовых методах. С помощью этого удобного инструмента вы можете легко настроить важные параметры SEO и контролировать индексируемые страницы.

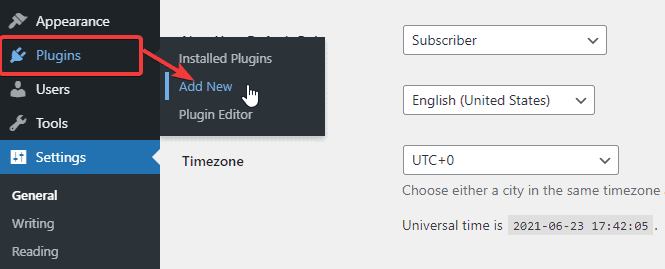

Чтобы создать файл robots.txt с помощью плагина Rank Math, сначала загрузите плагин, выбрав « Плагины» -> «Добавить новый » на панели администратора WordPress.

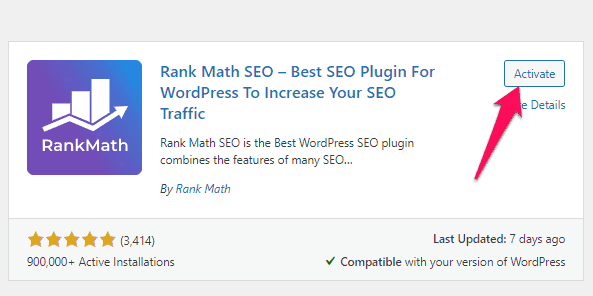

Теперь найдите Rank Math в строке поиска и нажмите кнопку « Установить сейчас и активировать », когда найдете плагин.

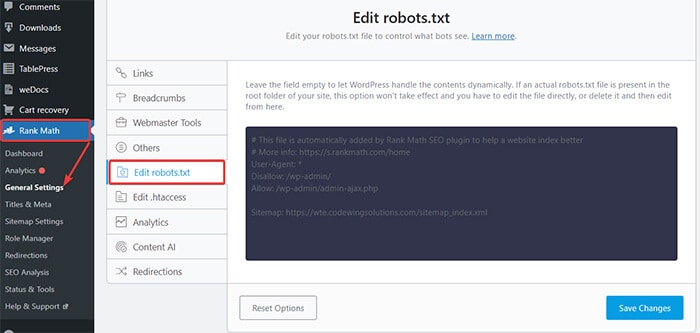

После активации плагина перейдите в Rank Math -> General Settings -> Edit robots.txt на панели управления WordPress.

Теперь введите следующий код или скопируйте код из предыдущего примера в пустое место и нажмите кнопку Сохранить изменения .

Ну вот! Вы успешно создали файл robots.txt с помощью подключаемого модуля Rank Math.

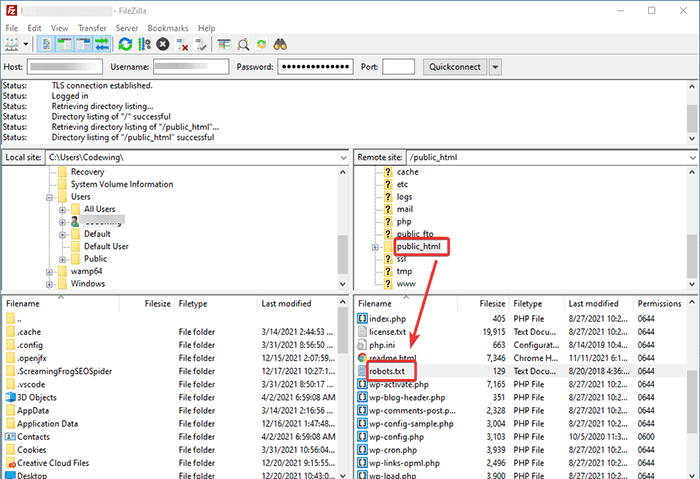

Способ 2: создание файла Robots.txt с использованием FTP

Второй метод предполагает создание файла robots.txt вручную на локальном компьютере, а затем загрузку его в корневую папку вашего сайта WordPress.

Вам нужно будет получить доступ к вашему хостингу WordPress с помощью FTP-клиента. После входа в FTP-клиент вы увидите файл robots.txt в корневой папке веб-сайта. Щелкните правой кнопкой мыши и выберите параметр « Изменить ».

Теперь добавьте свое пользовательское правило в файл и сохраните изменения. Например:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpЕсли вы не видите файл в корневой папке, вы можете создать его на локальном компьютере с помощью блокнота. Добавьте к нему свои правила, а затем загрузите его в корневую папку с помощью FTP.

Куда поместить файл robots.txt?

Вы всегда должны размещать файл robots.txt в корневом каталоге вашего сайта. Например, если ваш сайт — domainname.com , то домен вашего файла robots.txt будет https://domainname.com/robots.txt.

Помимо добавления файла robots.txt в корневой каталог, вот несколько дополнительных советов:

- Необходимо назвать файл «robots.txt».

- Имя файла чувствительно к регистру. Таким образом, вам нужно сделать это правильно, иначе это не сработает.

- Вам нужно добавить новую строку для каждого нового правила.

- Добавьте знак «$», чтобы обозначить конец URL-адреса.

- Используйте каждый пользовательский агент только один раз.

Как протестировать файл robots.txt?

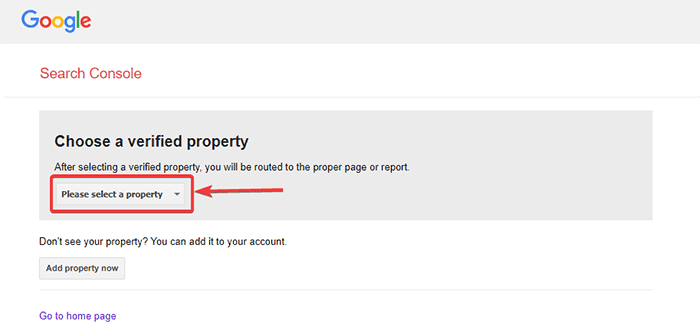

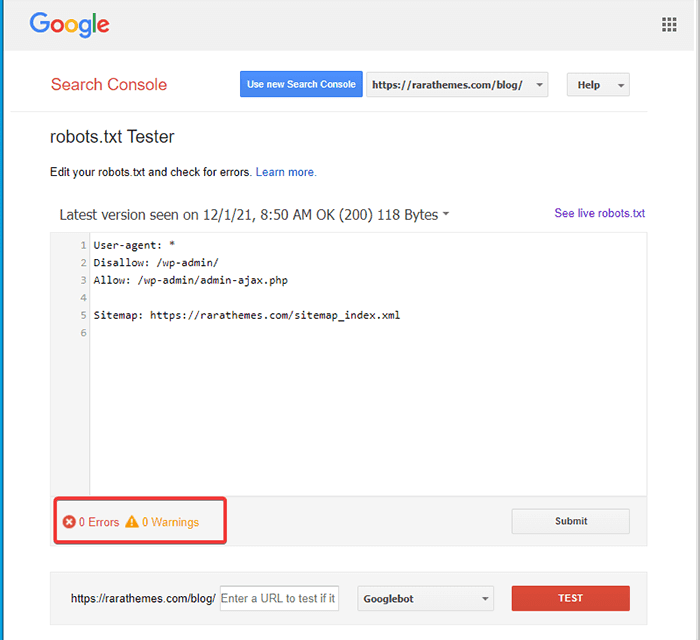

После создания файла robots.txt вы можете протестировать его с помощью Google Search Console. Здесь вы найдете инструмент для тестирования Open robot.txt.

- Выберите свою недвижимость из предложенного выпадающего списка.

Инструмент извлекает файл robots.txt вашего сайта и выделяет ошибки и предупреждения, если они обнаружены.

Примечание . Опция раскрывающегося свойства появляется только в том случае, если вы связали свой сайт WordPress с Google Search Console.

Если вы этого не сделали, вы можете быстро связать свой сайт следующим образом:

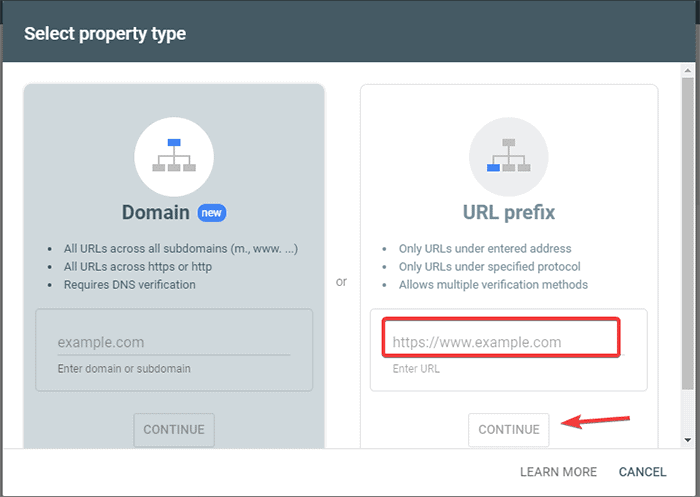

- Войдите в Google Search Console и создайте учетную запись. Вы можете настроить свою учетную запись, используя префикс домена или URL. Рекомендуется использовать префикс URL, так как это сравнительно проще.

- Введите URL вашего веб-сайта.

- Теперь нажмите на кнопку «Продолжить».

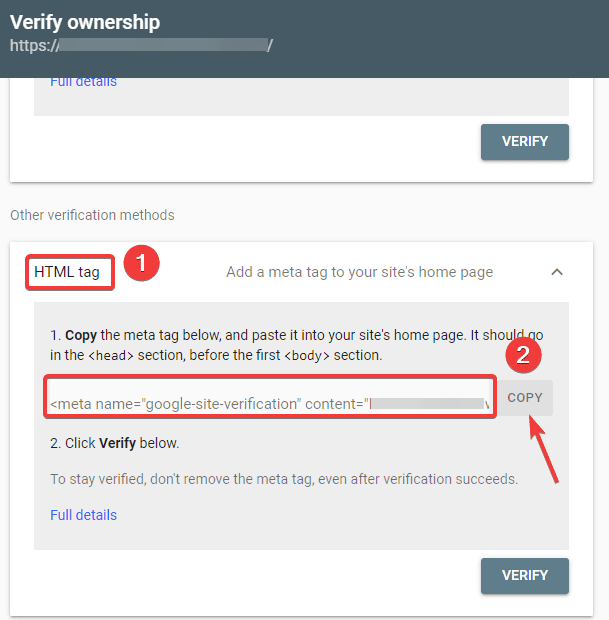

- Теперь вы должны подтвердить право собственности на сайт. Вы можете сделать это, используя любой из предложенных вариантов. Тем не менее, мы рекомендуем использовать опцию тега HTML.

- Скопируйте данный код и перейдите на панель инструментов WordPress.

Теперь вы можете проверить код с помощью плагина Insert Headers and Footers. Проверять:

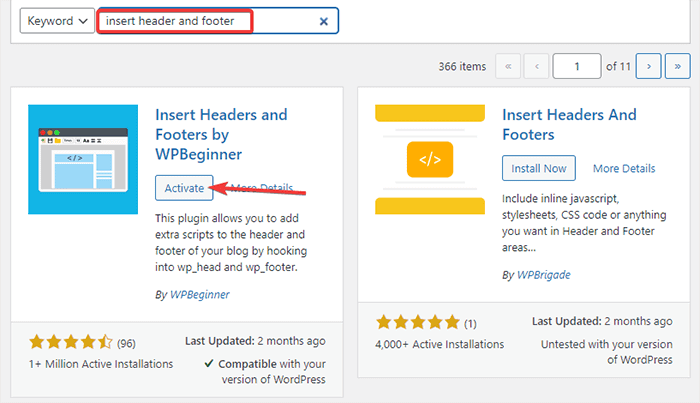

- Перейдите в « Плагины» -> «Добавить новый» из панели администратора WordPress.

- Теперь найдите плагин Insert Headers and Footers в строке поиска, а затем установите и активируйте плагин.

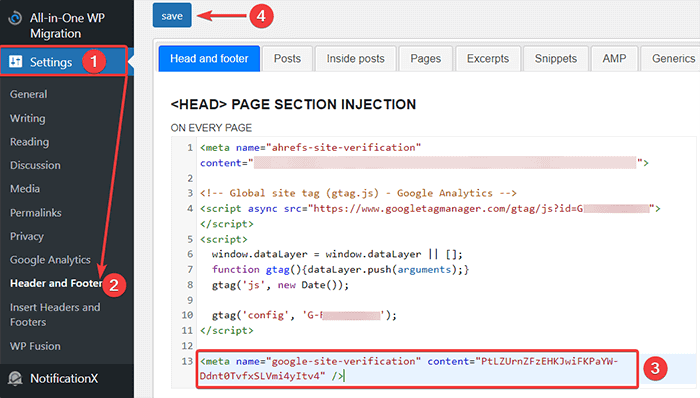

- После этого перенаправьте в « Настройки» -> «Верхний и нижний колонтитулы » с панели инструментов WordPress, а затем вставьте скопированный код на вкладку «Верхний и нижний колонтитулы». Когда вы закончите, нажмите кнопку Сохранить.

- Вернитесь на вкладку Google Search Console в браузере. Затем нажмите кнопку подтверждения.

- Google проверяет право собственности и отображает готовое сообщение, как только это будет сделано.

- Нажмите «Перейти к ресурсу», чтобы получить доступ к панели инструментов Google Search Console.

Теперь вернитесь к инструменту тестирования Open robot.txt и проверьте файл robots.txt, как указано выше.

Плюсы файла robots.txt

Вот преимущества использования файла Robots.txt в контексте SEO:

- Это помогает оптимизировать краулинговые бюджеты поисковой системы, пропуская индексирование страниц, которые вы не хотите сканировать ботами. Это создает для поисковой системы приоритет для сканирования только тех страниц, которые важны для вас.

- Это помогает оптимизировать веб-сервер, ограничивая ботов, которые без необходимости потребляют ресурсы.

- Это помогает скрыть страницы входа, целевые страницы, страницы благодарности от индексации поисковыми системами. Таким образом, он оптимизирует работу веб-сайта.

Минусы файла robots.txt

- Как мы объяснили выше, создать файл robots.txt довольно просто. Однако файл robots.txt также содержит URL-адреса ваших внутренних страниц, которые вы не хотите индексировать сканирующими роботами, например страницу входа. Это делает ваш сайт уязвимым для нарушений безопасности.

- Хотя создать файл robots.txt несложно, даже простая ошибка может свести на нет все ваши усилия. Например, если вы добавите или поместите не туда один символ в файле, это сведет на нет все ваши усилия по SEO.

Часто задаваемые вопросы (FAQ)

Что такое веб-сканирование?

Поисковые системы отправляют свои поисковые роботы (также известные как боты или пауки) через Интернет. Эти боты представляют собой интеллектуальное программное обеспечение, которое перемещается по всей сети в поисках новых страниц, ссылок и веб-сайтов. Этот процесс обнаружения известен как веб-сканирование.

Что такое индексация?

Когда поисковые роботы обнаруживают ваш веб-сайт, они упорядочивают ваши страницы в удобную структуру данных. Этот организационный процесс называется индексацией.

Каков краулинговый бюджет?

Бюджет сканирования — это ограничение на количество URL-адресов, которое поисковый бот может сканировать за данный сеанс. Каждый сайт имеет определенное распределение краулингового бюджета. Поэтому вам нужно убедиться, что вы тратите их наиболее полезным для вашего сайта способом.

Например, если на вашем сайте несколько страниц, вам необходимо распределить краулинговый бюджет на наиболее ценные страницы. Таким образом, вы можете указать URL страницы в файле robots.txt.

Вывод

При работе над SEO веб-сайта большинство пользователей сосредотачиваются на создании карт сайта, работе с обратными ссылками, исследовании ключевых слов и оптимизации контента. Лишь немногие веб-мастера обращают внимание на файл robots.txt.

Файл robots.txt может не играть большой роли при запуске сайта. Однако по мере роста вашего веб-сайта внимание к файлу robots.txt дает лучшие результаты.

Также существует миф о том, что блокировка категорий, архивных страниц и тегов увеличивает скорость сканирования и способствует более быстрой индексации. Это ложь.

Следуйте методам, упомянутым выше, чтобы создать файл robots.txt.

Мы надеемся, что эта статья помогла вам разобраться в вопросе о том, как создать и оптимизировать WordPress robots.txt для SEO.

Если вы хотите прочитать больше полезных статей, связанных с WordPress, вы можете прочитать следующие статьи:

- Как создать карту сайта в WordPress?

- Как начать блог WordPress?