Cum să optimizați WordPress Robots.txt pentru SEO cu un exemplu

Publicat: 2021-12-20SEO a fost o prioritate de top pentru proprietarii de site-uri web. Având în vedere că primele cinci rezultate obțin 75% din clicuri, cursa pentru o poziție superioară a fost o provocare. Există diverse tehnici SEO off-page și on-page care intră în joc. Optimizarea fișierului Robot.txt este unul dintre acele trucuri care pot consolida SEO pentru site-ul dvs.

Cu toate acestea, majoritatea începătorilor nu știu cum să optimizeze WordPress Robots.txt pentru SEO. Unii s-ar putea să nu știe în primul rând ce este un fișier robots.txt.

Din fericire, acest articol este în salvarea ta.

Aici, vom explica ce este un fișier robots.txt, cum să creați fișierul robots.txt și cum să optimizați fișierul robots.txt pentru SEO. Am adăugat și câteva întrebări frecvente la sfârșit. Așa că asigură-te că ești alături de noi până la sfârșit.

Acum, să începem!

Cuprins

- Ce este un fișier Robots.txt?

- Cum arată un fișier Robots.txt?

- De ce aveți nevoie de un fișier Robots.txt în WordPress?

- Cum să creezi un Robots.txt pentru site-ul tău?

- Metoda 1: Crearea fișierului Robots.txt folosind Pluginul Rank Math

- Metoda 2: Crearea fișierului Robots.txt folosind FTP

- Unde să-ți pui fișierul Robots.txt?

- Cum se testează fișierul Robots.txt?

- Avantajele fișierului Robots.txt

- Dezavantajele fișierului robots.txt

- Întrebări frecvente (FAQs)

- Ce este crawling-ul web?

- Ce este indexarea?

- Care este bugetul de crawl?

- Concluzie

Ce este un fișier Robots.txt?

Robots.txt în WordPress este un fișier text simplu care informează roboții motoarelor de căutare ce pagini de pe site-ul dvs. să acceseze cu crawlere și să indexeze. De asemenea, puteți formata fișierul pentru a exclude paginile de la indexare.

Robots.txt este stocat în directorul rădăcină WordPress. Acest fișier are un format de bază care arată astfel:

User-agent: [user-name] Disallow: [URL of the string not to be crawled] Allow: [URL of the string to be crawled] Sitemap: [URL of your WordPress XML Sitemap]Cum arată un fișier Robots.txt?

Un fișier robots.txt este doar câteva rânduri de text care direcționează motoarele de căutare despre cum și ce să acceseze cu crawlere pe site-ul dvs. Aveți mai multe rânduri în acest fișier pentru a permite sau restricționa anumite adrese URL ale paginilor. De asemenea, puteți adăuga mai multe sitemap-uri. Dacă nu permiteți o adresă URL, roboții motorului de căutare nu accesează pagina respectivă.

Iată un exemplu de fișier robots.txt:

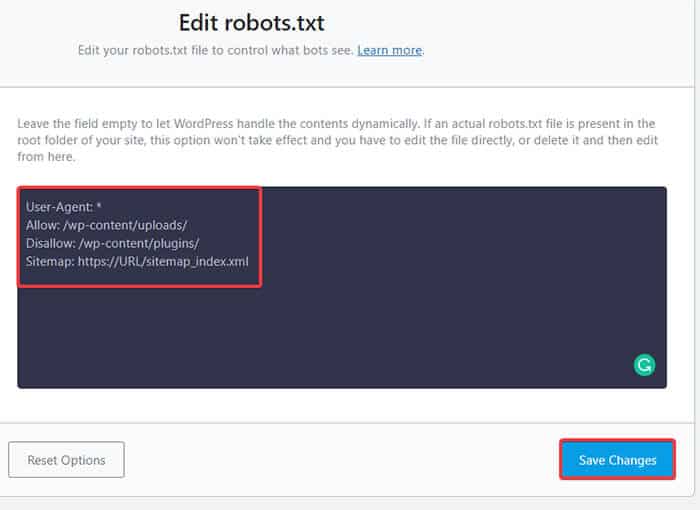

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Sitemap: https://URL/sitemap_index.xmlAcum, să învățăm despre acești patru termeni majori pe care îi puteți găsi într-un fișier roboți:

- User-agent : User-agent este crawler-ul web specific căruia îi oferiți instrucțiuni de accesare cu crawlere. De obicei este un motor de căutare.

- Permite : Permite este comanda care îi spune lui Googlebot că poate accesa o pagină sau un subdosar, chiar dacă subdosarul sau o pagină părinte ar putea fi interzisă.

- Disallow : comanda disallow îi spune unui user-agent să nu acceseze cu crawlere o anumită adresă URL. Puteți include doar o singură linie „Disallow:” pentru fiecare adresă URL.

- Harta site -ului : harta site-ului este utilizată pentru a indica locația oricăror hărți de site XML care au legătură cu această adresă URL. Această comandă este acceptată numai de Google, Bing, Ask și Yahoo.

În exemplul de mai sus, am permis roboților de căutare să acceseze cu crawlere și să indexeze folderul de încărcări, dar am restricționat folderul de pluginuri. În final, am permis indexarea sitemap-ului XML.

Semnul asterisc după User-Agent înseamnă că textul se aplică tuturor roboților motoarelor de căutare. Fiecare motor de căutare are agentul său utilizator pentru a indexa site-urile. Iată câțiva agenți de utilizator ai unor motoare de căutare populare:

- Google: Googlebot

- Imagini Googlebot: Googlebot-Imagine

- Știri Googlebot: Știri Googlebot

- Googlebot Video: Googlebot-Video

- Yahoo: Slurp Bot

- Bing: Bingbot

- Alexa de la Amazon: ia_archiver

- DuckDuckGo: DuckDuckBot

- Yandex: YandexBot

- Baidu: Baiduspider

- Exalead: ExaBot

Există atât de mulți user-agent în zilele noastre. Dacă doriți să vă concentrați asupra unui anumit motor de căutare, îl puteți specifica chiar și în fișierul robots.txt. Adică, pentru a configura instrucțiuni pentru Googlebot, puteți scrie prima linie a fișierului robots.txt ca:

Agent utilizator: Googlebot

De ce aveți nevoie de un fișier Robots.txt în WordPress?

Boții de căutare vor accesa cu crawlere și indexează site-ul dvs. chiar dacă nu aveți un fișier robots.txt. Deci, de ce ai avea cu adevărat nevoie de el? Ei bine, cu fișierul robots.txt, puteți direcționa motoarele de căutare să prioritizeze indexarea pe anumite pagini. De asemenea, puteți exclude pagini sau foldere pe care nu doriți să le indexați.

Acest lucru nu are un impact mai mare atunci când ești prima dată începe un blog și nu ai mult conținut. Cu toate acestea, după ce site-ul tău crește și are mult conținut, poate fi necesar să prioritizezi indexarea pe o anumită pagină/postări/dosar și să anulezi unele.

Vedeți, există o cotă pentru fiecare bot de căutare pentru fiecare site web. Aceasta înseamnă că boții se accesează cu crawlere pe un anumit număr de pagini la o anumită sesiune de accesare cu crawlere. Dacă roboții nu termină accesarea cu crawlere în acea sesiune, botul revine și reia accesarea cu crawlere în sesiunea următoare. Acest lucru încetinește rata de indexare a site-ului dvs.

Deci, utilizând fișierul robots.txt, puteți direcționa roboții de căutare în ce pagini, fișiere și foldere doriți să le indexați și pe care să le includeți. Procedând astfel, salvați cota de accesare cu crawlere. Poate că nu este cel mai sigur mod de a vă ascunde conținutul de public, dar împiedică apariția acestor conținuturi excluse în SERP-uri.

Cum să creezi un Robots.txt pentru site-ul tău?

Puteți crea robots.txt în două moduri diferite. Vom explica aceste metode mai jos. Apoi puteți urma metoda care credeți că va funcționa cel mai bine pentru dvs.

Metoda 1: Crearea fișierului Robots.txt folosind Pluginul Rank Math

Aici, vă vom arăta cum să creați un fișier robots.txt folosind popularul plugin Rank Math.

Rank Math este un plugin SEO WordPress care facilitează optimizarea conținutului site-ului dvs. cu sugestii încorporate bazate pe cele mai bune practici acceptate pe scară largă. Folosind acest instrument la îndemână, puteți personaliza cu ușurință setările SEO importante și puteți controla ce pagini sunt indexabile.

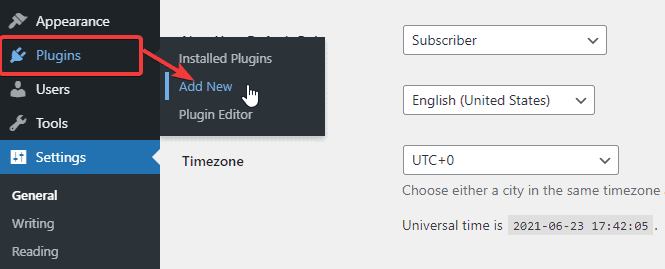

Pentru a crea un fișier robots.txt utilizând pluginul Rank Math, mai întâi, descărcați pluginul accesând Plugins -> Adăugați nou din tabloul de bord WordPress Admin.

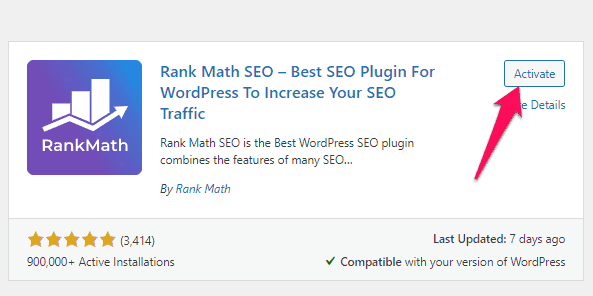

Acum, căutați Rank Math în bara de căutare și faceți clic pe butonul Instalați acum și activați după ce găsiți pluginul.

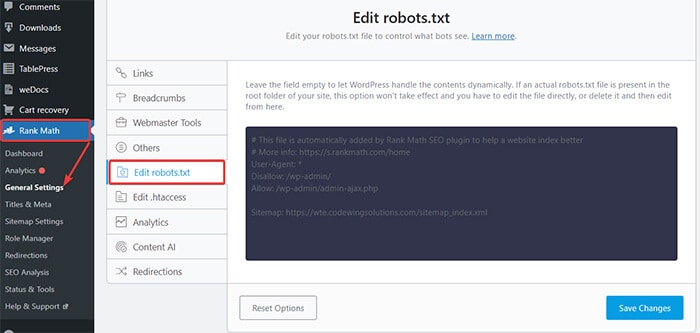

După ce activați pluginul, mergeți la Rank Math -> Setări generale -> Editați robots.txt din Tabloul de bord WordPress.

Acum, introduceți următorul cod sau copiați codul menționat în exemplul anterior în spațiul liber și faceți clic pe butonul Salvare modificări .

Iată! Ați creat cu succes un fișier robots.txt utilizând pluginul Rank Math.

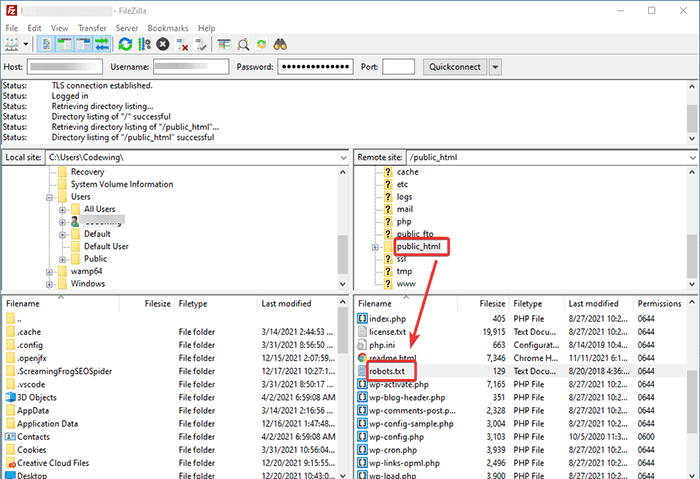

Metoda 2: Crearea fișierului Robots.txt folosind FTP

A doua metodă implică crearea manuală a unui fișier robots.txt pe un computer local și apoi încărcarea acestuia în folderul rădăcină al site-ului dvs. WordPress.

Va trebui să accesați găzduirea WordPress folosind un client FTP. După ce vă conectați la clientul dvs. FTP, puteți vedea fișierul robots.txt în folderul rădăcină al site-ului web. Faceți clic dreapta și selectați opțiunea Editare .

Acum, adăugați regula personalizată în fișier și salvați modificările. De exemplu:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.phpDacă nu vedeți fișierul în folderul rădăcină, îl puteți crea pe computerul local folosind notepad-ul. Adăugați regulile dvs. și apoi încărcați-l în folderul rooter folosind FTP.

Unde să-ți pui fișierul Robots.txt?

Ar trebui să plasați întotdeauna fișierul robots.txt în directorul rădăcină al site-ului dvs. web. De exemplu, dacă site-ul dvs. este numedomeniu.com , atunci domeniul fișierului robots.txt va fi https://numedomeniu.com/robots.txt.

Pe lângă adăugarea fișierului robots.txt în directorul rădăcină, iată câteva sfaturi suplimentare:

- Este obligatoriu să denumești fișierul „robots.txt”.

- Numele fișierului face distincție între majuscule și minuscule. Prin urmare, trebuie să o faci corect, altfel nu va funcționa.

- Trebuie să adăugați o linie nouă pentru fiecare regulă nouă.

- Adăugați un semn „$” pentru a semnifica sfârșitul unei adrese URL.

- Utilizați fiecare user-agent o singură dată.

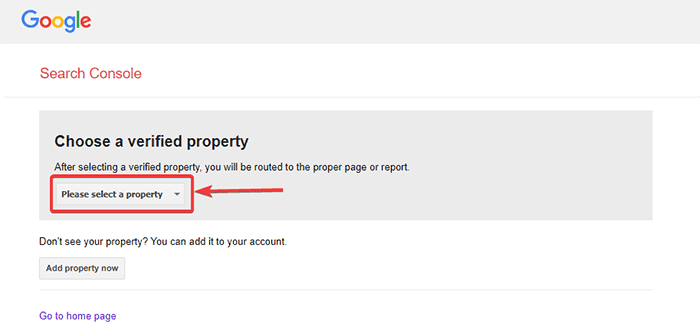

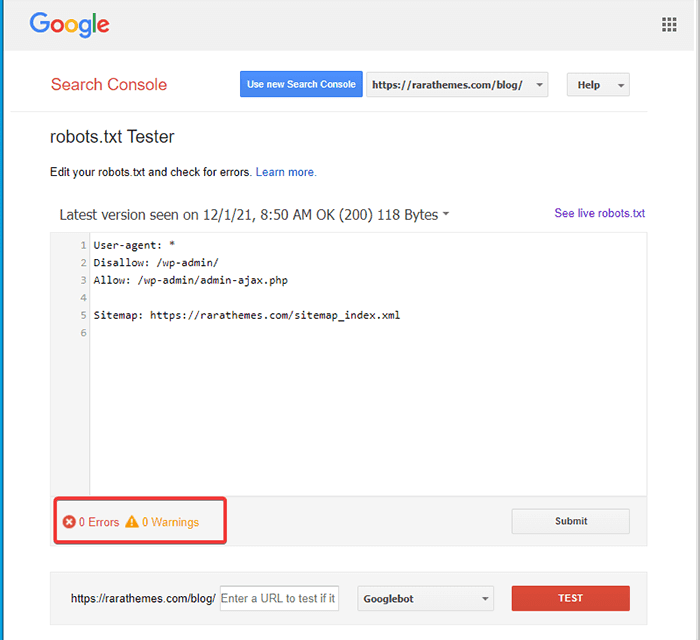

Cum se testează fișierul Robots.txt?

După ce ați creat fișierul robots.txt, îl puteți testa folosind Google Search Console. Aici veți găsi instrumentul de testare Open robot.txt.

- Selectați proprietatea dvs. din lista derulantă dată.

Instrumentul preia fișierul robots.txt al site-ului dvs. și evidențiază erorile și avertizarea dacă găsește vreuna.

Notă : opțiunea derulantă de proprietate apare numai dacă v-ați conectat site-ul WordPress la Google Search Console.

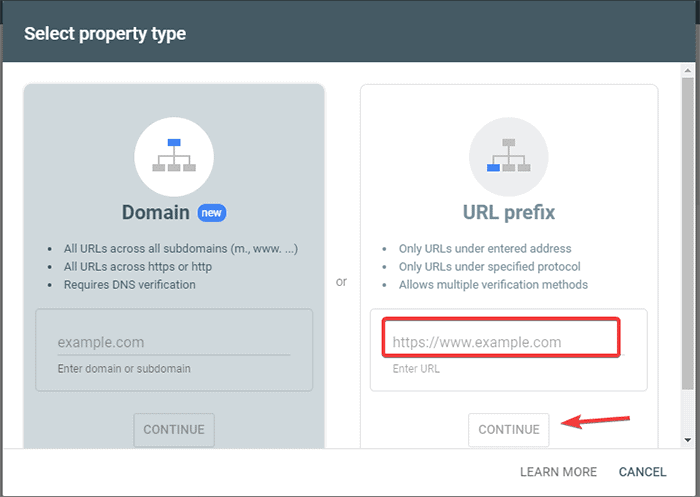

Dacă nu ați făcut-o, vă puteți conecta rapid site-ul după cum urmează:

- Conectați-vă la Google Search Console și creați un cont. Vă puteți configura contul folosind fie domeniul sau prefixul URL. Se recomandă să mergeți cu prefixul URL, deoarece este relativ mai ușor.

- Introduceți adresa URL a site-ului dvs. web.

- Acum, faceți clic pe butonul „Continuare”.

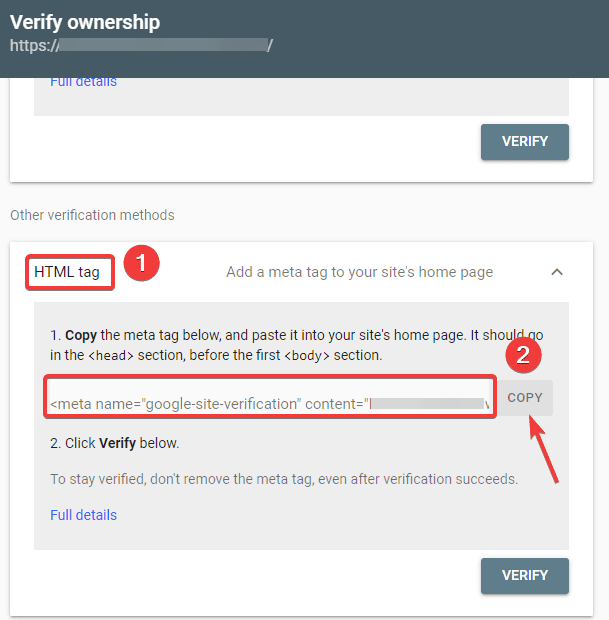

- Acum ar trebui să verificați calitatea de proprietar al site-ului. Puteți face acest lucru folosind oricare dintre opțiunile date. Cu toate acestea, vă recomandăm să utilizați opțiunea de etichetă HTML.

- Copiați codul dat și apoi mergeți la tabloul de bord WordPress.

Acum puteți verifica codul utilizând pluginul Insert Headers and Footers. A verifica:

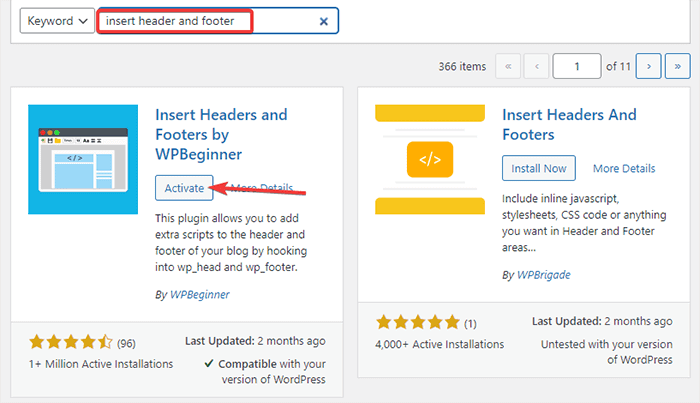

- Accesați Pluginuri -> Adăugați nou din tabloul de bord WordPress.

- Acum, căutați pluginul Inserare anteturi și subsoluri în bara de căutare, apoi Instalați și activați pluginul.

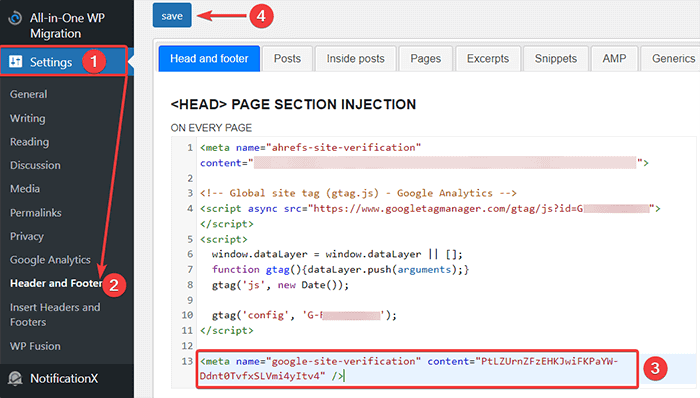

- După aceea, redirecționați la Setări -> Antet și subsol din tabloul de bord WordPress și apoi inserați codul copiat în fila Cap și subsol. După ce ați terminat, faceți clic pe butonul Salvare.

- Reveniți la fila Google Search Console din browser. Apoi, faceți clic pe butonul de verificare.

- Google verifică dreptul de proprietate și afișează mesajul completat odată ce este finalizat.

- Faceți clic pe opțiunea „Accesați proprietatea” pentru a accesa tabloul de bord Google Search Console.

Acum, reveniți la instrumentul de testare Deschideți robot.txt și testați-vă robots.txt așa cum s-a menționat mai sus.

Avantajele fișierului Robots.txt

Iată beneficiile utilizării fișierului Robots.txt în context SEO:

- Ajută la optimizarea bugetelor de accesare cu crawlere ale motorului de căutare, omitând indexarea paginilor pe care nu doriți să le acceseze cu crawlere. Acest lucru creează o prioritate pentru motorul de căutare de a accesa cu crawlere numai paginile care sunt importante pentru dvs.

- Ajută la optimizarea serverului web prin restricționarea roboților care consumă resurse inutil.

- Ajută să ascundeți paginile de conectare, paginile de destinație, paginile de mulțumire de la indexarea de către motoarele de căutare. Astfel, optimizează performanța site-ului.

Dezavantajele fișierului robots.txt

- Crearea unui fișier robots.txt este destul de ușoară, așa cum am explicat mai sus. Cu toate acestea, fișierul robots.txt include și adresele URL ale paginilor interne pe care nu doriți să le indexeze roboții de accesare cu crawlere, cum ar fi pagina de conectare. Acest lucru face site-ul dvs. vulnerabil la încălcări de securitate.

- În timp ce crearea unui fișier robots.txt este ușoară, a face chiar și o greșeală simplă vă poate trage tot efortul la gunoi. De exemplu, dacă adăugați sau plasați în mod greșit un singur caracter în fișier, acesta vă va încurca toate eforturile SEO.

Întrebări frecvente (FAQs)

Ce este crawling-ul web?

Motoarele de căutare își trimit crawlerele web (cunoscute și sub numele de roboți sau păianjeni) pe web. Acești roboți sunt software inteligent care navighează pe întregul web pentru a descoperi noi pagini, link-uri și site-uri web. Acest proces de descoperire este cunoscut sub numele de crawling pe web.

Ce este indexarea?

Când crawlerele web vă descoperă site-ul web, vă aranjează paginile într-o structură de date utilizabilă. Acest proces de organizare se numește indexare.

Care este bugetul de crawl?

Un buget de accesare cu crawlere reprezintă o limită a numărului de adrese URL pe care un robot de căutare poate accesa cu crawlere într-o anumită sesiune. Fiecare site are o alocare specifică de buget pentru accesare cu crawlere. Deci, trebuie să vă asigurați că o cheltuiți într-un mod care este cel mai benefic pentru site-ul dvs.

De exemplu, dacă aveți mai multe pagini pe site-ul dvs., trebuie să alocați bugetul de accesare cu crawlere celor mai valoroase pagini. Astfel, puteți menționa adresa URL a paginii în fișierul robots.txt.

Concluzie

Când lucrează la SEO a unui site web, majoritatea utilizatorilor se concentrează pe crearea de hărți de site, lucrul pe backlink, cercetarea cuvintelor cheie și optimizarea conținutului. Doar câțiva webmasteri acordă atenție fișierului robots.txt.

Este posibil ca fișierul robots.txt să nu joace un rol important atunci când porniți un site. Cu toate acestea, pe măsură ce site-ul dvs. web crește, acordând atenție fișierului robots.txt, obțineți rezultate mai bune.

De asemenea, există un mit conform căruia blocarea categoriilor, a paginilor de arhivă și a etichetelor crește rata de accesare cu crawlere și promovează o indexare mai rapidă. Este fals.

Urmați metodele menționate mai sus pentru a vă crea fișierul robots.txt.

Sperăm că acest articol v-a ajutat să vă sortați interogarea cu privire la cum să creați și să optimizați WordPress robots.txt pentru SEO.

Dacă doriți să citiți mai multe articole utile legate de WordPress, puteți citi următoarele articole:

- Cum se creează un Sitemap în WordPress?

- Cum să pornești un blog WordPress?