為 SEO 優化 WordPress Robots.txt 的完整指南

已發表: 2021-03-11為了讓您的網站快速被索引、針對 SEO 進行優化並提高 SERP 搜索結果頁面上的排名,首先,您需要為 WordPress 構建一個技術 robots.txt 文件。 Robots.txt 文件說明瞭如何掃描和配置您的索引站點,尤其是使其成為非常強大的 SEO 工具。 因此,我們將在本文中推薦完整的指南來增強 WordPress robots.txt 的 SEO。

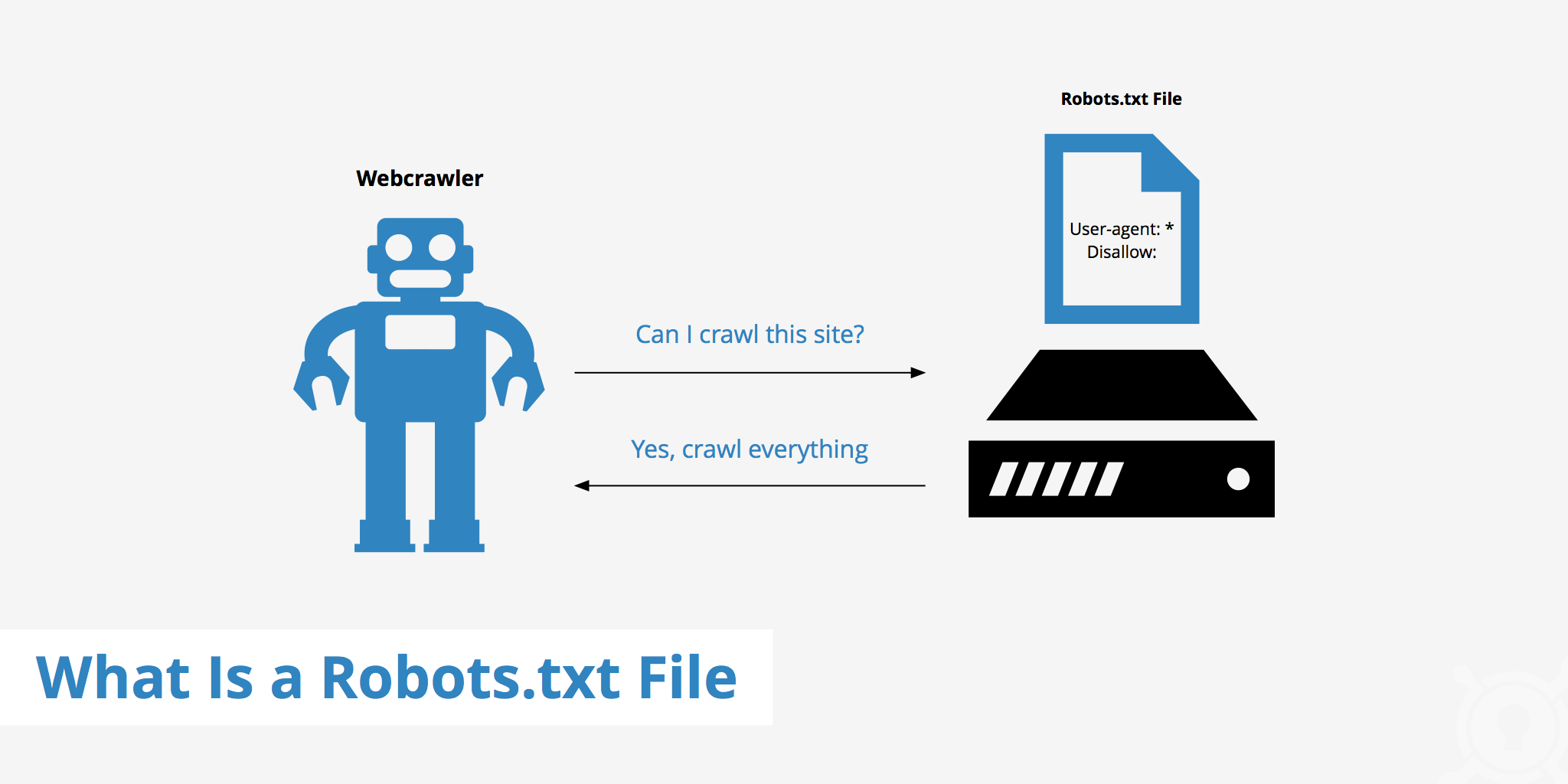

什麼是 WordPress Robots.txt?

這是網站根文件夾中的文本文件,提供有關搜索引擎可以為其編制索引的頁面的說明。

如果您之前了解過搜索引擎的工作流程,您就會知道,在抓取和索引階段,網絡瀏覽器會嘗試在網絡上查找公開可用的頁面,並可以將這些頁麵包含在索引中。

Web 瀏覽器在訪問網站時的第一件事就是查找並檢查 robots.txt 文件的內容。 根據文件中指定的規則,它們會生成可被抓取的 URL 列表,然後專門為該站點編制索引。

為什麼要構建WordPress robots.txt文件?

在許多情況下,搜索引擎機器人“掃描”您的網站會被阻止或限制:

內容無效且重複

事實上,在您的網站上,它會顯示很多其他信息,例如係統設置文件、WordPress 插件等。

該信息對用戶沒有價值。 此外,網站內容被複製的情況也有幾種。 如果內容仍然被索引,就會稀釋網站,降低網站的實際內容質量。

用於設置和測試網站的子頁面

在這種情況下,可能在使用 WordPress 創建新網站時,您還沒有完成網站的設計和設置過程,一般還沒有為用戶做好準備,您需要採取措施防止搜索引擎機器人“掃描”並驗證其網站。

不僅如此,有些網站還有很多子頁面,僅用於測試網站的功能和設計,讓用戶訪問這些網站會影響網站的質量和貴公司的專業性。

大容量網站加載時間長

每個搜索引擎機器人每次訪問網站時只有有限的“掃描”能力。 當您的網站有大量內容時,機器人將需要更多時間進行分析,因為如果它的運行足以進行一次訪問,則網站上的剩餘內容必須等到機器人下一次旋轉。 可以再次抓取和索引。

如果您的網站仍然有不必要的文件和內容,但首先被索引,不僅會降低網站的質量,還會花更多的時間為機器人編制索引。

不斷索引時降低網絡速度

當沒有 robots.txt 文件時,機器人仍會掃描您網站上的整個內容。 除了顯示您的客戶不想看到的內容之外,持續的抓取和索引也會降低頁面的加載速度。

網絡速度是網站的一個非常重要的方面,會影響他們訪問您的網站時的質量和用戶體驗。 頁面也更高。

由於這些原因,您應該為 WordPress 構建這種技術文件來指示機器人:“機器人掃描一側,不要掃描另一側!”。 使用 WordPress 的標準 robots.txt 文件有助於提高機器人網站抓取和索引的效率。 從那裡,改善您網站的 SEO 結果。

您的 WordPress 網站是否有必要擁有此文件?

如果您不使用站點地圖,您仍然需要跋涉並對您的網站進行排名。 但是,搜索引擎無法說明不應運行哪些頁面或文件夾。

當您開始寫博客時,這並不重要。 但是,隨著網站的發展和擁有大量內容,您可能想要更多地控制您的網站是如何排列和編入索引的。

搜索機器人對每個網站都有一個爬網配額。 這意味著他們會在抓取會話期間抓取某些頁面。 如果他們還沒有完成您網站上的所有頁面,他們將在下一個會話中再次爬行。 他們還在那裡,並沒有消失。

這可能會降低您網站的索引速度。 但是您可以通過禁止搜索機器人嘗試抓取不必要的頁面(例如 wp-admin 管理頁面、插件目錄和主題目錄)來解決此問題。

通過拒絕不必要的頁面,您可以節省抓取配額。 這使搜索引擎能夠絆倒並更快地索引您網站的頁面。

另一個使用 robots.txt 文件的好理由是防止搜索引擎將帖子或頁面編入索引。 這不是隱藏搜索引擎內容的最安全方法,但它有助於阻止搜索結果。

針對 SEO 內容優化 Robots.txt 的完美指南

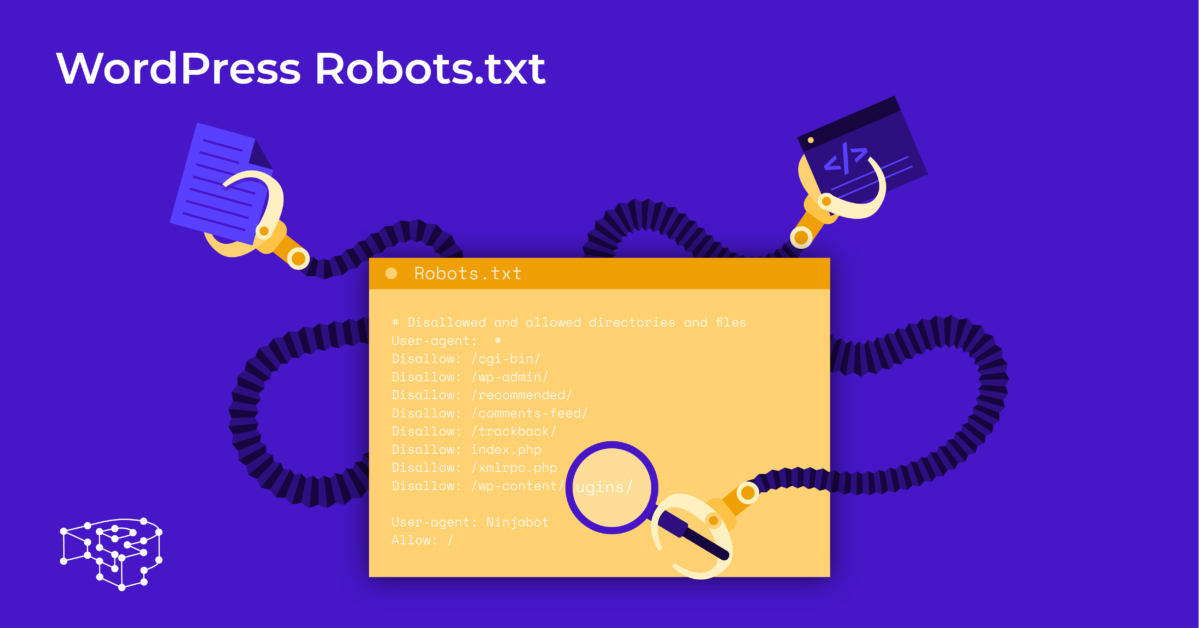

許多博客網站選擇在他們的 WordPress 網站上運行一個非常普通的 robots.txt 文件。 它們的內容可能會有所不同,具體取決於特定網站的需求:

用戶代理: *

不允許:

站點地圖:http://www.example.com/post-sitemap.xml

站點地圖:http://www.example.com/page-sitemap.xml

此 robots.txt 文件將所有機器人連接到 XML 站點地圖以指示所有內容。

我們為 WordPress 網站推荐一些有用文件的以下指南:

用戶代理: *

允許:/wp-content/uploads/

禁止:/wp-content/plugins/

禁止:/wp-admin/

禁止:/readme.html

禁止:/引用/

站點地圖:http://www.example.com/post-sitemap.xml

站點地圖:http://www.example.com/page-sitemap.xml

WordPress 的所有圖片和文件都已編入索引。 搜索機器人甚至可以索引插件文件、管理區域、自述文件和附屬鏈接。

您還可以通過向 robots.txt 文件添加地圖,輕鬆讓 Google Bot 找到您網站上的所有頁面。

為您的網站創建 WordPress robots.txt 文件

使用記事本創建 robots.txt 文件

記事本是 Microsoft 的最小文本編輯器。 它用於編寫服務於 Pascal、C+、HTML 編程語言等的代碼。

WordPress robots.txt 需要一個文本文件,ASCII 或 UTF-8,以名稱“robots.txt”正確保存在網站源文件中。 每個文件包含許多規則,每個規則在一行上。

您可以生成一個新的記事本文件,將其保存為 robots.txt 並按照上述說明添加規則。

之後,將WordPress的文件上傳到public_html目錄就完成了。

使用 Yoast SEO 插件創建 robots.txt 文件

Yoast SEO 插件是評價最高的插件之一,可幫助您在內容方面優化網站的 SEO。 但是,Yoast SEO 也可以被視為 robots.txt WordPress 插件,可幫助您創建用於優化網站的創新文件。

首先,您轉到儀表板。

在儀表板=> 選擇在 Yoast SEO 管理頁面 => 選擇文件編輯器。

選擇新建以啟動 WordPress 文件或編輯現有文件。

選擇Save changes to robots.txt 以確認自定義 robots.txt 文件已完成。

再次訪問該網站,您將看到剛剛安裝的新規則。

檢查 Google Search Console 上的 robots.txt 文件

您可以登錄 Google Search Console 並註冊您的網站資產以開始。

選擇Go to old version返回舊界面並啟用使用。

在抓取下=> 選擇檢查錯誤和警告數量的結果=> 如果有,請執行更正。

選擇下載更新的代碼下載新的robots.txt並將新文件重新上傳到原始目錄或選擇最後的想法

通過本文,您了解了為 WordPress 設置 robots.txt 文件的重要性和方法。 擁有一個標準的 robots.txt 文件將有助於您的網站和搜索引擎機器人更好地互動,因此網站的信息將得到準確更新並增加接觸更多用戶的能力。

讓我們開始為 WordPress 創建您自己的技術文件並立即改進網站的 SEO!

閱讀更多:用於保護 WordPress 的 10 個最佳免費 WP 備份插件