Ghidul complet pentru optimizarea WordPress Robots.txt pentru SEO

Publicat: 2021-03-11Pentru ca site-ul dvs. să fie indexat rapid, optimizat pentru SEO și îmbunătățirea clasamentului pe pagina cu rezultatele căutării SERP, mai întâi trebuie să construiți un fișier tehnic robots.txt pentru WordPress. Fișierul Robots.txt ilustrează cum să scanați și să configurați site-ul dvs. de index, în special, făcându-l un instrument SEO extrem de puternic. Prin urmare, vă vom sugera ghidul complet pentru a îmbunătăți WordPress robots.txt pentru SEO în acest articol.

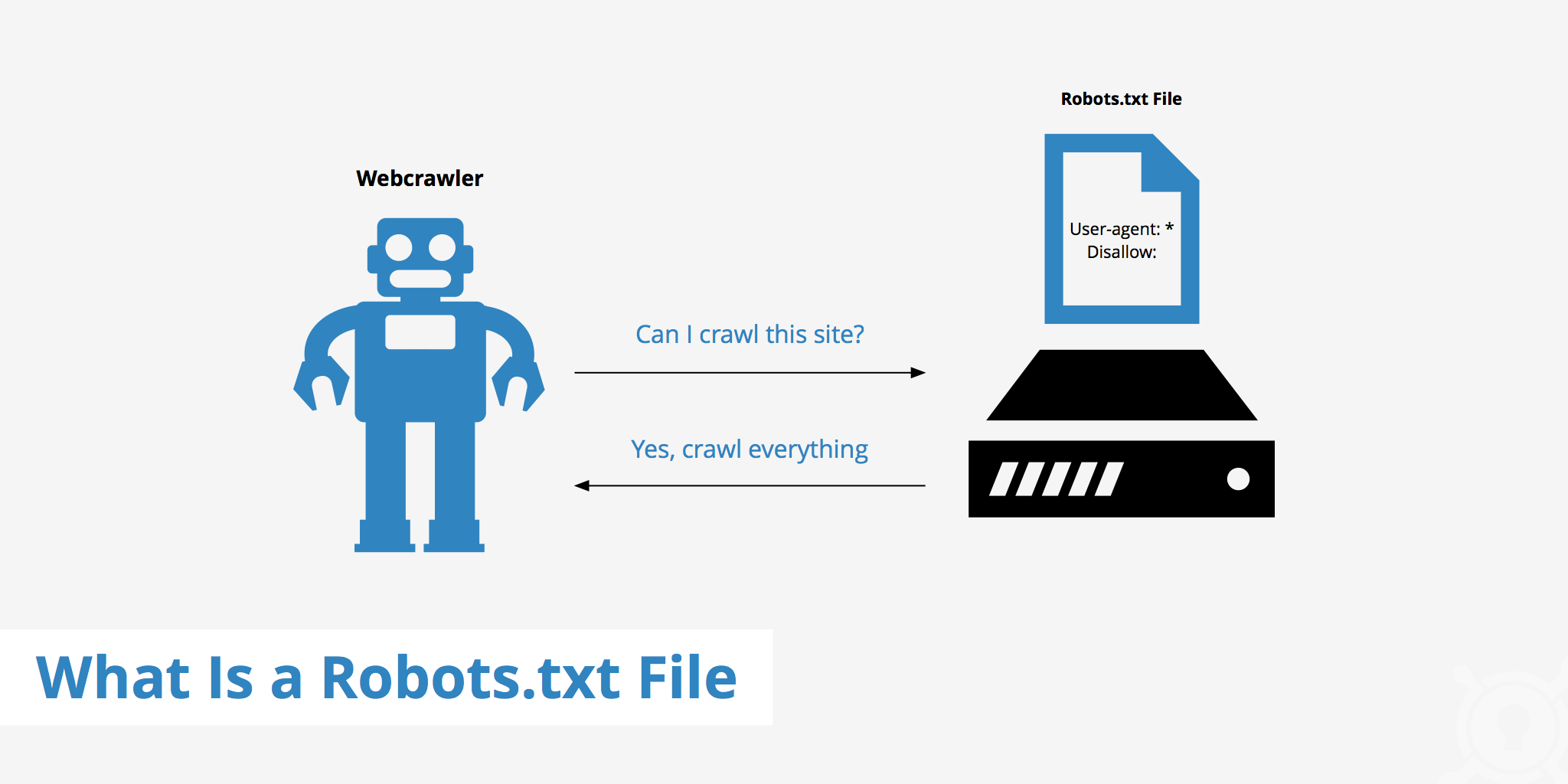

Ce este WordPress Robots.txt?

Acesta este fișierul text din folderul rădăcină al unui site web și oferă instrucțiuni despre motorul de căutare pentru care paginile pot fi indexate.

Dacă ați descoperit anterior procesul de lucru al motoarelor de căutare, veți ști că în timpul fazei de crawling și indexare, browserele web încearcă să găsească pagini disponibile public pe web, pe care le pot include în indexul lor.

Primul lucru pe care îl operează un browser web atunci când vizitează un site web este să găsească și să verifice conținutul fișierului robots.txt. În funcție de regulile specificate în fișier, acestea generează o listă de adrese URL care pot fi accesate cu crawlere și apoi indexate în mod specific pentru site.

De ce trebuie să construiți un fișier WordPress robots.txt?

Există multe cazuri în care roboții motoarelor de căutare „scanează” site-ul dvs. sunt împiedicați sau restricționați:

Conținutul este nul și duplicat

De fapt, pe site-ul dvs. web, afișează o mulțime de alte informații, cum ar fi fișiere de configurare a sistemului, pluginuri WordPress etc.

Aceste informații nu sunt valoroase pentru utilizator. Mai mult, există mai multe situații în care conținutul site-ului este duplicat. Dacă conținutul este încă indexat, acesta va dilua site-ul web, reducând calitatea reală a conținutului site-ului.

Subpagini pentru configurarea și testarea site-ului web

În acest caz, poate că atunci când creați un nou site web prin WordPress, nu ați finalizat procesul de proiectare și configurare a site-ului web, în general nu este pregătit pentru utilizator, trebuie să luați măsuri pentru a împiedica roboții motoarelor de căutare să „scaneze” și să-și valideze site-ul web.

Nu numai asta, dar unele site-uri web au și multe subpagini care sunt folosite doar pentru a testa caracteristicile și designul site-ului web, permițând utilizatorilor să acceseze astfel de site-uri va afecta calitatea site-ului web și profesionalismul companiei dumneavoastră.

Site-ul web de mare capacitate durează mult timp de încărcare

Fiecare roboți de motor de căutare are doar o capacitate limitată de „scanare” pentru fiecare vizită pe site. Când site-ul dvs. are o cantitate mare de conținut, roboții vor trebui să ia mai mult timp pentru a analiza, deoarece dacă a funcționat suficient pentru o vizită, conținutul rămas de pe site trebuie să aștepte până la următoarea rotire a botilor. poate fi accesat cu crawlere și indexat din nou.

Dacă site-ul dvs. are încă fișiere și conținut inutile, dar este indexat mai întâi, nu numai că va reduce calitatea site-ului, ci va petrece și mai mult timp indexând roboții.

Reduce viteza web la indexarea constantă

Când nu există niciun fișier robots.txt, roboții vor scana în continuare întregul conținut de pe site-ul dvs. Pe lângă faptul că afișează conținut pe care clienții tăi nu doresc să-l vadă, accesarea cu crawlere și indexarea constantă pot, de asemenea, să încetinească rata de încărcare a paginii.

Viteza web este un aspect esențial al site-ului web, influențând calitatea și experiența utilizatorului atunci când vă vizitează site-ul. pagina este de asemenea mai sus.

Din aceste motive, ar trebui să construiți acest tip de fișier tehnic pentru WordPress pentru a instrui roboții: „Boții scanează o parte, nu scanați cealaltă!”. Utilizarea fișierului robots.txt standard al WordPress ajută la creșterea și eficiența accesării cu crawlere și a indexării site-urilor web ale roboților. De acolo, îmbunătățiți rezultatele SEO pentru site-ul dvs.

Este necesar să aveți acest fișier pentru site-ul dvs. WordPress?

Dacă nu utilizați o hartă a site-ului, vă veți continua și vă veți clasifica site-ul. Motoarele de căutare nu pot spune totuși ce pagini sau foldere nu ar trebui să fie rulate.

Când începi un blog, asta nu contează prea mult. Cu toate acestea, puteți dori mai mult control asupra modului în care site-ul dvs. este ondulat și indexat pe măsură ce site-ul dvs. crește și aveți o mulțime de conținut.

Botul de căutare are o cotă de accesare cu crawlere pe site. Aceasta înseamnă că accesează cu crawlere anumite pagini în timpul unei sesiuni de accesare cu crawlere. Dacă nu au terminat toate paginile de pe site-ul dvs., ei vin și se accesează cu crawlere din nou în următoarea sesiune. Sunt încă acolo și nu dispar.

Acest lucru poate reduce viteza de indexare a site-ului dvs. Dar puteți remedia acest lucru interzicând roboții de căutare să încerce să acceseze cu crawlere paginile inutile, cum ar fi pagina de administrare wp-admin, directorul de pluginuri și directorul de teme.

Respingând paginile inutile, vă puteți salva cota de accesare cu crawlere. Acest lucru permite motoarelor de căutare să se împiedice și să indexeze mai rapid paginile site-ului dvs.

Un alt motiv bun pentru a utiliza fișierele robots.txt este acela de a împiedica motoarele de căutare să indexeze postări sau pagini. Acesta nu este cel mai sigur mod de a ascunde conținutul motorului de căutare, dar ajută la prevenirea rezultatelor căutării.

Ghidul perfect pentru a optimiza Robots.txt pentru conținutul SEO

Multe site-uri de blog aleg să ruleze un fișier robots.txt foarte modest pe web-ul lor WordPress. Conținutul lor poate varia, în funcție de nevoile site-ului respectiv:

Agent utilizator: *

Nu permiteți:

Harta site-ului: http://www.example.com/post-sitemap.xml

Harta site-ului: http://www.example.com/page-sitemap.xml

Acest fișier robots.txt oferă tuturor roboților o conexiune la harta site-ului XML pentru a indica tot conținutul.

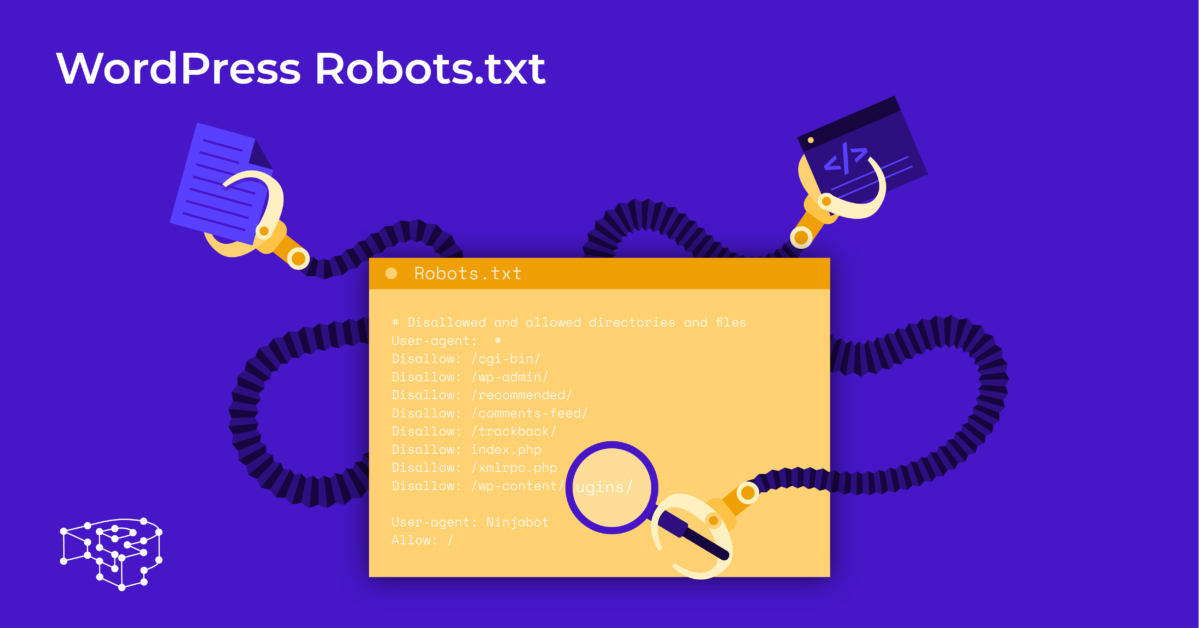

Vă recomandăm următoarele instrucțiuni ale unor fișiere utile pentru site-urile WordPress:

Agent utilizator: *

Permite: /wp-content/uploads/

Nu permiteți: /wp-content/plugins/

Nu permiteți: /wp-admin/

Nu permiteți: /readme.html

Nu permiteți: /refer/

Harta site-ului: http://www.example.com/post-sitemap.xml

Harta site-ului: http://www.example.com/page-sitemap.xml

Toate imaginile și fișierele WordPress sunt indexate. Boții de căutare ar putea chiar să indexeze fișierele plugin, zona de administrare, fișierele readme și linkurile afiliate.

De asemenea, puteți lăsa cu ușurință Google Bots să găsească toate paginile de pe site-ul dvs., adăugând o hartă în fișierul robots.txt.

Crearea unui fișier WordPress robots.txt pentru site-ul dvs. web

Creați fișierul robots.txt folosind Notepad

Notepad este un editor de text minim de la Microsoft . Este pentru scrierea codului care servește Pascal, C +, limbajul de programare HTML, ...

Pentru WordPress robots.txt este necesar un fișier text, ASCII sau UTF-8, salvat în mod corespunzător în fișierul sursă al site-ului web cu numele „robots.txt”. Fiecare fișier conține multe reguli și fiecare regulă este pe o singură linie.

Puteți genera un nou fișier Notepad, îl puteți salva ca robots.txt și puteți adăuga regulile conform instrucțiunilor de mai sus.

După aceea, încărcarea fișierului pentru WordPress în directorul public_html este completă.

Creați fișierul robots.txt folosind pluginul Yoast SEO

Pluginul Yoast SEO se numără printre cele mai bine cotate pluginuri pentru a vă ajuta să optimizați SEO site-ului dvs. din punct de vedere al conținutului. Cu toate acestea, Yoast SEO poate fi văzut și ca un plugin WordPress robots.txt care vă ajută să creați un fișier inovator pentru optimizarea site-urilor dvs.

Mai întâi, accesați Tabloul de bord.

În Tabloul de bord => Selectați În pagina de administrare Yoast SEO => Alegeți Editorul de fișiere.

Selectați Creare nou pentru a iniția fișierul pentru WordPress sau pentru a edita un fișier existent.

Selectați Salvați modificările în robots.txt pentru a confirma că fișierul personalizat robots.txt este complet.

Vizitați din nou site-ul web și veți vedea noile reguli pe care tocmai le-ați instalat.

Verificați fișierul robots.txt pe Google Search Console

Vă puteți conecta la Google Search Console și vă puteți înregistra de la început proprietatea site-ului .

Selectați Accesați versiunea veche pentru a reveni la vechea interfață și a activa utilizarea.

Sub Crawl => Selectați Verificați rezultatul numărului de Erori și Avertismente => Efectuați corectarea dacă există.

Selectați Descărcați codul actualizat pentru a descărca noul robots.txt și reîncărcați noul fișier în directorul original sau selectați Gânduri finale

Prin acest articol, ați învățat importanța precum și modul de a configura un fișier robots.txt pentru WordPress. Deținerea unui fișier standard robots.txt va ajuta site-ul dvs. web și roboții motoarelor de căutare să interacționeze mai bine, astfel încât informațiile site-ului vor fi actualizate cu acuratețe și vor crește capacitatea de a ajunge la mai mulți utilizatori.

Să începem cu crearea propriului fișier tehnic pentru WordPress și îmbunătățirea imediată a SEO a site-ului!

Citiți mai multe: 10 cele mai bune pluginuri gratuite de backup WP pentru protejarea WordPress