SEOのためにWordPressRobots.txtを最適化するための完全なガイド

公開: 2021-03-11ウェブサイトのインデックスをすばやく作成し、SEOを最適化し、SERP検索結果ページのランキングを向上させるには、まず、WordPress用の技術的なrobots.txtファイルを作成する必要があります。 Robots.txtファイルは、インデックスサイトをスキャンして構成する方法を示しています。特に、非常に強力なSEOツールになっています。 したがって、この記事では、SEO用のWordPressrobots.txtを強化するための完全なガイドを提案します。

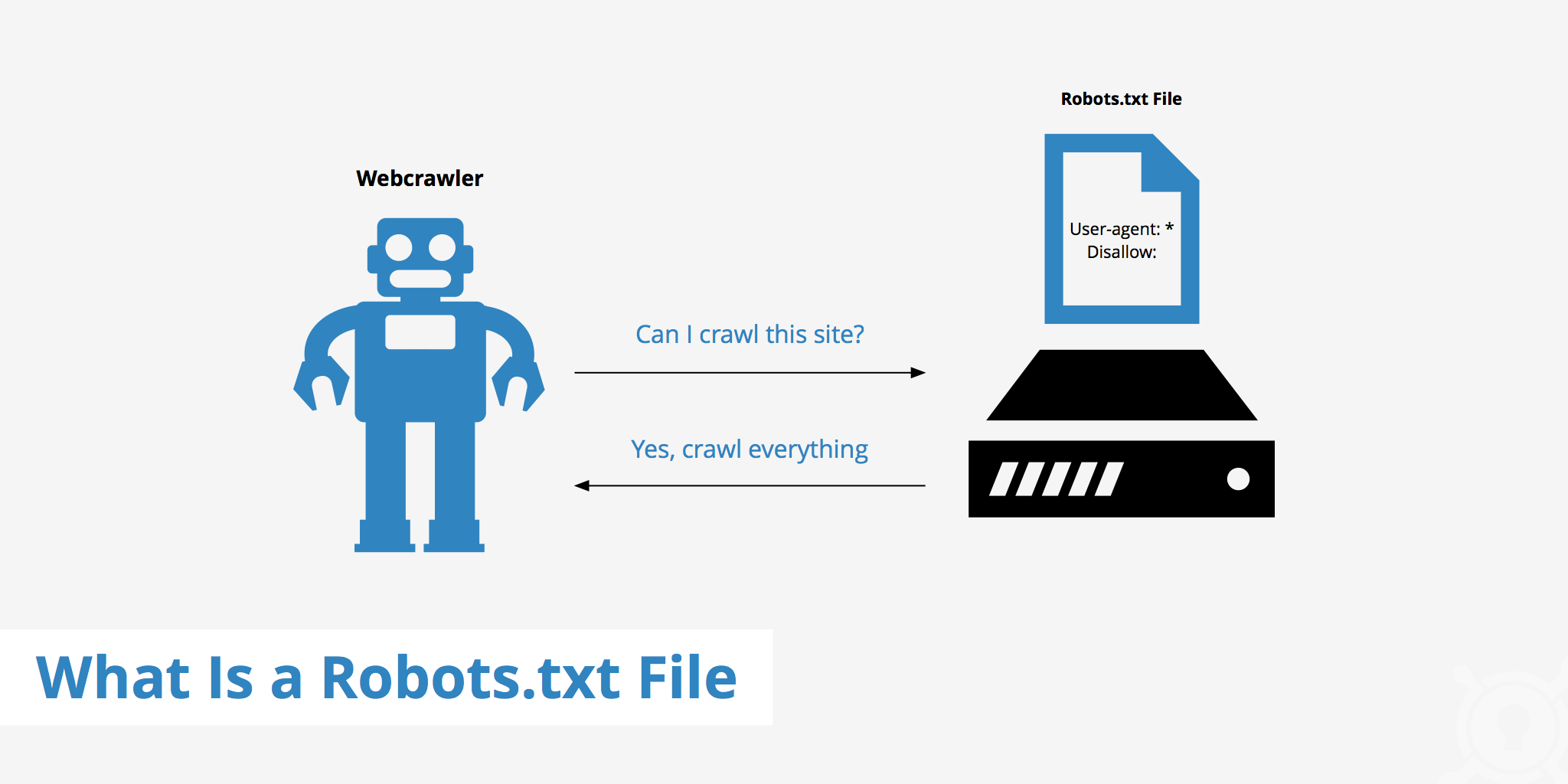

WordPress Robots.txtとは何ですか?

これは、Webサイトのルートフォルダにあるテキストファイルであり、ページのインデックスを作成できる検索エンジンに関する指示を提供します。

以前に検索エンジンの動作プロセスを発見したことがある場合は、クロールとインデックス作成の段階で、WebブラウザがWeb上で公開されているページを見つけようとし、そのページをインデックスに含めることができることをご存知でしょう。

WebブラウザがWebサイトにアクセスしたときに最初に動作するのは、robots.txtファイルの内容を見つけて確認することです。 ファイルで指定されたルールに応じて、クロールしてサイト用に特別にインデックスを作成できるURLのリストが生成されます。

なぜWordPressrobots.txtファイルを作成する必要があるのですか?

検索エンジンボットがあなたのウェブサイトを「スキャン」することを妨げられたり制限されたりする多くの場合があります:

コンテンツは無効であり、複製されています

実際、あなたのWebサイトには、システムセットアップファイルやWordPressプラグインなど、他の多くの情報が表示されます。

この情報はユーザーにとって価値がありません。 また、ウェブサイトの内容が重複する場合があります。 コンテンツがまだインデックスに登録されている場合、Webサイトが希薄になり、Webサイトの実際のコンテンツ品質が低下します。

Webサイトを設定およびテストするためのサブページ

この場合、WordPressで新しいウェブサイトを作成するときに、ウェブサイトの設計と設定のプロセスが完了していない可能性があります。通常、ユーザーの準備ができていないため、検索エンジンボットが「スキャン」して検証するのを防ぐための対策を講じる必要があります。 Webサイト。

それだけでなく、一部のWebサイトには、Webサイトの機能とデザインのテストにのみ使用される多くのサブページがあり、ユーザーがそのようなサイトにアクセスできるようにすると、Webサイトの品質と会社の専門性に影響します。

大容量のウェブサイトは読み込みに時間がかかります

各検索エンジンボットには、Webサイトへのアクセスごとに制限された「スキャン」機能しかありません。 Webサイトに大量のコンテンツがある場合、ボットは分析に時間がかかります。これは、1回の訪問で十分に機能している場合、Webサイトの残りのコンテンツは、次にボットがスピンするまで待機する必要があるためです。 クロールして再度インデックスを作成できます。

Webサイトに不要なファイルとコンテンツがまだあるが、最初にインデックスが作成されると、Webサイトの品質が低下するだけでなく、ボットのインデックス作成により多くの時間が費やされます。

常にインデックスを作成するときにWebの速度を低下させます

robots.txtファイルがない場合でも、ボットはWebサイトのコンテンツ全体をスキャンします。 顧客が見たくないコンテンツを表示することに加えて、継続的なクロールとインデックス作成により、ページの読み込み速度が低下する可能性があります。

Web速度は、Webサイトの非常に重要な側面であり、Webサイトにアクセスしたときの品質とユーザーエクスペリエンスに影響を与えます。 ページも高くなっています。

これらの理由から、WordPress用にこの種のテクニカルファイルを作成して、ボットに「ボットは一方をスキャンし、もう一方はスキャンしないでください」と指示する必要があります。 WordPressの標準robots.txtファイルを使用すると、ボットのWebサイトのクロールとインデックスの効率が向上します。 そこから、WebサイトのSEO結果を改善します。

あなたのWordPressウェブサイトのためにこのファイルを持っている必要がありますか?

サイトマップを使用していない場合でも、Webサイトを追跡してランク付けします。 ただし、検索エンジンは、どのページまたはフォルダーを実行したくないかを判断できません。

あなたがブログを始めるとき、それはそれほど重要ではありません。 ただし、サイトが成長し、コンテンツがたくさんある場合に、サイトがどのように波及してインデックスに登録されるかについて、より詳細に制御することができます。

検索ボットには、Webサイトごとにクロールクォータがあります。 これは、クロールセッション中に特定のページをクロールすることを意味します。 彼らがあなたのウェブサイトのすべてのページを終えていない場合、彼らは来て、次のセッションで再びクロールします。 彼らはまだそこにいて、消えることはありません。

これにより、Webサイトのインデックス作成速度が低下する可能性があります。 ただし、検索ボットがwp-admin管理ページ、プラグインディレクトリ、テーマディレクトリなどの不要なページをクロールすることを禁止することで、これを修正できます。

不要なページを拒否することで、クロールクォータを節約できます。 これにより、検索エンジンはつまずき、Webサイトのページをより迅速にインデックスに登録できます。

robots.txtファイルを使用するもう1つの理由は、検索エンジンが投稿やページのインデックスを作成できないようにすることです。 これは検索エンジンのコンテンツを非表示にする最も安全な方法ではありませんが、検索結果を防ぐのに役立ちます。

SEOコンテンツ用にRobots.txtを最適化するための完璧なガイドライン

多くのブログサイトは、WordPressWeb上で非常に控えめなrobots.txtファイルを実行することを選択しています。 それらのコンテンツは、特定のWebサイトのニーズに応じて異なります。

ユーザーエージェント: *

禁止:

サイトマップ:http://www.example.com/post-sitemap.xml

サイトマップ:http://www.example.com/page-sitemap.xml

このrobots.txtファイルは、すべてのボットにXMLサイトマップへの接続を提供してすべてのコンテンツを示します。

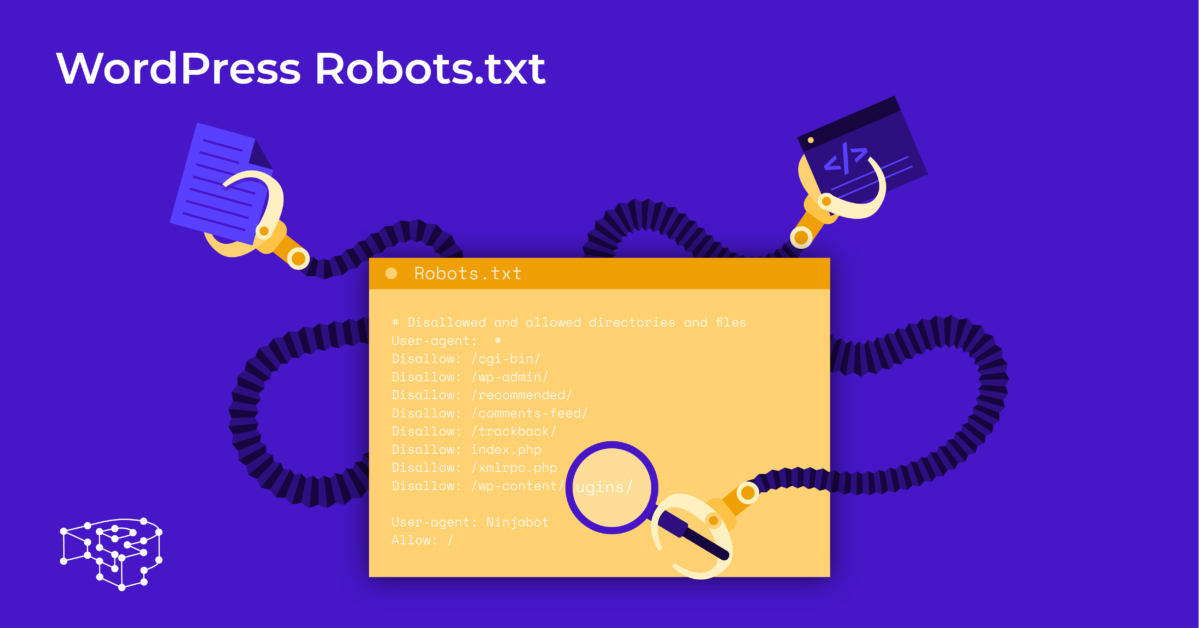

WordPressWebサイトに役立つファイルについて次のガイドラインをお勧めします。

ユーザーエージェント: *

許可:/ wp-content / uploads /

禁止:/ wp-content / plugins /

禁止:/ wp-admin /

禁止:/readme.html

禁止:/ refer /

サイトマップ:http://www.example.com/post-sitemap.xml

サイトマップ:http://www.example.com/page-sitemap.xml

WordPressのすべての写真とファイルにインデックスが付けられます。 検索ボットは、プラグインファイル、管理領域、readmeファイル、およびアフィリエイトリンクのインデックスを作成することもできます。

また、robots.txtファイルに地図を追加することで、Googleボットにウェブサイト上のすべてのページを簡単に検索させることができます。

ウェブサイト用のWordPressrobots.txtファイルを作成する

メモ帳を使用してrobots.txtファイルを作成します

メモ帳は、Microsoftの最小限のテキストエディタです。 Pascal、C +、HTMLプログラミング言語などを提供するコードを書くためのものです。

WordPress robots.txtには、「robots.txt」という名前でWebサイトのソースファイルに適切に保存されたASCIIまたはUTF-8のテキストファイルが必要です。 各ファイルには多くのルールが含まれており、各ルールは1行にあります。

新しいメモ帳ファイルを生成し、robots.txtとして保存して、上記の手順でルールを追加できます。

その後、WordPressのファイルのpublic_htmlディレクトリへのアップロードが完了します。

YoastSEOプラグインを使用してrobots.txtファイルを作成します

Yoast SEOプラグインは、コンテンツの観点からWebサイトのSEOを最適化するのに役立つ最も評価の高いプラグインの1つです。 ただし、Yoast SEOは、サイトを最適化するための革新的なファイルを作成するのに役立つrobots.txtWordPressプラグインと見なすこともできます。

まず、ダッシュボードに移動します。

ダッシュボードには=>を選択YoastSEO管理ページで=>ファイルエディタを選択し[新規作成]を選択して、WordPressのファイルを開始するか、既存のファイルを編集します。

[変更をrobots.txtにもう一度Webサイトにアクセスすると、インストールしたばかりの新しいルールが表示されます。

Google検索コンソールでrobots.txtファイルを確認してください

Google Search Consoleにログインして、ウェブサイトのプロパティをスタートに登録できます。

[古いバージョンにクロールの下に=>選択しエラーと警告の数の結果を確認します=>修正がある場合は実行します。

[更新されたコードをダウンロード]を選択して新しいrobots.txtをダウンロードし、新しいファイルを元のディレクトリに再アップロードする最終的な考え

この記事を通じて、WordPressのrobots.txtファイルを設定する方法と重要性を学びました。 標準のrobots.txtファイルを所有すると、ウェブサイトと検索エンジンのボットの相互作用が向上するため、サイトの情報が正確に更新され、より多くのユーザーにリーチできるようになります。

WordPress用の独自のテクニカルファイルを作成し、WebサイトのSEOをすぐに改善することから始めましょう!

続きを読む:WordPressを保護するための10の最高の無料WPバックアッププラグイン