Kompletny przewodnik po optymalizacji WordPress Robots.txt pod kątem SEO

Opublikowany: 2021-03-11Aby Twoja witryna została szybko zaindeksowana, zoptymalizowana pod kątem SEO i poprawiła rankingi na stronie wyników wyszukiwania SERP, najpierw musisz zbudować techniczny plik robots.txt dla WordPress. Plik Robots.txt ilustruje, jak skanować i konfigurować witrynę indeksu, dzięki czemu jest niezwykle potężnym narzędziem SEO. Dlatego w tym artykule zasugerujemy pełny przewodnik dotyczący ulepszenia pliku robots.txt WordPress pod kątem SEO.

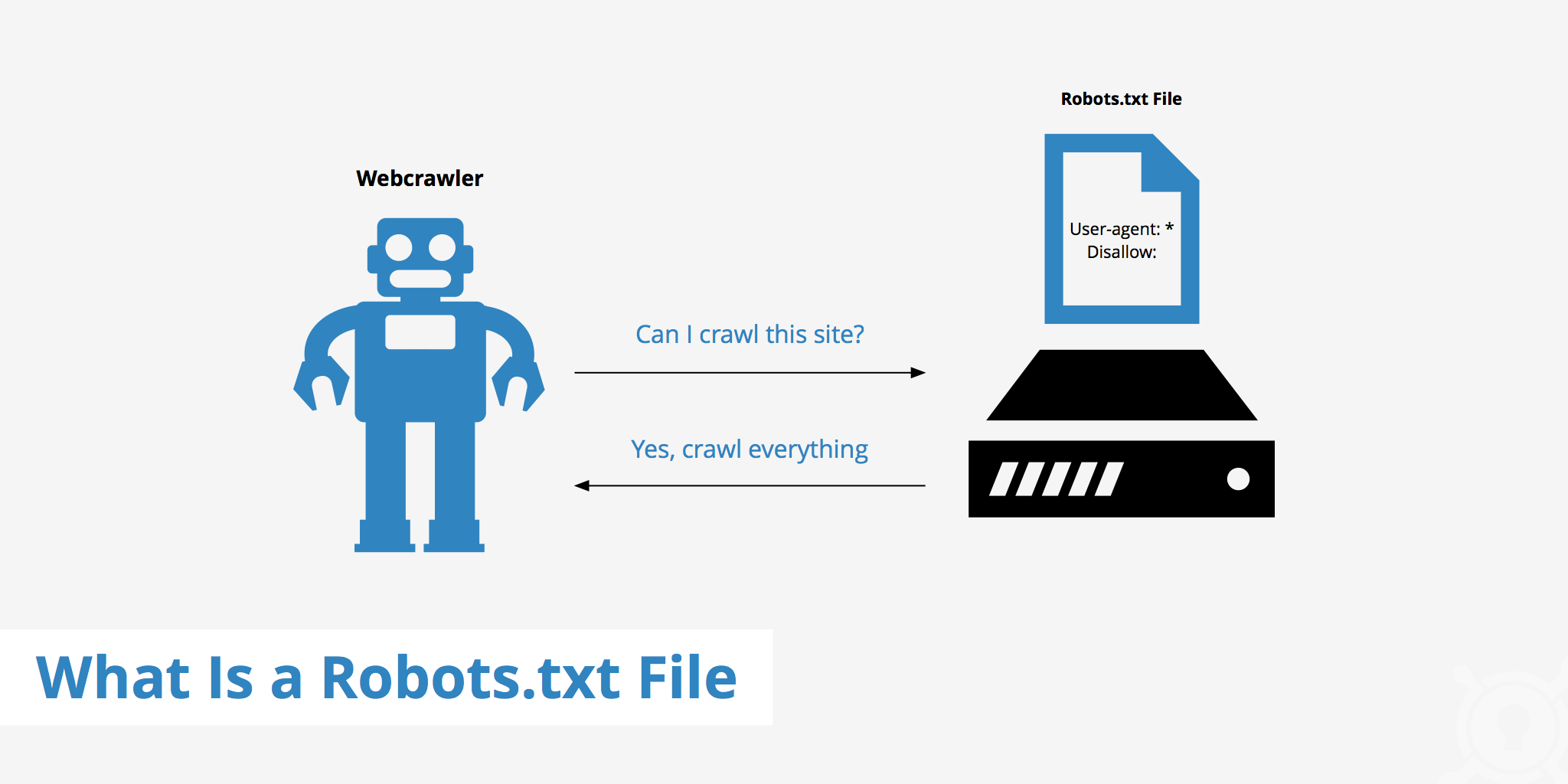

Co to jest WordPress Robots.txt?

Jest to plik tekstowy w folderze głównym witryny i zawiera instrukcje w wyszukiwarce, które strony mogą być indeksowane.

Jeśli wcześniej odkryłeś proces działania wyszukiwarek, będziesz wiedział, że podczas fazy przeszukiwania i indeksowania przeglądarki internetowe próbują znaleźć publicznie dostępne strony w sieci, które mogą uwzględnić w swoim indeksie.

Pierwszą czynnością, jaką działa przeglądarka internetowa podczas odwiedzania witryny, jest znalezienie i sprawdzenie zawartości pliku robots.txt. W zależności od reguł określonych w pliku generują listę adresów URL, które można przeszukiwać, a następnie specjalnie indeksować dla witryny.

Dlaczego musisz konstruować plik robots.txt WordPress?

Istnieje wiele przypadków, w których boty wyszukiwarek „skanują” Twoją witrynę, są blokowane lub ograniczane:

Treść jest nieważna i zduplikowana

W rzeczywistości na Twojej stronie wyświetla się wiele innych informacji, takich jak pliki konfiguracyjne systemu, wtyczki WordPress itp.

Te informacje nie są cenne dla użytkownika. Ponadto istnieje kilka sytuacji, w których zawartość serwisu jest powielana. Jeśli treść jest nadal indeksowana, osłabi to witrynę, obniżając rzeczywistą jakość treści witryny.

Podstrony do zakładania i testowania serwisu

W takim przypadku, być może podczas tworzenia nowej witryny przez WordPress, nie zakończyłeś procesu projektowania i konfiguracji witryny, generalnie nie jest ona gotowa dla użytkownika, musisz podjąć środki, aby roboty wyszukiwarek nie „skanowały” i weryfikowały swoje Strona internetowa.

Mało tego, niektóre serwisy mają też wiele podstron, które służą jedynie do testowania funkcjonalności i projektowania serwisu, co wpłynie na jakość serwisu i profesjonalizm Twojej firmy.

Witryna o dużej pojemności zajmuje długi czas ładowania

Każdy boty wyszukiwarek ma tylko ograniczoną możliwość „skanowania” na wizytę w witrynie. Gdy Twoja witryna zawiera dużą ilość treści, boty będą musiały poświęcić więcej czasu na analizę, ponieważ jeśli działały wystarczająco dużo na jedną wizytę, pozostała zawartość witryny musi poczekać do następnego obrotu. mogą być ponownie przeszukiwane i indeksowane.

Jeśli Twoja witryna nadal zawiera niepotrzebne pliki i treści, ale jest najpierw zaindeksowana, nie tylko obniży to jakość witryny, ale także spędzi więcej czasu na indeksowaniu botów.

Zmniejsza prędkość sieci przy ciągłym indeksowaniu

Gdy nie ma pliku robots.txt, boty nadal będą skanować całą zawartość Twojej witryny. Oprócz wyświetlania treści, których Twoi klienci nie chcą oglądać, ciągłe indeksowanie i indeksowanie może również spowolnić ładowanie strony.

Szybkość sieci jest bardzo istotnym aspektem witryny, wpływającym na jakość i wrażenia użytkownika podczas odwiedzania witryny. strona jest również wyższa.

Z tych powodów powinieneś stworzyć tego rodzaju plik techniczny dla WordPressa, aby poinstruować boty: „Boty skanują jedną stronę, nie skanuj drugiej!”. Wykorzystanie standardowego pliku robots.txt WordPressa pomaga zwiększyć i wydajność indeksowania i indeksowania stron internetowych botów. Stamtąd popraw wyniki SEO dla swojej witryny.

Czy konieczne jest posiadanie tego pliku dla Twojej witryny WordPress?

Jeśli nie korzystasz z mapy witryny, nadal będziesz brnąć i pozycjonować swoją witrynę. Wyszukiwarki nie mogą jednak stwierdzić, które strony lub foldery nie powinny chcieć działać.

Kiedy zakładasz bloga, nie ma to większego znaczenia. Możesz jednak chcieć mieć większą kontrolę nad tym, w jaki sposób Twoja witryna jest ripowana i indeksowana, gdy Twoja witryna się rozrasta i masz dużo treści.

Bot wyszukiwania ma limit indeksowania na witrynę. Oznacza to, że indeksują określone strony podczas sesji indeksowania. Jeśli nie ukończyli wszystkich stron w Twojej witrynie, przychodzą i indeksują ponownie w następnej sesji. Są nadal istnieje i nie zniknie.

Może to zmniejszyć szybkość indeksowania Twojej witryny. Ale możesz to naprawić, uniemożliwiając botom wyszukiwania próby indeksowania niepotrzebnych stron, takich jak strona administracyjna wp-admin, katalog wtyczek i katalog motywów.

Odrzucając niepotrzebne strony, możesz zaoszczędzić swój limit indeksowania. Umożliwia to wyszukiwarkom potykanie się i szybsze indeksowanie stron Twojej witryny.

Innym dobrym powodem używania plików robots.txt jest uniemożliwienie wyszukiwarkom indeksowania postów lub stron. Nie jest to najbezpieczniejszy sposób ukrywania treści wyszukiwarek, ale pomaga zapobiegać wynikom wyszukiwania.

Idealna wskazówka dotycząca optymalizacji pliku Robots.txt pod kątem treści SEO

Wiele witryn blogowych decyduje się na uruchomienie bardzo skromnego pliku robots.txt w swojej sieci WordPress. Ich zawartość może się różnić w zależności od potrzeb konkretnego serwisu:

Agent użytkownika: *

Uniemożliwić:

Mapa witryny: http://www.example.com/post-sitemap.xml

Mapa witryny: http://www.example.com/page-sitemap.xml

Ten plik robots.txt nadaje wszystkim botom połączenie z mapą witryny XML, aby wskazać całą zawartość.

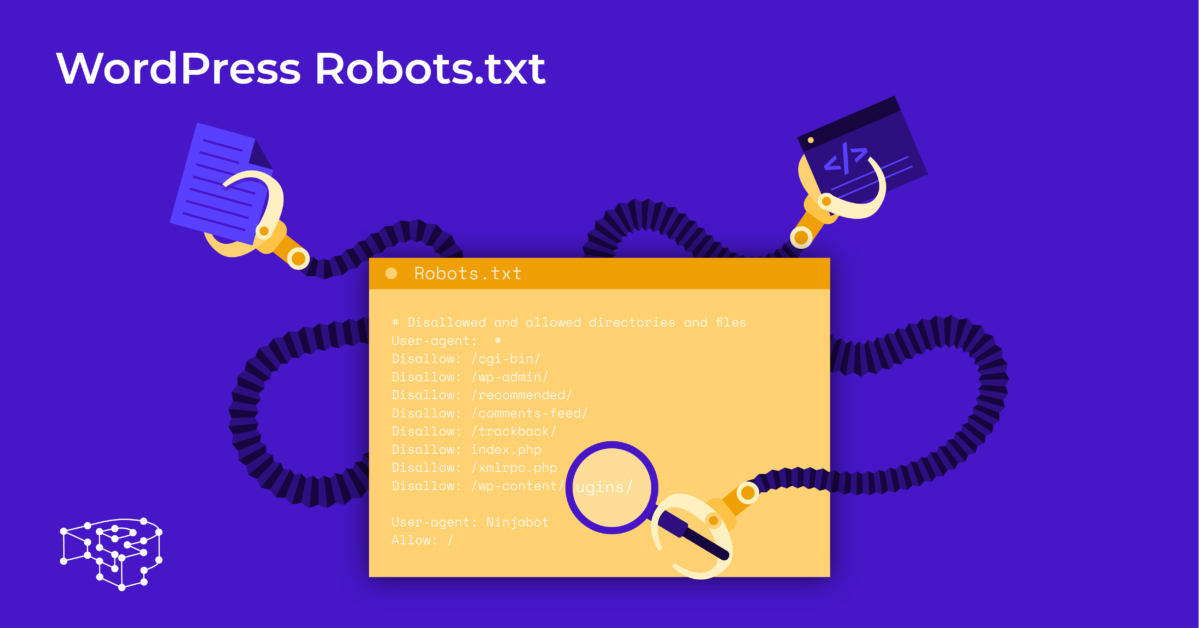

Polecamy następujące wytyczne niektórych przydatnych plików dla witryn WordPress:

Agent użytkownika: *

Zezwól: /wp-content/uploads/

Disallow: /wp-content/plugins/

Nie zezwalaj: /wp-admin/

Nie zezwalaj: /readme.html

Nie zezwalaj: /odsyłaj/

Mapa witryny: http://www.example.com/post-sitemap.xml

Mapa witryny: http://www.example.com/page-sitemap.xml

Wszystkie zdjęcia i pliki WordPressa są indeksowane. Boty wyszukiwania mogą nawet indeksować pliki wtyczek, obszar administracyjny, pliki readme i linki partnerskie.

Możesz też łatwo pozwolić robotom Google na znajdowanie wszystkich stron w Twojej witrynie, dodając mapę do pliku robots.txt.

Tworzenie pliku robots.txt WordPress dla Twojej witryny

Utwórz plik robots.txt za pomocą Notatnika

Notatnik to minimalny edytor tekstu firmy Microsoft . Służy do pisania kodu obsługującego Pascal, C +, język programowania HTML, …

Plik tekstowy ASCII lub UTF-8, prawidłowo zapisany w pliku źródłowym witryny pod nazwą „robots.txt”, jest wymagany dla WordPress robots.txt. Każdy plik zawiera wiele reguł, a każda reguła jest w jednym wierszu.

Możesz wygenerować nowy plik notatnika, zapisać go jako robots.txt i dodać reguły zgodnie z instrukcją powyżej.

Następnie przesyłanie pliku dla WordPressa do katalogu public_html jest zakończone.

Utwórz plik robots.txt za pomocą wtyczki Yoast SEO

Wtyczka Yoast SEO jest jedną z najlepiej ocenianych wtyczek, które pomagają w optymalizacji SEO witryny pod względem treści. Jednak Yoast SEO można również postrzegać jako wtyczkę do WordPressa robots.txt, która pomaga tworzyć innowacyjny plik do optymalizacji witryn.

Najpierw przejdź do pulpitu nawigacyjnego.

W Dashboard => Wybierz Na stronie administratora Yoast SEO => Wybierz edytor plików.

Wybierz opcję Utwórz nowy, aby zainicjować plik dla WordPress lub edytować istniejący plik.

Wybierz opcję Zapisz zmiany w pliku robots.txt, aby potwierdzić, że niestandardowy plik robots.txt jest gotowy.

Odwiedź stronę ponownie, a zobaczysz nowe reguły, które właśnie zainstalowałeś.

Sprawdź plik robots.txt w Google Search Console

Aby rozpocząć, możesz zalogować się do Google Search Console i zarejestrować właściwość swojej witryny .

Wybierz Przejdź do starej wersji, aby powrócić do starego interfejsu i włączyć użycie.

W obszarze Indeksowanie => Wybierz Sprawdź wynik liczby błędów i ostrzeżeń => dokonaj korekty, jeśli występują.

Wybierz Pobierz zaktualizowany kod, aby pobrać nowy plik robots.txt i ponownie prześlij nowy plik do oryginalnego katalogu, lub wybierz Myśli końcowe

Dzięki temu artykułowi poznałeś znaczenie i sposób konfiguracji pliku robots.txt dla WordPress. Posiadanie standardowego pliku robots.txt pomoże Twojej witrynie i robotom wyszukiwarek lepiej współdziałać, dzięki czemu informacje w witrynie będą dokładnie aktualizowane i zwiększą możliwość dotarcia do większej liczby użytkowników.

Zacznijmy od stworzenia własnego pliku technicznego dla WordPressa i natychmiastowego usprawnienia SEO strony!

Czytaj więcej: 10 najlepszych darmowych wtyczek do tworzenia kopii zapasowych WP do ochrony WordPress