Полное руководство по оптимизации WordPress Robots.txt для SEO

Опубликовано: 2021-03-11Чтобы ваш веб-сайт мог быстро индексироваться, оптимизироваться для SEO и повышать рейтинг на странице результатов поиска SERP, прежде всего, вам необходимо создать технический файл robots.txt для WordPress. Файл Robots.txt показывает, как сканировать и настраивать ваш индексный сайт, в частности, делая его чрезвычайно мощным инструментом SEO. Следовательно, в этой статье мы предложим полное руководство по улучшению файла robots.txt WordPress для SEO.

Что такое WordPress Robots.txt?

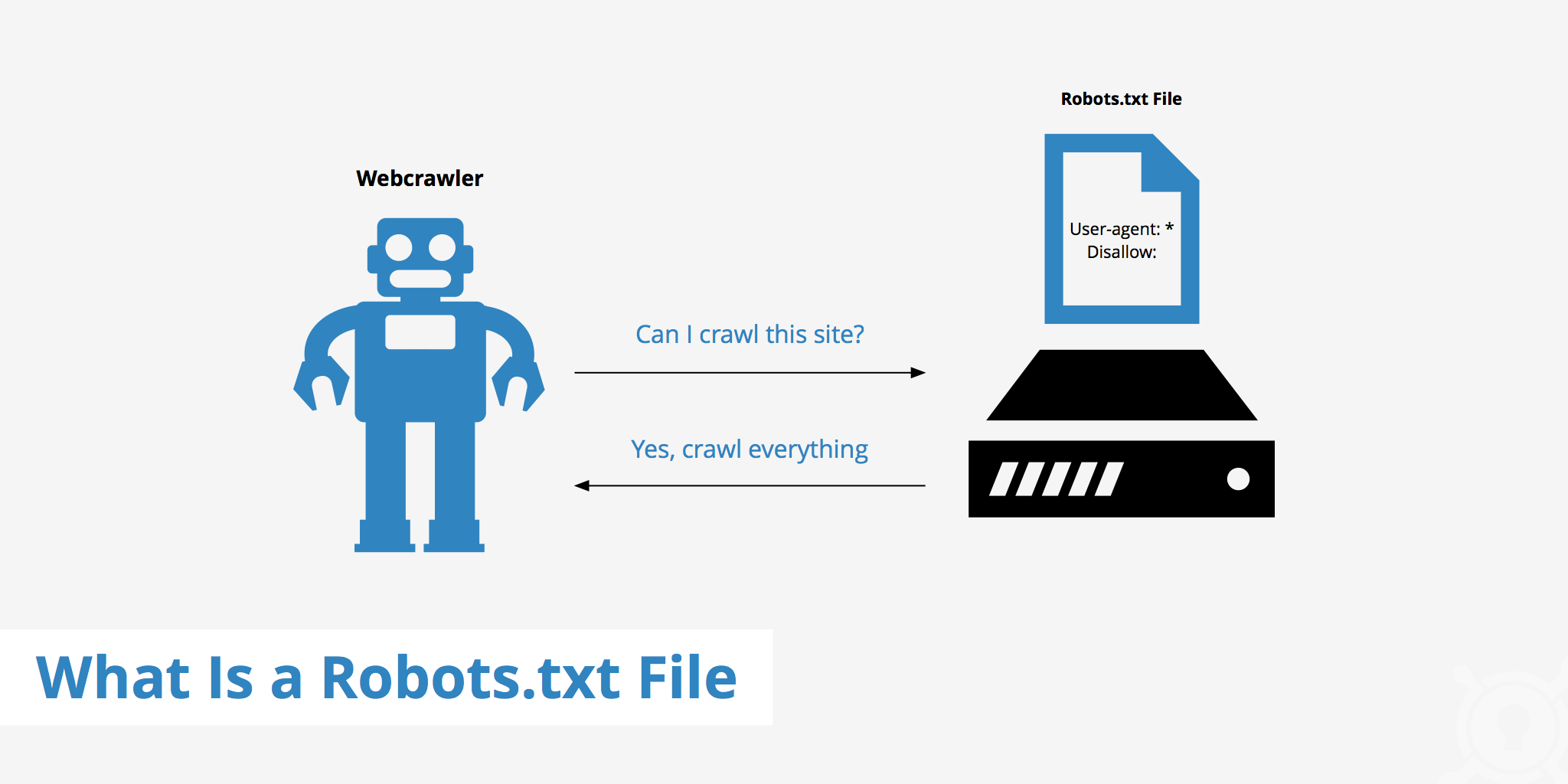

Это текстовый файл в корневой папке веб-сайта, содержащий инструкции для поисковой системы, для которых страницы могут быть проиндексированы.

Если вы ранее знакомы с рабочим процессом поисковых систем, вы знаете, что на этапе сканирования и индексации веб-браузеры пытаются найти общедоступные страницы в Интернете, которые они могут включить в свой индекс.

Первое, что делает веб-браузер при посещении веб-сайта, - это находит и проверяет содержимое файла robots.txt. В зависимости от правил, указанных в файле, они создают список URL-адресов, которые можно сканировать, а затем специально индексировать для сайта.

Зачем вам нужно создавать файл robots.txt WordPress?

Во многих случаях роботам поисковых систем запрещается или ограничивается «сканирование» вашего веб-сайта:

Контент недействителен и дублируется

Фактически, на вашем веб-сайте отображается много другой информации, такой как файлы настройки системы, плагины WordPress и т. Д.

Эта информация не представляет ценности для пользователя. Более того, есть несколько ситуаций, когда контент веб-сайта дублируется. Если контент по-прежнему проиндексирован, он разбавит веб-сайт, снизив фактическое качество содержимого веб-сайта.

Подстраницы для настройки и тестирования сайта

В этом случае, возможно, при создании нового веб-сайта с помощью WordPress вы не завершили процесс проектирования и настройки веб-сайта, как правило, не готовы для пользователя, вам необходимо принять меры для предотвращения «сканирования» поисковыми роботами и проверки их Веб-сайт.

Более того, на некоторых веб-сайтах также есть множество подстраниц, которые используются только для тестирования функций и дизайна веб-сайтов, и предоставление пользователям доступа к таким сайтам повлияет на качество веб-сайта и профессионализм вашей компании.

Веб-сайт большого размера долго загружается

У каждого робота поисковой системы есть только ограниченная возможность «сканирования» при посещении веб-сайта. Когда на вашем веб-сайте много контента, ботам потребуется больше времени для анализа, потому что, если он проработал достаточно для одного посещения, оставшийся контент на веб-сайте должен дождаться следующего запуска ботов. можно сканировать и снова индексировать.

Если на вашем веб-сайте все еще есть ненужные файлы и контент, но он сначала проиндексирован, это не только снизит качество веб-сайта, но и потратит больше времени на индексацию ботов.

Снижает скорость Интернета при постоянном индексировании

Когда файл robots.txt отсутствует, боты по-прежнему будут сканировать весь контент на вашем сайте. Помимо показа контента, который ваши клиенты не хотят видеть, постоянное сканирование и индексирование также могут снизить скорость загрузки страницы.

Скорость Интернета является важным аспектом веб-сайта, влияющим на качество и удобство работы пользователей при посещении вашего веб-сайта. страница тоже выше.

По этим причинам вам следует создать такой технический файл для WordPress, чтобы инструктировать ботов: «Боты сканируют одну сторону, не сканируйте другую!». Использование стандартного файла robots.txt WordPress помогает повысить эффективность сканирования и индексации веб-сайтов ботами. Оттуда улучшите результаты SEO для вашего сайта.

Нужен ли этот файл для вашего сайта WordPress?

Если вы не используете карту сайта, вы все равно будете тащиться и оценивать свой сайт. Однако поисковые системы не могут сказать, какие страницы или папки не должны запускаться.

Когда вы начинаете вести блог, это не имеет большого значения. Однако вам может потребоваться больше контроля над тем, как ваш сайт будет изменяться и индексироваться по мере роста вашего сайта и наличия большого количества контента.

У поискового бота есть квота сканирования для каждого веб-сайта. Это означает, что они сканируют определенные страницы во время сеанса сканирования. Если они не завершили работу со всеми страницами вашего веб-сайта, они будут сканировать снова в следующем сеансе. Они все еще существуют и никуда не денутся.

Это может снизить скорость индексации вашего сайта. Но вы можете исправить это, запретив поисковым роботам пытаться сканировать ненужные страницы, такие как страница администратора wp-admin, каталог плагинов и каталог тем.

Отклоняя ненужные страницы, вы можете сэкономить квоту на сканирование. Это позволяет поисковым системам быстрее индексировать страницы вашего сайта.

Еще одна веская причина для использования файлов robots.txt - запретить поисковым системам индексировать сообщения или страницы. Это не самый безопасный способ скрыть содержимое поисковой системы, но он помогает предотвратить выдачу результатов поиска.

Идеальное руководство по оптимизации Robots.txt для содержания SEO

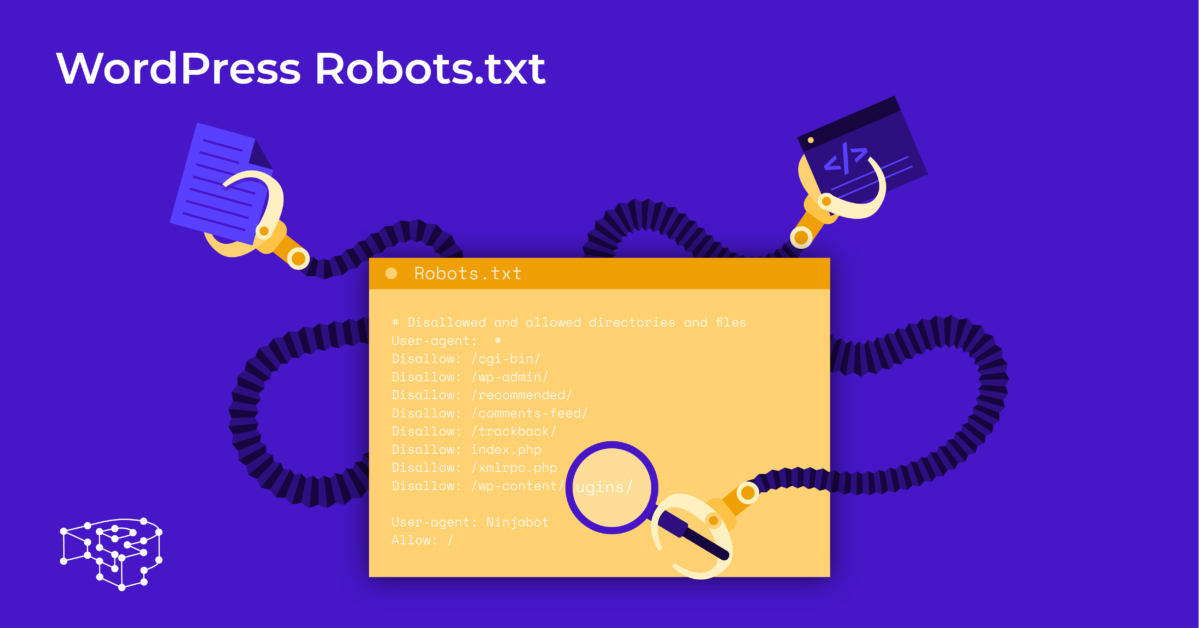

Многие сайты блогов предпочитают запускать очень скромный файл robots.txt в своей сети WordPress. Их содержание может варьироваться в зависимости от потребностей конкретного веб-сайта:

Пользовательский агент: *

Запретить:

Карта сайта: http://www.example.com/post-sitemap.xml

Карта сайта: http://www.example.com/page-sitemap.xml

Этот файл robots.txt передает всем ботам соединение с XML-картой сайта для обозначения всего содержимого.

Мы рекомендуем следующие рекомендации для некоторых полезных файлов для веб-сайтов WordPress:

Пользовательский агент: *

Разрешить: / wp-content / uploads /

Запретить: / wp-content / plugins /

Запретить: / wp-admin /

Запретить: /readme.html

Запретить: / ссылаться /

Карта сайта: http://www.example.com/post-sitemap.xml

Карта сайта: http://www.example.com/page-sitemap.xml

Все картинки и файлы WordPress проиндексированы. Поисковые роботы могут даже индексировать файлы плагинов, админку, файлы readme и партнерские ссылки.

Вы также можете легко позволить роботам Google находить все страницы вашего веб-сайта, добавив карту в файл robots.txt.

Создание файла robots.txt WordPress для вашего сайта

Создайте файл robots.txt с помощью Блокнота

Блокнот - это минималистичный текстовый редактор от Microsoft . Он предназначен для написания кода, обслуживающего Паскаль, C +, язык программирования HTML,…

Для файла robots.txt WordPress необходим текстовый файл ASCII или UTF-8, правильно сохраненный в исходном файле веб-сайта под именем robots.txt. Каждый файл содержит множество правил, и каждое правило находится в одной строке.

Вы можете создать новый файл блокнота, сохранить его как robots.txt и добавить правила, как описано выше.

После этого загрузка файла для WordPress в каталог public_html завершена.

Создайте файл robots.txt с помощью плагина Yoast SEO

Плагин Yoast SEO входит в число лучших плагинов, которые помогут вам оптимизировать SEO вашего сайта с точки зрения содержания. Однако Yoast SEO также можно рассматривать как плагин WordPress robots.txt, который помогает вам создавать инновационные файлы для оптимизации ваших сайтов.

Сначала вы переходите на панель инструментов.

В панели инструментов => выберите На странице администратора Yoast SEO => Выбрать редактор файлов.

Выберите « Создать», чтобы запустить файл для WordPress или отредактировать существующий файл.

Выберите Сохранить изменения в robots.txt, чтобы убедиться, что пользовательский файл robots.txt готов.

Посетите веб-сайт еще раз, и вы увидите новые правила, которые вы только что установили.

Проверьте файл robots.txt в консоли поиска Google.

Вы можете войти в Google Search Console и зарегистрировать свой сайт на сайте .

Выберите Перейти к старой версии, чтобы вернуться к старому интерфейсу и разрешить использование.

В разделе " Сканирование" => выберите Проверьте результат количества ошибок и предупреждений => Выполните исправление, если таковые имеются.

Выберите « Загрузить обновленный код», чтобы загрузить новый файл robots.txt и повторно загрузить новый файл в исходный каталог, или выберите « Заключительные мысли

Из этой статьи вы узнали о важности, а также о способе создания файла robots.txt для WordPress. Наличие стандартного файла robots.txt поможет вашему веб-сайту и роботам поисковых систем лучше взаимодействовать, поэтому информация на сайте будет точно обновляться и повысить возможность охвата большего числа пользователей.

Давайте начнем с создания вашего собственного технического файла для WordPress и сразу же улучшим SEO сайта!

Подробнее: 10 лучших бесплатных плагинов WP Backup для защиты WordPress