คู่มือฉบับสมบูรณ์เพื่อเพิ่มประสิทธิภาพ WordPress Robots.txt สำหรับ SEO

เผยแพร่แล้ว: 2021-03-11เพื่อให้เว็บไซต์ของคุณได้รับการจัดทำดัชนีอย่างรวดเร็ว เพิ่มประสิทธิภาพสำหรับ SEO และปรับปรุงการจัดอันดับในหน้าผลการค้นหาของ SERP อันดับแรก คุณต้องสร้างไฟล์ robots.txt ทางเทคนิคสำหรับ WordPress ไฟล์ Robots.txt แสดงวิธีการสแกนและกำหนดค่าเว็บไซต์ดัชนีของคุณ โดยเฉพาะอย่างยิ่ง ทำให้เป็นเครื่องมือ SEO ที่ทรงพลังอย่างยิ่ง ดังนั้น เราจะแนะนำคู่มือฉบับสมบูรณ์เพื่อปรับปรุง WordPress robots.txt สำหรับ SEO ในบทความนี้

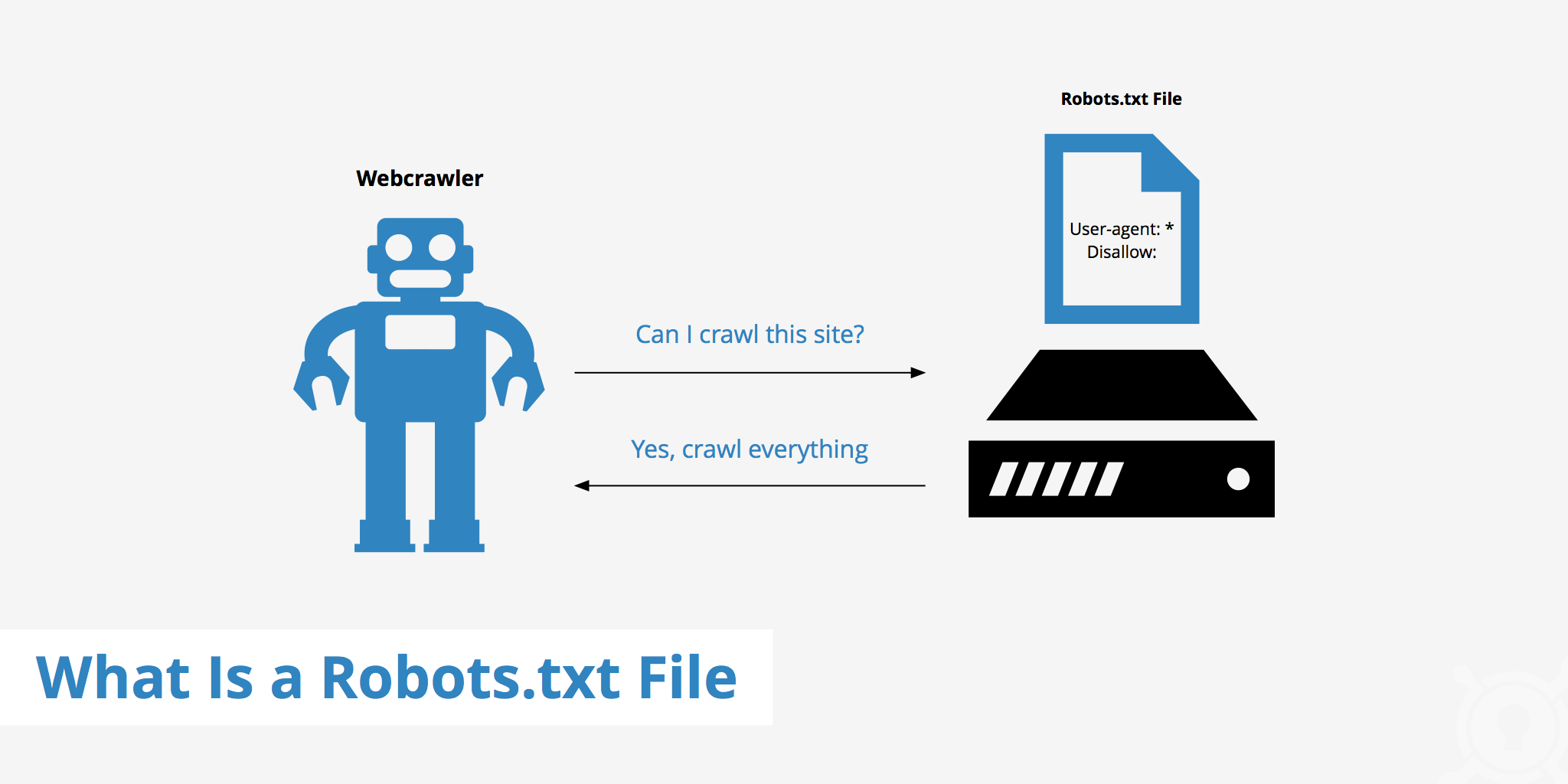

WordPress Robots.txt คืออะไร?

นี่คือไฟล์ข้อความในโฟลเดอร์รูทของเว็บไซต์และให้คำแนะนำในเครื่องมือค้นหาซึ่งหน้าต่างๆ สามารถสร้างดัชนีได้

หากคุณเคยพบกระบวนการทำงานของเครื่องมือค้นหามาก่อน คุณจะรู้ว่าในระหว่างขั้นตอนการรวบรวมข้อมูลและจัดทำดัชนี เว็บเบราว์เซอร์จะพยายามค้นหาหน้าที่เผยแพร่ต่อสาธารณะบนเว็บ ซึ่งสามารถรวมไว้ในดัชนีได้

สิ่งแรกที่เว็บเบราว์เซอร์ทำงานเมื่อเข้าชมเว็บไซต์คือการค้นหาและตรวจสอบเนื้อหาของไฟล์ robots.txt ขึ้นอยู่กับกฎที่ระบุในไฟล์ พวกเขาสร้างรายการ URL ที่สามารถรวบรวมข้อมูลและจัดทำดัชนีเฉพาะสำหรับไซต์ได้

ทำไมคุณต้องสร้างไฟล์ WordPress robots.txt?

มีหลายกรณีที่บอทของเครื่องมือค้นหาจากการ "สแกน" เว็บไซต์ของคุณได้รับการป้องกันหรือจำกัด:

เนื้อหาเป็นโมฆะและทำซ้ำ

ที่จริงแล้วบนเว็บไซต์ของคุณ ฉัน แสดง ข้อมูลอื่นๆ มากมาย เช่น ไฟล์การตั้งค่าระบบ ปลั๊กอิน WordPress เป็นต้น

ข้อมูลนี้ไม่มีค่าสำหรับผู้ใช้ นอกจากนี้ มีหลายกรณีที่เนื้อหาของเว็บไซต์ซ้ำซ้อน หากเนื้อหายังคงได้รับการจัดทำดัชนี จะทำให้เว็บไซต์เจือจางลง ส่งผลให้คุณภาพเนื้อหาที่แท้จริงของเว็บไซต์ลดลง

หน้าย่อยสำหรับตั้งค่าและทดสอบเว็บไซต์

ในกรณีนี้ บางทีเมื่อสร้างเว็บไซต์ใหม่ด้วย WordPress คุณยังไม่เสร็จสิ้นขั้นตอนการออกแบบและตั้งค่าเว็บไซต์ ซึ่งโดยทั่วไปไม่พร้อมสำหรับผู้ใช้ คุณต้องใช้มาตรการเพื่อป้องกันไม่ให้บอทของเครื่องมือค้นหา "สแกน" และตรวจสอบความถูกต้อง เว็บไซต์.

ไม่เพียงเท่านั้น แต่บางเว็บไซต์ยังมีหน้าย่อยจำนวนมากที่ใช้เพื่อทดสอบคุณลักษณะและการออกแบบของเว็บไซต์เท่านั้น การอนุญาตให้ผู้ใช้เข้าถึงเว็บไซต์ดังกล่าวจะส่งผลต่อคุณภาพของเว็บไซต์และความเป็นมืออาชีพของบริษัทคุณ

เว็บไซต์ที่มีความจุสูงใช้เวลาในการโหลดนาน

บอทของเครื่องมือค้นหาแต่ละตัวจะจำกัดความสามารถในการ "สแกน" ต่อการเข้าชมเว็บไซต์เท่านั้น เมื่อเว็บไซต์ของคุณมีเนื้อหาจำนวนมาก บอทจะต้องใช้เวลามากขึ้นในการวิเคราะห์ เพราะหากดำเนินการเพียงพอสำหรับการเข้าชมหนึ่งครั้ง เนื้อหาที่เหลือบนเว็บไซต์จะต้องรอจนกว่าบอทจะหมุนครั้งต่อไป สามารถรวบรวมข้อมูลและจัดทำดัชนีได้อีกครั้ง

หากเว็บไซต์ของคุณยังมีไฟล์และเนื้อหาที่ไม่จำเป็นแต่มีการจัดทำดัชนีก่อน ไม่เพียงแต่จะลดคุณภาพของเว็บไซต์ แต่ยังใช้เวลามากขึ้นในการจัดทำดัชนีบอท

ลดความเร็วของเว็บเมื่อสร้างดัชนีอย่างต่อเนื่อง

เมื่อไม่มีไฟล์ robots.txt บอทจะยังสแกนเนื้อหาทั้งหมดบนเว็บไซต์ของคุณ นอกจากการแสดงเนื้อหาที่ลูกค้าของคุณไม่ต้องการเห็นแล้ว การรวบรวมข้อมูลและการจัดทำดัชนีอย่างต่อเนื่องยังทำให้อัตราการโหลดหน้าเว็บช้าลงอีกด้วย

ความเร็วของเว็บเป็นส่วนสำคัญของเว็บไซต์ ซึ่งส่งผลต่อคุณภาพและประสบการณ์ของผู้ใช้เมื่อเข้าชมเว็บไซต์ของคุณ หน้าก็สูงขึ้นด้วย

ด้วยเหตุผลเหล่านี้ คุณควรสร้างไฟล์ทางเทคนิคประเภทนี้สำหรับ WordPress เพื่อสั่งบอท: “บอทสแกนด้านใดด้านหนึ่ง อย่าสแกนอีกด้านหนึ่ง!” การใช้ไฟล์ robots.txt มาตรฐานของ WordPress ช่วยเพิ่มและประสิทธิภาพของการรวบรวมข้อมูลเว็บไซต์และดัชนีของบอท จากนั้น ปรับปรุงผลลัพธ์ SEO สำหรับเว็บไซต์ของคุณ

จำเป็นต้องมีไฟล์นี้สำหรับเว็บไซต์ WordPress ของคุณหรือไม่?

หากคุณไม่ได้ใช้แผนผังเว็บไซต์ คุณจะยังคงย่ำยีและจัดอันดับเว็บไซต์ของคุณ อย่างไรก็ตาม เสิร์ชเอ็นจิ้นไม่สามารถบอกได้ว่าเพจหรือโฟลเดอร์ใดไม่ควรเรียกใช้

เมื่อคุณเริ่มบล็อก นั้นไม่สำคัญมากนัก อย่างไรก็ตาม คุณสามารถควบคุมได้มากขึ้นว่าไซต์ของคุณมีการกระเพื่อมและจัดทำดัชนีอย่างไรเมื่อไซต์ของคุณเติบโตขึ้น และคุณมีเนื้อหามากมาย

บอทการค้นหามีโควต้าการรวบรวมข้อมูลต่อเว็บไซต์ ซึ่งหมายความว่าจะรวบรวมข้อมูลบางหน้าระหว่างเซสชันการรวบรวมข้อมูล หาก ยังทำไม่เสร็จ ทุกหน้าในเว็บไซต์ของคุณ พวกเขาจะมาและรวบรวมข้อมูลอีกครั้งในเซสชันถัดไป พวกเขา ยังคงอยู่ที่นั่นและไม่หายไป

ซึ่งอาจลดความเร็วการจัดทำดัชนีของเว็บไซต์ของคุณ แต่คุณสามารถแก้ไขได้โดยไม่อนุญาตให้บอทค้นหาพยายามรวบรวมข้อมูลหน้าที่ไม่จำเป็น เช่น หน้าผู้ดูแลระบบ wp-admin ไดเรกทอรีปลั๊กอิน และไดเรกทอรีของธีม

คุณสามารถบันทึกโควต้าการรวบรวมข้อมูลได้ด้วยการปฏิเสธหน้าที่ไม่จำเป็น ซึ่งช่วยให้เสิร์ชเอ็นจิ้นสามารถสะดุดและจัดทำดัชนีหน้าเว็บไซต์ของคุณได้รวดเร็วยิ่งขึ้น

อีกเหตุผลหนึ่งที่ดีในการใช้ไฟล์ robots.txt คือการป้องกันไม่ให้เครื่องมือค้นหาสร้างดัชนีบทความหรือหน้า นี่ไม่ใช่วิธีที่ปลอดภัยที่สุดในการซ่อนเนื้อหาเครื่องมือค้นหา แต่ช่วยป้องกันผลการค้นหา

แนวทางที่สมบูรณ์แบบในการเพิ่มประสิทธิภาพ Robots.txt สำหรับเนื้อหา SEO

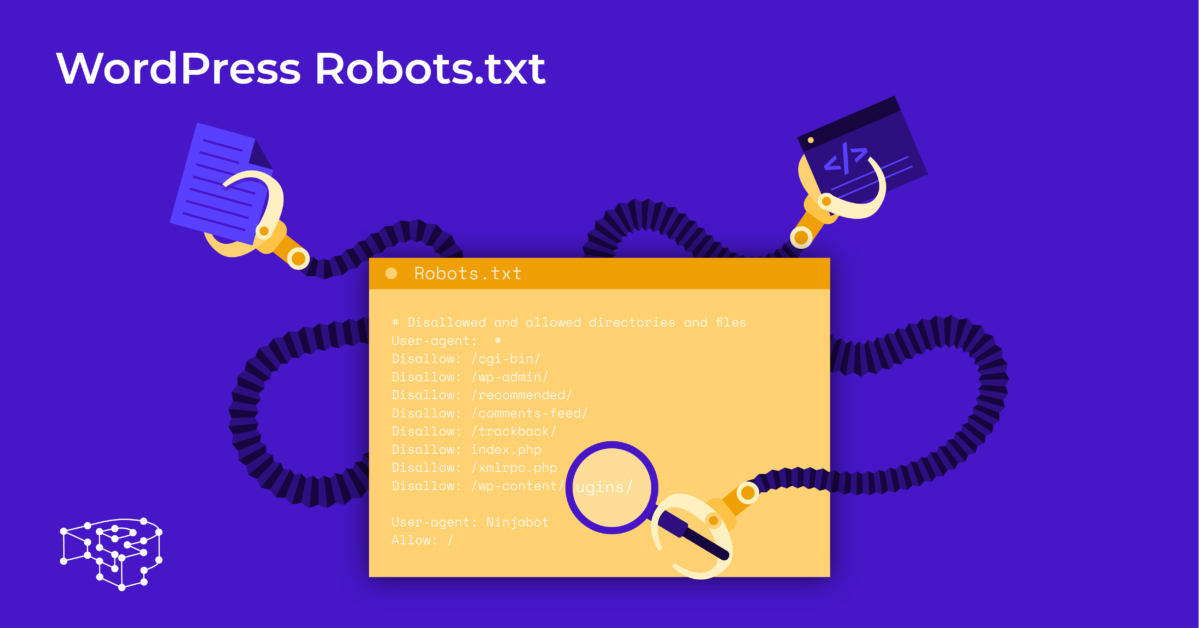

ไซต์บล็อกหลายแห่งเลือกที่จะเรียกใช้ไฟล์ robots.txt ที่เจียมเนื้อเจียมตัวมากบนเว็บ WordPress ของตน เนื้อหาอาจแตกต่างกันไปขึ้นอยู่กับความต้องการของเว็บไซต์โดยเฉพาะ:

ตัวแทนผู้ใช้: *

ไม่อนุญาต:

แผนผังเว็บไซต์: http://www.example.com/post-sitemap.xml

แผนผังเว็บไซต์: http://www.example.com/page-sitemap.xml

ไฟล์ robots.txt นี้ทำให้บ็อตทั้งหมดเชื่อมต่อกับแผนผังเว็บไซต์ XML เพื่อระบุเนื้อหาทั้งหมด

เราขอแนะนำแนวทางต่อไปนี้สำหรับไฟล์ที่มีประโยชน์บางอย่างสำหรับเว็บไซต์ WordPress:

ตัวแทนผู้ใช้: *

อนุญาต: /wp-content/uploads/

ไม่อนุญาต: /wp-content/plugins/

ไม่อนุญาต: /wp-admin/

ไม่อนุญาต: /readme.html

ไม่อนุญาต: /อ้างอิง/

แผนผังเว็บไซต์: http://www.example.com/post-sitemap.xml

แผนผังเว็บไซต์: http://www.example.com/page-sitemap.xml

รูปภาพและไฟล์ทั้งหมดของ WordPress ได้รับการจัดทำดัชนี บอทการค้นหาสามารถสร้างดัชนีไฟล์ปลั๊กอิน พื้นที่ผู้ดูแลระบบ ไฟล์ readme และลิงค์พันธมิตร

คุณยังสามารถให้ Google Bots ค้นหาหน้าทั้งหมดบนเว็บไซต์ของคุณได้อย่างง่ายดายด้วยการเพิ่มแผนที่ลงในไฟล์ robots.txt

การสร้างไฟล์ WordPress robots.txt สำหรับเว็บไซต์ของคุณ

สร้างไฟล์ robots.txt โดยใช้ Notepad

Notepad เป็นโปรแกรมแก้ไขข้อความขั้นต่ำจาก Microsoft . ใช้ สำหรับเขียนโค้ดที่ให้บริการ Pascal, C +, ภาษาโปรแกรม HTML, ...

ไฟล์ข้อความ ASCII หรือ UTF-8 บันทึกอย่างถูกต้องในไฟล์ต้นฉบับของเว็บไซต์โดยใช้ชื่อ “robots.txt” สำหรับ WordPress robots.txt แต่ละไฟล์มีกฎมากมายและแต่ละกฎอยู่ในบรรทัดเดียว

คุณสามารถสร้างไฟล์แผ่นจดบันทึกใหม่ บันทึกเป็น robots.txt และเพิ่มกฎตามคำแนะนำด้านบน

หลังจากนั้นการอัพโหลดไฟล์สำหรับ WordPress ไปยัง ไดเร็กทอรี public_html เสร็จสมบูรณ์

สร้างไฟล์ robots.txt โดยใช้ปลั๊กอิน Yoast SEO

ปลั๊กอิน Yoast SEO เป็นหนึ่งในปลั๊กอินที่ได้รับคะแนนสูงสุดเพื่อช่วยคุณในการเพิ่มประสิทธิภาพ SEO ของเว็บไซต์ของคุณในแง่ของเนื้อหา อย่างไรก็ตาม Yoast SEO อาจถูกมองว่าเป็นปลั๊กอิน WordPress ของ robots.txt ที่ช่วยให้คุณสร้างไฟล์ที่เป็นนวัตกรรมใหม่สำหรับการเพิ่มประสิทธิภาพเว็บไซต์ของคุณ

ขั้นแรก คุณไปที่ แดชบอร์ด

ใน Dashboard => Select ในหน้าผู้ดูแลระบบ Yoast SEO => เลือก File Editor

เลือก สร้างใหม่ เพื่อเริ่มต้นไฟล์สำหรับ WordPress หรือแก้ไขไฟล์ที่มีอยู่

เลือก บันทึกการเปลี่ยนแปลง ไปยัง robots.txt เพื่อยืนยันว่าไฟล์ robots.txt ที่กำหนดเองเสร็จสมบูรณ์

เยี่ยมชมเว็บไซต์อีกครั้งและคุณจะเห็นกฎใหม่ที่คุณเพิ่งติดตั้ง

ตรวจสอบไฟล์ robots.txt บน Google Search Console

คุณสามารถเข้าสู่ระบบ Google Search Console และลงทะเบียนคุณสมบัติเว็บไซต์ของคุณเพื่อ เริ่มต้น

เลือก ไปที่เวอร์ชันเก่า เพื่อกลับไปที่อินเทอร์เฟซเก่าและเปิดใช้งานการใช้งาน

ใต้ Crawl => Select ตรวจสอบผลลัพธ์ของจำนวน ข้อผิดพลาดและคำเตือน => ทำการแก้ไข หากมี

เลือก ดาวน์โหลดโค้ดที่อัปเดต เพื่อดาวน์โหลด robots.txt ใหม่และอัปโหลดไฟล์ใหม่ไปยังไดเร็กทอรีเดิมหรือเลือก ความคิด สุดท้าย

จากบทความนี้ คุณได้เรียนรู้ถึงความสำคัญและวิธีการตั้งค่าไฟล์ robots.txt สำหรับ WordPress การเป็นเจ้าของไฟล์ robots.txt มาตรฐานจะช่วยให้เว็บไซต์และบอทของเครื่องมือค้นหาโต้ตอบกันได้ดีขึ้น ดังนั้นข้อมูลของเว็บไซต์จะได้รับการอัปเดตอย่างถูกต้องและเพิ่มความสามารถในการเข้าถึงผู้ใช้มากขึ้น

เริ่มต้นด้วยการสร้างไฟล์ทางเทคนิคของคุณเองสำหรับ WordPress และปรับปรุง SEO ของเว็บไซต์ทันที!

อ่านเพิ่มเติม: 10 ปลั๊กอินสำรอง WP ฟรีที่ดีที่สุดสำหรับการปกป้อง WordPress