O guia completo para otimizar WordPress Robots.txt para SEO

Publicados: 2021-03-11Para que seu site seja indexado rapidamente, otimize para SEO e melhore as classificações na página de resultados de pesquisa do SERP, em primeiro lugar, você precisa criar um arquivo técnico robots.txt para WordPress. O arquivo Robots.txt ilustra como verificar e configurar seu site de índice, especialmente, tornando-o uma ferramenta de SEO extremamente poderosa. Portanto, vamos sugerir o guia completo para aprimorar o robots.txt do WordPress para SEO neste artigo.

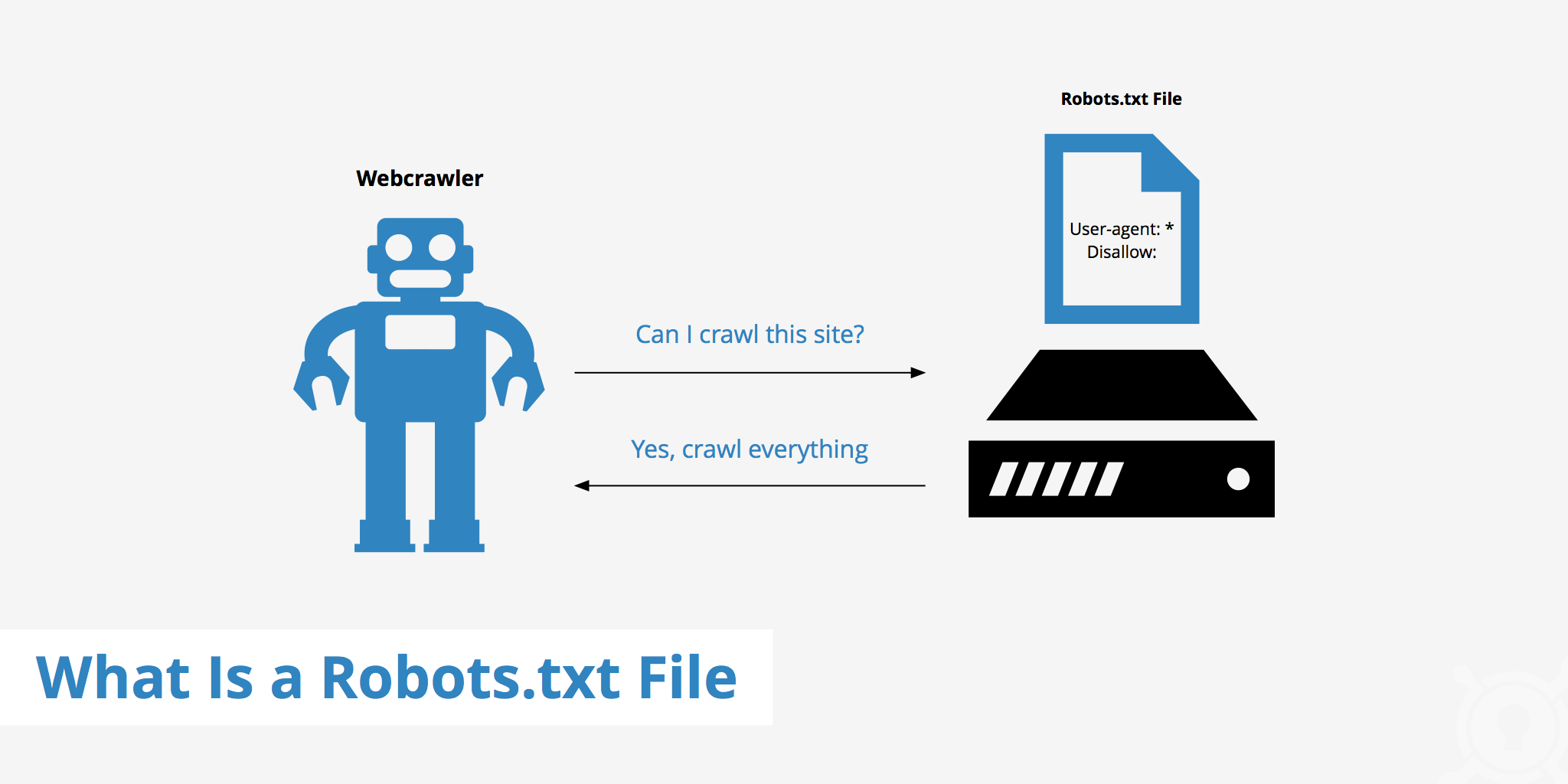

O que é WordPress Robots.txt?

Este é o arquivo de texto na pasta raiz de um site da Web e fornece instruções sobre o mecanismo de pesquisa para quais páginas podem ser indexadas.

Se você já descobriu o processo de trabalho dos mecanismos de pesquisa anteriormente, saberá que, durante a fase de rastreamento e indexação, os navegadores da web tentam encontrar páginas disponíveis publicamente na web, que podem incluir em seu índice.

A primeira coisa que um navegador da web opera quando visita um site é localizar e verificar o conteúdo do arquivo robots.txt. Dependendo das regras especificadas no arquivo, eles geram uma lista de URLs que podem ser rastreados e indexados especificamente para o site.

Por que você precisa construir um arquivo robots.txt do WordPress?

Existem muitos casos em que os robôs do mecanismo de pesquisa de "escanear" seu site são impedidos ou restringidos:

O conteúdo é nulo e duplicado

Na verdade, em seu site, ele exibe muitas outras informações, como arquivos de configuração do sistema, plug-ins do WordPress, etc.

Esta informação não é valiosa para o usuário. Além disso, existem várias situações em que o conteúdo do site é duplicado. Se o conteúdo ainda estiver indexado, isso diluirá o site, reduzindo a qualidade real do conteúdo do site.

Subpáginas para configurar e testar o site

Neste caso, talvez ao criar um novo site por WordPress, você não tenha concluído o processo de concepção e configuração do site, geralmente não está pronto para o usuário, você precisa tomar medidas para evitar que os bots de mecanismos de pesquisa “escaneiem” e validem seus local na rede Internet.

Além disso, alguns sites também possuem muitas subpáginas que são usadas apenas para testar os recursos e o design do site. Permitir que os usuários acessem esses sites afetará a qualidade do site e o profissionalismo de sua empresa.

O site de grande capacidade leva muito tempo para carregar

Cada robô de mecanismo de pesquisa tem apenas uma capacidade limitada de “varredura” por visita ao site. Quando o seu site possui uma grande quantidade de conteúdo, os bots terão que levar mais tempo para analisar porque se ele operou o suficiente para uma visita, o restante do conteúdo do site deve esperar até a próxima vez que os bots girarem. pode ser rastreado e indexado novamente.

Se o seu site ainda tiver arquivos e conteúdo desnecessários, mas for indexado primeiro, isso não apenas reduzirá a qualidade do site, mas também gastará mais tempo indexando os bots.

Reduz a velocidade da web ao indexar constantemente

Quando não há arquivo robots.txt, os bots ainda irão verificar todo o conteúdo do seu site. Além de mostrar o conteúdo que seus clientes não desejam ver, o rastreamento e a indexação constantes também podem diminuir a taxa de carregamento da página.

A velocidade da Web é um aspecto significativamente vital do site, influenciando a qualidade e a experiência do usuário quando ele o visita. a página também é mais alta.

Por essas razões, você deve construir este tipo de arquivo técnico para WordPress para instruir os bots: “Os bots escaneiam um lado, não escaneiam o outro!”. O uso do arquivo robots.txt padrão do WordPress ajuda a aumentar e a eficiência do rastreamento e índice de sites de bots. A partir daí, melhore os resultados de SEO do seu site.

É necessário ter este arquivo para o seu site WordPress?

Se não estiver usando um mapa do site, você ainda avançará e classificará o seu site. Os motores de busca não podem, entretanto, dizer quais páginas ou pastas não devem ser executadas.

Quando você começa um blog, isso não importa muito. No entanto, você pode desejar mais controle sobre como seu site é propagado e indexado conforme ele cresce e você tem muito conteúdo.

O bot de pesquisa tem uma cota de rastreamento por site. Isso significa que eles rastreiam certas páginas durante uma sessão de rastreamento. Se eles não terminaram todas as páginas do seu site, eles estão vindo e rastejando novamente na próxima sessão. Eles ainda estão lá e não desaparecem.

Isso pode reduzir a velocidade de indexação do seu site. Mas você pode corrigir isso impedindo que os robôs de pesquisa tentem rastrear páginas desnecessárias, como a página de administração wp-admin, o diretório de plug-ins e o diretório de temas.

Ao rejeitar páginas desnecessárias, você pode salvar sua cota de rastreamento. Isso permite que os mecanismos de pesquisa tropecem e indexem mais rapidamente as páginas do seu site.

Outro bom motivo para usar os arquivos robots.txt é evitar que os mecanismos de pesquisa indexem postagens ou páginas. Essa não é a maneira mais segura de ocultar o conteúdo do mecanismo de pesquisa, mas ajuda a evitar os resultados da pesquisa.

A diretriz perfeita para otimizar Robots.txt para o conteúdo de SEO

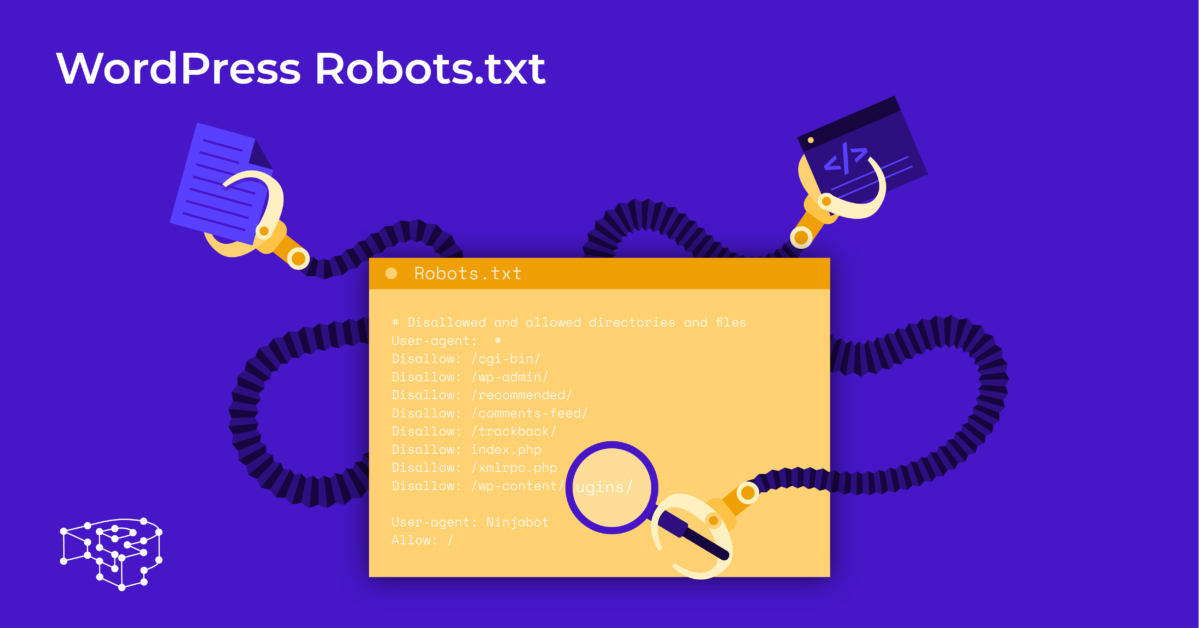

Muitos sites de blog optam por executar um arquivo robots.txt muito modesto em sua web WordPress. Seu conteúdo pode variar, dependendo das necessidades do site específico:

Agente de usuário: *

Disallow:

Mapa do site: http://www.example.com/post-sitemap.xml

Mapa do site: http://www.example.com/page-sitemap.xml

Este arquivo robots.txt dá a todos os bots uma conexão com o mapa do site XML para indicar todo o conteúdo.

Recomendamos as seguintes diretrizes de alguns arquivos úteis para sites WordPress:

Agente de usuário: *

Permitir: / wp-content / uploads /

Disallow: / wp-content / plugins /

Disallow: / wp-admin /

Disallow: /readme.html

Disallow: / refer /

Mapa do site: http://www.example.com/post-sitemap.xml

Mapa do site: http://www.example.com/page-sitemap.xml

Todas as fotos e arquivos do WordPress são indexados. Os bots de pesquisa podem até mesmo indexar arquivos de plug-ins, área de administração, arquivos leia-me e links de afiliados.

Você também pode permitir que o Google Bots encontre facilmente todas as páginas do seu site adicionando um mapa ao arquivo robots.txt.

Criação de um arquivo robots.txt do WordPress para o seu site

Crie o arquivo robots.txt usando o Notepad

O Bloco de notas é um editor de texto mínimo da Microsoft . É para escrever código servindo Pascal, C +, linguagem de programação HTML, ...

Um arquivo de texto, ASCII ou UTF-8, salvo corretamente no arquivo de origem do site com o nome “robots.txt”, é necessário para o arquivo robots.txt do WordPress. Cada arquivo contém muitas regras e cada regra está em uma linha.

Você pode gerar um novo arquivo de bloco de notas, salvá-lo como robots.txt e adicionar as regras conforme as instruções acima.

Depois disso, o upload do arquivo para WordPress no diretório public_html está completo.

Crie o arquivo robots.txt usando o plugin Yoast SEO

O plugin Yoast SEO está entre os plugins mais bem avaliados para ajudá-lo a otimizar o SEO do seu site em termos de conteúdo. Porém, Yoast SEO também pode ser visto como um plugin para WordPress de robots.txt que ajuda você a criar um arquivo inovador para otimização de seus sites.

Primeiro, você vai para o Dashboard.

No Dashboard => Select Na página de administração do Yoast SEO => Escolha o Editor de Arquivo.

Selecione Criar novo para iniciar o arquivo para WordPress ou editar um arquivo existente.

Selecione Salvar alterações em robots.txt para confirmar se o arquivo robots.txt personalizado está completo.

Visite o site novamente e você verá as novas regras que acabou de instalar.

Verifique o arquivo robots.txt no Google Search Console

Você pode fazer login no Google Search Console e registrar a propriedade do seu site para começar.

Selecione Ir para a versão antiga para retornar à interface antiga e habilitar o uso.

Em Crawl => Select Verifique o resultado do número de Erros e Avisos => Execute a correção, se houver.

Selecione Baixar código atualizado para baixar o novo robots.txt e reenviar o novo arquivo para o diretório original ou selecione Considerações Finais

Por meio deste artigo, você aprendeu a importância e também a maneira de configurar um arquivo robots.txt para WordPress. Possuir um arquivo robots.txt padrão ajudará seu site e os bots de mecanismos de pesquisa a interagir melhor, de modo que as informações do site sejam atualizadas com precisão e aumentem a capacidade de alcançar mais usuários.

Vamos começar criando seu próprio arquivo técnico para WordPress e melhorando o SEO do site imediatamente!

Leia mais: 10 melhores plug-ins de backup WP gratuitos para proteger o WordPress