La guida completa all'ottimizzazione di WordPress Robots.txt per SEO

Pubblicato: 2021-03-11Affinché il tuo sito Web possa essere indicizzato rapidamente, ottimizzato per la SEO e migliorare il posizionamento nella pagina dei risultati di ricerca SERP, per prima cosa devi creare un file tecnico robots.txt per WordPress. Il file Robots.txt illustra come scansionare e configurare il tuo sito indice, in particolare, rendendolo uno strumento SEO estremamente potente. Quindi, suggeriremo la guida completa per migliorare WordPress robots.txt per la SEO in questo articolo.

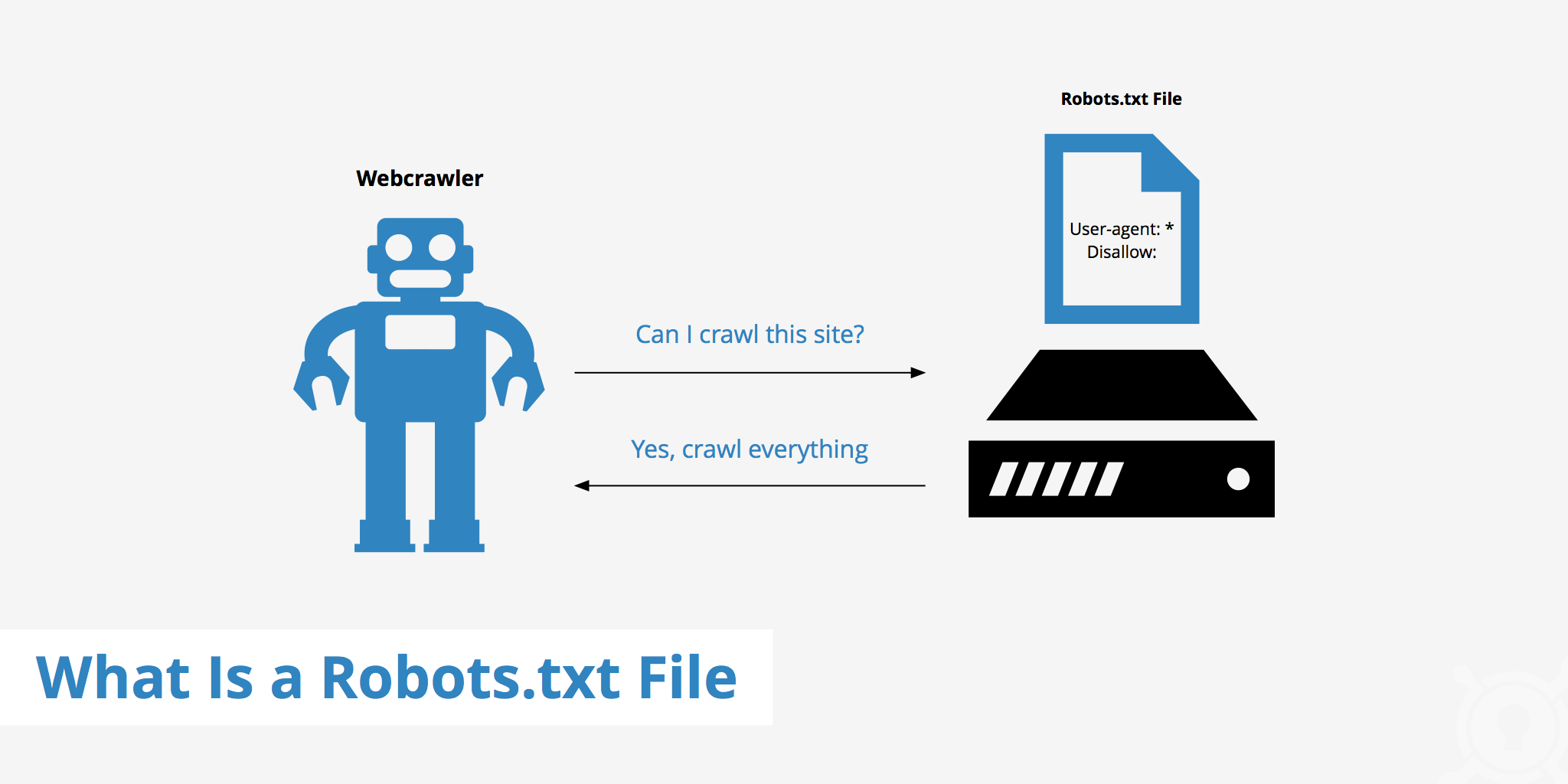

Che cos'è WordPress Robots.txt?

Questo è il file di testo nella cartella principale di un sito Web e fornisce istruzioni sul motore di ricerca per le pagine che possono essere indicizzate.

Se hai scoperto in precedenza il processo di funzionamento dei motori di ricerca, saprai che durante la fase di scansione e indicizzazione, i browser Web tentano di trovare pagine disponibili pubblicamente sul Web, che possono includere nel loro indice.

La prima cosa che un browser web opera quando visita un sito web è trovare e controllare il contenuto del file robots.txt. A seconda delle regole specificate nel file, generano un elenco di URL che possono essere scansionati e quindi indicizzati in modo specifico per il sito.

Perché devi creare un file WordPress robots.txt?

Ci sono molti casi in cui i bot dei motori di ricerca che "scansionano" il tuo sito web sono impediti o limitati:

Il contenuto è nullo e duplicato

Infatti, sul tuo sito web, mostra molte altre informazioni, come i file di configurazione del sistema, i plugin di WordPress, ecc.

Queste informazioni non sono preziose per l'utente. Inoltre, ci sono diverse situazioni in cui il contenuto del sito Web è duplicato. Se il contenuto è ancora indicizzato, diluirà il sito Web, riducendo l'effettiva qualità del contenuto del sito Web.

Sottopagine per configurare e testare il sito web

In questo caso, forse durante la creazione di un nuovo sito Web da WordPress, non hai completato il processo di progettazione e configurazione del sito Web, generalmente non pronto per l'utente, è necessario adottare misure per evitare che i bot dei motori di ricerca "scansionino" e convalidano il loro sito web.

Non solo, ma alcuni siti Web hanno anche molte sottopagine che vengono utilizzate solo per testare le funzionalità e il design del sito Web, consentendo agli utenti di accedere a tali siti influirà sulla qualità del sito Web e sulla professionalità della tua azienda.

Il sito Web di grande capacità richiede molto tempo di caricamento

Ogni bot dei motori di ricerca ha solo una capacità di "scansione" limitata per visita al sito web. Quando il tuo sito Web ha una grande quantità di contenuti, i bot dovranno impiegare più tempo per l'analisi perché se ha funzionato abbastanza per una visita, il contenuto rimanente sul sito Web deve attendere fino alla successiva rotazione dei bot. possono essere scansionati e indicizzati di nuovo.

Se il tuo sito Web ha ancora file e contenuti non necessari ma viene indicizzato per primo, non solo ridurrà la qualità del sito Web, ma impiegherà anche più tempo a indicizzare i bot.

Riduce la velocità del web durante l'indicizzazione costante

Quando non è presente alcun file robots.txt, i bot eseguiranno comunque la scansione dell'intero contenuto del tuo sito web. Oltre a mostrare contenuti che i tuoi clienti non vogliono vedere, la scansione e l'indicizzazione costanti possono anche rallentare la velocità di caricamento della pagina.

La velocità del Web è un aspetto significativamente vitale del sito Web, che influenza la qualità e l'esperienza dell'utente quando visita il tuo sito Web. la pagina è anche più alta.

Per questi motivi, dovresti creare questo tipo di file tecnico per WordPress per istruire i bot: "I bot scansionano un lato, non scansionare l'altro!". L'uso del file robots.txt standard di WordPress aiuta ad aumentare e l'efficienza della scansione e dell'indicizzazione del sito web dei bot. Da lì, migliora i risultati SEO per il tuo sito web.

È necessario avere questo file per il tuo sito WordPress?

Se non stai utilizzando una mappa del sito, continuerai a arrancare e classificare il tuo sito web. I motori di ricerca, tuttavia, non possono dire quali pagine o cartelle non dovrebbero essere eseguite.

Quando apri un blog, non importa molto. Tuttavia, puoi desiderare un maggiore controllo su come il tuo sito viene increspato e indicizzato man mano che il tuo sito cresce e hai molti contenuti.

Il bot di ricerca ha una quota di scansione per sito web. Ciò significa che scansionano determinate pagine durante una sessione di scansione. Se non hanno terminato tutte le pagine del tuo sito web, torneranno e effettueranno la scansione di nuovo nella sessione successiva. Sono ancora lì e non scompaiono.

Ciò potrebbe ridurre la velocità di indicizzazione del tuo sito web. Ma puoi risolvere questo problema impedendo ai bot di ricerca di provare a eseguire la scansione di pagine non necessarie come la pagina di amministrazione di wp-admin, la directory dei plug-in e la directory dei temi.

Rifiutando le pagine non necessarie, puoi salvare la quota di scansione. Ciò consente ai motori di ricerca di inciampare e indicizzare più rapidamente le pagine del tuo sito web.

Un altro buon motivo per utilizzare i file robots.txt è impedire ai motori di ricerca di indicizzare post o pagine. Questo non è il modo più sicuro per nascondere il contenuto del motore di ricerca, ma aiuta a prevenire i risultati della ricerca.

La linea guida perfetta per ottimizzare Robots.txt per i contenuti SEO

Molti siti di blog scelgono di eseguire un file robots.txt molto modesto sul proprio sito Web WordPress. Il loro contenuto può variare, a seconda delle esigenze del sito Web specifico:

Agente utente: *

Non consentire:

Mappa del sito: http://www.example.com/post-sitemap.xml

Mappa del sito: http://www.example.com/page-sitemap.xml

Questo file robots.txt fornisce a tutti i bot una connessione alla mappa del sito XML per indicare tutto il contenuto.

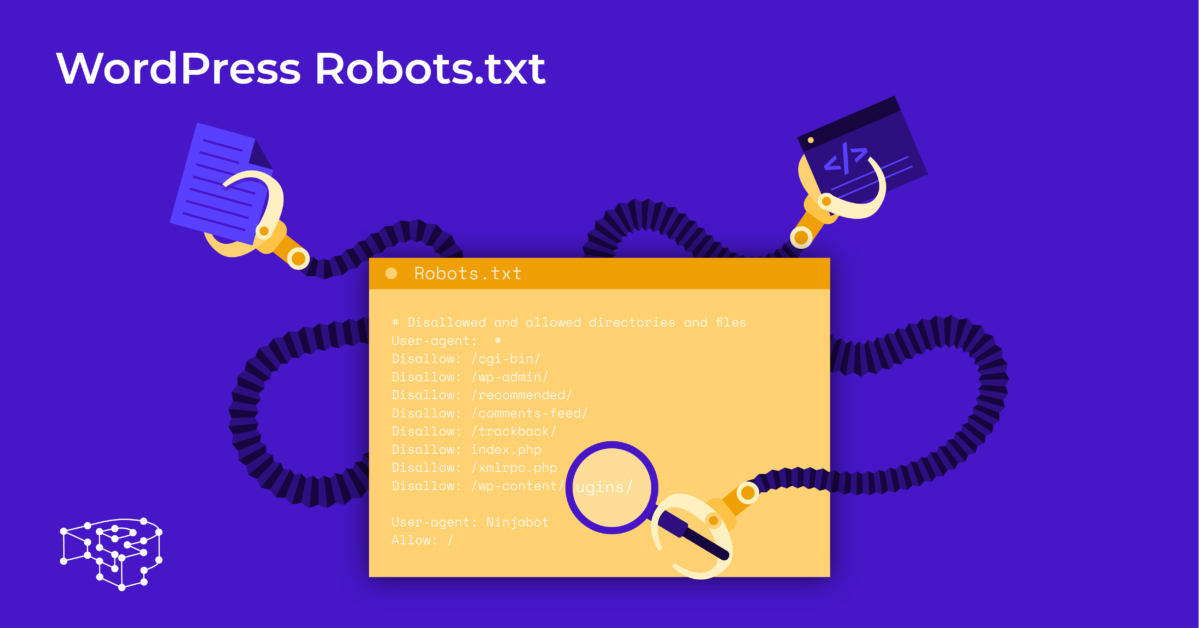

Consigliamo le seguenti linee guida di alcuni file utili per i siti Web WordPress:

Agente utente: *

Consenti: /wp-content/uploads/

Non consentire: /wp-content/plugins/

Non consentire: /wp-admin/

Non consentire: /readme.html

Non consentire: /refer/

Mappa del sito: http://www.example.com/post-sitemap.xml

Mappa del sito: http://www.example.com/page-sitemap.xml

Tutte le immagini e i file di WordPress sono indicizzati. I bot di ricerca possono persino indicizzare i file dei plug-in, l'area di amministrazione, i file readme e i link di affiliazione.

Puoi anche consentire a Google Bot di trovare facilmente tutte le pagine del tuo sito web aggiungendo una mappa al file robots.txt.

Creazione di un file WordPress robots.txt per il tuo sito web

Crea file robots.txt usando Blocco note

Blocco note è un editor di testo minimo di Microsoft . Serve per scrivere codice che serve Pascal, C +, linguaggio di programmazione HTML, ...

Per WordPress robots.txt è necessario un file di testo, ASCII o UTF-8, salvato correttamente nel file sorgente del sito Web con il nome "robots.txt". Ogni file contiene molte regole e ogni regola è su una riga.

Puoi generare un nuovo file di blocco note, salvarlo come robots.txt e aggiungere le regole come indicato sopra.

Successivamente, il caricamento del file per WordPress nella directory public_html è completo.

Crea file robots.txt usando il plugin Yoast SEO

Il plug-in Yoast SEO è tra i plug-in più votati per aiutarti a ottimizzare la SEO del tuo sito web in termini di contenuto. Tuttavia, Yoast SEO può anche essere visto come un plugin WordPress robots.txt che ti aiuta a creare un file innovativo per l'ottimizzazione dei tuoi siti.

Per prima cosa, vai su Dashboard.

In Dashboard => Seleziona Nella pagina di amministrazione di Yoast SEO => Scegli Editor di file.

Seleziona Crea nuovo per avviare il file per WordPress o modificare un file esistente.

Seleziona Salva modifiche in robots.txt per confermare che il file robots.txt personalizzato è completo.

Visita di nuovo il sito Web e vedrai le nuove regole che hai appena installato.

Controlla il file robots.txt su Google Search Console

Puoi accedere a Google Search Console e registrare la proprietà del tuo sito web per iniziare.

Selezionare Vai alla versione precedente per tornare alla vecchia interfaccia e abilitare l'utilizzo.

Sotto Scansione => Seleziona Controllare il risultato del numero di Errori e Avvisi => Eseguire la correzione se presente.

Seleziona Scarica codice aggiornato per scaricare il nuovo robots.txt e ricaricare il nuovo file nella directory originale o seleziona Considerazioni finali

Attraverso questo articolo, hai imparato l'importanza e il modo di impostare un file robots.txt per WordPress. Possedere un file robots.txt standard aiuterà il tuo sito Web e i bot dei motori di ricerca a interagire meglio, quindi le informazioni del sito verranno aggiornate in modo accurato e aumenterà la capacità di raggiungere più utenti.

Iniziamo creando il tuo file tecnico per WordPress e migliorando subito la SEO del sito!

Leggi di più: 10 migliori plugin gratuiti per il backup di WP per la protezione di WordPress