La guía completa para optimizar WordPress Robots.txt para SEO

Publicado: 2021-03-11Para que su sitio web se indexe rápidamente, optimice para SEO y mejore la clasificación en la página de resultados de búsqueda SERP, lo primero es lo primero, debe crear un archivo robots.txt técnico para WordPress. El archivo Robots.txt ilustra cómo escanear y configurar su sitio de índice, especialmente, lo que lo convierte en una herramienta de SEO extremadamente poderosa. Por lo tanto, sugeriremos la guía completa para mejorar el archivo robots.txt de WordPress para SEO en este artículo.

¿Qué es WordPress Robots.txt?

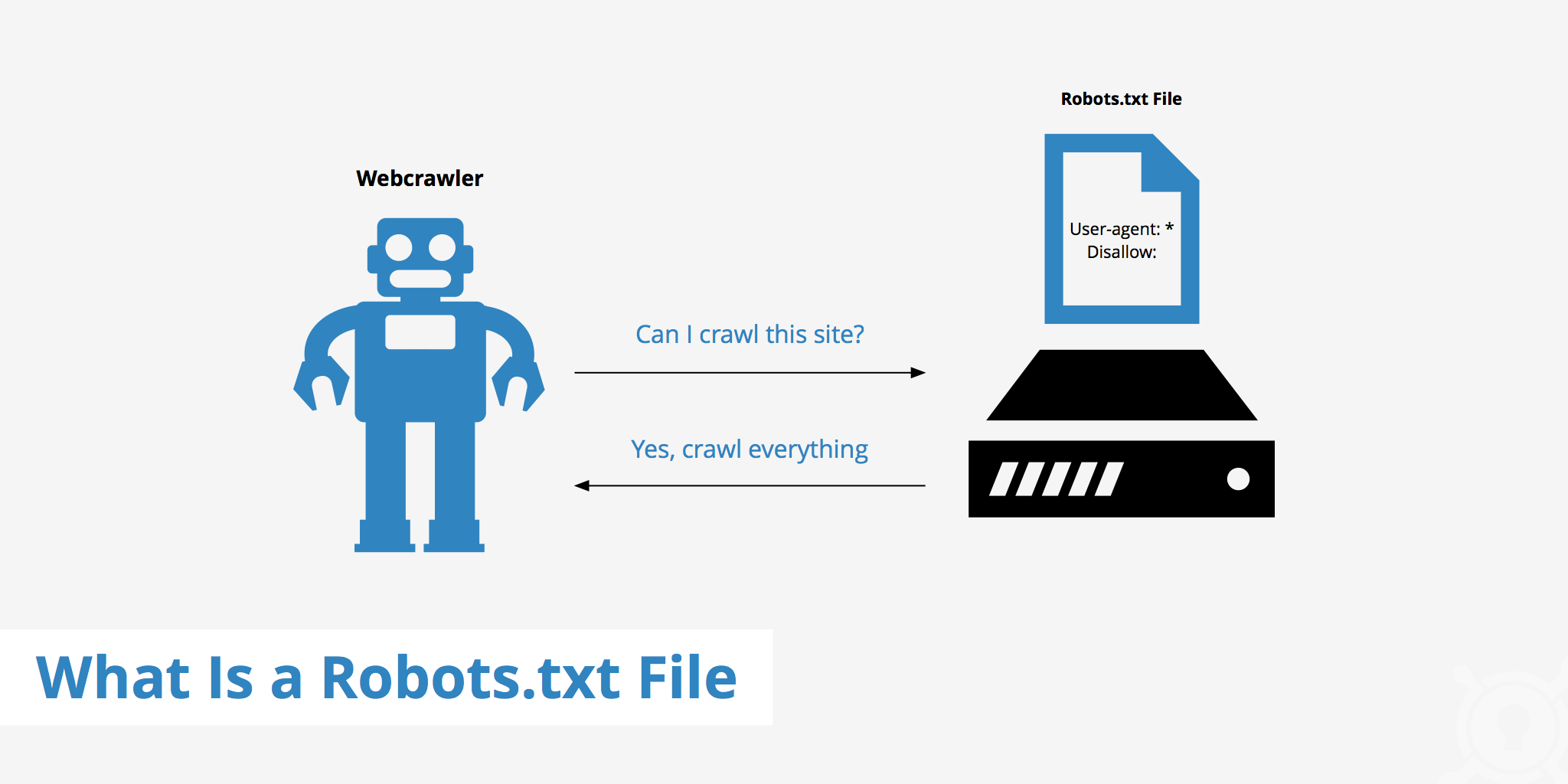

Este es el archivo de texto en la carpeta raíz de un sitio web y proporciona instrucciones en el motor de búsqueda para saber qué páginas se pueden indexar.

Si ha descubierto anteriormente el proceso de trabajo de los motores de búsqueda, sabrá que durante la fase de rastreo e indexación, los navegadores web intentan encontrar páginas disponibles públicamente en la web, que pueden incluir en su índice.

Lo primero que hace un navegador web cuando visita un sitio web es buscar y comprobar el contenido del archivo robots.txt. Dependiendo de las reglas especificadas en el archivo, generan una lista de URL que se pueden rastrear y luego indexar específicamente para el sitio.

¿Por qué tienes que construir un archivo robots.txt de WordPress?

Hay muchos casos en los que los robots de los motores de búsqueda "escanean" su sitio web se evitan o restringen:

El contenido es nulo y duplicado.

De hecho, en su sitio web, muestra mucha otra información, como archivos de configuración del sistema, complementos de WordPress, etc.

Esta información no es valiosa para el usuario. Además, hay varias situaciones en las que se duplica el contenido del sitio web. Si el contenido aún está indexado, diluirá el sitio web, reduciendo la calidad del contenido real del sitio web.

Subpáginas para configurar y probar el sitio web

En este caso, tal vez al crear un nuevo sitio web con WordPress, no haya completado el proceso de diseño y configuración del sitio web, generalmente no está listo para el usuario, debe tomar medidas para evitar que los robots de los motores de búsqueda "escaneen" y validen su sitio web.

No solo eso, algunos sitios web también tienen muchas subpáginas que solo se utilizan para probar las características y el diseño del sitio web, por lo que permitir que los usuarios accedan a dichos sitios afectará la calidad del sitio web y la profesionalidad de su empresa.

El sitio web de gran capacidad tarda mucho en cargarse

Cada bot de motor de búsqueda solo tiene una capacidad de "escaneo" limitada por visita al sitio web. Cuando su sitio web tiene una gran cantidad de contenido, los bots tendrán que tomarse más tiempo para analizar porque si ha funcionado lo suficiente para una visita, el contenido restante en el sitio web debe esperar hasta la próxima vez que los bots giren. se puede rastrear e indexar de nuevo.

Si su sitio web todavía tiene archivos y contenido innecesarios, pero se indexa primero, no solo reducirá la calidad del sitio web, sino que también dedicará más tiempo a indexar los bots.

Reduce la velocidad de la web cuando se indexa constantemente

Cuando no hay un archivo robots.txt, los bots seguirán escaneando todo el contenido de su sitio web. Además de mostrar contenido que sus clientes no quieren ver, el rastreo y la indexación constantes también pueden ralentizar la velocidad de carga de la página.

La velocidad web es un aspecto significativamente vital del sitio web, que influye en la calidad y la experiencia del usuario cuando visitan su sitio web. la página también es más alta.

Por estas razones, debería crear este tipo de archivo técnico para que WordPress instruya a los bots: “¡Los bots escanean un lado, no escaneen el otro!”. El uso del archivo robots.txt estándar de WordPress ayuda a aumentar la eficiencia del rastreo y el índice de sitios web de los bots. A partir de ahí, mejore los resultados de SEO para su sitio web.

¿Es necesario tener este archivo para su sitio web de WordPress?

Si no está utilizando un mapa del sitio, seguirá avanzando y clasificará su sitio web. Sin embargo, los motores de búsqueda no pueden decir qué páginas o carpetas no deberían querer ejecutarse.

Cuando comienzas un blog, eso no importa mucho. Sin embargo, puede querer tener más control sobre cómo su sitio se divide e indexa a medida que su sitio crece y tiene mucho contenido.

El robot de búsqueda tiene una cuota de rastreo por sitio web. Esto significa que rastrean determinadas páginas durante una sesión de rastreo. Si no han terminado todas las páginas de su sitio web, volverán a aparecer y volverán a rastrear en la próxima sesión. Siguen ahí y no desaparecen.

Esto puede reducir la velocidad de indexación de su sitio web. Pero puede solucionar esto impidiendo que los robots de búsqueda intenten rastrear páginas innecesarias como la página de administración de wp-admin, el directorio de complementos y el directorio de temas.

Al rechazar páginas innecesarias, puede guardar su cuota de rastreo. Esto permite que los motores de búsqueda tropiecen e indexen más rápidamente las páginas de su sitio web.

Otra buena razón para utilizar archivos robots.txt es evitar que los motores de búsqueda indexen publicaciones o páginas. Esta no es la forma más segura de ocultar el contenido del motor de búsqueda, pero ayuda a evitar resultados de búsqueda.

La guía perfecta para optimizar Robots.txt para el contenido SEO

Muchos sitios de blogs optan por ejecutar un archivo robots.txt muy modesto en su web de WordPress. Su contenido puede variar, dependiendo de las necesidades del sitio web en particular:

Agente de usuario: *

Rechazar:

Mapa del sitio: http://www.example.com/post-sitemap.xml

Mapa del sitio: http://www.example.com/page-sitemap.xml

Este archivo robots.txt imparte a todos los bots una conexión con el mapa del sitio XML para indicar todo el contenido.

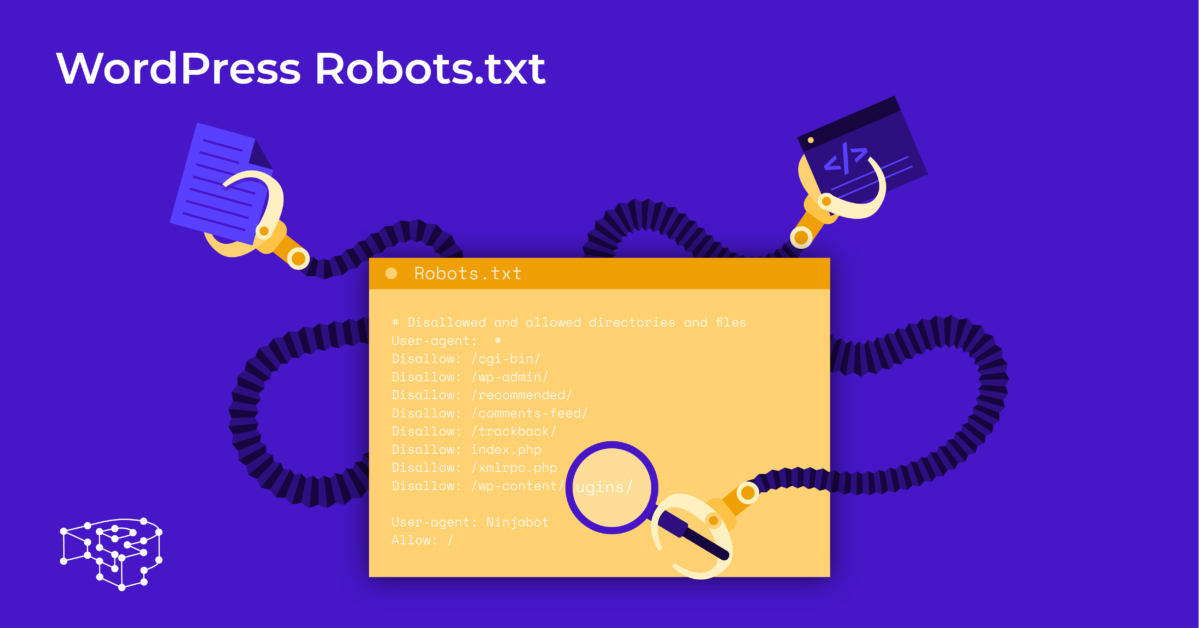

Recomendamos las siguientes pautas de algunos archivos útiles para sitios web de WordPress:

Agente de usuario: *

Permitir: / wp-content / uploads /

No permitir: / wp-content / plugins /

No permitir: / wp-admin /

No permitir: /readme.html

No permitir: / refer /

Mapa del sitio: http://www.example.com/post-sitemap.xml

Mapa del sitio: http://www.example.com/page-sitemap.xml

Todas las imágenes y archivos de WordPress están indexados. Los robots de búsqueda podrían incluso indexar archivos de complementos, área de administración, archivos Léame y enlaces de afiliados.

También puede permitir que Google Bots encuentre fácilmente todas las páginas de su sitio web agregando un mapa al archivo robots.txt.

Creación de un archivo robots.txt de WordPress para su sitio web

Cree un archivo robots.txt con el Bloc de notas

El Bloc de notas es un editor de texto mínimo de Microsoft . Es para escribir código sirviendo Pascal, C +, lenguaje de programación HTML,…

Un archivo de texto, ASCII o UTF-8, guardado correctamente en el archivo fuente del sitio web con el nombre "robots.txt", es necesario para WordPress robots.txt. Cada archivo contiene muchas reglas y cada regla está en una línea.

Puede generar un nuevo archivo de bloc de notas, guardarlo como robots.txt y agregar las reglas como se indicó anteriormente.

Después de eso, se completa la carga del archivo para WordPress en el directorio public_html .

Cree un archivo robots.txt con el complemento Yoast SEO

El complemento Yoast SEO se encuentra entre los complementos mejor calificados para ayudarlo a optimizar el SEO de su sitio web en términos de contenido. Sin embargo, Yoast SEO también puede verse como un complemento de WordPress robots.txt que le ayuda a crear un archivo innovador para la optimización de sus sitios.

Primero, vaya al Panel de control.

En Panel de control => Seleccione En la página de administración de Yoast SEO => Elija Editor de archivos.

Seleccione Crear nuevo para iniciar el archivo para WordPress o editar un archivo existente.

Seleccione Guardar cambios en robots.txt para confirmar que el archivo robots.txt personalizado está completo.

Visite el sitio web nuevamente y verá las nuevas reglas que acaba de instalar.

Verifique el archivo robots.txt en Google Search Console

Puede iniciar sesión en Google Search Console y registrar la propiedad de su sitio web para comenzar.

Seleccione Ir a la versión anterior para volver a la interfaz anterior y habilitar el uso.

En Rastreo => Seleccione Verifique el resultado de la cantidad de Errores y Advertencias => Realice la corrección si corresponde.

Seleccione Descargar código actualizado para descargar el nuevo archivo robots.txt y vuelva a cargar el nuevo archivo en el directorio original o seleccione Pensamientos finales

A través de este artículo, ha aprendido la importancia y la forma de configurar un archivo robots.txt para WordPress. Tener un archivo robots.txt estándar ayudará a que los robots de su sitio web y de motores de búsqueda interactúen mejor, por lo que la información del sitio se actualizará con precisión y aumentará la capacidad de llegar a más usuarios.

¡Comencemos creando su propio archivo técnico para WordPress y mejorando el SEO del sitio web de inmediato!

Leer más: 10 mejores complementos de copia de seguridad de WP gratuitos para proteger WordPress