为 SEO 优化 WordPress Robots.txt 的完整指南

已发表: 2021-03-11为了让您的网站快速被索引、针对 SEO 进行优化并提高 SERP 搜索结果页面上的排名,首先,您需要为 WordPress 构建一个技术 robots.txt 文件。 Robots.txt 文件说明了如何扫描和配置您的索引站点,尤其是使其成为非常强大的 SEO 工具。 因此,我们将在本文中推荐完整的指南来增强 WordPress robots.txt 的 SEO。

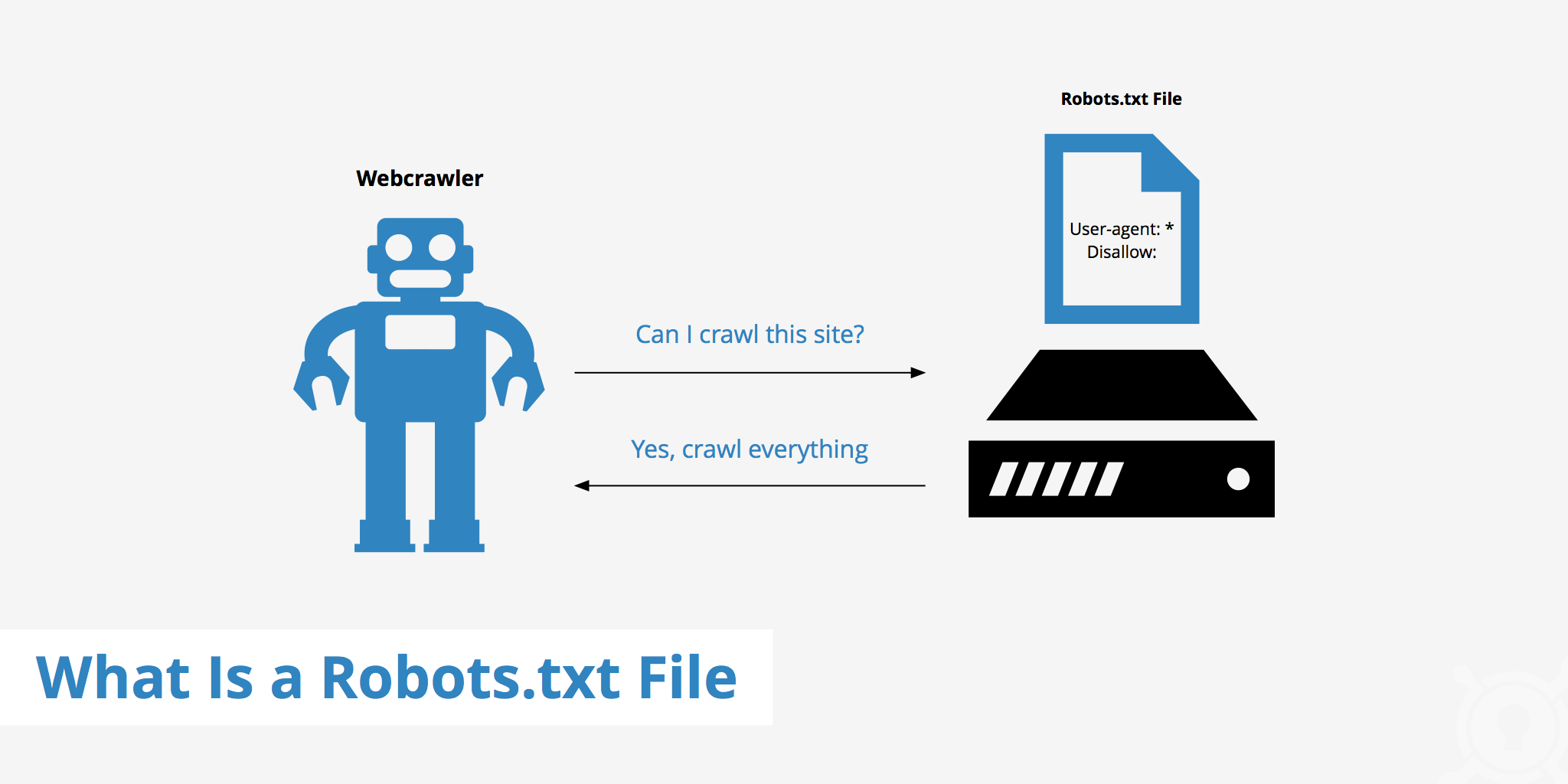

什么是 WordPress Robots.txt?

这是网站根文件夹中的文本文件,提供有关搜索引擎可以为其编制索引的页面的说明。

如果您之前了解过搜索引擎的工作流程,您就会知道,在抓取和索引阶段,网络浏览器会尝试在网络上查找公开可用的页面,并可以将这些页面包含在索引中。

Web 浏览器在访问网站时的第一件事就是查找并检查 robots.txt 文件的内容。 根据文件中指定的规则,它们会生成可被抓取的 URL 列表,然后专门为该站点编制索引。

为什么要构建WordPress robots.txt文件?

在许多情况下,搜索引擎机器人“扫描”您的网站会被阻止或限制:

内容无效且重复

事实上,在您的网站上,它会显示很多其他信息,例如系统设置文件、WordPress 插件等。

该信息对用户没有价值。 此外,网站内容被复制的情况也有几种。 如果内容仍然被索引,就会稀释网站,降低网站的实际内容质量。

用于设置和测试网站的子页面

在这种情况下,可能在使用 WordPress 创建新网站时,您还没有完成网站的设计和设置过程,一般还没有为用户做好准备,您需要采取措施防止搜索引擎机器人“扫描”并验证其网站。

不仅如此,有些网站还有很多子页面,仅用于测试网站的功能和设计,让用户访问这些网站会影响网站的质量和贵公司的专业性。

大容量网站加载时间长

每个搜索引擎机器人每次访问网站时只有有限的“扫描”能力。 当您的网站有大量内容时,机器人将需要更多时间进行分析,因为如果它的运行足以进行一次访问,则网站上的剩余内容必须等到机器人下一次旋转。 可以再次抓取和索引。

如果您的网站仍然有不必要的文件和内容,但首先被索引,不仅会降低网站的质量,还会花更多的时间为机器人编制索引。

不断索引时降低网络速度

当没有 robots.txt 文件时,机器人仍会扫描您网站上的整个内容。 除了显示您的客户不想看到的内容之外,持续的抓取和索引也会降低页面的加载速度。

网络速度是网站的一个非常重要的方面,会影响他们访问您的网站时的质量和用户体验。 页面也更高。

由于这些原因,您应该为 WordPress 构建这种技术文件来指示机器人:“机器人扫描一侧,不要扫描另一侧!”。 使用 WordPress 的标准 robots.txt 文件有助于提高机器人网站抓取和索引的效率。 从那里,改善您网站的 SEO 结果。

您的 WordPress 网站是否有必要拥有此文件?

如果您不使用站点地图,您仍然需要跋涉并对您的网站进行排名。 但是,搜索引擎无法说明不应运行哪些页面或文件夹。

当您开始写博客时,这并不重要。 但是,随着网站的发展和拥有大量内容,您可能想要更多地控制您的网站是如何排列和编入索引的。

搜索机器人对每个网站都有一个爬网配额。 这意味着他们在抓取会话期间抓取某些页面。 如果他们还没有完成您网站上的所有页面,他们将在下一个会话中再次爬行。 他们还在那里,并没有消失。

这可能会降低您网站的索引速度。 但是您可以通过禁止搜索机器人尝试抓取不必要的页面(例如 wp-admin 管理页面、插件目录和主题目录)来解决此问题。

通过拒绝不必要的页面,您可以节省抓取配额。 这使搜索引擎能够绊倒并更快地索引您网站的页面。

另一个使用 robots.txt 文件的好理由是防止搜索引擎将帖子或页面编入索引。 这不是隐藏搜索引擎内容的最安全方法,但它有助于阻止搜索结果。

针对 SEO 内容优化 Robots.txt 的完美指南

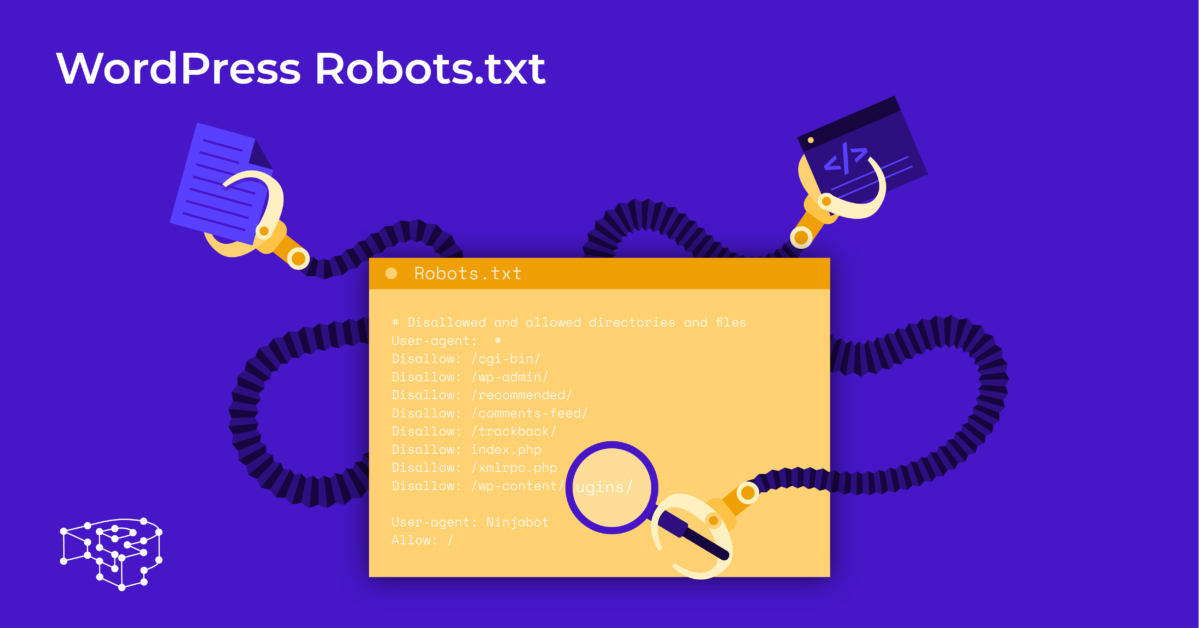

许多博客网站选择在他们的 WordPress 网站上运行一个非常普通的 robots.txt 文件。 它们的内容可能会有所不同,具体取决于特定网站的需求:

用户代理: *

不允许:

站点地图:http://www.example.com/post-sitemap.xml

站点地图:http://www.example.com/page-sitemap.xml

此 robots.txt 文件将所有机器人连接到 XML 站点地图以指示所有内容。

我们为 WordPress 网站推荐一些有用文件的以下指南:

用户代理: *

允许:/wp-content/uploads/

禁止:/wp-content/plugins/

禁止:/wp-admin/

禁止:/readme.html

禁止:/引用/

站点地图:http://www.example.com/post-sitemap.xml

站点地图:http://www.example.com/page-sitemap.xml

WordPress 的所有图片和文件都已编入索引。 搜索机器人甚至可以索引插件文件、管理区域、自述文件和附属链接。

您还可以通过向 robots.txt 文件添加地图,轻松让 Google Bot 找到您网站上的所有页面。

为您的网站创建 WordPress robots.txt 文件

使用记事本创建 robots.txt 文件

记事本是 Microsoft 的最小文本编辑器。 它用于编写服务于 Pascal、C+、HTML 编程语言等的代码。

WordPress robots.txt 需要一个文本文件,ASCII 或 UTF-8,以名称“robots.txt”正确保存在网站源文件中。 每个文件包含许多规则,每个规则在一行上。

您可以生成一个新的记事本文件,将其保存为 robots.txt 并按照上述说明添加规则。

之后,将WordPress的文件上传到public_html目录就完成了。

使用 Yoast SEO 插件创建 robots.txt 文件

Yoast SEO 插件是评价最高的插件之一,可帮助您在内容方面优化网站的 SEO。 但是,Yoast SEO 也可以被视为 robots.txt WordPress 插件,可帮助您创建用于优化网站的创新文件。

首先,您转到仪表板。

在仪表板=> 选择在 Yoast SEO 管理页面 => 选择文件编辑器。

选择新建以启动 WordPress 文件或编辑现有文件。

选择Save changes to robots.txt 以确认自定义 robots.txt 文件已完成。

再次访问该网站,您将看到刚刚安装的新规则。

检查 Google Search Console 上的 robots.txt 文件

您可以登录 Google Search Console 并注册您的网站资产以开始。

选择Go to old version返回旧界面并启用使用。

在抓取下=> 选择检查错误和警告数量的结果=> 如果有,请执行更正。

选择下载更新的代码下载新的robots.txt并将新文件重新上传到原始目录或选择最后的想法

通过本文,您了解了为 WordPress 设置 robots.txt 文件的重要性和方法。 拥有一个标准的 robots.txt 文件将有助于您的网站和搜索引擎机器人更好地互动,因此网站的信息将得到准确更新并增加接触更多用户的能力。

让我们开始为 WordPress 创建您自己的技术文件并立即改进网站的 SEO!

阅读更多:用于保护 WordPress 的 10 个最佳免费 WP 备份插件