Die vollständige Anleitung zur Optimierung von WordPress Robots.txt für SEO

Veröffentlicht: 2021-03-11Damit Ihre Website schnell indexiert, für SEO optimiert und das Ranking auf der SERP-Suchergebnisseite verbessert wird, müssen Sie als erstes eine technische robots.txt-Datei für WordPress erstellen. Die Datei Robots.txt veranschaulicht, wie Sie Ihre Index-Site scannen und konfigurieren, insbesondere, was sie zu einem äußerst leistungsstarken SEO-Tool macht. Daher schlagen wir in diesem Artikel die vollständige Anleitung zur Verbesserung der WordPress robots.txt für SEO vor.

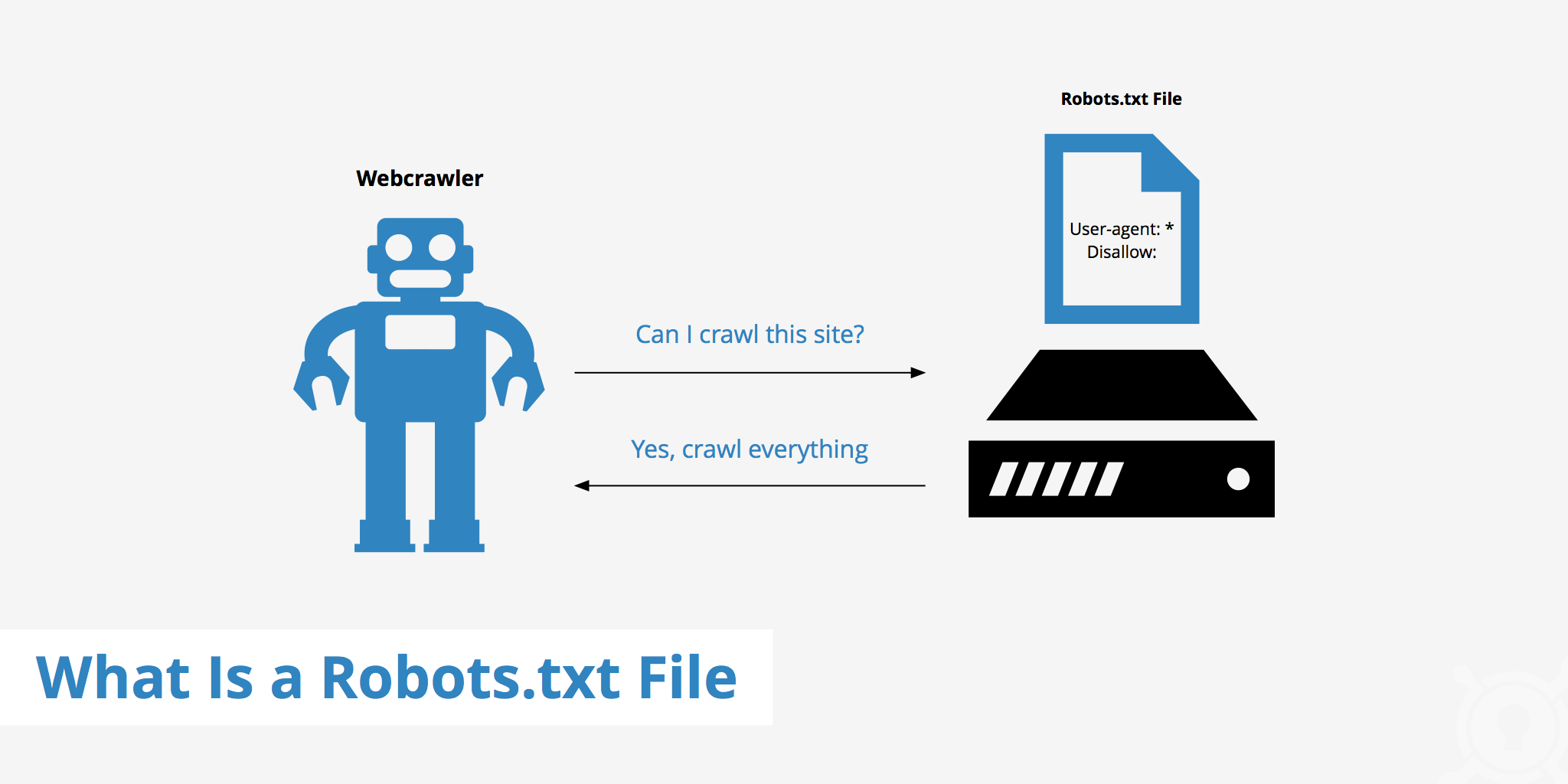

Was ist WordPress Robots.txt?

Dies ist die Textdatei im Stammordner einer Website und enthält Anweisungen zur Suchmaschine, für die Seiten indiziert werden können.

Wenn Sie den Arbeitsprozess von Suchmaschinen schon einmal entdeckt haben, wissen Sie, dass Webbrowser während der Crawling- und Indexierungsphase versuchen, öffentlich zugängliche Seiten im Web zu finden, die sie in ihren Index aufnehmen können.

Das erste, was ein Webbrowser beim Besuch einer Website durchführt, besteht darin, den Inhalt der Datei robots.txt zu finden und zu überprüfen. Abhängig von den in der Datei angegebenen Regeln generieren sie eine Liste von URLs, die gecrawlt und dann speziell für die Site indiziert werden können.

Warum müssen Sie eine WordPress robots.txt-Datei erstellen?

Es gibt viele Fälle, in denen Suchmaschinen-Bots daran gehindert oder eingeschränkt werden, Ihre Website zu „scannen“:

Der Inhalt ist ungültig und dupliziert

Tatsächlich werden auf Ihrer Website viele andere Informationen angezeigt , z. B. System-Setup-Dateien, WordPress-Plugins usw.

Diese Informationen sind für den Benutzer nicht wertvoll. Darüber hinaus gibt es mehrere Situationen, in denen der Inhalt der Website dupliziert wird. Wenn der Inhalt immer noch indiziert ist, wird die Website verwässert und die tatsächliche Inhaltsqualität der Website verringert.

Unterseiten zum Einrichten und Testen der Website

In diesem Fall, vielleicht beim Erstellen einer neuen Website mit WordPress, haben Sie den Prozess des Entwerfens und Einrichtens der Website noch nicht abgeschlossen, im Allgemeinen noch nicht für den Benutzer bereit Webseite.

Darüber hinaus haben einige Websites viele Unterseiten, die nur zum Testen von Website-Funktionen und -Design verwendet werden. Der Zugriff auf solche Websites durch die Benutzer wirkt sich auf die Qualität der Website und die Professionalität Ihres Unternehmens aus.

Die großvolumige Website benötigt eine lange Ladezeit

Jeder Suchmaschinen-Bot hat nur eine begrenzte „Scan“-Funktion pro Website-Besuch. Wenn Ihre Website eine große Menge an Inhalten enthält, müssen Bots mehr Zeit für die Analyse benötigen, denn wenn sie für einen Besuch ausreichend funktioniert hat, müssen die verbleibenden Inhalte auf der Website warten, bis sich die Bots das nächste Mal drehen. kann wieder gecrawlt und indiziert werden.

Wenn Ihre Website immer noch unnötige Dateien und Inhalte enthält, aber zuerst indiziert wird, verringert dies nicht nur die Qualität der Website, sondern verbraucht auch mehr Zeit für die Indizierung der Bots.

Reduziert die Webgeschwindigkeit bei ständiger Indizierung

Wenn keine robots.txt-Datei vorhanden ist, scannen Bots trotzdem den gesamten Inhalt Ihrer Website. Neben der Anzeige von Inhalten, die Ihre Kunden nicht sehen möchten, kann das ständige Crawlen und Indexieren auch die Laderate der Seite verlangsamen.

Die Webgeschwindigkeit ist ein entscheidender Aspekt der Website und beeinflusst die Qualität und das Benutzererlebnis beim Besuch Ihrer Website. die Seite ist auch höher.

Aus diesen Gründen sollten Sie eine solche technische Datei für WordPress erstellen, um Bots anzuweisen: „Bots scannen eine Seite, scannen nicht die andere!“. Die Verwendung der standardmäßigen robots.txt-Datei von WordPress hilft dabei, das Crawlen und Indexieren von Websites durch Bots zu steigern und effizienter zu machen. Verbessern Sie von dort aus die SEO-Ergebnisse für Ihre Website.

Ist diese Datei für Ihre WordPress-Website erforderlich?

Wenn Sie keine Site-Map verwenden, werden Sie trotzdem durch Ihre Website stolpern und ein Ranking erstellen. Die Suchmaschinen können jedoch nicht sagen, welche Seiten oder Ordner nicht ausgeführt werden sollen.

Wenn Sie einen Blog starten, spielt das keine große Rolle. Sie können jedoch mehr Kontrolle darüber haben, wie Ihre Site gewellt und indiziert wird, wenn Ihre Site wächst und Sie viele Inhalte haben.

Der Suchbot hat eine Crawling-Quote pro Website. Das bedeutet, dass sie während einer Crawling-Sitzung bestimmte Seiten crawlen. Wenn sie nicht alle Seiten Ihrer Website fertig gestellt haben, kommen sie und crawlen in der nächsten Sitzung erneut. Sie sind immer noch da und verschwinden nicht.

Dies kann die Indexierungsgeschwindigkeit Ihrer Website verringern. Sie können dies jedoch beheben, indem Sie Such-Bots daran hindern, unnötige Seiten wie die wp-admin-Admin-Seite, das Plugin-Verzeichnis und das Themenverzeichnis zu crawlen.

Indem Sie unnötige Seiten ablehnen, können Sie Ihre Crawling-Quote sparen. Dies ermöglicht es Suchmaschinen, die Seiten Ihrer Website schneller zu indizieren und zu indizieren.

Ein weiterer guter Grund für die Verwendung von robots.txt-Dateien besteht darin, Suchmaschinen daran zu hindern, Beiträge oder Seiten zu indizieren. Dies ist nicht die sicherste Methode, um Suchmaschineninhalte zu verbergen, aber es hilft, Suchergebnisse zu verhindern.

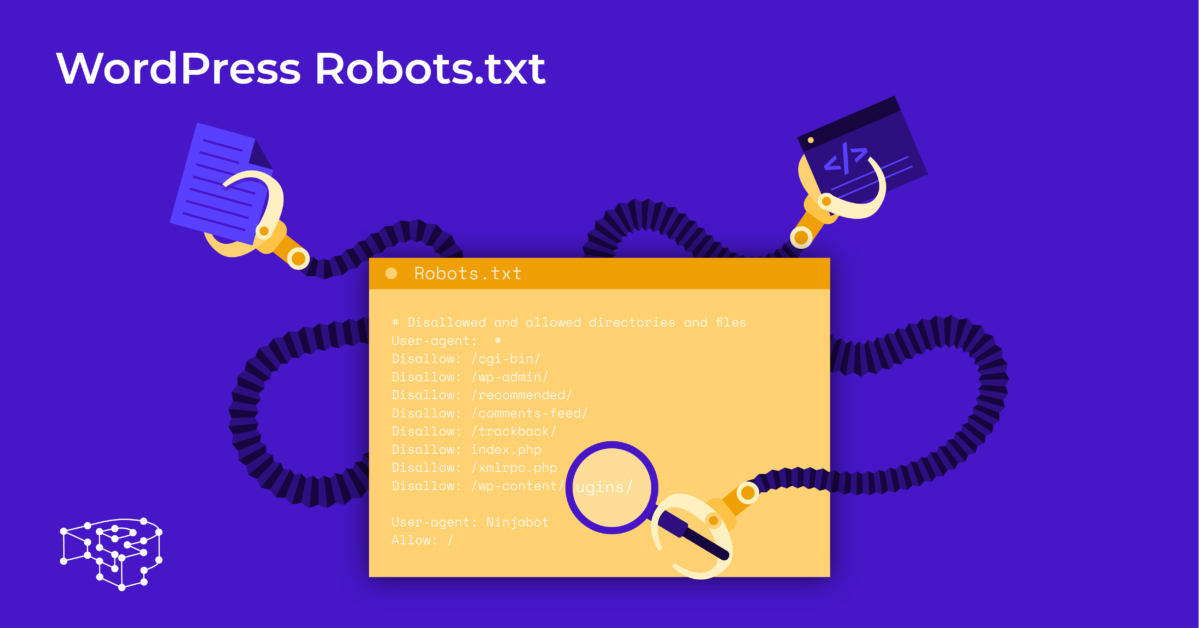

Die perfekte Richtlinie, um Robots.txt für den SEO-Inhalt zu optimieren

Viele Blog-Sites entscheiden sich dafür, eine sehr bescheidene robots.txt-Datei in ihrem WordPress-Web auszuführen. Ihr Inhalt kann je nach Bedarf der jeweiligen Website variieren:

User-Agent: *

Nicht zulassen:

Sitemap: http://www.example.com/post-sitemap.xml

Sitemap: http://www.example.com/page-sitemap.xml

Diese robots.txt-Datei vermittelt allen Bots eine Verbindung zur XML-Sitemap, um alle Inhalte anzuzeigen.

Wir empfehlen die folgenden Richtlinien einiger nützlicher Dateien für WordPress-Websites:

User-Agent: *

Erlauben: /wp-content/uploads/

Verbieten: /wp-content/plugins/

Nicht zulassen: /wp-admin/

Nicht zulassen: /readme.html

Verbieten: /refer/

Sitemap: http://www.example.com/post-sitemap.xml

Sitemap: http://www.example.com/page-sitemap.xml

Alle Bilder und Dateien von WordPress sind indiziert. Suchbots könnten sogar Plugin-Dateien, den Admin-Bereich, Readme-Dateien und Affiliate-Links indizieren.

Sie können Google Bots auch ganz einfach erlauben, alle Seiten Ihrer Website zu finden, indem Sie der robots.txt-Datei eine Karte hinzufügen.

Erstellen einer WordPress-robots.txt-Datei für Ihre Website

robots.txt-Datei mit Notepad erstellen

Notepad ist ein minimaler Texteditor von Microsoft . Es ist zum Schreiben von Code für Pascal, C +, HTML-Programmiersprache, …

Für WordPress robots.txt ist eine Textdatei im ASCII- oder UTF-8-Format erforderlich, die ordnungsgemäß in der Quelldatei der Website unter dem Namen „robots.txt“ gespeichert ist. Jede Datei enthält viele Regeln und jede Regel befindet sich in einer Zeile.

Sie können eine neue Notizblockdatei erstellen, diese als robots.txt speichern und die Regeln wie oben beschrieben hinzufügen.

Danach ist das Hochladen der Datei für WordPress in das Verzeichnis public_html abgeschlossen.

Erstelle robots.txt-Datei mit dem Yoast SEO-Plugin

Das Yoast SEO-Plugin gehört zu den am besten bewerteten Plugins, um Sie bei der inhaltlichen Optimierung der SEO Ihrer Website zu unterstützen. Yoast SEO kann jedoch auch als robots.txt WordPress-Plugin angesehen werden, das Ihnen hilft, eine innovative Datei zur Optimierung Ihrer Websites zu erstellen.

Gehen Sie zuerst zum Dashboard.

Im Dashboard => Auf der Yoast SEO-Admin-Seite => Wählen Sie Datei-Editor.

Wählen Sie Neu erstellen , um die Datei für WordPress zu initiieren oder eine vorhandene Datei zu bearbeiten.

Wählen Sie Änderungen an robots.txt Besuchen Sie die Website erneut und Sie sehen die neuen Regeln, die Sie gerade installiert haben.

Überprüfen Sie die robots.txt-Datei in der Google Search Console

Sie können sich bei der Google Search Console anmelden und Ihre Website-Property registrieren, um zu starten.

Wählen Sie Zur alten Version wechseln, um zur alten Benutzeroberfläche zurückzukehren und die Nutzung zu aktivieren.

Wählen Sie unter Crawl => Überprüfen Sie das Ergebnis der Anzahl der Fehler und Warnungen => Führen Sie ggf. eine Korrektur durch.

Wählen Sie Aktualisierten Code herunterladen aus, um die neue robots.txt-Datei herunterzuladen und die neue Datei erneut in das ursprüngliche Verzeichnis hochzuladen, oder wählen Letzte Gedanken

Durch diesen Artikel haben Sie die Bedeutung sowie die Vorgehensweise zum Einrichten einer robots.txt-Datei für WordPress kennengelernt. Der Besitz einer standardmäßigen robots.txt-Datei hilft Ihrer Website und Suchmaschinen-Bots, besser zu interagieren, sodass die Informationen der Website genau aktualisiert werden und die Möglichkeit erhöht wird, mehr Benutzer zu erreichen.

Beginnen wir damit, Ihre eigene technische Datei für WordPress zu erstellen und sofort die SEO der Website zu verbessern!

Lesen Sie mehr: Die 10 besten kostenlosen WP-Backup-Plugins zum Schutz von WordPress