الدليل الكامل لتحسين WordPress Robots.txt لتحسين محركات البحث

نشرت: 2021-03-11من أجل فهرسة موقع الويب الخاص بك بسرعة ، وتحسين SEO ، وتحسين الترتيب على صفحة نتائج بحث SERP ، أولاً وقبل كل شيء ، تحتاج إلى إنشاء ملف robots.txt تقني لـ WordPress. يوضح ملف Robots.txt كيفية فحص موقع الفهرس وتكوينه ، على وجه الخصوص ، مما يجعله أداة فعالة للغاية لتحسين محركات البحث. ومن ثم ، سنقترح الدليل الكامل لتحسين WordPress robots.txt لتحسين محركات البحث في هذه المقالة.

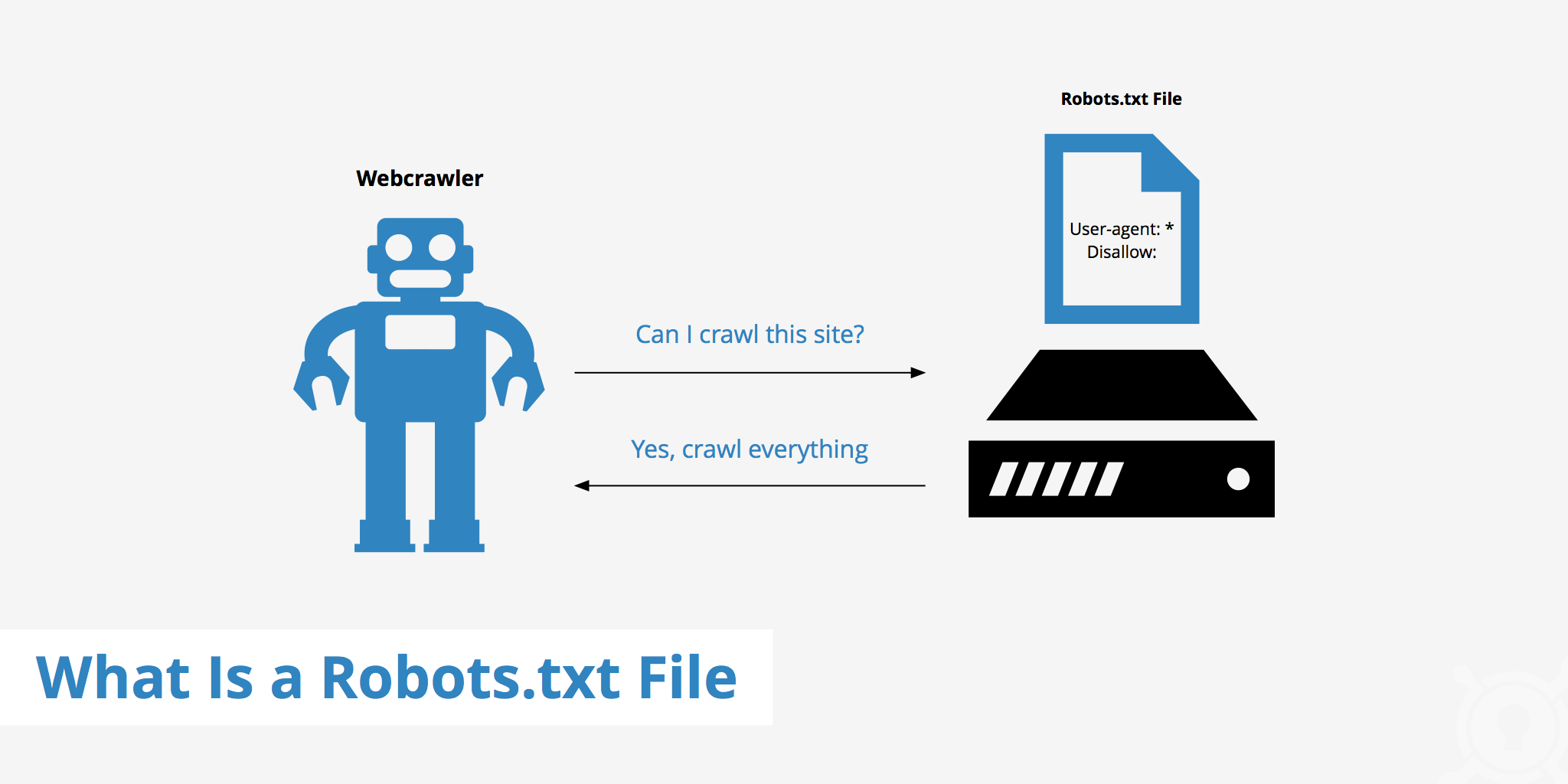

ما هو WordPress Robots.txt؟

هذا هو الملف النصي الموجود في المجلد الجذر لموقع الويب ويقدم إرشادات حول محرك البحث الذي يمكن فهرسة الصفحات من أجله.

إذا كنت قد اكتشفت عملية عمل محركات البحث مسبقًا ، فستعرف أنه أثناء مرحلة الزحف والفهرسة ، تحاول متصفحات الويب العثور على الصفحات المتاحة للجمهور على الويب ، والتي يمكن تضمينها في فهرسها.

أول شيء يعمل به متصفح الويب عند زيارته لموقع ويب هو البحث عن محتويات ملف robots.txt والتحقق منها. اعتمادًا على القواعد المحددة في الملف ، يقومون بإنشاء قائمة بعناوين URL التي يمكن الزحف إليها ثم فهرستها للموقع على وجه التحديد.

لماذا يجب عليك إنشاء ملف robots.txt في WordPress؟

هناك العديد من الحالات التي يتم فيها منع أو تقييد روبوتات محرك البحث من "فحص" موقع الويب الخاص بك:

المحتوى باطل ومكرر

في الواقع ، على موقع الويب الخاص بك ، أنا أعرض الكثير من المعلومات الأخرى ، مثل ملفات إعداد النظام ، ومكونات WordPress الإضافية ، وما إلى ذلك.

هذه المعلومات ليست ذات قيمة للمستخدم. علاوة على ذلك ، هناك العديد من المواقف التي يتم فيها نسخ محتوى الموقع. إذا كان المحتوى لا يزال مفهرسًا ، فسيؤدي ذلك إلى إضعاف موقع الويب ، مما يقلل من جودة المحتوى الفعلية للموقع.

صفحات فرعية لإعداد واختبار الموقع

في هذه الحالة ، ربما عند إنشاء موقع ويب جديد بواسطة WordPress ، لم تكن قد أكملت عملية تصميم موقع الويب وإعداده ، بشكل عام غير جاهز للمستخدم ، فأنت بحاجة إلى اتخاذ تدابير لمنع "مسح" روبوتات محرك البحث والتحقق من صحتها. موقع الكتروني.

ليس ذلك فحسب ، بل تحتوي بعض مواقع الويب أيضًا على العديد من الصفحات الفرعية التي تُستخدم فقط لاختبار ميزات وتصميم مواقع الويب ، مما سيؤثر السماح للمستخدمين بالوصول إلى هذه المواقع على جودة موقع الويب واحترافية شركتك.

يستغرق موقع الويب ذي السعة الكبيرة وقتًا طويلاً في التحميل

كل روبوتات محرك بحث لها قدرة محدودة على "الفحص" لكل زيارة للموقع. عندما يحتوي موقع الويب الخاص بك على قدر كبير من المحتوى ، سيتعين على برامج الروبوت أن تستغرق وقتًا أطول للتحليل لأنه إذا تم تشغيلها بشكل كافٍ لزيارة واحدة ، فيجب أن ينتظر المحتوى المتبقي على موقع الويب حتى المرة التالية التي تدور فيها الروبوتات. يمكن الزحف إليها وفهرستها مرة أخرى.

إذا كان موقع الويب الخاص بك لا يزال يحتوي على ملفات ومحتوى غير ضروريين ولكن تمت فهرسته أولاً ، فلن يؤدي ذلك إلى تقليل جودة موقع الويب فحسب ، بل سيقضي أيضًا وقتًا أطول في فهرسة برامج الروبوت.

يقلل من سرعة الويب عند الفهرسة باستمرار

في حالة عدم وجود ملف robots.txt ، ستستمر برامج الروبوت في فحص المحتوى بالكامل على موقع الويب الخاص بك. بالإضافة إلى إظهار المحتوى الذي لا يرغب عملاؤك في رؤيته ، يمكن أن يؤدي الزحف والفهرسة المستمران أيضًا إلى إبطاء معدل تحميل الصفحة.

تعد سرعة الويب جانبًا حيويًا بشكل كبير في موقع الويب ، حيث تؤثر على الجودة وتجربة المستخدم عند زيارة موقع الويب الخاص بك. الصفحة أعلى أيضًا.

لهذه الأسباب ، يجب عليك إنشاء هذا النوع من الملفات التقنية لـ WordPress لإرشاد الروبوتات: "تفحص الروبوتات جانبًا واحدًا ، ولا تفحص الجانب الآخر!". يساعد استخدام ملف robots.txt القياسي في WordPress على زيادة وكفاءة الزحف إلى موقع الويب وفهرسته. من هناك ، قم بتحسين نتائج SEO لموقعك على الويب.

هل من الضروري أن يكون لديك هذا الملف لموقعك على WordPress؟

إذا كنت لا تستخدم خريطة الموقع ، فستظل تمشي وتصنف موقع الويب الخاص بك. ومع ذلك ، لا تستطيع محركات البحث تحديد الصفحات أو المجلدات التي يجب ألا ترغب في تشغيلها.

عندما تبدأ مدونة ، لا يهم هذا كثيرًا. ومع ذلك ، يمكنك الحصول على مزيد من التحكم حول كيفية تموج موقعك وفهرسته مع نمو موقعك ولديك الكثير من المحتوى.

يحتوي روبوت البحث على حصة زحف لكل موقع ويب. هذا يعني أنهم يزحفون إلى صفحات معينة أثناء جلسة الزحف. إذا لم ينتهوا من جميع الصفحات على موقع الويب الخاص بك ، فإنهم يأتون ويزحفون مرة أخرى في الجلسة التالية. فهي لا تزال هناك وليس تختفي.

قد يقلل هذا من سرعة فهرسة موقع الويب الخاص بك. ولكن يمكنك إصلاح ذلك عن طريق عدم السماح لروبوتات البحث بمحاولة الزحف إلى الصفحات غير الضرورية مثل صفحة مسؤول wp-admin ودليل المكونات الإضافية ودليل السمات.

من خلال رفض الصفحات غير الضرورية ، يمكنك حفظ حصة الزحف الخاصة بك. يتيح ذلك لمحركات البحث التعثر وفهرسة صفحات موقع الويب الخاص بك بسرعة أكبر.

سبب وجيه آخر لاستخدام ملفات robots.txt هو منع محركات البحث من فهرسة المنشورات أو الصفحات. هذه ليست الطريقة الأكثر أمانًا لإخفاء محتوى محرك البحث ، لكنها تساعد في منع نتائج البحث.

الدليل المثالي لتحسين ملف Robots.txt لمحتوى تحسين محركات البحث

تختار العديد من مواقع المدونات تشغيل ملف robots.txt متواضع جدًا على ويب WordPress الخاص بهم. يمكن أن يختلف محتواها ، اعتمادًا على احتياجات موقع الويب المعين:

وكيل المستخدم: *

عدم السماح:

خريطة الموقع: http://www.example.com/post-sitemap.xml

خريطة الموقع: http://www.example.com/page-sitemap.xml

يضفي ملف robots.txt هذا على جميع برامج الروبوت اتصالاً بخريطة موقع XML للإشارة إلى كل المحتوى.

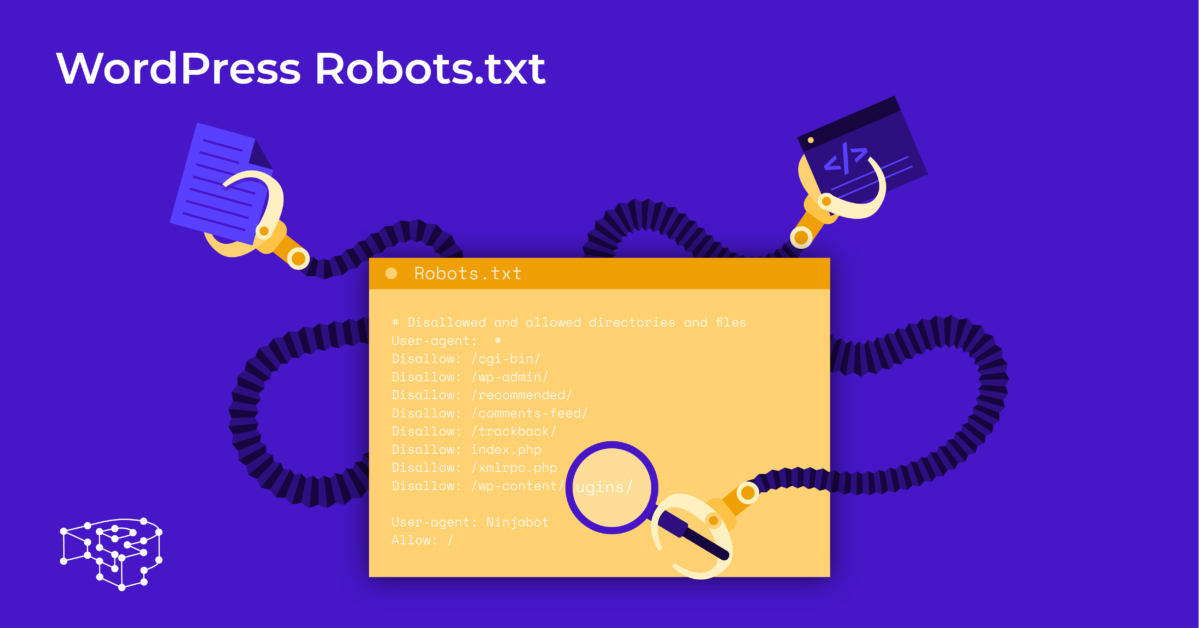

نوصي بالإرشادات التالية لبعض الملفات المفيدة لمواقع WordPress على الويب:

وكيل المستخدم: *

السماح: / wp-content / uploads /

Disallow: / wp-content / plugins /

Disallow: / wp-admin /

Disallow: /readme.html

Disallow: / إحالة /

خريطة الموقع: http://www.example.com/post-sitemap.xml

خريطة الموقع: http://www.example.com/page-sitemap.xml

جميع صور وملفات ووردبريس مفهرسة. يمكن لروبوتات البحث حتى فهرسة ملفات المكونات الإضافية ، ومنطقة الإدارة ، وملفات التمهيدي ، والروابط التابعة.

يمكنك أيضًا السماح لـ Google Bots بالعثور على جميع الصفحات على موقع الويب الخاص بك بسهولة عن طريق إضافة خريطة إلى ملف robots.txt.

إنشاء ملف WordPress robots.txt لموقعك على الويب

قم بإنشاء ملف robots.txt باستخدام المفكرة

برنامج Notepad هو محرر نص صغير من Microsoft . إنه مخصص لكتابة التعليمات البرمجية لخدمة Pascal و C + ولغة برمجة HTML ، ...

مطلوب ملف نصي ، ASCII أو UTF-8 ، محفوظ بشكل صحيح في ملف مصدر موقع الويب باسم "robots.txt" ، لـ WordPress robots.txt. يحتوي كل ملف على العديد من القواعد وكل قاعدة في سطر واحد.

يمكنك إنشاء ملف مفكرة جديد وحفظه كملف robots.txt وإضافة القواعد كما هو موضح أعلاه.

بعد ذلك ، يكتمل تحميل ملف WordPress إلى دليل public_html .

قم بإنشاء ملف robots.txt باستخدام البرنامج المساعد Yoast SEO

يعد المكون الإضافي Yoast SEO من بين أفضل المكونات الإضافية تصنيفًا لمساعدتك في تحسين مُحسّنات محرّكات البحث لموقع الويب الخاص بك من حيث المحتوى. ومع ذلك ، يمكن أيضًا اعتبار Yoast SEO كمكوِّن إضافي لملف robots.txt WordPress يساعدك على إنشاء ملف مبتكر لتحسين مواقعك.

أولاً ، تذهب إلى لوحة القيادة.

في Dashboard => حدد في صفحة مسؤول Yoast SEO => اختر محرر الملفات.

حدد إنشاء جديد لبدء ملف WordPress أو تحرير ملف موجود.

حدد حفظ التغييرات على ملف robots.txt لتأكيد اكتمال ملف robots.txt المخصص.

قم بزيارة الموقع مرة أخرى وسترى القواعد الجديدة التي قمت بتثبيتها للتو.

تحقق من ملف robots.txt على Google Search Console

يمكنك تسجيل الدخول إلى Google Search Console وتسجيل ملكية موقع الويب الخاص بك .

حدد الانتقال إلى الإصدار القديم للعودة إلى الواجهة القديمة وتمكين الاستخدام.

ضمن الزحف => حدد تحقق من نتيجة عدد الأخطاء والتحذيرات => إجراء التصحيح إن وجد.

حدد تنزيل رمز محدث لتنزيل ملف robots.txt الجديد وإعادة تحميل الملف الجديد إلى الدليل الأصلي أو حدد الأفكار النهائية

من خلال هذه المقالة ، تعلمت أهمية وطريقة إعداد ملف robots.txt لبرنامج WordPress. سيساعد امتلاك ملف robots.txt قياسي موقع الويب الخاص بك وروبوتات محرك البحث على التفاعل بشكل أفضل ، وبالتالي سيتم تحديث معلومات الموقع بدقة وزيادة القدرة على الوصول إلى المزيد من المستخدمين.

لنبدأ بإنشاء ملف تقني خاص بك لبرنامج WordPress وتحسين مُحسّنات محرّكات البحث لموقع الويب على الفور!

قراءة المزيد: أفضل 10 إضافات نسخ احتياطي مجانية لـ WP لحماية WordPress