Список сканеров: боты веб-сканеров и как использовать их для достижения успеха

Опубликовано: 2022-12-03Большинству маркетологов необходимы постоянные обновления, чтобы поддерживать сайт в актуальном состоянии и повышать рейтинг SEO.

Однако некоторые сайты содержат сотни или даже тысячи страниц, что усложняет работу команд, которые вручную загружают обновления в поисковые системы. Если контент обновляется так часто, как команды могут гарантировать, что эти улучшения повлияют на их SEO-рейтинг?

Вот где в игру вступают краулер-боты. Бот веб-краулера будет очищать вашу карту сайта на наличие новых обновлений и индексировать контент в поисковых системах.

В этом посте мы опишем исчерпывающий список поисковых роботов, который охватывает всех ботов поисковых роботов, которые вам нужно знать. Прежде чем мы углубимся, давайте определим ботов поисковых роботов и покажем, как они работают.

Что такое веб-краулер?

Поисковый робот — это компьютерная программа, которая автоматически сканирует и систематически читает веб-страницы, чтобы индексировать их для поисковых систем. Поисковые роботы также известны как пауки или боты.

Чтобы поисковые системы отображали актуальные релевантные веб-страницы для пользователей, инициирующих поиск, должен выполняться обход веб-роботом. Иногда этот процесс может происходить автоматически (в зависимости от настроек сканера и вашего сайта) или может быть инициирован напрямую.

Многие факторы влияют на SEO-рейтинг ваших страниц, в том числе релевантность, обратные ссылки, веб-хостинг и многое другое. Однако все это не имеет значения, если ваши страницы не сканируются и не индексируются поисковыми системами. Вот почему так важно убедиться, что ваш сайт позволяет выполнять правильное сканирование и устраняет любые препятствия на его пути.

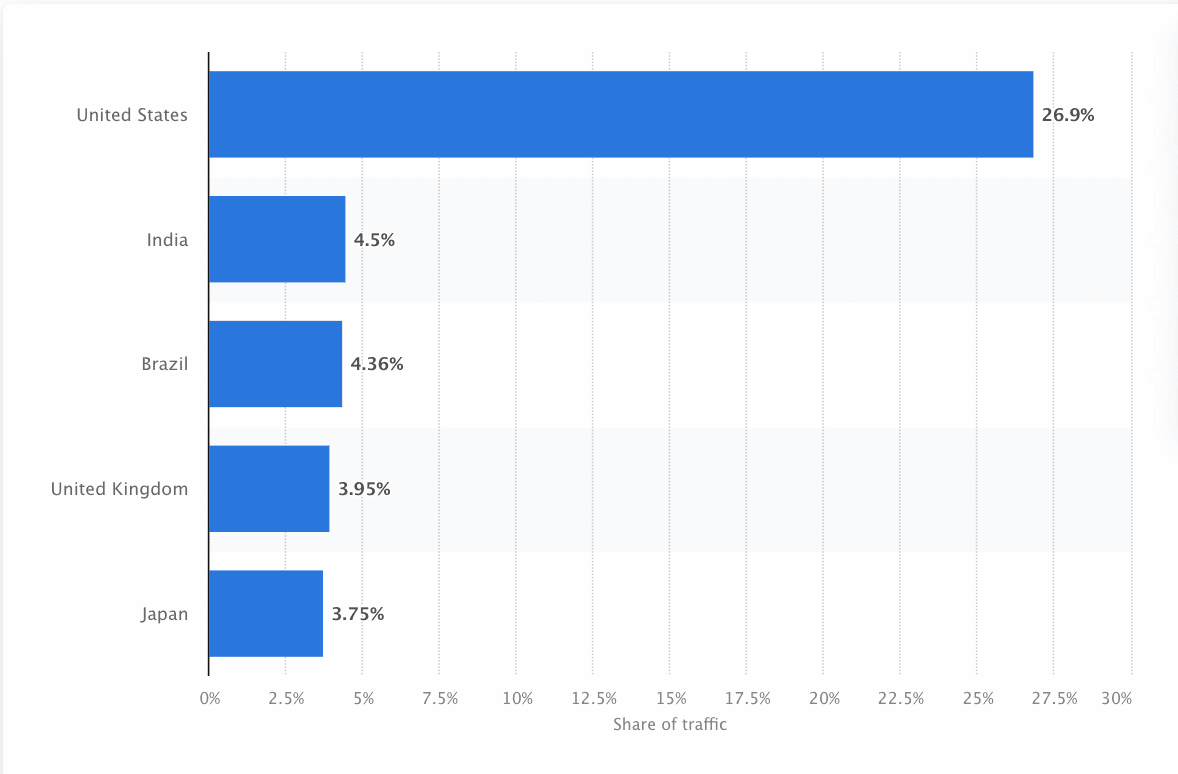

Боты должны постоянно сканировать и очищать Интернет, чтобы обеспечить предоставление наиболее точной информации. Google является самым посещаемым веб-сайтом в Соединенных Штатах, и примерно 26,9% поисковых запросов исходят от американских пользователей:

Однако не существует одного поискового робота, который сканировал бы все поисковые системы. Каждая поисковая система обладает уникальными преимуществами, поэтому разработчики и маркетологи иногда составляют «список поисковых роботов». Этот список поисковых роботов помогает им определить различные поисковые роботы в журнале своего сайта, чтобы принять или заблокировать их.

Маркетологи должны составить список поисковых роботов, полный различных поисковых роботов, и понять, как они оценивают свой сайт (в отличие от парсеров контента, которые крадут контент), чтобы убедиться, что они правильно оптимизируют свои целевые страницы для поисковых систем.

Как работает веб-краулер?

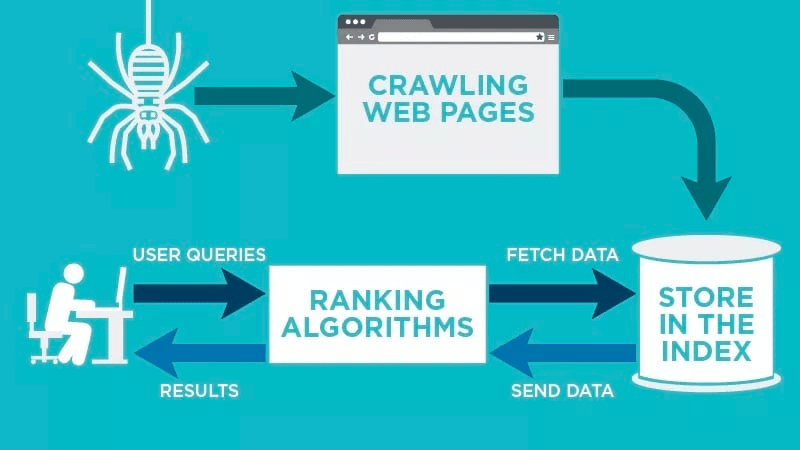

Поисковый робот автоматически просканирует вашу веб-страницу после ее публикации и проиндексирует ваши данные.

Поисковые роботы ищут определенные ключевые слова, связанные с веб-страницей, и индексируют эту информацию для соответствующих поисковых систем, таких как Google, Bing и других.

Алгоритмы поисковых систем будут извлекать эти данные, когда пользователь отправляет запрос по релевантному ключевому слову, связанному с ним.

Сканирование начинается с известных URL-адресов. Это установленные веб-страницы с различными сигналами, которые направляют поисковые роботы на эти страницы. Этими сигналами могут быть:

- Обратные ссылки: сколько раз сайт ссылается на него.

- Посетители: сколько трафика направляется на эту страницу.

- Авторитет домена: общее качество домена.

Затем они сохраняют данные в индексе поисковой системы. Когда пользователь инициирует поисковый запрос, алгоритм извлечет данные из индекса, и они появятся на странице результатов поисковой системы. Этот процесс может происходить в течение нескольких миллисекунд, поэтому результаты часто появляются быстро.

Как веб-мастер, вы можете контролировать, какие боты будут сканировать ваш сайт. Вот почему важно иметь список поисковых роботов. Это протокол robots.txt, который находится на серверах каждого сайта и направляет поисковых роботов к новому контенту, который необходимо проиндексировать.

В зависимости от того, что вы вводите в свой протокол robots.txt на каждой веб-странице, вы можете указать сканеру сканировать или избегать индексации этой страницы в будущем.

Поняв, что поисковый робот ищет при сканировании, вы сможете понять, как лучше позиционировать свой контент для поисковых систем.

Составление списка поисковых роботов: какие существуют типы поисковых роботов?

Когда вы начнете думать о составлении списка поисковых роботов, вам придется искать три основных типа поисковых роботов. Это включает:

- Собственные сканеры: это сканеры, разработанные командой разработчиков компании для сканирования ее сайта. Обычно они используются для аудита и оптимизации сайта.

- Коммерческие поисковые роботы: это специальные поисковые роботы, такие как Screaming Frog, которые компании могут использовать для сканирования и эффективной оценки своего контента.

- Поисковые роботы с открытым исходным кодом : это бесплатные поисковые роботы, созданные различными разработчиками и хакерами по всему миру.

Важно понимать различные типы существующих поисковых роботов, чтобы вы знали, какой тип вам нужно использовать для достижения ваших собственных бизнес-целей.

11 самых распространенных поисковых роботов, которые стоит добавить в свой список поисковых роботов

Не существует одного поискового робота, который выполняет всю работу для каждой поисковой системы.

Вместо этого существует множество поисковых роботов, которые оценивают ваши веб-страницы и сканируют контент для всех поисковых систем, доступных пользователям по всему миру.

Давайте посмотрим на некоторые из наиболее распространенных сегодня поисковых роботов.

1. Гуглбот

Googlebot — это универсальный поисковый робот Google, который отвечает за сканирование сайтов, которые будут отображаться в поисковой системе Google.

Хотя технически существует две версии Googlebot — Googlebot для настольных ПК и Googlebot для смартфонов (мобильная версия), — большинство экспертов считают Googlebot одним единственным поисковым роботом.

Это связано с тем, что оба следуют одному и тому же уникальному токену продукта (известному как токен пользовательского агента), указанному в файле robots.txt каждого сайта. Пользовательский агент Googlebot — это просто «Googlebot».

Googlebot приступает к работе и обычно заходит на ваш сайт каждые несколько секунд (если только вы не заблокировали его в файле robots.txt вашего сайта). Резервная копия отсканированных страниц сохраняется в единой базе данных под названием Google Cache. Это позволяет просматривать старые версии вашего сайта.

Кроме того, Google Search Console — это еще один инструмент, который веб-мастера используют, чтобы понять, как Googlebot сканирует их сайт, и оптимизировать свои страницы для поиска.

2. Бингбот

Bingbot был создан Microsoft в 2010 году для сканирования и индексации URL-адресов, чтобы гарантировать, что Bing предлагает релевантные и актуальные результаты поисковой системы для пользователей платформы.

Как и Googlebot, разработчики или маркетологи могут указать в своем файле robots.txt на своем сайте, одобряют ли они или нет идентификатор агента «bingbot» для сканирования своего сайта.

Кроме того, у них есть возможность различать поисковые роботы, ориентированные на мобильные устройства, и поисковые роботы для настольных компьютеров, поскольку Bingbot недавно перешел на новый тип агента. Это, наряду с инструментами для веб-мастеров Bing, предоставляет веб-мастерам большую гибкость, чтобы показать, как их сайт обнаруживается и демонстрируется в результатах поиска.

3. Яндекс Бот

Яндекс Бот — это краулер специально для российской поисковой системы Яндекс. Это одна из самых крупных и популярных поисковых систем в России.

Веб-мастера могут сделать страницы своего сайта доступными для Яндекс-бота через файл robots.txt .

Кроме того, они также могут добавить тег Яндекс.Метрики к определенным страницам, переиндексировать страницы в веб-мастере Яндекса или выдать протокол IndexNow — уникальный отчет, который указывает на новые, измененные или деактивированные страницы.

4. Яблочный бот

Apple поручила Apple Bot сканировать и индексировать веб-страницы для предложений Apple Siri и Spotlight.

Apple Bot учитывает несколько факторов при принятии решения о том, какой контент следует повысить в предложениях Siri и Spotlight. К этим факторам относятся вовлеченность пользователей, релевантность условий поиска, количество/качество ссылок, сигналы на основе местоположения и даже дизайн веб-страницы.

5. Бот DuckDuck

DuckDuckBot — это поисковый робот для DuckDuckGo, который предлагает «полную защиту конфиденциальности в вашем веб-браузере».

Веб-мастера могут использовать DuckDuckBot API, чтобы узнать, просканировал ли DuckDuck Bot их сайт. По мере сканирования он обновляет базу данных API DuckDuckBot последними IP-адресами и пользовательскими агентами.

Это помогает веб-мастерам идентифицировать любых самозванцев или вредоносных ботов, пытающихся ассоциироваться с DuckDuck Bot.

6. Паук Байду

Baidu — ведущая китайская поисковая система, а Baidu Spider — единственный краулер сайта.

Google запрещен в Китае, поэтому важно разрешить Baidu Spider сканировать ваш сайт, если вы хотите выйти на китайский рынок.

Чтобы определить, что Baidu Spider сканирует ваш сайт, найдите следующие пользовательские агенты: baiduspider, baiduspider-image, baiduspider-video и другие.

Если вы не ведете бизнес в Китае, может иметь смысл заблокировать Baidu Spider в вашем скрипте robots.txt. Это предотвратит сканирование вашего сайта пауком Baidu, тем самым исключив вероятность появления ваших страниц на страницах результатов поисковой системы Baidu (SERP).

7. Согу Паук

Sogou — это китайская поисковая система, которая, как сообщается, является первой поисковой системой, проиндексировавшей 10 миллиардов страниц на китайском языке.

Если вы ведете бизнес на китайском рынке, это еще один популярный поисковый робот, о котором вам нужно знать. Sogou Spider следует тексту исключения робота и параметрам задержки сканирования.

Как и в случае с Baidu Spider, если вы не хотите вести бизнес на китайском рынке, вам следует отключить этого паука, чтобы предотвратить медленную загрузку сайта.

8. Внешний хит Facebook

Facebook External Hit, также известный как Facebook Crawler, сканирует HTML-код приложения или веб-сайта, опубликованного на Facebook.

Это позволяет социальной платформе создавать общий предварительный просмотр каждой ссылки, размещенной на платформе. Заголовок, описание и уменьшенное изображение появляются благодаря сканеру.

Если сканирование не будет выполнено в течение нескольких секунд, Facebook не покажет контент в пользовательском фрагменте, созданном перед публикацией.

9. Эксабот

Exalead — компания-разработчик программного обеспечения, созданная в 2000 году со штаб-квартирой в Париже, Франция. Компания предоставляет поисковые платформы для частных и корпоративных клиентов.

Exabot — это сканер для их основной поисковой системы, построенный на их продукте CloudView.

Как и большинство поисковых систем, Exalead учитывает как обратные ссылки, так и контент на веб-страницах при ранжировании. Exabot — пользовательский агент робота Exalead. Робот создает «основной индекс», который собирает результаты, которые увидят пользователи поисковой системы.

10. Свифтбот

Swiftype — это система пользовательского поиска для вашего сайта. Он сочетает в себе «лучшие технологии поиска, алгоритмы, структуру приема контента, клиентов и инструменты аналитики».

Если у вас сложный сайт с большим количеством страниц, Swiftype предлагает удобный интерфейс для каталогизации и индексации всех ваших страниц.

Swiftbot — это поисковый робот Swiftype. Однако, в отличие от других ботов, Swiftbot сканирует только те сайты, которые запрашивают их клиенты.

11. Slurp Bot

Slurp Bot — это поисковый робот Yahoo, который сканирует и индексирует страницы для Yahoo.

Это сканирование необходимо как для Yahoo.com, так и для его партнерских сайтов, включая Yahoo News, Yahoo Finance и Yahoo Sports. Без него релевантные списки сайтов не появились бы.

Индексированный контент способствует более персонализированному использованию Интернета для пользователей с более релевантными результатами.

8 коммерческих поисковых роботов, которые должны знать SEO-специалисты

Теперь, когда у вас есть 11 самых популярных ботов в вашем списке поисковых роботов, давайте рассмотрим некоторые распространенные коммерческие поисковые роботы и инструменты SEO для профессионалов.

1. Бот Ahrefs

Бот Ahrefs — это поисковый робот, который компилирует и индексирует базу данных из 12 триллионов ссылок, которую предлагает популярное программное обеспечение для SEO Ahrefs.

Бот Ahrefs ежедневно посещает 6 миллиардов веб-сайтов и считается «вторым по активности поисковым роботом» после Googlebot.

Как и другие боты, бот Ahrefs следует функциям robots.txt , а также разрешает/запрещает правила в коде каждого сайта.

2. Семруш Бот

Semrush Bot позволяет Semrush, ведущему программному обеспечению для SEO, собирать и индексировать данные сайта для использования его клиентами на своей платформе.

Данные используются в общедоступной поисковой системе обратных ссылок Semrush, инструменте аудита сайта, инструменте аудита обратных ссылок, инструменте построения ссылок и помощнике по написанию.

Он сканирует ваш сайт, составляя список URL-адресов веб-страниц, посещая их и сохраняя определенные гиперссылки для будущих посещений.

3. Кампания Moz's Crawler Rogerbot

Rogerbot — сканер для ведущего SEO-сайта Moz. Этот сканер специально собирает контент для аудита сайта Moz Pro Campaign.

Rogerbot следует всем правилам, изложенным в файлах robots.txt , поэтому вы можете решить, хотите ли вы заблокировать или разрешить Rogerbot сканировать ваш сайт.

Веб-мастера не смогут искать статический IP-адрес, чтобы увидеть, какие страницы просканированы Rogerbot, из-за его многогранного подхода.

4. Кричащая лягушка

Screaming Frog — это поисковый робот, который SEO-специалисты используют для аудита своего собственного сайта и определения областей улучшения, которые повлияют на их рейтинг в поисковых системах.

После запуска сканирования вы можете просматривать данные в режиме реального времени и выявлять неработающие ссылки или улучшения, которые необходимы для заголовков ваших страниц, метаданных, роботов, дублированного контента и многого другого.

Для настройки параметров обхода необходимо приобрести лицензию Screaming Frog.

5. Лумар (ранее Deep Crawl)

Lumar — это «централизованный командный центр для поддержания технического состояния вашего сайта». С помощью этой платформы вы можете инициировать обход вашего сайта, чтобы помочь вам спланировать архитектуру вашего сайта.

Lumar гордится тем, что является «самым быстрым сканером веб-сайтов на рынке» и может сканировать до 450 URL-адресов в секунду.

6. Величественный

Majestic в первую очередь фокусируется на отслеживании и идентификации обратных ссылок в URL-адресах.

Компания гордится тем, что у нее есть «один из самых полных источников данных об обратных ссылках в Интернете», что подчеркивает ее исторический индекс, который увеличился с 5 до 15 лет ссылок в 2021 году.

Сканер сайта делает все эти данные доступными для клиентов компании.

7. Когнитивное SEO

Когнитивное SEO — еще одно важное программное обеспечение для SEO, которое используют многие профессионалы.

Когнитивный поисковый робот SEO позволяет пользователям выполнять всесторонний аудит сайта, который будет информировать об архитектуре их сайта и всеобъемлющей стратегии SEO.

Бот просканирует все страницы и предоставит «полностью настраиваемый набор данных», уникальный для конечного пользователя. Этот набор данных также будет содержать рекомендации для пользователей о том, как они могут улучшить свой сайт для других поисковых роботов — как для воздействия на рейтинг, так и для блокировки ненужных сканеров.

8. Сканирование

Oncrawl — это «ведущий в отрасли поисковый робот и анализатор журналов» для корпоративных клиентов.

Пользователи могут настроить «профили сканирования», чтобы создать определенные параметры для сканирования. Вы можете сохранить эти настройки (включая начальный URL-адрес, ограничения сканирования, максимальную скорость сканирования и т. д.), чтобы легко снова запустить сканирование с теми же установленными параметрами.

Нужно ли защищать мой сайт от вредоносных поисковых роботов?

Не все сканеры хороши. Некоторые из них могут негативно повлиять на скорость вашей страницы, в то время как другие могут попытаться взломать ваш сайт или иметь злонамеренные намерения.

Вот почему важно понимать, как заблокировать доступ поисковых роботов на ваш сайт.

Создав список поисковых роботов, вы будете знать, какие поисковые роботы являются хорошими для поиска. Затем вы можете отсеять подозрительные и добавить их в свой черный список.

Как заблокировать вредоносные поисковые роботы

Имея под рукой список поисковых роботов, вы сможете определить, каких ботов вы хотите одобрить, а каких нужно заблокировать.

Первый шаг — просмотреть список поисковых роботов и определить пользовательский агент и полную строку агента, связанную с каждым поисковым роботом, а также его конкретный IP-адрес. Это ключевые определяющие факторы, связанные с каждым ботом.

С помощью пользовательского агента и IP-адреса вы можете сопоставить их в записях вашего сайта с помощью поиска DNS или сопоставления IP-адресов. Если они не совпадают точно, у вас может быть вредоносный бот, пытающийся выдать себя за настоящего.

Затем вы можете заблокировать самозванца, настроив разрешения с помощью тега сайта robots.txt .

Резюме

Поисковые роботы полезны для поисковых систем и важны для понимания маркетологами.

Обеспечение правильного сканирования вашего сайта правильными поисковыми роботами важно для успеха вашего бизнеса. Ведя список поисковых роботов, вы можете знать, каких из них следует остерегаться, когда они появляются в журнале вашего сайта.

Следуя рекомендациям коммерческих поисковых роботов и улучшая содержание и скорость своего сайта, вы облегчите поисковым роботам доступ к вашему сайту и индексацию нужной информации для поисковых систем и потребителей, которые ее ищут.