Lista robotów indeksujących: boty robotów indeksujących i jak je wykorzystać, aby odnieść sukces

Opublikowany: 2022-12-03Dla większości marketerów ciągłe aktualizacje są potrzebne, aby ich strona była świeża i poprawiała rankingi SEO.

Jednak niektóre witryny mają setki, a nawet tysiące stron, co stanowi wyzwanie dla zespołów, które ręcznie przesyłają aktualizacje do wyszukiwarek. Jeśli treść jest aktualizowana tak często, w jaki sposób zespoły mogą zapewnić, że te ulepszenia wpływają na ich rankingi SEO?

W tym miejscu do gry wchodzą boty gąsienicowe. Bot indeksujący przeszuka Twoją mapę witryny w poszukiwaniu nowych aktualizacji i zaindeksuje zawartość w wyszukiwarkach.

W tym poście przedstawimy obszerną listę robotów indeksujących, która obejmuje wszystkie roboty indeksujące, które musisz znać. Zanim przejdziemy do szczegółów, zdefiniujmy roboty indeksujące i pokażmy, jak działają.

Co to jest robot indeksujący?

Robot indeksujący to program komputerowy, który automatycznie skanuje i systematycznie odczytuje strony internetowe w celu indeksowania stron dla wyszukiwarek. Roboty indeksujące są również znane jako pająki lub boty.

Aby wyszukiwarki prezentowały aktualne, odpowiednie strony internetowe użytkownikom inicjującym wyszukiwanie, musi nastąpić indeksowanie przez robota indeksującego. Ten proces może czasami zachodzić automatycznie (w zależności od ustawień robota i Twojej witryny) lub może zostać zainicjowany bezpośrednio.

Wiele czynników wpływa na ranking SEO Twoich stron, w tym trafność, linki zwrotne, hosting i inne. Jednak nic z tego nie ma znaczenia, jeśli Twoje strony nie są przeszukiwane i indeksowane przez wyszukiwarki. Dlatego tak ważne jest upewnienie się, że Twoja witryna umożliwia prawidłowe indeksowanie i usuwanie wszelkich przeszkód na swojej drodze.

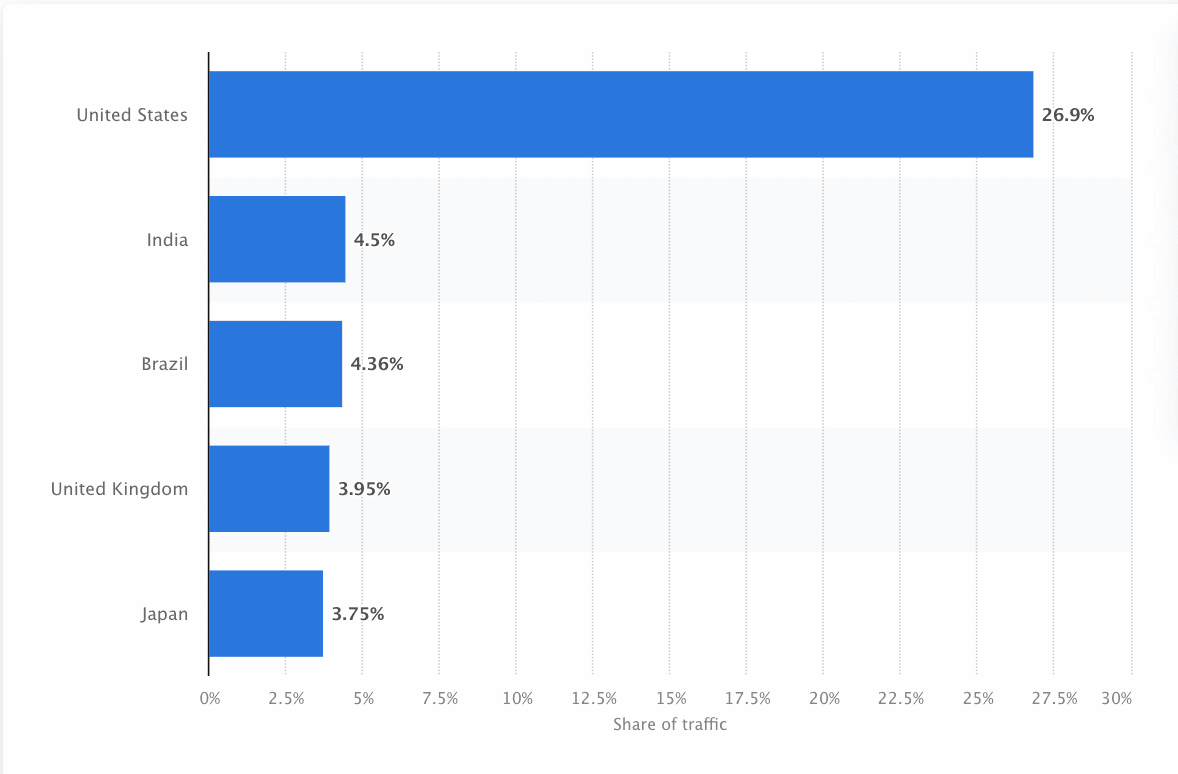

Boty muszą nieustannie skanować i przeglądać sieć, aby zapewnić jak najdokładniejsze informacje. Google jest najczęściej odwiedzaną witryną w Stanach Zjednoczonych, a około 26,9% wyszukiwań pochodzi od użytkowników amerykańskich:

Jednak nie ma jednego robota indeksującego, który przeszukuje każdą wyszukiwarkę. Każda wyszukiwarka ma unikalne mocne strony, więc programiści i marketerzy czasami tworzą „listę robotów indeksujących”. Ta lista robotów indeksujących pomaga im zidentyfikować w dzienniku witryny różne roboty indeksujące, które należy zaakceptować lub zablokować.

Marketerzy muszą zebrać pełną listę robotów indeksujących i zrozumieć, w jaki sposób oceniają swoją witrynę (w przeciwieństwie do skrobaków treści, które kradną treść), aby upewnić się, że poprawnie optymalizują strony docelowe dla wyszukiwarek.

Jak działa robot indeksujący?

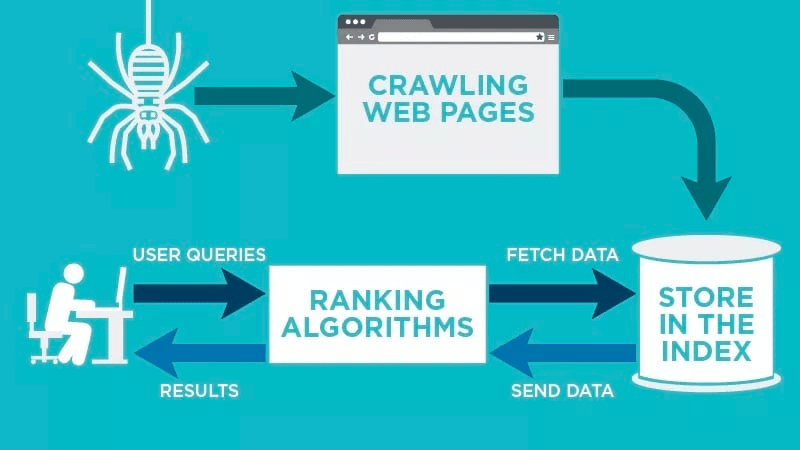

Robot indeksujący automatycznie przeskanuje Twoją stronę internetową po jej opublikowaniu i zaindeksuje Twoje dane.

Roboty indeksujące wyszukują określone słowa kluczowe powiązane ze stroną internetową i indeksują te informacje dla odpowiednich wyszukiwarek, takich jak Google, Bing i inne.

Algorytmy wyszukiwarek pobiorą te dane, gdy użytkownik prześle zapytanie dotyczące odpowiedniego słowa kluczowego, które jest z nim powiązane.

Indeksowanie rozpoczyna się od znanych adresów URL. Są to ustalone strony internetowe z różnymi sygnałami, które kierują roboty indeksujące do tych stron. Tymi sygnałami mogą być:

- Linki zwrotne: Liczba linków do witryny, które prowadzą do niej

- Odwiedzający: jaki ruch kieruje się na tę stronę

- Domain Authority: Ogólna jakość domeny

Następnie przechowują dane w indeksie wyszukiwarki. Gdy użytkownik zainicjuje zapytanie, algorytm pobierze dane z indeksu i pojawi się na stronie wyników wyszukiwania. Proces ten może nastąpić w ciągu kilku milisekund, dlatego wyniki często pojawiają się szybko.

Jako webmaster możesz kontrolować, które boty indeksują Twoją witrynę. Dlatego ważne jest, aby mieć listę robotów indeksujących. To protokół robots.txt znajdujący się na serwerach każdej witryny kieruje roboty indeksujące do nowych treści, które należy zindeksować.

W zależności od tego, co wpisujesz w protokole robots.txt na każdej stronie internetowej, możesz nakazać robotowi indeksującemu przeskanowanie tej strony lub unikanie jej indeksowania w przyszłości.

Rozumiejąc, czego robot indeksujący szuka podczas skanowania, możesz zrozumieć, jak lepiej pozycjonować treść dla wyszukiwarek.

Tworzenie listy robotów indeksujących: jakie są różne typy robotów indeksujących?

Kiedy zaczynasz myśleć o kompilowaniu listy robotów indeksujących, musisz szukać trzech głównych typów robotów indeksujących. Obejmują one:

- Roboty indeksujące wewnętrzne: Są to roboty indeksujące zaprojektowane przez zespół programistów firmy w celu skanowania jej witryny. Zazwyczaj są one używane do audytu i optymalizacji witryny.

- Komercyjne roboty indeksujące: są to niestandardowe roboty indeksujące, takie jak Screaming Frog, których firmy mogą używać do indeksowania i wydajnej oceny swoich treści.

- Roboty indeksujące typu open source : są to bezpłatne roboty indeksujące tworzone przez różnych programistów i hakerów z całego świata.

Ważne jest, aby zrozumieć różne rodzaje istniejących robotów indeksujących, aby wiedzieć, który typ należy wykorzystać do własnych celów biznesowych.

11 najpopularniejszych robotów indeksujących, które możesz dodać do swojej listy robotów indeksujących

Nie ma jednego robota, który wykona całą pracę dla każdej wyszukiwarki.

Zamiast tego istnieje wiele robotów indeksujących, które oceniają Twoje strony internetowe i skanują zawartość wszystkich wyszukiwarek dostępnych dla użytkowników na całym świecie.

Przyjrzyjmy się niektórym z najpopularniejszych obecnie robotów indeksujących.

1. Googlebota

Googlebot to ogólny robot indeksujący Google, który jest odpowiedzialny za indeksowanie witryn wyświetlanych w wyszukiwarce Google.

Chociaż z technicznego punktu widzenia istnieją dwie wersje Googlebota — Googlebot Desktop i Googlebot Smartphone (Mobile) — większość ekspertów uważa Googlebota za jednego robota indeksującego.

Dzieje się tak dlatego, że oba korzystają z tego samego unikalnego tokena produktu (nazywanego tokenem klienta użytkownika) zapisanego w pliku robots.txt każdej witryny. Klient użytkownika Googlebot to po prostu „Googlebot”.

Googlebot zabiera się do pracy i zwykle uzyskuje dostęp do Twojej witryny co kilka sekund (chyba że zablokowałeś go w pliku robots.txt ). Kopia zapasowa zeskanowanych stron jest zapisywana w ujednoliconej bazie danych o nazwie Google Cache. Dzięki temu możesz przeglądać stare wersje swojej witryny.

Ponadto Google Search Console to kolejne narzędzie, którego webmasterzy używają do zrozumienia, w jaki sposób Googlebot indeksuje ich witryny, oraz do optymalizacji stron pod kątem wyszukiwania.

2. Bingbota

Bingbot został stworzony w 2010 roku przez firmę Microsoft w celu skanowania i indeksowania adresów URL w celu zapewnienia użytkownikom platformy Bing odpowiednich, aktualnych wyników wyszukiwania.

Podobnie jak Googlebot, programiści lub marketerzy mogą określić w swoim pliku robots.txt na swojej stronie, czy akceptują, czy nie akceptują identyfikatora agenta „bingbot” do skanowania ich witryny.

Ponadto mają możliwość rozróżnienia robotów indeksujących zorientowanych na urządzenia mobilne i robotów indeksujących na komputery, ponieważ Bingbot niedawno przeszedł na nowy typ agenta. To, wraz z narzędziami Bing dla webmasterów, zapewnia webmasterom większą elastyczność w pokazywaniu, w jaki sposób ich witryna jest wykrywana i prezentowana w wynikach wyszukiwania.

3. Bot Yandex

Yandex Bot to robot indeksujący przeznaczony specjalnie dla rosyjskiej wyszukiwarki Yandex. Jest to jedna z największych i najpopularniejszych wyszukiwarek w Rosji.

Webmasterzy mogą udostępnić strony swojej witryny botowi Yandex za pośrednictwem pliku robots.txt .

Ponadto mogliby dodać tag Yandex.Metrica do określonych stron, ponownie zindeksować strony w Yandex Webmaster lub wydać protokół IndexNow, unikalny raport, który wskazuje nowe, zmodyfikowane lub dezaktywowane strony.

4. Apple Bot

Firma Apple zleciła robotowi Apple Bot przeszukiwanie i indeksowanie stron internetowych na potrzeby sugestii Siri i Spotlight firmy Apple.

Apple Bot bierze pod uwagę wiele czynników przy podejmowaniu decyzji, którą zawartość podnieść w sugestiach Siri i Spotlight. Czynniki te obejmują zaangażowanie użytkowników, trafność wyszukiwanych haseł, liczbę/jakość linków, sygnały oparte na lokalizacji, a nawet projekt strony internetowej.

5. DuckDuck Bot

DuckDuckBot to robot indeksujący dla DuckDuckGo, który oferuje „Bezproblemową ochronę prywatności w Twojej przeglądarce internetowej”.

Webmasterzy mogą korzystać z interfejsu API DuckDuckBot, aby sprawdzić, czy DuckDuck Bot zaindeksował ich witrynę. Podczas indeksowania aktualizuje bazę danych API DuckDuckBot o najnowsze adresy IP i agenty użytkownika.

Pomaga to webmasterom zidentyfikować oszustów lub złośliwe boty, które próbują być powiązane z DuckDuck Bot.

6. Pająk Baidu

Baidu jest wiodącą chińską wyszukiwarką, a Baidu Spider jest jedynym robotem indeksującym witryny.

Google jest zakazane w Chinach, dlatego ważne jest, aby umożliwić Baidu Spider indeksowanie Twojej witryny, jeśli chcesz dotrzeć na chiński rynek.

Aby zidentyfikować Baidu Spider indeksującego Twoją witrynę, poszukaj następujących klientów użytkownika: baiduspider, baiduspider-image, baiduspider-video i innych.

Jeśli nie prowadzisz działalności w Chinach, warto zablokować Baidu Spider w skrypcie pliku robots.txt. Zapobiegnie to przeszukiwaniu Twojej witryny przez Pająka Baidu, eliminując w ten sposób wszelkie szanse na pojawienie się Twoich stron na stronach wyników wyszukiwania Baidu (SERP).

7. Pająk Sogou

Sogou to chińska wyszukiwarka, która podobno jest pierwszą wyszukiwarką z zaindeksowanymi 10 miliardami chińskich stron.

Jeśli prowadzisz interesy na rynku chińskim, jest to kolejny popularny robot wyszukiwarek, o którym musisz wiedzieć. Sogou Spider podąża za tekstem wykluczenia robota i parametrami opóźnienia indeksowania.

Podobnie jak w przypadku Baidu Spider, jeśli nie chcesz robić interesów na rynku chińskim, powinieneś wyłączyć tego pająka, aby zapobiec długiemu ładowaniu witryny.

8. Zewnętrzny hit Facebooka

Facebook External Hit, znany również jako Facebook Crawler, przeszukuje kod HTML aplikacji lub witryny udostępnianej na Facebooku.

Dzięki temu platforma społecznościowa może wygenerować podgląd każdego łącza zamieszczonego na platformie, który można udostępnić. Tytuł, opis i miniatura pojawiają się dzięki robotowi indeksującemu.

Jeśli indeksowanie nie zostanie wykonane w ciągu kilku sekund, Facebook nie pokaże treści w niestandardowym fragmencie wygenerowanym przed udostępnieniem.

9. Eksabot

Exalead to firma programistyczna utworzona w 2000 roku z siedzibą w Paryżu we Francji. Firma dostarcza platformy wyszukiwania dla klientów indywidualnych i korporacyjnych.

Exabot jest robotem indeksującym dla ich podstawowej wyszukiwarki zbudowanej na ich produkcie CloudView.

Podobnie jak większość wyszukiwarek, Exalead bierze pod uwagę zarówno linki zwrotne, jak i zawartość stron internetowych podczas ustalania rankingu. Exabot jest agentem użytkownika robota Exalead. Robot tworzy „główny indeks”, który zestawia wyniki, które zobaczą użytkownicy wyszukiwarki.

10. Swiftbot

Swiftype to niestandardowa wyszukiwarka dla Twojej witryny. Łączy w sobie „najlepszą technologię wyszukiwania, algorytmy, strukturę przetwarzania treści, klientów i narzędzia analityczne”.

Jeśli masz złożoną witrynę z wieloma stronami, Swiftype oferuje przydatny interfejs do katalogowania i indeksowania wszystkich stron.

Swiftbot to robot indeksujący Swiftype. Jednak w przeciwieństwie do innych botów, Swiftbot indeksuje tylko witryny, o które proszą ich klienci.

11. Slurp Bot

Slurp Bot to robot wyszukiwania Yahoo, który przeszukuje i indeksuje strony dla Yahoo.

Indeksowanie to jest niezbędne zarówno dla witryny Yahoo.com, jak i jej witryn partnerskich, w tym Yahoo News, Yahoo Finance i Yahoo Sports. Bez niego odpowiednie wykazy witryn nie byłyby wyświetlane.

Zindeksowana treść przyczynia się do bardziej spersonalizowanego korzystania z sieci dla użytkowników z bardziej trafnymi wynikami.

8 komercyjnych robotów indeksujących, które profesjonaliści SEO powinni znać

Teraz, gdy masz już 11 najpopularniejszych robotów na liście robotów indeksujących, przyjrzyjmy się niektórym popularnym komercyjnym robotom indeksującym i narzędziom SEO dla profesjonalistów.

1. Bot Ahrefs

Bot Ahrefs to robot indeksujący, który kompiluje i indeksuje bazę danych 12 bilionów linków, którą oferuje popularne oprogramowanie SEO, Ahrefs.

Bot Ahrefs codziennie odwiedza 6 miliardów stron internetowych i jest uważany za „drugiego najaktywniejszego robota indeksującego”, zaraz za Googlebotem.

Podobnie jak inne boty, Ahrefs Bot podąża za funkcjami pliku robots.txt , a także dopuszcza/nie zezwala na reguły w kodzie każdej witryny.

2. Bot Semrush

Semrush Bot umożliwia Semrush, wiodącemu oprogramowaniu SEO, zbieranie i indeksowanie danych witryn do użytku klientów na jego platformie.

Dane są wykorzystywane w publicznej wyszukiwarce linków zwrotnych Semrush, narzędziu do audytu witryny, narzędziu do audytu linków zwrotnych, narzędziu do budowania linków i asystencie pisania.

Indeksuje Twoją witrynę, tworząc listę adresów URL stron internetowych, odwiedzając je i zapisując określone hiperłącza do przyszłych odwiedzin.

3. Pełzacz kampanii Moza, Rogerbot

Rogerbot jest robotem indeksującym dla wiodącej witryny SEO, Moz. Ten robot zbiera treści specjalnie na potrzeby audytów witryny Moz Pro Campaign.

Rogerbot przestrzega wszystkich zasad określonych w plikach robots.txt , więc możesz zdecydować, czy chcesz zablokować/zezwolić Rogerbotowi na skanowanie Twojej witryny.

Webmasterzy nie będą mogli wyszukać statycznego adresu IP, aby zobaczyć, które strony przeszukiwał Rogerbot ze względu na jego wielopłaszczyznowe podejście.

4. Wrzeszcząca żaba

Screaming Frog to robot indeksujący, którego specjaliści SEO używają do audytu własnej witryny i identyfikowania obszarów ulepszeń, które wpłyną na ich rankingi w wyszukiwarkach.

Po zainicjowaniu indeksowania możesz przeglądać dane w czasie rzeczywistym i identyfikować niedziałające linki lub potrzebne ulepszenia tytułów stron, metadanych, robotów, zduplikowanych treści i nie tylko.

Aby skonfigurować parametry indeksowania, należy zakupić licencję Screaming Frog.

5. Lumar (dawniej Deep Crawl)

Lumar to „scentralizowane centrum dowodzenia do utrzymywania stanu technicznego witryny”. Dzięki tej platformie możesz zainicjować indeksowanie swojej witryny, aby pomóc w zaplanowaniu architektury witryny.

Lumar szczyci się mianem „najszybszego robota indeksującego strony internetowe na rynku” i szczyci się tym, że może indeksować do 450 adresów URL na sekundę.

6. Majestatyczny

Majestic koncentruje się przede wszystkim na śledzeniu i identyfikowaniu linków zwrotnych w adresach URL.

Firma szczyci się posiadaniem „jednego z najbardziej wszechstronnych źródeł danych o linkach zwrotnych w Internecie”, podkreślając swój historyczny wskaźnik, który wzrósł z 5 do 15 lat linków w 2021 roku.

Robot indeksujący witryny udostępnia wszystkie te dane klientom firmy.

7. kognitywne SEO

CognitiveSEO to kolejne ważne oprogramowanie SEO, z którego korzysta wielu profesjonalistów.

Robot kognitywny SEO umożliwia użytkownikom przeprowadzanie kompleksowych audytów witryny, które będą informować o architekturze witryny i nadrzędnej strategii SEO.

Bot przeszuka wszystkie strony i dostarczy „w pełni dostosowany zestaw danych”, który jest unikalny dla użytkownika końcowego. Ten zestaw danych zawiera również zalecenia dla użytkownika, w jaki sposób może ulepszyć swoją witrynę dla innych robotów indeksujących — zarówno w celu wpłynięcia na rankingi, jak i zablokowania robotów, które są niepotrzebne.

8. Czołganie się

Oncrawl to „wiodący w branży robot SEO i analizator logów” dla klientów korporacyjnych.

Użytkownicy mogą skonfigurować „profile indeksowania”, aby utworzyć określone parametry indeksowania. Możesz zapisać te ustawienia (w tym początkowy adres URL, limity indeksowania, maksymalną prędkość indeksowania i inne), aby łatwo ponownie uruchomić indeksowanie z tymi samymi ustalonymi parametrami.

Czy muszę chronić swoją witrynę przed złośliwymi robotami indeksującymi?

Nie wszystkie roboty są dobre. Niektóre mogą negatywnie wpłynąć na szybkość Twojej strony, podczas gdy inne mogą próbować zhakować Twoją witrynę lub mieć złośliwe zamiary.

Dlatego ważne jest, aby wiedzieć, jak zablokować robotom indeksującym dostęp do Twojej witryny.

Tworząc listę robotów indeksujących, dowiesz się, które roboty indeksujące są dobre, na które należy zwrócić uwagę. Następnie możesz przeglądać te podejrzane i dodawać je do listy zablokowanych.

Jak blokować złośliwe roboty indeksujące

Mając w ręku listę robotów indeksujących, będziesz w stanie określić, które boty chcesz zatwierdzić, a które należy zablokować.

Pierwszym krokiem jest przejrzenie listy przeszukiwaczy i zdefiniowanie agenta użytkownika oraz pełnego ciągu znaków agenta, który jest powiązany z każdym przeszukiwaczem, a także jego konkretny adres IP. Są to kluczowe czynniki identyfikujące, które są powiązane z każdym botem.

Dzięki agentowi użytkownika i adresowi IP możesz dopasować je w rekordach witryny za pomocą wyszukiwania DNS lub dopasowania adresu IP. Jeśli nie pasują dokładnie, może to oznaczać, że złośliwy bot próbuje udawać rzeczywistego.

Następnie możesz zablokować oszusta, dostosowując uprawnienia za pomocą tagu witryny robots.txt .

Streszczenie

Roboty indeksujące są przydatne dla wyszukiwarek i ważne do zrozumienia dla marketerów.

Zapewnienie, że witryna jest prawidłowo indeksowana przez odpowiednie roboty, jest ważne dla sukcesu Twojej firmy. Prowadząc listę robotów indeksujących, możesz wiedzieć, na które z nich uważać, gdy pojawiają się w dzienniku witryny.

Postępując zgodnie z zaleceniami komercyjnych robotów indeksujących i poprawiając zawartość i szybkość swojej witryny, ułatwisz robotom indeksującym dostęp do Twojej witryny i indeksowanie właściwych informacji dla wyszukiwarek i konsumentów, którzy ich szukają.