7 erreurs de test A/B à éviter

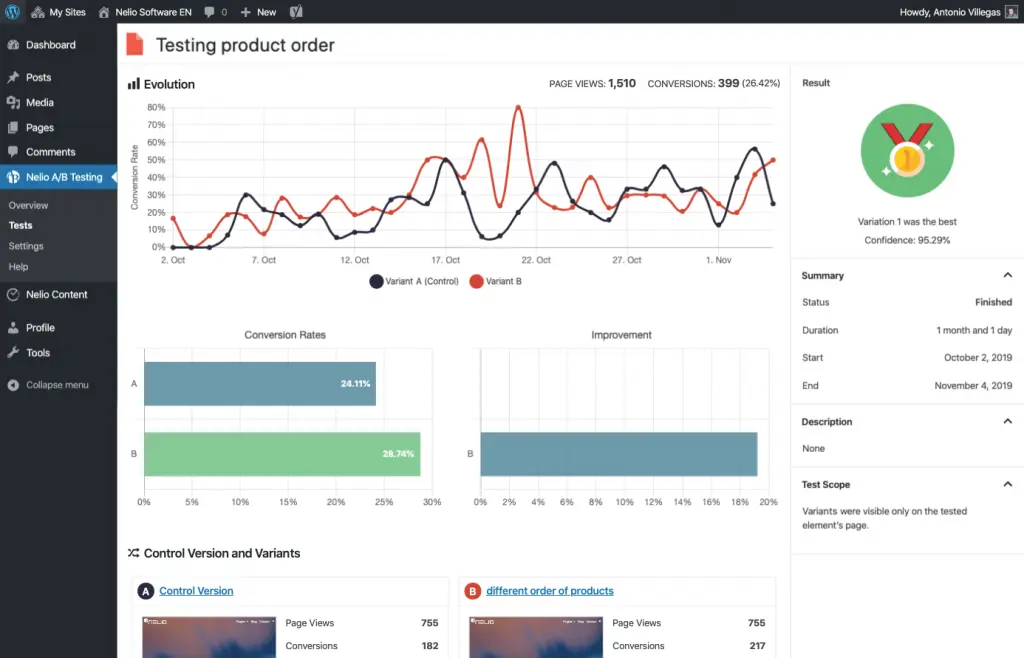

Publié: 2020-04-14Les tests A/B sont le meilleur outil pour améliorer le taux de conversion de n'importe quel site (ventes, abonnements ou toute autre action qui pourrait vous intéresser). Après avoir créé deux versions ou plus d'une page ou d'un article sur votre site Web, vous pouvez savoir, avec des données et non des hypothèses, laquelle fonctionne le mieux.

Mais si la théorie est bonne, attention à la pratique. Avant de commencer à faire des tests A/B de vos pages, assurez-vous de ne pas faire d'erreurs qui pourraient conduire à des résultats illusoires. Cela pourrait finir par être une perte de temps et d'argent que vous devriez éviter à tout prix.

Voyons quelles erreurs vous devez éviter lors de la création de tests A/B…

#1 Comparer différentes périodes de temps

Il peut être tentant d'analyser en détail le comportement et la conversion de vos visiteurs sur l'une de vos pages pendant un certain temps. Ensuite, apportez des modifications au Web et analysez à nouveau le détail du comportement sur votre site.

Dans ce contexte, il semble assez facile de conclure que si vous avez obtenu de meilleurs résultats durant la première ou la seconde période c'est parce que la version testée durant cette période est meilleure que l'autre.

Eh bien, je suis désolé de vous dire que ce n'est pas une bonne idée. Pour commencer, la quantité et la qualité du trafic qui atteint votre site Web peuvent varier entre les jours et les semaines. La même page peut un jour ou une semaine convertir 15% et le jour ou la semaine suivante 12%.

Ce changement peut être dû à des facteurs totalement étrangers à votre site (climat économique, humeur de vos visiteurs, etc). Par exemple, grâce à un tweet qui devient viral, vous augmentez le trafic sur votre site web. Mais le type de trafic est de moindre qualité et après avoir atteint votre site Web, il convertit moins. Autre exemple : vous lancez une nouvelle annonce sur Google avec une offre et le pourcentage de visiteurs qui accèdent à votre site Web via l'annonce et qui se convertissent ensuite est très élevé.

Par conséquent, la seule façon de prendre en compte tous ces facteurs est d'effectuer un test A/B où chaque variante est présentée à un nombre proportionnel de visiteurs au cours de la même période. En montrant au hasard les deux versions (ou plus) aux visiteurs au cours de la même semaine, il y a une probabilité beaucoup plus grande que les résultats soient statistiquement pertinents.

Alors oubliez de faire un test avant et après car vous ne saurez pas avec certitude à quel point les résultats sont pertinents pour décider quelle version est la meilleure.

#2 Terminer le test plus tôt

Maintenant que vous savez que vous devez faire des tests A/B, vous venez d'installer Nelio A/B Testing et vous êtes impatient de lancer votre test de première page.

Vous commencez à collecter des résultats et rapidement la variante commence à avoir plus de conversions que la page d'origine. Pourquoi perdre du temps ? Pourquoi ne pas faire un changement rapide et rendre la nouvelle variante permanente ? Cela augmentera les conversions plus rapidement…

Le volume

Les tests A/B sont basés sur des statistiques et, à ce titre, il est important de garder à l'esprit que la taille de votre échantillon est importante - elle doit être représentative. En d'autres termes, nous devons nous assurer que nous avons obtenu suffisamment de résultats de notre test pour que le test reflète adéquatement la réalité.

Si vous utilisez un outil spécialisé pour effectuer des tests A/B, comme Nelio A/B Testing, l'outil lui-même vous informera si vos résultats de test sont statistiquement significatifs.

Alors vous pourriez penser que, puisque vous avez un site Web avec beaucoup de trafic, vous obtiendrez rapidement des résultats à partir de ce qui fonctionne le mieux.

Durée

Fais attention! Il y a un autre facteur à prendre en compte lors de la création de tests A/B. Non seulement c'est une question de volume, mais assurez-vous que vos tests durent suffisamment longtemps pour couvrir un cycle de votre entreprise. Autrement dit, si, par exemple, le type de trafic que vous recevez est différent les jours de semaine et le week-end, assurez-vous qu'un test dure la période de temps minimale pour que tous les types de trafic soient représentés.

Je vous recommande le calculateur CXL pour explorer un peu plus la durée et la taille qu'un test A/B devrait avoir pour que ses résultats soient statistiquement significatifs.

Rappelez-vous : tirer des conclusions à l'avance revient à prendre des décisions par intuition.

#3 Terminer le test trop tard

Passons maintenant à l'autre extrême : vous venez de lancer un test et vous obtenez des résultats différents. Puisque vous savez que vous ne pouvez pas tirer de conclusions trop tôt, vous décidez d'attendre d'avoir des données concluantes, n'est-ce pas ? Les jours passent et aucune variante ne semble nettement meilleure que l'autre, alors peut-être faut-il encore attendre…

Eh bien, nous vous avons déjà dit de ne pas vous précipiter, mais si vous avez passé trois mois sans résultats concluants, vous perdez probablement votre temps. Et vous le gaspillez pour la simple raison que vous manquez d'autres types de tests qui pourraient probablement vous donner des informations beaucoup plus pertinentes sur la façon d'optimiser la conversion.

#4 S'appuyer sur les tests des autres

Nous pouvons et devons apprendre des autres, mais je crains que les données statistiques des autres ne s'appliquent pas nécessairement à votre site Web. Autrement dit, vous avez probablement lu un article commentant que la couleur du bouton d'appel à l'action qui fonctionne le mieux est le rouge.

La théorie est très bonne mais la réalité est que vous ne décidez pas que ce résultat va être utile sans d'abord le tester sur votre site Web. Les études de cas d'autres personnes ne sont pas utiles pour prendre des décisions concernant votre cas particulier. Ils vous seront utiles pour avoir de nouvelles idées sur ce que vous pourriez tester.

#5 Modifier un test en cours

L'une des pires erreurs que vous puissiez commettre après avoir lancé un test AB sur votre site Web est peut-être de l'arrêter, d'apporter certaines modifications et de le reprendre. Au mieux, corrigez une petite faute de frappe que vous détectez, mais ne créez pas de nouvelles variantes et ne modifiez pas celles qui sont déjà en cours d'exécution. Ces changements peuvent totalement invalider les résultats obtenus.

Si vous vous trouvez dans une situation où vous souhaitez apporter des modifications à un test A/B en cours, arrêtez-le complètement et exécutez un nouveau test. Les deux tests séparément vous donneront des résultats valides. Si vous le souhaitez, essayez d'interpréter les résultats des deux ensemble, mais sachez que vous ne pourrez pas obtenir de résultats fiables si vous apportez des modifications à un test A/B en cours.

#6 Exécuter plusieurs tests simultanément

Simplifiez-vous la vie avec les tests A/B. Si vous essayez d'analyser trop de changements à la fois, il vous sera particulièrement difficile d'interpréter les résultats de chaque test. Vous pouvez créer deux ou plusieurs variantes d'une page qui en affichent des versions radicalement différentes. C'est OK de le faire, et en fait, il a été étudié que des changements majeurs peuvent avoir un impact plus important sur la conversion.

Cependant, n'essayez pas d'effectuer plusieurs tests simultanément. Pour chaque nouveau test que vous créez, une nouvelle répartition du trafic sera créée aux différentes combinaisons possibles de variantes avec celles précédemment créées. Et précisément, plus vous finirez par avoir de variantes, plus votre trafic sera divisé et plus il vous en coûtera pour obtenir des résultats statistiquement significatifs.

#7 Ne pas connaître le but de votre test

Et cela devrait être l'erreur la plus importante à éviter.

Le but d'un test A/B est d'optimiser la conversion. D'accord. À partir de là, appliquez le bon sens. Toutes les pages et tous les messages ont un but sur votre site Web : informer sur les produits et services que vous proposez, vous faire connaître, expliquer en détail le fonctionnement du produit ou service, vous assurer que vous respectez la loi sur la protection des données, etc. Bien qu'ils soient tous importants, certains d'entre eux sont beaucoup plus critiques dans l'entonnoir de conversion.

Par exemple, si vous avez un e-commerce, les pages les plus pertinentes seront celles qui montrent tous les produits, celles qui montrent le détail d'un produit et la page où l'achat payant est effectué. Donc, pour commencer, ne vous embourbez pas en analysant d'autres pages et concentrez-vous sur l'optimisation de celles-ci.

Aussi, réfléchissez bien aux objectifs les plus importants dans chacun d'eux :

- Laissez le visiteur acheter ce produit.

- Laissez le visiteur ajouter ce produit à la liste de souhaits ou au panier.

- Demandez-leur de regarder d'autres produits connexes.

- Recommander l'achat de ces produits à des tiers.

- Pour vous contacter pour plus d'informations.

Identifiez bien vos objectifs et réfléchissez aux améliorations qui peuvent vous aider à les atteindre. À partir de là, les tests qui, selon vous, auront du sens et aideront à améliorer votre site Web.

Image sélectionnée par Sarah Kilian sur Unsplash.