検索エンジンインデックスの仕組みの基本

公開: 2022-04-17検索エンジン最適化(SEO)は、Webサイトの可視性を高め、より多くのオーガニックトラフィックを引き付けるために不可欠な方法です。 ただし、これは、アルゴリズムを理解し、さまざまなランキング要素を活用することに依存する複雑な戦略です。 あなたがSEOの専門家になることを探しているなら、あなたは検索エンジンの索引付けを理解する必要があるでしょう。

この投稿では、検索エンジンがWebサイトにインデックスを付ける方法と、ランキングを上げる方法について説明します。 また、このSEOの概念に関してよく寄せられる質問にも回答します。 始めましょう!

検索エンジンインデックスとは何ですか?

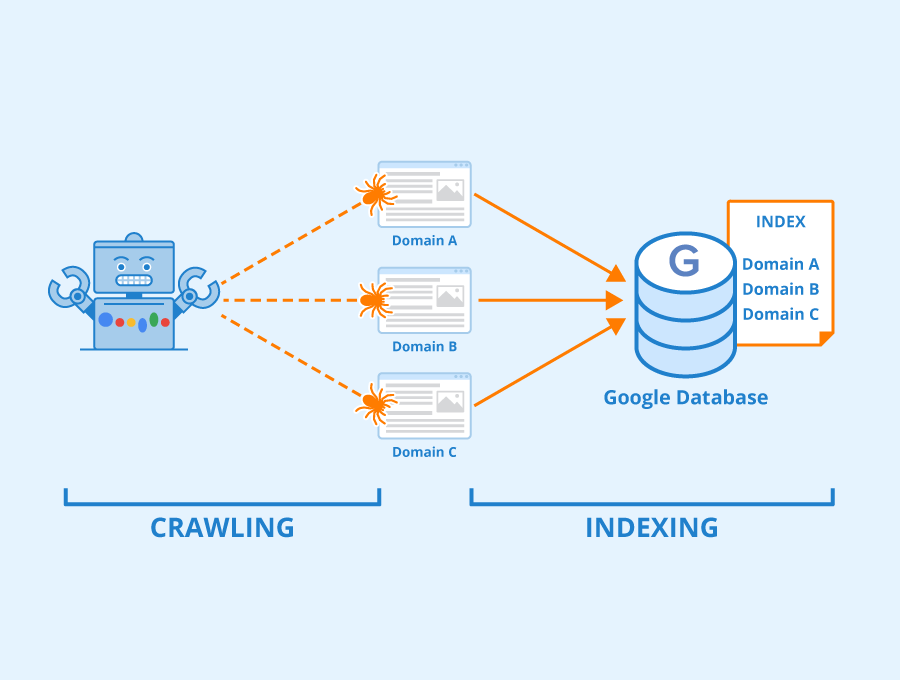

検索エンジンのインデックス作成とは、検索エンジン(Googleなど)がオンラインコンテンツを整理して中央データベース(そのインデックス)に保存するプロセスを指します。 その後、検索エンジンはコンテンツを分析して理解し、検索エンジン結果ページ(SERP)のランク付けされたリストの読者にコンテンツを提供できます。

Webサイトのインデックスを作成する前に、検索エンジンは「クローラー」を使用してリンクとコンテンツを調査します。 次に、検索エンジンはクロールされたコンテンツを取得し、データベースに整理します。

画像ソース:Seobility –ライセンス:CC BY-SA 4.0

次のセクションでは、このプロセスがどのように機能するかを詳しく見ていきます。 今のところ、インデックス作成は、Webサイトの投稿やページ、ビデオ、画像、その他のコンテンツのオンラインファイリングシステムと考えると役立ちます。 グーグルに関して言えば、このシステムはグーグルインデックスとして知られている巨大なデータベースです。

検索エンジンはどのようにサイトにインデックスを付けますか?

Googleのような検索エンジンは、「クローラー」を使用してオンラインコンテンツを探索し、分類します。 これらのクローラーは、リンクをたどり、Webページをスキャンし、Webサイトに関するできるだけ多くのデータを取得するソフトウェアボットです。 次に、インデックスを作成するために検索エンジンのサーバーに情報を配信します。

画像ソース:Seobility –ライセンス:CC BY-SA 4.0

コンテンツが公開または更新されるたびに、検索エンジンはコンテンツをクロールしてインデックスを作成し、その情報をデータベースに追加します。 このプロセスは自動的に発生する可能性がありますが、サイトマップを検索エンジンに送信することで処理を高速化できます。 これらのドキュメントは、検索エンジンがコンテンツをより効果的にクロールして理解するのに役立つ、リンクを含むWebサイトのインフラストラクチャの概要を示しています。

検索エンジンのクローラーは「クロール予算」で動作します。 この予算は、ボットが設定された期間内にWebサイトでクロールしてインデックスを作成するページ数を制限します。 (ただし、戻ってきます。)

クローラーは、キーワード、公開日、画像、ビデオファイルなどの重要なデータに関する情報を編集します。 検索エンジンは、内部リンクと外部URLをたどってインデックスを作成することにより、さまざまなページとWebサイト間の関係も分析します。

検索エンジンのクローラーは、Webサイト上のすべてのURLをたどるわけではないことに注意してください。 それらは、nofollowに相当するものを無視して、dofollowリンクを自動的にクロールします。 したがって、リンク構築の取り組みでは、dofollowリンクに焦点を当てる必要があります。 これらは、コンテンツを指す外部サイトからのURLです。

外部リンクが高品質のソースからのものである場合、クローラーが別のサイトからあなたのサイトにそれらをたどるときに、それらは「リンクジュース」を渡します。 そのため、これらのURLは、SERPでのランキングを上げることができます。

画像ソース:Seobility –ライセンス:CC BY-SA 4.0

さらに、一部のコンテンツは検索エンジンでクロールできないことに注意してください。 ページがログインフォームやパスワードの背後に隠れている場合、または画像にテキストが埋め込まれている場合、検索エンジンはそのコンテンツにアクセスしてインデックスを作成できません。 (ただし、代替テキストを使用して、これらの画像を単独で検索に表示させることができます。)

検索エンジンインデックス作成のための4つのツール

いくつかのツールを使用して、Googleや他の検索エンジンがコンテンツをクロールしてインデックスに登録する方法をガイドできます。 最も役立つオプションのいくつかを見てみましょう!

1.サイトマップ

サイトマップには、XMLとHTMLの2種類があることに注意してください。 これらの2つの概念は、どちらも-MLで終わるタイプのサイトマップであるため、混乱しがちですが、目的は異なります。

HTMLサイトマップは、Webサイトのすべてのコンテンツを一覧表示するユーザーフレンドリーなファイルです。 たとえば、通常、これらのサイトマップの1つはサイトのフッターにあります。 Apple.comを一番下までスクロールすると、次のHTMLサイトマップが表示されます。

このサイトマップを使用すると、訪問者はWebサイトを簡単にナビゲートできます。 これは一般的なディレクトリとして機能し、SEOにプラスの影響を与え、確かなユーザーエクスペリエンス(UX)を提供します。

対照的に、XMLサイトマップには、Webサイトのすべての重要なページのリストが含まれています。 このドキュメントを検索エンジンに送信すると、検索エンジンがコンテンツをより効果的にクロールしてインデックスに登録できるようになります。

この記事でサイトマップについて説明するときは、XMLドキュメントを参照することに注意してください。 また、XMLサイトマップを作成するためのガイドを確認することをお勧めします。これにより、さまざまな検索エンジンでドキュメントを使用できるようになります。

2.Google検索コンソール

SEOの取り組みをGoogleに集中させたい場合、Google検索コンソールは習得するための不可欠なツールです。

コンソールでは、インデックスカバレッジレポートにアクセスできます。このレポートは、Googleによってインデックスが作成されたページを示し、プロセス中の問題を強調表示します。 ここでは、問題のあるURLを分析し、トラブルシューティングして「インデックス可能」にすることができます。

さらに、XMLサイトマップをGoogle検索コンソールに送信できます。 このドキュメントは「ロードマップ」として機能し、Googleがコンテンツをより効果的にインデックスに登録するのに役立ちます。 さらに、Googleにサイトの特定のURLと一部を再クロールするように依頼して、Googleのクローラーがサイトに戻るのを待たずに、更新されたトピックを常に視聴者が利用できるようにすることができます。

3.代替検索エンジンコンソール

グーグルは最も人気のある検索エンジンですが、それが唯一の選択肢ではありません。 Googleに限定すると、Bingなどの代替ソースからのトラフィックに対してサイトが閉鎖される可能性があります。

XMLサイトマップをBingWebmasterToolsおよびYandexWebmasterToolsに送信するためのガイドを確認することをお勧めします。 残念ながら、YahooやDuckDuckGoなどの他の検索エンジンでは、サイトマップを送信できません。

これらの各コンソールには、SERPでのサイトのインデックス作成とランキングを監視するための独自のツールが用意されていることに注意してください。 したがって、SEO戦略を拡大したい場合は、それらを試してみることをお勧めします。

4. Robots.txt

サイトマップを使用して、検索エンジンにWebサイトの特定のページにインデックスを付けるように指示する方法についてはすでに説明しました。 さらに、 robots.txtファイルを使用して特定のコンテンツを除外できます。

robots.txtファイルには、サイトに関するインデックス情報が含まれています。 ルートディレクトリ内に保存され、2行あります。検索エンジンクローラーを指定するuser-agent行と、特定のファイルをブロックするdisallowディレクティブです。

たとえば、 robots.txtファイルは次のようになります。

ユーザーエージェント: * 禁止:/ example_page / 禁止:/ example_page_2 /

この例では、 *はすべての検索エンジンクローラーを対象としています。 次に、 disallow行は特定のファイルまたはURLパスを指定します。

単純なテキストファイルを作成し、 robots.txtという名前を付けるだけです。 次に、許可しないデータを追加し、ファイル転送プロトコル(FTP)クライアントを使用してファイルをルートディレクトリにアップロードします。

よくある質問

これまで、検索エンジンのインデックス作成の基本について説明してきました。 このSEOの概念についてまだ質問がある場合は、ここで回答します。 (まだお持ちの場合は、コメントでお知らせください。そこでお答えします!)

どうすれば検索エンジンでより良いインデックスを取得できますか?

サイトマップを作成し、クロールエラーがないか監査し、複数の検索エンジンに送信することで、検索エンジンのインデックスを作成しやすくなります。 さらに、モバイルデバイス向けにコンテンツを最適化し、読み込み時間を短縮して、クロールとインデックス作成を高速化することを検討する必要があります。

コンテンツを頻繁に更新すると、検索エンジンに「新しい」ページをクロールしてインデックスを作成するように警告することもできます。 最後に、 robots.txtファイルを使用するか削除して、検索エンジンが重複コンテンツをクロールしないようにすることをお勧めします。

自分のサイトをクロールするために検索エンジンをリクエストする必要がありますか?

検索エンジンはインターネット上で公開されている新しいコンテンツをクロールしますが、このプロセスには数週間から数か月かかる場合があります。 したがって、選択した検索エンジンにサイトマップを送信することで、処理を高速化することをお勧めします。

新しいコンテンツを公開した場合、検索エンジンに警告する必要がありますか?

新しいコンテンツを公開するときは、サイトマップを更新することをお勧めします。 このアプローチにより、投稿がより迅速にクロールされ、インデックスに登録されます。 サイトマップを簡単に生成するには、YoastSEOなどのプラグインを使用することをお勧めします。

私のコンテンツがGoogleや他の検索エンジンから削除されたことはありますか?

コンテンツが利用規約に違反している場合、Googleはその投稿またはページをインデックスから削除する場合があります。 これは、多くの場合、コンテンツがプライバシー、名誉毀損、著作権、またはその他の法律に違反していることを意味します。 また、Googleは、識別可能な財務情報や医療情報などの個人データをインデックスから削除します。 最後に、GoogleはブラックハットSEO技術を使用するページにペナルティを科す場合があります。

コンテンツが削除された場合、どうすればコンテンツのインデックスを再作成できますか?

検索エンジンのウェブマスター品質ガイドラインを満たすようにコンテンツを変更することで、コンテンツのインデックスを再作成するようGoogleに依頼できます。 次に、再審査リクエストを送信して、Googleの応答が表示されるのを待つことができます。

検索エンジンが特定のページにインデックスを付けるのを防ぐにはどうすればよいですか?

ページの<head>セクションにnoindexメタタグを追加することで、検索エンジンが特定のページにインデックスを付けるのを防ぐことができます。 または、コンテンツがメディアファイルの場合は、 robots.txtファイルに追加できます。 最後に、Googleウェブマスターツールを使用すると、URLの削除ツールを使用してページを非表示にできます。

結論

SEOは、検索エンジンアルゴリズムからオフページ最適化手法まで、あらゆるものを網羅する幅広い分野です。 このトピックに慣れていない場合は、すべての情報に圧倒されていると感じるかもしれません。 幸いなことに、索引付けは理解しやすい概念の1つです。

検索エンジンのインデックス作成は、Webサイトのコンテンツを中央データベースに編成するための重要なプロセスです。 検索エンジンのクローラーは、サイトのコンテンツとアーキテクチャを分析して分類します。 次に、特定の検索用語の結果ページでページをランク付けできます。

検索エンジンのインデックス作成について他に質問がありますか? 以下のコメントセクションでお知らせください。

Sammby/shutterstock.com経由の注目の画像