WordPress で robots.txt を編集する方法 (プラグインあり、なし)

公開: 2023-05-25WordPress で robots.txt を編集する最も効果的な方法をお探しですか? これらは、検索エンジンのクローラーに、クロールしてインデックスを付ける必要がある Web サイトのページとセクションを知らせる場合に非常に重要です。

WordPress はデフォルトで Web サイトの robots.txt ファイルを生成しますが、検索エンジンが表示できるものを管理するためにファイルを変更する必要がある場合があります。 robots.txt に詳しくなくても、心配する必要はありません。 このチュートリアルでは、robots.txt とは何か、それを編集することが不可欠な理由、および WordPress ウェブサイト上で robots.txt を編集するためのさまざまな方法について説明します。

それでは、robots.txt とは何かを理解しましょう。

Robots.txt とは何ですか?

Robots.txt は、Web サイトのルート ディレクトリにあるプレーン テキスト ファイルで、Web ロボットまたはボットがサイトのどのページまたは領域をクロールしてインデックスを付ける必要があるかについての指示が含まれています。 このファイルは、Web サイトの特定の規制に基づいて、ページまたはセクションをインデックスに登録するかどうかを検索エンジンに指示します。

たとえば、Google Web クローラーなどの Web クローラーは Web サイトを定期的にチェックして、ページのインデックスを更新します。 Google のこれらの Web クローラー (Googlebot とも呼ばれます) は、robots.txt ファイルに記載されている指示に従って Web サイトをチェックします。

robots.txt ファイルの主な目的は、Web マスターがサイト上で検索エンジンがアクセスできる情報を制御できるようにすることです。 このファイルを使用すると、ボットが特定のサイトまたはディレクトリにアクセスするのを防ぐことができます。 ただし、Googlebot やその他の有名な Web クローラー以外の一部のボットは、ファイル内のガイドラインに従っていない可能性があることに注意してください。

Robots.txt ファイルを編集する必要があるのはなぜですか?

WordPress で robots.txt ファイルを編集すると、いくつかの利点があります。 以下にいくつかの考慮事項を示します。

- 不要なボットをブロックする:一部のボットは Web サイトにとって有益ではない場合や、サーバー上の貴重なリソースを消費する可能性があります。 これにより、Web サイトの読み込み時間が遅くなり、サイトのパフォーマンスが低下する可能性があります。 そのため、robots.txt ファイルを編集すると、不要なボットがサイトをクロールするのをブロックし、Web サイト全体の速度を向上させることができます。

- 機密情報を保護する: Web サイトの特定のページには、検索エンジンにインデックスを付けたくない機密情報が含まれている場合があります。 これには、個人データ、ビジネスの機密情報、パスワードで保護されたコンテンツ、さらには法的またはコンプライアンス関連のコンテンツが含まれる場合があります。

robots.txt ファイルを編集することで、これらのページがクロールされたりインデックスが作成されたりするのを防ぐことができます。 これは、Web サイトのプライバシーとセキュリティの保護にも役立ちます。 - ボットを特定のページに誘導する: robots.txt を使用して、検索エンジンにクロールしてインデックスを作成させたい Web サイト上の特定のページにボットを誘導することもできます。 これにより、検索エンジンの結果で上位に表示したいページに優先順位を付けることができます。

- 重複したコンテンツのインデックス作成を防止する: Web サイト上に、カテゴリ ページやタグ ページなど、類似したコンテンツを含むページがある場合があります。 その場合は、robots.txt ファイルを使用して、検索エンジンのボットによるインデックス作成を防ぐことができます。 これにより、Web サイトの検索エンジンのランキングに悪影響を与える重複コンテンツの問題を回避できます。

robots.txt ファイルとは何か、そしてそれらが不可欠である理由は理解できたので、次のセクションに進み、それをカスタマイズする方法を説明します。

WordPress で Robots.txt を編集する方法

WordPress では、robots.txt ファイルを次の 3 つの主な方法で編集できます。

- FTPクライアントの使用

- cパネル

- プラグインを使用する

これらの各アプローチについて詳しく説明します。 ただし、 FTP クライアントまたは cPanel アプローチを使用する場合は、最初にrobots.txt ファイルを手動で作成する必要があります。

WordPress は、サイトを起動するとデフォルトで仮想 robots.txt ファイルを作成します。 ドメインの末尾にパス「 /robots.txt 」を追加することでアクセスできます。

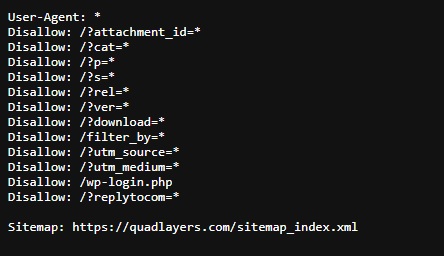

たとえば、リンク「https://quadlayers.com/robots.txt」を使用して、QuadLayers の robots.txt ファイルにアクセスできます。

ただし、デフォルトの robots.txt ファイルは使用しません。 これは、QuadLayers の特定のニーズを満たすように編集されています。 ただし、WordPress によって作成されるデフォルトの robots.txt ファイルには、次の情報のみが含まれます。

ユーザーエージェント: * 禁止: /wp-admin/ 許可: /wp-admin/admin-ajax.php

残念ながら、このファイルは仮想ファイルであるため編集できません。 WordPress Web サイトの robots.txt ファイルを編集するには、手動でファイルを作成する必要があります。

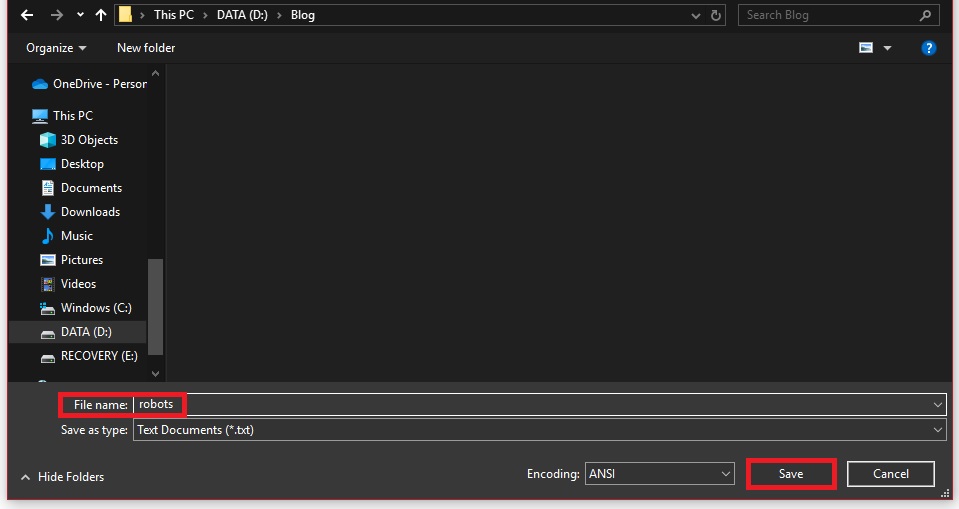

これを行うには、任意のテキスト エディタを使用して空のファイルを作成し、そのファイルを「 robots.txt 」として保存します。

あるいは、SEO プラグインを使用してファイルを編集する場合は、プラグインを通じて自動的に編集できます。 これについては、このガイドの後半で学習します。

ただし、どのようなアプローチを使用する場合でも、robots.txt ファイルには同じ情報が含まれている必要があります。 それでは、robots.txt ファイルに何を含める必要があるか見てみましょう。

Robots.txt ファイルには何を含めるべきですか?

検索エンジンが Web サイトのインデックスを適切に作成できるようにするために、robots.txt ファイルに含めることができるコード コマンドまたはディレクティブをいくつか示します。

- ユーザー エージェント:指示が適用される検索エンジンまたはボットを識別します。 制御するボットに応じて、robots.txt ファイルに 1 つ以上のユーザー エージェントを含めることができます。 たとえば、「ユーザー エージェント: Googlebot」は、Google の Web クローラーを指します。

- Disallow:このディレクティブは、検索エンジン ボットがクロールまたはインデックスを作成してはならないページまたはディレクトリをボットに指示します。 個々のページまたはディレクトリ全体を指定できます。 たとえば、「Disallow: /wp-admin/」と指定すると、すべてのボットが WordPress 管理ディレクトリ内のページをクロールできなくなります。

- サイトマップ:このディレクティブは、Web サイトのサイトマップ ファイルの場所をボットに指示します。 サイトマップ ファイルには、検索エンジンにインデックスを作成するサイト上のすべてのページがリストされます。

robots.txt ファイルで「 allow 」ディレクティブを使用することもできます。 これは、ボットにどのページまたはディレクトリをクロールまたはインデックス付けする必要があるかを指示します。 ただし、これはオプションであり、必要な場合にのみ使用する必要があることに注意してください。

基本的な robots.txt ファイルの例を次に示します。

ユーザーエージェント: * 禁止: /wp-admin/ 禁止: /wp-includes/ サイトマップ: https://www.example.com/sitemap.xml

この例では、ユーザー エージェントが「*」に設定されています。これは、指示がすべてのボットに適用されることを意味します。 「disallow」ディレクティブは、ボットが WordPress 管理ディレクトリと「wp-include」ディレクトリをクロールするのをブロックします。 同様に、サイトマップ ディレクティブはサイトマップ ファイルの場所を指定します。

robots.txt ファイルに何を含めるべきかについて基本を理解したので、ボットにクロールまたはインデックスを作成させたくない Web ページをすべて追加できます。 最後に、ファイルを保存します。

1) FTP クライアントを使用して Robots.txt を編集する

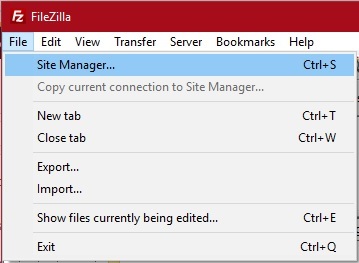

FTP クライアントを使用して WordPress で robots.txt を編集するには、FTP クライアントをインストールし、Web サイトに接続する必要があります。 この方法に使用できる FileZilla や Cyberduck などの FTP クライアントが多数あります。 ただし、このチュートリアルではFileZillaを使用します。

1.1) WordPress ウェブサイトを FTP に接続します

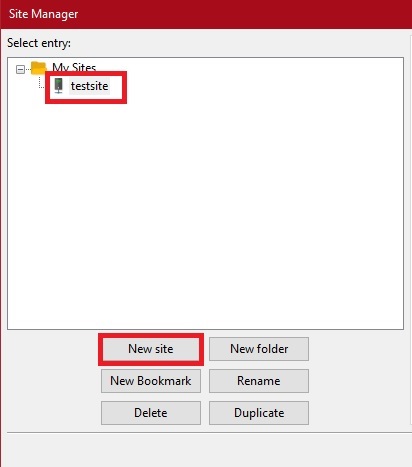

FTP クライアントをインストールした後、アプリケーションを開き、 [ファイル] > [サイト マネージャー]に移動します。 キーボードのCtrl+Sを押してサイト マネージャーを開くこともできます。

次に、 [新しいサイト]をクリックし、 [個人用サイト]に Web サイトの名前を入力します。

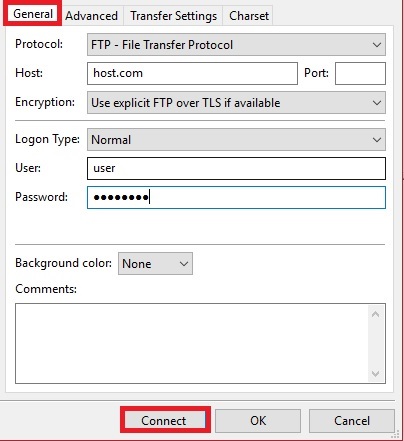

ここで、 「全般」タブを開き、サイトの資格情報を入力します。 Web サイトを FileZilla に接続するための資格情報をホスティング サービスから取得できます。

資格情報を入力したら、 「接続」をクリックします。

サイトに接続すると、コンピュータからサイトのファイル ディレクトリにアクセスできます。 それでは、robots.txt ファイルをコンピュータから Web サイトにアップロードしましょう。

1.2) Robots.txt ファイルを WordPress にアップロードします

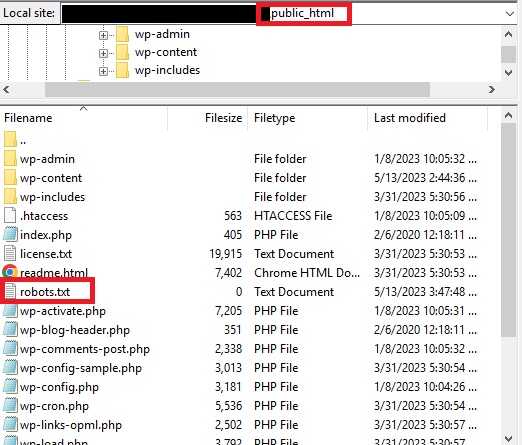

サイトを FTP クライアントに接続したら、Web サイトのルート ディレクトリに移動する必要があります。これは、robots.txt ファイルが配置される場所であるためです。

ルート ファイルは「 public_html 」ファイルとも呼ばれます。

最近作成した robots.txt ファイルをここにアップロードできます。 robots.txt ファイルがこのファイル内にすでに存在する場合は、それを置き換えます。

それでおしまい!

あとは、前の例で示したように、ドメインの末尾に「/robots.txt」パスを追加して robots.txt ファイルをテストするだけです。

2) cPanel を使用して Robots.txt を編集する

cPanel を使用した robots.txt ファイルの編集は、FTP クライアントのアプローチと非常によく似ています。 まず、Web サイトのcPanel にログインする必要があります。 繰り返しになりますが、必要なログイン資格情報はすべてホスティング サービスによってすでに提供されているはずです。

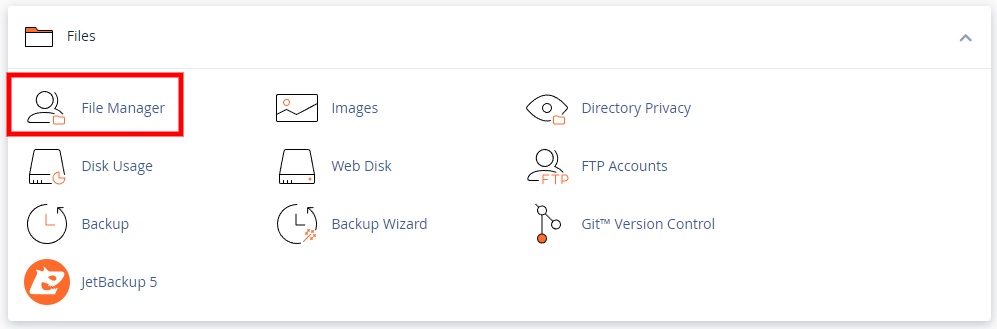

cPanel にログインした後、 「ファイル」セクションまでスクロールし、 「ファイル マネージャー」をクリックします。

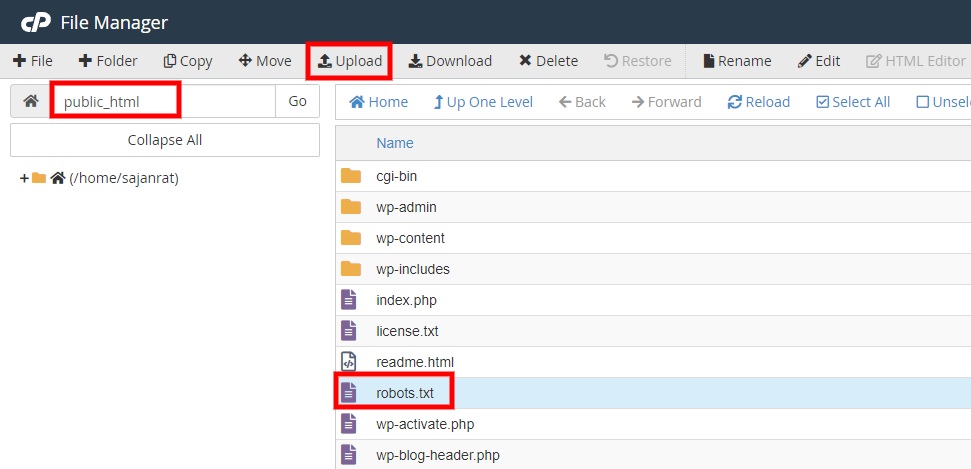

次に、「 public_html 」ファイル ディレクトリに移動し、最近作成した robots.txt ファイルをここにアップロードします。 もう一度言いますが、robots.txt ファイルがここにすでに存在する場合は、新しく編集したファイルに置き換える必要があります。

最後に、ドメインの末尾に「/robots.txt」パスを追加して、robots.txt ファイルをテストします。

3) プラグインを使用して Robots.txt を編集する

robots.txt ページの編集にかかる時間と手間を大幅に節約したい場合は、プラグインを使用することもできます。 Yoast SEO、All in One SEO、Rank Math SEO などのいくつかの SEO プラグインを使用すると、robots.txt ファイルを作成および編集できます。

使用するプラグインを決定するための詳細情報が必要な場合は、最高の WordPress SEO プラグインの完全なリストをご覧ください。

ただし、このデモではRank Math SEOプラグインを使用します。 これは最も人気のある SEO プラグインの 1 つで、robots.txt ファイルを編集するための非常に簡単なインターフェイスを備えています。 それでは、プラグインをインストールすることから始めましょう。

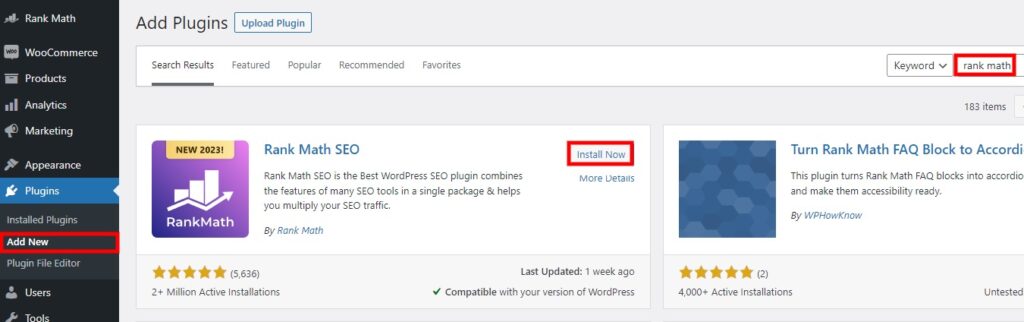

3.1) プラグインのインストールと有効化

プラグインをインストールするには、WordPress ダッシュボードから[プラグイン] > [新規追加]に移動し、最初にプラグインのキーワードを検索する必要があります。 検索エンジンにプラグインが表示されたら、 「今すぐインストール」をクリックします。 インストールには少し時間がかかります。

インストールが完了したら、 「有効化」をクリックしてプラグインを有効化します。

プレミアム プラグインを使用したい場合は、手動でアップロードする必要があります。 詳細については、WordPress プラグインを手動でインストールするための詳細ガイドをご覧ください。

さらに、Rank Math SEO の設定中に問題が発生した場合には、Rank Math の設定方法に関する具体的なガイドも用意しています。

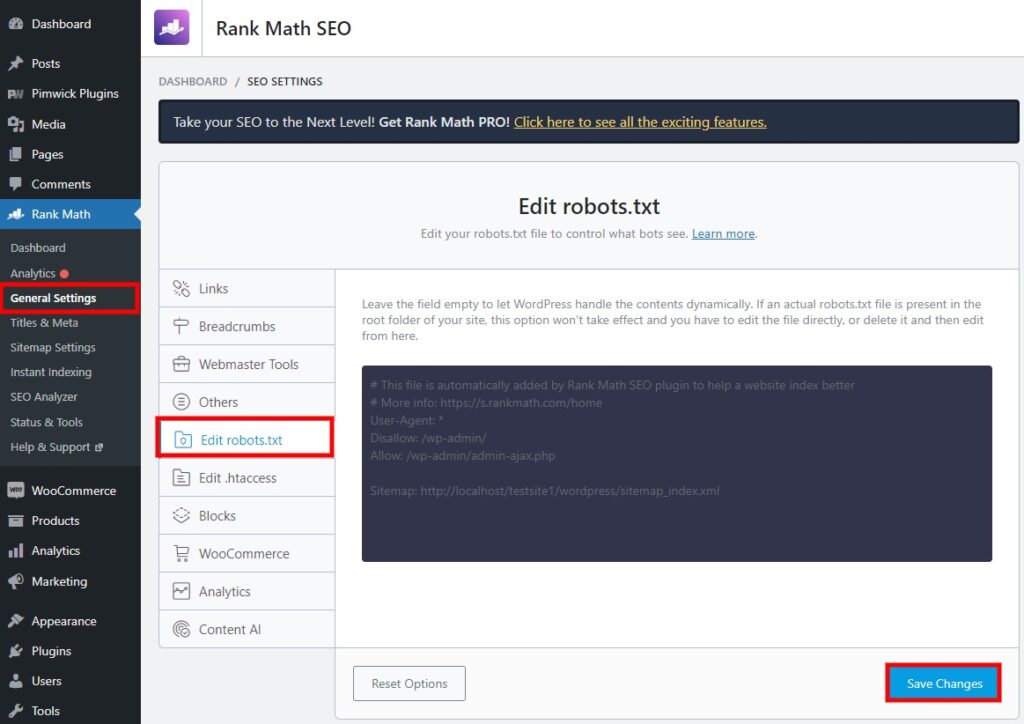

3.2) Robots.txt ファイルの編集

プラグインがアクティブになったら、WordPress ダッシュボードからRank Math > 一般設定に移動し、 robots.txt ファイルの編集タブを選択します。 このセクションでは、robots.txt ファイルを編集するためのテキスト エディターがプラグインに提供されていることがわかります。

ここでは、ボットにクロールしてインデックスを作成させたい Web ページに応じて、すべてのコードとコマンドを追加する必要があります。 サポートが必要な場合は、このチュートリアルの前の手順のいずれかで、必要なガイドラインをすべて提供しています。

robots.txt ファイルに必要なコマンドとディレクティブをすべて追加したら、 [変更を保存]をクリックします。

素晴らしい! ここで、ドメインの末尾に「/robots.txt」パスを追加すると、ファイルがそれに応じて更新されたことがわかります。 したがって、検索エンジン ボットは、robots.txt ファイルに基づいて許可された Web ページのみを通過します。

結論

これは、 WordPress で robots.txt ファイルを作成および編集する方法です。 検索エンジンのボットが Web サイトの機密コンテンツや重複コンテンツを通過したくない場合は、そうすることが不可欠です。 robots.txt ファイルを使用して、Web サイトの特定のページをクロールしてインデックスを作成するようにボットに指示することもできます。

要約すると、robots.txt ファイルは 3 つの主な方法で編集できます。

- FTPクライアントの使用

- cパネル

- プラグインを使用する

FTP クライアントと cPanel の使用方法は非常に似ています。 cPanel にログインするか、Web サイトを FTP クライアントに接続して、robots.txt ファイルをアップロードするだけです。 次に、以前に手動で作成した robots.txt ファイルをアップロードする必要があります。

一方、プラグインを使用すると、robots.txt ファイルが Web サイトに自動的に追加されます。 プラグインには、robots.txt ファイルの編集に役立つテキスト エディターも提供されます。

それでは、Web サイトの robots.txt ファイルを今すぐ編集できますか? 試したことがあるかどうかをコメントでお知らせください。

一方、この記事が役立つと思われた場合は、WordPress Web サイトをカスタマイズまたは改善するために使用できるその他の投稿を以下に示します。

- WordPress SEO を改善する方法: 9 つの方法

- 最高の WordPress SSL プラグイン (無料および有料)

- WordPress にメタディスクリプションを追加する方法